Материалы по тегу: hardware

|

10.04.2025 [16:11], Владимир Мироненко

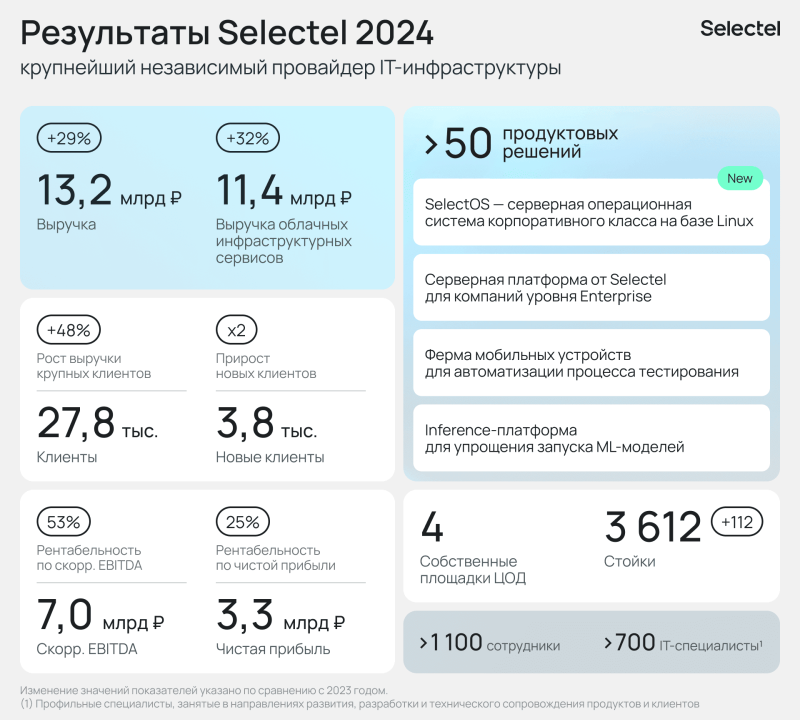

Выручка Selectel увеличилась в 2024 году на 29 % на фоне роста спроса на IaaSПровайдер IT-инфраструктуры АО «Селектел» (Selectel) опубликовал аудированную финансовую отчетность по МСФО за 2024 год, подтвердившую неаудированные результаты. Выручка Selectel увеличилась на 29 % год к году до 13,2 млрд руб. Большую часть денежных поступлений — 87 % — обеспечили облачные инфраструктурные сервисы, продажи которых выросли на 32 % год к году до 11,4 млрд руб., что соответствует прогнозам по росту рынка IaaS. На услуги ЦОД приходится 11 % выручки или 1,1 млрд руб. (рост год к году на 1 %), на прочие услуги — 5 % или 0,7 млрд руб. (рост — 33 %). Клиентская база Selectel увеличилась на 3,8 тыс. новых компаний до 27,8 тыс. У всех групп клиентов зафиксирован рост выручки, больше всего — у крупных клиентов — на 48 % год к году. При этом на Топ-5 клиентов приходится 15 % выручки компании. Наиболее популярны сервисы Selectel в сфере IT, ретейла и медиа, на которые приходится 63 % всех клиентов. Наиболее активно наращивали темпы использования облаков девелопмент (рост в 1,5 раза год к году), ретейл (в 1,5 раза) и медиа (в 1,4 раза). Чистая прибыль Selectel увеличилась на 19 % до 3,3 млрд руб. Рентабельность по чистой прибыли составила 25 %. Показатель скорректированной EBITDA увеличился на 24 % до 7,0 млрд руб. Рентабельность по скорр. EBITDA сохранилась на высоком уровне (53 %), хотя снизилась год к году на 2 п.п. в связи с увеличением расходов, направленных на привлечение клиентов и увеличение потенциала продаж. Капитальные затраты за отчётный период составили 5,9 млрд руб. Большая часть суммы (3,8 млрд руб.) была израсходована на серверное оборудование, 1,9 млрд руб. было направлено на развитие инфраструктуры дата-центров (рост в 1,7 раза год к году), в том числе на развитие дата-центра «Юрловский». За прошедший год компанией было введено в эксплуатацию 112 стоек. На начало 2025 года в ЦОД Selectel насчитывалось 3612 стоек. Долговая нагрузка сохранилась на комфортном уровне. Показатель «чистый долг/скорр. EBITDA» составил 1,9х на конец 2024 года по сравнению с 1,4х на конец 2023 года.

10.04.2025 [15:01], Руслан Авдеев

В Эдинбургском университете заработал ИИ-кластер на базе Cerebras CS-3Эдинбургский университет и Cerebras Systems развернули в суперкомпьютерным центре EPCC кластера из четырёх ИИ-систем CS-3 на базе царь-ускорителей WSE-3. Новые мощности являются частью Edinburgh International Data Facility. По словам EPCC, это крупнейший кластер CS-3 в Европе. EPCC уже имеет опыт работы с системами CS-1 и CS-2. В Cerebras заявили, что гордятся расширением сотрудничества с EPCC, которое поможет стать Великобритании одним из ключевых мировых ИИ-хабов. Как заявляют в EPCC, ИИ сегодня изменяет все сферы жизни, поэтому новые системы помогут университетам, государственным организациям и компаниям обучать и использовать ИИ-модели на скоростях и с лёгкостью, недоступной другим ИИ-решениям. Платформы Cerebras оптимизированы не только для масштабного обучения моделей, но и для сверхбыстрого инференса — пользователям кластера теперь доступна платформа-рекордсмен Cerebras AI Inference. Системы CS-3 способны выдавать до 2000 токенов/с для популярных ИИ-моделей.

Источник изображения: Nadia Ramella/unsplash.com С новыми кластерами на основе Cerebras CS-3, EPCC сможет обучать модели от 240 млрд до 1 трлн параметров, а также ежедневно тюнинговать модели с 70 млрд параметров. Лёгкость использования технологий Cerebras позволяет использовать ИИ-модели и в дисциплинах, не относящихся к компьютерным наукам. Технологии Cerebras обеспечивают линейную масштабируемость, что ускоряет инновации и повышает продуктивность команды EPCC, говорится в сообщении. Эдинбургский университет считается одним из лидеров в разработке ИИ-систем в последние 60 лет. Системы CS-2 в распоряжении EPCC уже позволили исследователям разработать высокоэффективное ПО для инференса для больших языковых моделей (LLM) — как для местного применения, так и для помощи исследователям из Индии в разработке ИИ-моделей для материаловедения и из Швейцарии — для адаптации LLM к местному диалекту немецкого языка. Кроме того, платформы CS-3 с миллионами вычислительных ядер позволят продолжить исследования EPCC в областипараллельных вычислений и энергоэффективности.

10.04.2025 [11:27], Сергей Карасёв

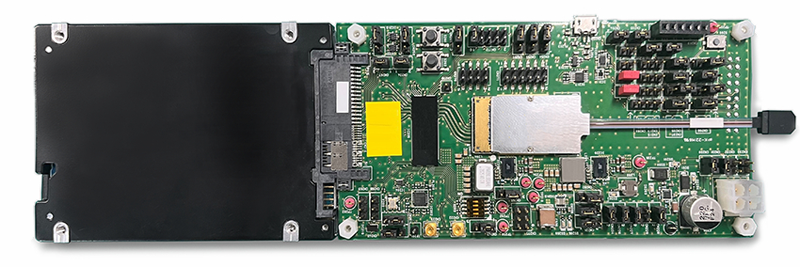

SSD с «хвостиком»: Kioxia представила «оптические» SSD для дата-центров следующего поколенияКомпании Kioxia, AIO Core и Kyocera объявили о разработке прототипа SSD с оптическим интерфейсом, совместимого с PCIe 5.0. Изделие ориентировано на дата-центры следующего поколения, рассчитанные на ресурсоёмкие нагрузки, включая приложения ИИ с высокой интенсивностью обмена данными. О разработке «оптических» твердотельных накопителей Kioxia сообщала в августе прошлого года. Речь идёт об использовании оптического интерфейса подключения вместо традиционного электрического. Новый подход позволяет устранить влияние посторонних электромагнитных помех. При этом длина соединения может достигать 40 м с последующим увеличением до 100 м. В представленном прототипе SSD задействованы оптический трансивер IOCore разработки AIO Core и технология оптоэлектронной интеграции Optinity компании Kyocera. Реализованная оптическая система, как утверждается, позволяет устройству функционировать на скоростях интерфейса PCIe 5.0.

Источник изображения: Kioxia Разработка «оптического» SSD осуществляется в рамках японского проекта JPNP21029 «Развитие технологий зелёных центров обработки данных следующего поколения». Он субсидируется Организацией по развитию новых энергетических и промышленных технологий (NEDO). Цель инициативы заключается в сокращении энергопотребления ЦОД более чем на 40 % по сравнению с нынешними площадками. В рамках проекта Kioxia отвечает за SSD нового типа, тогда как AIO Core и Kyocera создают оптоэлектронные компоненты. Предполагается, что появление «оптических» SSD откроет новые возможности в плане проектирования дата-центров. Представленная технология позволит значительно увеличить физическое расстояние между вычислительными и запоминающими устройствами, обеспечивая при этом энергоэффективность и высокое качество сигнала.

10.04.2025 [09:14], Владимир Мироненко

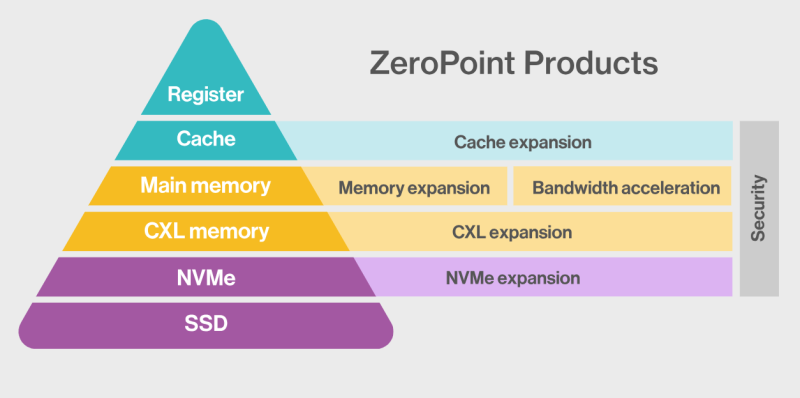

ZeroPoint Technologies и Rebellions займутся разработкой ИИ-ускорителей со «сжимаемой» памятьюШведская компания ZeroPoint Technologies, специализирующаяся на создании решений для оптимизации памяти, объявила о стратегическом альянсе с южнокорейским разработчиком ИИ-чипов Rebellions с целью разработки ИИ-ускорителей для инференс. Компании планируют представить новые продукты в 2026 году, обещая «беспрецедентную производительность в пересчёте на токены в секунду на Вт (TPS/W)», пишет EE Times. Компании планируют увеличить эффективную пропускную способность и ёмкость памяти для нагрузок инференса, используя технологии сжатия, уплотнения и управления памятью от ZeroPoint Technologies. По словам генерального директора ZeroPoint Technologies Класа Моро (Klas Moreau), аппаратная оптимизация работы с памятью на уровне ЦОД позволит увеличить адресуемую ёмкость с ускорением работы почти в 1000 раз по сравнению с использованием программного сжатия. Компании планируют улучшить показатели токенов в секунду на Вт без ущерба для точности, используя сжатие модели без потерь для уменьшения её размера и сокращения использования энергии, необходимой для перемещения компонентов модели. Гендиректор Rebellions Сонхён Пак (Sunghyun Park) указал, что партнёрство позволит компаниям переопределить возможности инференса, предоставляя более умную, экономичную и устойчивую ИИ-инфраструктуру. Моро ранее заявил, что более 70 % данных, хранящихся в памяти, являются избыточными, что позволяет полностью избавиться от них, добившись сжатия без потерь полезной информации. Такая технология сжатия должна выполнять ряд специфических действий в пределах наносекунды, т.е. всего нескольких тактов: «Во-первых, она должна отрабатывать сжатие и распаковку. Во-вторых, она должна уплотнять полученные данные, собирая небольшие фрагменты в единичную линию кеша, чтобы значительно улучшить видимую пропускную способность памяти, и, наконец, она должна бесперебойно управлять данными, отслеживая все фрагменты. Чтобы минимизировать задержку, такой подход должен работать с гранулярностью линий кеша — сжимая, уплотняя и управляя данными в 64-байт фрагментах — в отличие от гораздо больших блоков 4–128 Кбайт, используемых традиционными методами сжатия вроде ZSTD и LZ4». По словам Моро, благодаря этой технологии, для базовых рабочих нагрузок в ЦОД гиперскейлера адресуемая ёмкость памяти и пропускная способность могут быть увеличены в два-четыре раза, производительность на Вт может увеличиться на 50 %, а совокупная стоимость владения (TCO) может быть значительно снижена. А для специализированных нагрузок, таких как большие языковые модели (LLM), интеграция программного сжатия в сочетании с встроенной аппаратной декомпрессией (что минимизирует любую дополнительную задержку) уже продемонстрировала прирост примерно на 50 % в адресуемой ёмкости памяти, пропускной способности и токенах в секунду. Моро утверждает, что грядущая интеграция аппаратной (де-)компрессии обещает ещё более существенные улучшения. Например, для базовых ИИ-нагрузок кластер со 100 Гбайт физической памяти благодаря использованию этой технологии будет функционировать так, как если бы у него было 150 Гбайт памяти. «Это не только представляет собой миллиарды долларов потенциальной экономии, но и может повысить производительность сложных ИИ-моделей», — заявил Моро. «Эти достижения обеспечивают надёжную основу для компаний, производящих чипы ИИ, позволяя бросить вызов доминированию таких гигантов отрасли, как NVIDIA», — добавил он.

09.04.2025 [21:55], Владимир Мироненко

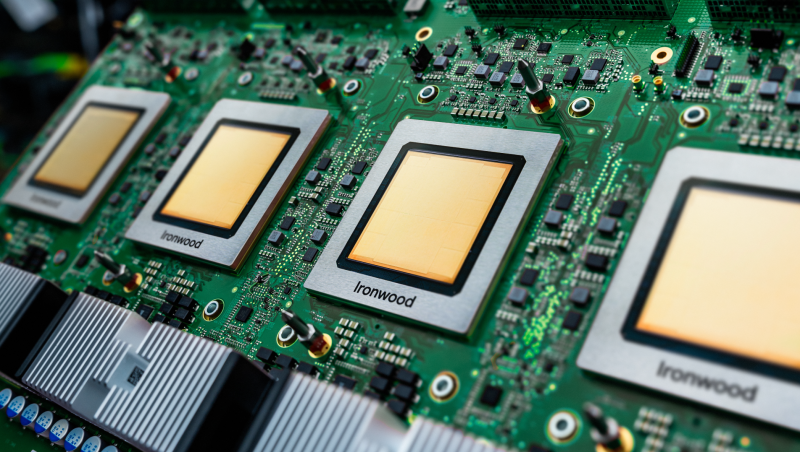

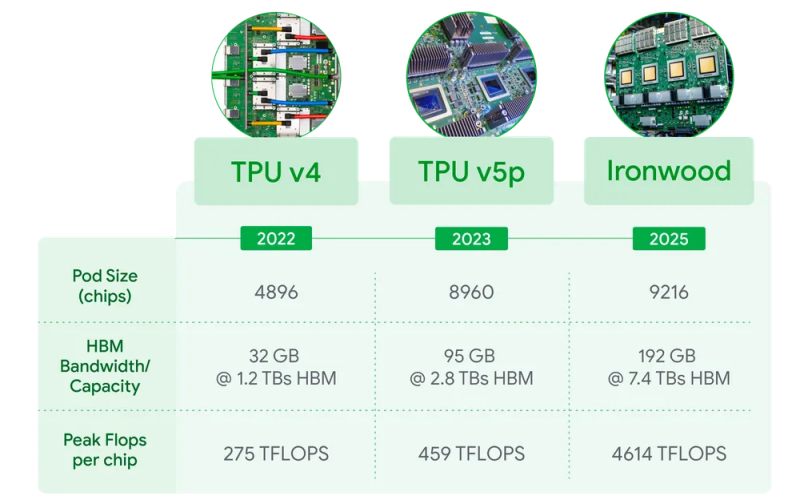

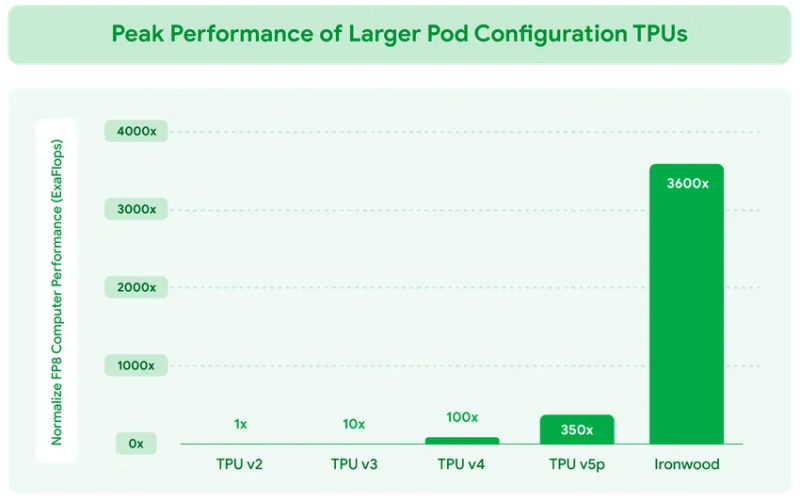

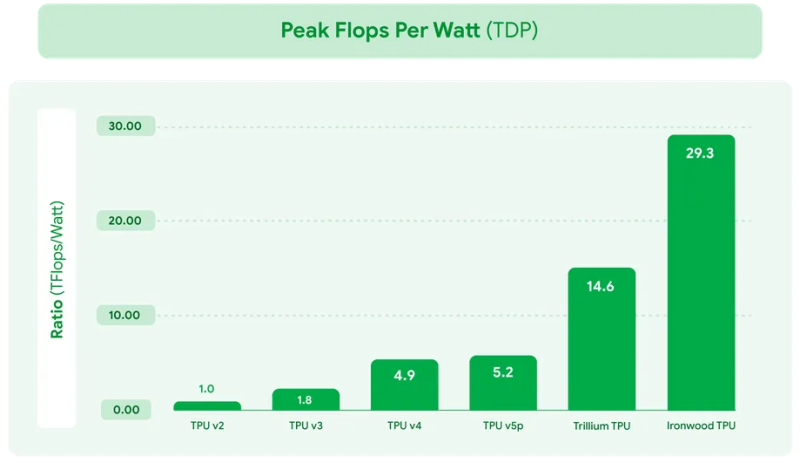

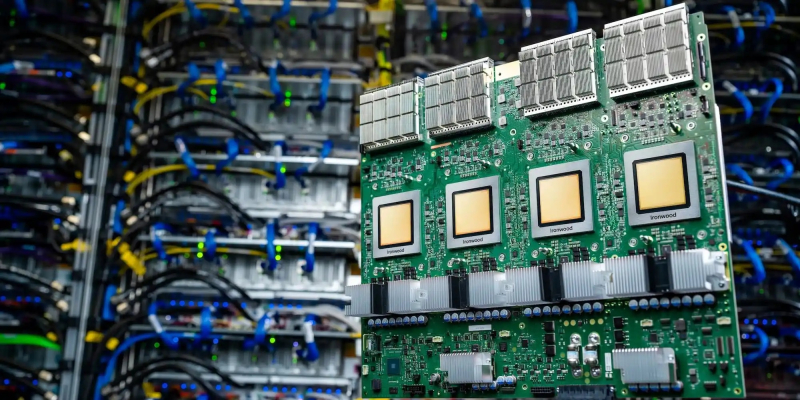

Google представила ИИ-ускоритель TPU v7 Ironwood, созданный специально для инференса «размышляющих» моделейКомпания Google Cloud представила тензорный ускоритель TPU седьмого поколения Ironwood, который охарактеризовала как свой самый производительный и масштабируемый настраиваемый ИИ-ускоритель на сегодняшний день и первый среди её чипов, разработанный специально для инференса. Новый чип представляет собой важный поворот в десятилетней стратегии Google по разработке ИИ-чипов, отметил ресурс VentureBeat. В то время как предыдущие поколения TPU были созданы в первую очередь для рабочих нагрузок обучения и инференса, Ironwood — первый чип, специально созданный для инференса. Как пояснила Google, Ironwood знаменует значительный сдвиг в развитии ИИ и инфраструктуры — переход от простых ИИ-моделей, которые просто предоставляют информацию в режиме реального времени, к моделям, которые обеспечивают проактивную генерацию идей и интерпретацию данных. Компания назвала этот период «эпохой инференса», когда ИИ-агенты будут активно извлекать и генерировать данные, чтобы совместно предоставлять информацию и ответы, а не просто «голые» сведения. Ironwood разработан в соответствии со сложными вычислительными и коммуникационными требованиями «моделей мышления», которые охватывают большие языковые модели (LLM), смешанные экспертные модели (MoE) и сложные задачи для рассуждения. Эти модели требуют массивной параллельной обработки и эффективного доступа к памяти. В частности, Ironwood разработан для минимизации перемещения данных и задержек на чипе при выполнении массивных тензорных манипуляций. Требования размышляющих моделей к вычислительным мощностям выходят далеко за рамки возможностей любого отдельного чипа. Google Cloud Ironwood будет поставляться в двух конфигурациях: с 256 или с 9216 чипами. Один чип может похвастаться пиковой вычислительной мощностью 4614 Тфлопс (FP8), а кластер из 9216 чипов мощностью порядка 10 МВт выдаёт в общей сложности 42,5 Эфлопс. Ironwood оснащён усовершенствованным блоком SparseCore, предназначенным для ускорения работы с ИИ-моделями, которые используются в системах ранжирования и рекомендаций. Расширенная реализация SparseCore в Ironwood позволяет ускорить более широкий спектр рабочих нагрузок, выйдя за рамки традиционной области ИИ в финансовые и научные сферы. Каждый чип оснащен 192 Гбайт памяти HBM, что в шесть раз больше, чем у TPU v6 Trillium. Пропускная способность памяти достигает 7,2 Тбайт/с на чип, что в 4,5 раза больше, чем у Trillium. Также используется межчиповый интерконнект Inter-Chip Interconnect (ICI) с пропускной способностью 1,2 Тбайт/с в дуплексе, что в 1,5 раза больше, чем у Trillium. Наконец, самое важное в эпоху ограниченных по мощности ЦОД — Ironwood обеспечивает вдвое большую производительность на Вт по сравнению с Trillium, а в сравнении с самым первым TPU от 2018 года он почти в 30 энергоэффективнее. Для Ironwood используется СЖО. С Ironwood разработчики также могут задействовать программный стек Pathways от Google DeepMind, чтобы использовать объединённую вычислительную мощность десятков тысяч TPU Ironwood. Как сообщается, Ironwood будет доступен клиентам Google и её собственным разработчикам в конце 2025 года. Google зафиксировала 10-кратный рост спроса на ИИ-вычисления за последние восемь лет. Как отметил ресурс VentureBeat, перенос Google фокуса на оптимизацию инференса имеет смысл. Обучение производится редко, а операции инференса — миллиарды раз в день. Экономика ИИ всё больше связана с затратами на инференс, особенно по мере того, как модели становятся всё более сложными и требующими больших вычислительных ресурсов.

09.04.2025 [17:03], Руслан Авдеев

NVIDIA и Cassava Technologies построят в Африке ИИ-фабрику за $720 млнАфриканская технологическая компания Cassava Technologies может инвестировать до $720 млн в первую в Африке «ИИ-фабрику» на базе решений NVIDIA, сообщает Bloomberg. Действующая на территории всего африканского континента компания зимбабвийского происхождения намерена развернуть ИИ-кластеры и сервисы в Южной Африке, Египте, Нигерии, Кении и Марокко. Как сообщает представитель Cassava, если компания не сделает первый шаг в деле инвестиций в ИИ, какими бы ограниченными они ни были, нельзя рассчитывать, что это сделают и другие. В компании уверены, что нельзя позволить, чтобы Африка осталась позади в деле мирового развития искусственного интеллекта. «ИИ-фабрика» Cassava рассчитана на исследователей в университетах, стартапы и разработчиков в самых разных секторах — здравоохранении, финтехе, государственном управлении. Первый кластер из 3 тыс. ускорителей NVIDIA к июню будет развёрнут в Южной Африке. В течение трёх-четырёх лет Cassava рассчитывает довести общее количество ускорителей в Африке до 12 тыс. Впрочем, сами ускорители, по словам компании — это лишь основа, а инвестиции в целом направлены на создание ИИ-экосистемы. Кроме того, компания рассчитывает продавать избыточные вычислительные мощности другим заказчикам со всего мира.

09.04.2025 [15:41], Руслан Авдеев

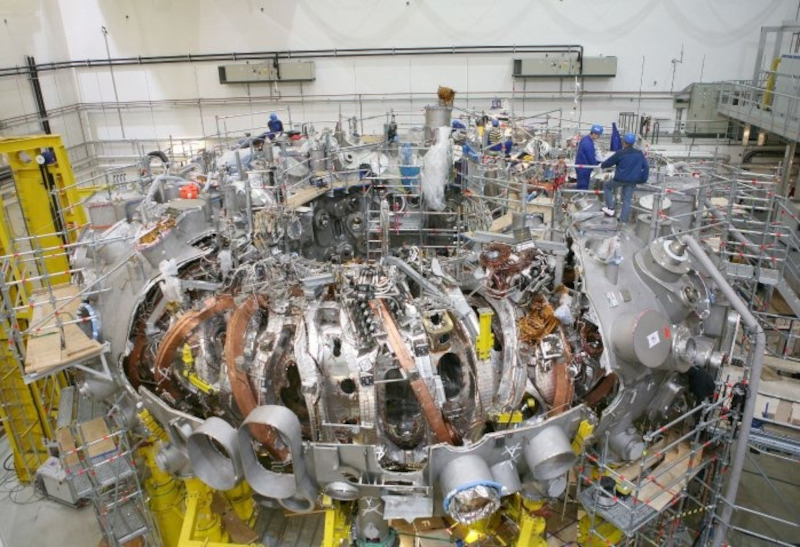

Type One Energy и TVA построят термоядерный реактор-стелларатор на заброшенной угольной электростанции в ТеннессиКоммерческий разработчик атомных технологий Type One Energy и государственная компания Tennessee Valley Authority (TVA) заключили соглашение о совместной разработке планов строительства термоядерной электростанции с использованием стелларатора, сообщает Business Wire. Соглашение расширяет сферу действия проекта Infinity, инициированного Type One Energy, TVA и Национальной лабораторией Ок-Ридж (ORNL) Министерства энергетики США в начале 2024 года при поддержке властей Теннесси. Пилотная термоядерная электростанция Infinity Two мощностью 350 МВт станет дополнительным источником энергии уже в середине 2030-х годов. Объект сможет задействовать инфраструктуру уже выведенной из эксплуатации угольной электростанции. Если изначально предполагалось лишь развёртывание прототипа стелларатора Type One Energy Infinity One на старой электростанции в Булл-Ране (Bull Run), принадлежащей TVA, то теперь в рамках Project Infinity предусмотрены более комплексные действия для коммерциализации термоядерной энергии. TVA и Type One Energy будут сотрудничать в исследованиях по монтажу термоядерной электростанции, участвовать в экологических экспертизах и лицензировании, а также в разработке планов проекта и поиске финансирования.

Источник изображения: Type One Energy В соответствии с соглашением Type One Energy будет использовать мощности центров Power Service Shops (PSS) TVA в Маскл-Шолс (Muscle Shoals) в Алабаме для создания цепочки поставок и модульного производства компонентов своего стелларатора. TVA получит возможность в будущем использовать успешные наработки для масштабирования термоядерной энергетики. Цель — коммерциализация термоядерного синтеза после успешного развёртывания Infinity Two. Также в рамках проекта Infinity предусмотрено развитие трудовых ресурсов, навыков и знаний для сборки, эксплуатации и обслуживания термоядерных стеллараторов. Штаты Теннесси и Алабама хорошо готовы для того, чтобы предоставить таланты и ресурсы, необходимые для успешной реализации термоядерных проектов, говорится в пресс-релизе. Как заявляют в Type One Energy, помощь TVA позволит сосредоточиться на завершении проектирования Infinity Two и тестировании прототипа Infinity One на станции TVA в Булл-Ране. Новое соглашение дополняет недавний договор Type One Energy о лицензировании технологий и производстве с Commonwealth Fusion Systems. Project Infinity также хорошо согласуется с миссией TVA по развитию безопасных, надёжных, доступных и устойчивых источникокв энергии. TVA весьма заинтересована в развитии энергетики, в частности, в Теннесси. Недавно она подверглась критике за выделение энергии суперкомпьютеру xAI Colossus в штате. Местные жители опасаются, что его огромное энергопотребление негативно скажется на ценах на электричество для обычных пользователей.

09.04.2025 [15:23], Руслан Авдеев

Строительство ЛЭП между Ирландиями оказалось под вопросом из-за прожорливых ЦОДПлан соединить энергосети Северной Ирландии (Великобритания) и Республики Ирландия 400-кВ линией на 400 кВ встретил сопротивление местных активистов. Они утверждают, что Северная Ирландия фактически будет отдуваться за «провальную стратегию» соседа, у которого на дата-центры в 2023 году пришлось 21 % национального энергопотребления, сообщает Datacenter Dynamics. Иск о прекращении реализации проекта был подан организацией Safe Electricity Armagh Tyrone (SEAT) в феврале: представителей власти Северной Ирландии призвали прекратить строительство линии электропередачи в Тироне и Арме (Северная Ирландия) до судебного рассмотрения, которое должно начаться 9 апреля. Работы над проектом уже начались, но разрешение на строительство должно истечь осенью. Если иск удовлетворят, реализацию проекта могут отложить на годы или вовсе отменить. На одну только подготовку проекта ушло почти 20 лет — с момента анонса в 2006 году он постоянно сталкивался с различными препятствиями. По словам главы SAFE и бизнесмена Джона Вудса (John Woods), фундаментальный вопрос заключается в том, зачем вообще нужно подключение между странами и что это даёт Северной Ирландии? По его словам — ничего, ни в ближайшей перспективе, ни в будущие десятилетия. Фактически возобновляемая энергия из Великобритании будет продаваться с наценкой ЦОД в Ирландии. Более того, как заявил Вудс, ЛЭП позволит «выкачивать» энергию из Шотландии в пользу Ирландии, а Северная Ирландия будет играть лишь роль моста.

Источник изображения: Andrey Metelev/unspalsh.com В ответ на жалобы оператор System Operator for Northern Ireland (SONI) заявил, что выкладки Вудса неверны. Линия, связывающая север с югом, также позволит существенно снизить ограничения для электросетей самой Северной Ирландии, позволяя региону использовать больше уже вырабатываемой возобновляемой энергии. Устранение таких ограничений позволит сэкономить местным потребителям до £55 тыс. ($70,3 тыс.) в день или £19 млн ($24,3 млн) ежегодно. Планируемая ЛЭП должна присоединиться к электросети Северной Ирландии в графстве Тирон (Tyron), пересечь границу между Армой (Armagh) и Монаханом (Monaghan), а затем подключиться к электросети в графстве Мит (Meath) в Республике Ирландия. Поскольку проект охватывает две юрисдикции, его реализация курируется как SONI в Северной Ирландии, так и ирландским оператором EirGrid. Предварительные строительные работы уже начались. Если дальнейших задержек не будет, на его завершение уйдёт не менее трёх лет, а его стоимость составит порядка £300 млн ($383,7 млн). Самой Ирландии отчаянно не хватает электричества, особенно в районе столицы — Дублина. В стране фактически действует мораторий на строительство новых ЦОД (с некоторыми оговорками), поскольку они за восемь лет увеличили энергопотребление на 473 %. Местный регулятор CRU предложил дата-центрам заняться самостоятельной постройкой электростанций и энергохранилищ.

09.04.2025 [13:30], Сергей Карасёв

Британское ИИ-облако NexGen Cloud привлекло на развитие $45 млнКомпания NexGen Cloud из Великобритании, по сообщению ресурса Datacenter Dynamics, осуществила раунд финансирования Series A, в рамках которого на дальнейшее развитие привлечено $45 млн. В качестве инвесторов выступили преимущественно частные лица и семейные трасты, однако подробности о них не разглашаются. Стартап NexGen Cloud был основан в 2020 году. Компания начинала свою деятельность как поставщик облачной инфраструктуры для блокчейн-приложений, но позднее переориентировалась на стремительно развивающуюся отрасль ИИ. В частности, была развёрнута облачная платформа GPU-as-a-Service (GPU как услуга). У NexGen Cloud нет собственных дата-центров. Вместо этого стартап заключил долгосрочные соглашения на использование GPU-ресурсов с существующими гиперскейлерами. Эти аппаратные мощности NexGen Cloud затем предлагает клиентам, которым нужен более гибкий подход к обучению ИИ-моделей и инференсу. Ресурсы GPU предоставляются через платформу Hyperstack: утверждается, что на сегодняшний день она насчитывает более 10 тыс. пользователей, включая Red Hat, Ingenix.AI, Tyne и ArchiLabs.

Источник изображения: NexGen Cloud В конце 2023 года NexGen Cloud объявила о намерении инвестировать $1 млрд в создание европейского ИИ-супероблака, насчитывающего 20 тыс. ускорителей NVIDIA H100. Привлечённые в ходе раунда финансирования Series A средства стартап намерен направить на развитие партнёрских отношений, которые «помогут улучшить доступ к вычислительным мощностям для ИИ». Кроме того, компания планирует запустить инфраструктурные услуги и новые продукты, включая систему Fine-Tuning-as-a-Service, призванную повысить эффективность предварительно обученных моделей ИИ.

09.04.2025 [13:22], Руслан Авдеев

Microsoft отказалась от планов строительства ЦОД за $1 млрд в ОгайоКомпания Microsoft отказалась от планов строительства дата-центров в округе Ликинг (Licking) в штате Огайо (США). В компании сообщают, что более не намерена инвестировать $1 млрд на возведение трёх кампусов ЦОД в Нью-Олбани (New Albany), Хите (Heath) и Хевроне (Hebron), сообщает Datacenter Dynamics. Это последние новости об отказах Microsoft от реализации связанных с ЦОД проектов. Недавно появилась информация о том, что компания отменила проекты на 2 ГВт в США и Европе. Вскоре после этого она отказалась от проектов в Азиатско-Тихоокеанском регионе и Великобритании. В октябре 2024 года Microsoft анонсировала планы инвестировать $1 млрд в кампусы ЦОД в Центральном Огайо. На тот момент $420 млн было зарезервировано для кампуса в Нью-Олбани, в том же месяце местный городской совет объявил о налоговых льготах для Microsoft сроком на 15 лет. Площадь ЦОД должна была составить 22 800 м2, площадь участка — более 80 га. Строительство должно было стартовать в июле 2025 года. Локации для ЦОД в Хите и Хевроне не обнародовали, но ранее Microsoft приобрела порядка 90 га в одном из райнов Хита (Торнвуд-Драйв, Thornwood Drive) и почти столько же — на Хай-Стрит (High Street) в Хевроне. В Хите строительство должны были начать летом 2025 года, а в Хевроне — в 2026-м. По информации представителя Microsoft, компания продолжает оценивать проекты в Огайо в рамках соей инвестиционной стратегии. Руководство и жителей округа Ликинг поблагодарили за поддержку инициатив.

Источник изображения: Matt Koffel/unspalsh.com Позже компания добавила, что оставит земельные участки за собой и когда-нибудь всё-таки начнёт строительство. Тем временем земля в двух локациях будет поддерживаться в состоянии, пригодном для использования в сельскохозяйственных целей. Кроме того, компания продолжит выполнять обязательства по поддержки местных дорог и инфраструктуры для возможного использования в будущем. Аналитики TD Cowen полагают, что отмена аренды и отсрочки ввода мощностей связаны с избытком предложения и не исключается, что текущий спрос на ЦОД оказался ниже прогнозируемого. До сих пор позиция Microsoft не менялась, компания заявляла, что благодаря уже сделанным значительным инвестициям она имеет хорошие возможности для того, чтобы удовлетворить спрос. Только в прошлом году компания добавила больше ёмкости ЦОД, чем в любой другой год до этого. Хотя компания вынуждена оптимизировать подходы и инфраструктуру в некоторых регионах, Microsoft намерена сохранять рост везде, где присутствует. Это позволит инвестировать и распределять ресурсы в зоны роста в будущем. В целом в текущем финансовом году планируется потратить более $80 млрд на инфраструктуру — рост продолжается рекордными темпами. Летом 2024 года сообщалось о том, что Google намерена инвестировать ЦОД в Огайо $2,3 млрд, а ещё в 2023 году AWS анонсировала инвестиции в объёме $8 млрд в том же штате. |

|