Материалы по тегу: ии

|

13.04.2025 [15:00], Сергей Карасёв

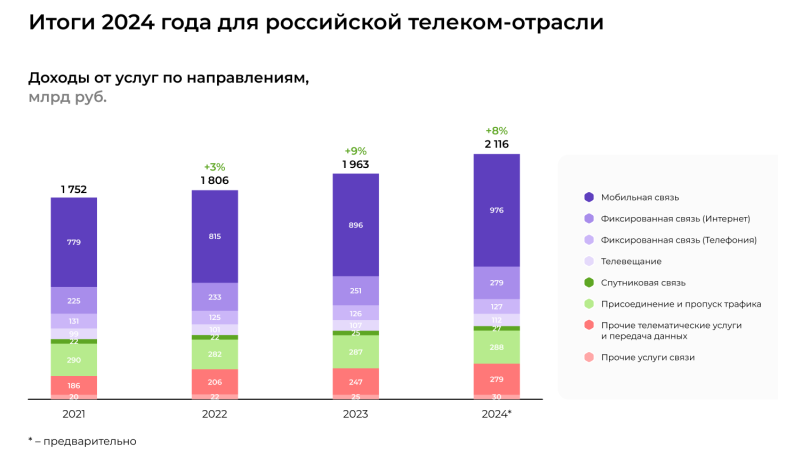

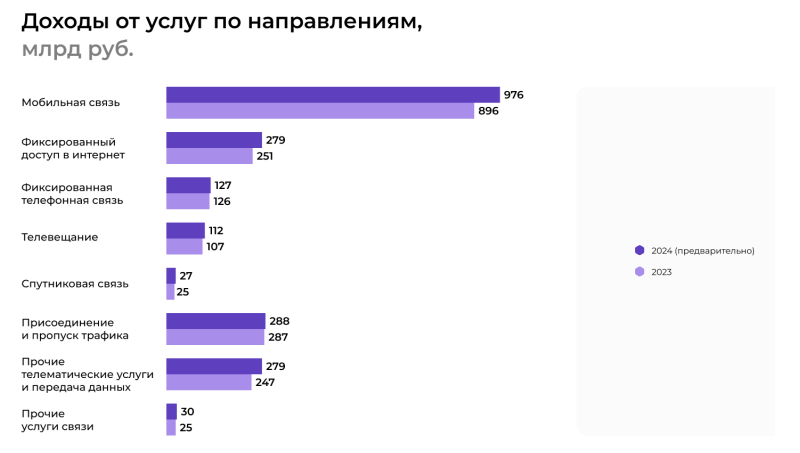

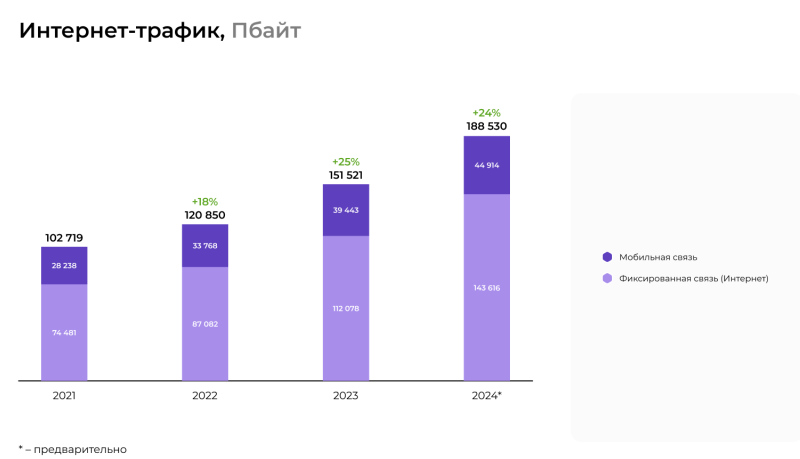

Объём телеком-рынка в России в 2024 году превысил 2,1 трлн руб., а трафик вырос со 151,52 Эбайт до 188,53 ЭбайтМинистерство цифрового развития, связи и массовых коммуникаций РФ (Минцифры) обнародовало данные по российскому телекоммуникационному рынку за 2024 год. Объём отрасли достиг 2,12 трлн руб., что на 7,8 % больше по сравнению с предыдущим годом, когда затраты оценивались в 1,96 трлн руб. Львиную долю выручки обеспечили услуги мобильной связи — 976 млрд руб. Для сравнения: в 2023 году показатель равнялся 896 млрд руб. Таким образом, отмечен рост на 8,9 %. Количество активных абонентов мобильной связи (SIM-карт) в годовом исчислении увеличилось на 2,5 %, составив приблизительно 270 млн. Расширение абонентской базы, как отмечает Минцифры, обусловлено в том числе экспансией банковских виртуальных операторов мобильной связи (MVNO). Эти игроки помогают поддерживать интерес к услугам связи и обеспечивают дополнительный рост. Мобильным интернетом в 2024 году пользовались около 188 млн абонентов в России, что на 6,5 % больше по сравнению с предыдущим годом.

Источник изображений: Минцифры В сегменте фиксированного широкополосного интернет-доступа выручка поднялась на 11 % — с 251 млрд руб. в 2023 году до 279 млрд руб. в 2024-м. Количество активных абонентов фиксированного интернета увеличилось на 4,7 % — до 39 млн. Драйверами данного сектора названы расширение сетей операторов в пригороды и частный сектор и ввод в эксплуатацию нового жилья с современной инфраструктурой.  «Рынок вырос примерно на 8 %. Мобильная часть — даже чуть больше. За 2024 год — рост инвестиций на 20 % в сегменте мобильной связи и 15 % — в сегменте фиксированной. Ситуация даже лучше, чем была в 2020 году. Надеемся, что рост продолжится и дальше», — отметил глава Минцифры. Фиксированная телефонная связь в 2024 году принесла примерно 127 млрд руб. против 126 млрд руб. годом ранее. В области телевещания расходы за год увеличились со 107 млрд до 112 млрд руб., в сфере спутниковой связи — с 25 млрд до 27 млрд руб.  Трафик в российских фиксированных и мобильных сетях за 2024 год вырос на 24,4 % — со 151,52 Эбайт до 188,53 Эбайт. В целом, Минцифры выделяет несколько основных факторов, способствующих увеличению выручки телеком-операторов в России. Это рост потребления интернет-трафика, проникновение пакетных тарифов, продвижение дополнительных опций и медийных сервисов, а также развитие новых направлений бизнеса в дополнение к традиционным услугам связи.

12.04.2025 [16:20], Владимир Мироненко

В 2024 госзакупки ИИ-оборудования увеличились на 150 % до 2,4 млрд рублейВ 2024 году госзакупки ПАК с использованием ИИ-ускорителей увеличились на 150 % в деньгах, до 2,4 млрд руб., и на 120 % в количественном выражении. При этом в основном закупки осуществляли госорганы по 44-ФЗ (закупки государственных и муниципальных заказчиков за счёт бюджетных средств), на которые пришлось 2,3 млрд руб., сообщил «Коммерсантъ» со ссылкой на данные площадки «Тендерплан». Крупнейшим заказчиком в 2024 году было управление информационных технологий и связи Санкт-Петербурга с тендером на 1,3 млрд руб. Председатель комитета по информатизации и связи Санкт-Петербурга сообщил «Коммерсанту», что закупка производилась для распределённого регионального ЦОД в связи с созданием на его базе масштабируемой платформы для обработки больших данных с внедрением ИИ-сервисов. Это оборудование используется и для АПК «Безопасный город». По данным «Контур.Закупок», количество таких закупок по 44-ФЗ выросло почти втрое, с 11 до 32 при росте суммы контрактов на 147 %, до 2,26 млрд руб. У госкомпаний (223-ФЗ) количество закупок выросло на 50 %, до 24 процедур, а сумма контрактов увеличилась на 383 %, до 116 млн руб. В «Контур.Закупках» объясняют рост закупок бюджетных организаций трендом на цифровизацию и внедрением решений на базе ИИ в разные сферы. Эксперты полагают, что небольшое количество сделок может быть связано с высокой стоимостью и специфичностью применения оборудования. Кроме того, на рост закупок в денежном выражении мог повлиять резкий рост курса валют и необходимость закупки оборудования для проектов, которые выходят на стадию реализации. Ранее стало известно, что правительство планирует обязать ведомства и госкомпании закупать отдельные виды российской радиоэлектронной продукции по полной предоплате, чтобы покрыть расходы на закупку компонентов и снизить издержки, связанные с высокой ключевой ставкой ЦБ.

12.04.2025 [15:07], Сергей Карасёв

Объём экспорта российского ПО в 2024 году рухнул в полтора раза, но это не точноБанк России, по сообщению газеты «Коммерсантъ», оценил объём экспорта российского ПО и компьютерных услуг по итогам 2024 года в $1,9 млрд. Это примерно в полтора раза меньше по сравнению с предыдущим годом, когда поставки за рубеж составляли около $2,9 млрд. Однако, как отмечается, данные ЦБ расходятся с оценками участников отрасли и других ведомств. В частности, ассоциация «Руссофт» считает, что экспорт отечественного ПО в 2024 году увеличился на 7,2 %, достигнув $5,9 млрд. С такой оценкой соглашается Минцифры РФ. Эксперты связывают значительную разницу в данных Банка России и «Руссофта» со сформировавшейся геополитической обстановкой. Многие компании, опасаясь санкционного давления, используют нестандартные схемы расчётов с зарубежными партнёрами. Это могут быть, например, переводы физическим лицам или транзакции в криптовалютах. Такие платежи в статистике ЦБ не учитываются по статье «компьютерные услуги». Директор Ассоциации предприятий компьютерных и информационных технологий (АПКИТ) также говорит, что в условиях санкций «экспорт не может быть прямым, официальным». В связи с этим учет поставок продукции за рубеж со стороны государства затруднён, а поэтому возникают значительные несоответствия в оценках: официальные цифры оказываются меньше реальных, в которых подсчитываются все продажи на иностранных рынках. Негативное влияние на экспорт российского софта также оказывают другие факторы, среди которых дефицит квалифицированных кадров и трудности прямого маркетинга. Участники отрасли говорят, что сокращение экспорта связано прежде всего с закрытием рынков США и ЕС для российских IT-компаний. Вместе с тем растёт конкуренция на внутреннем рынке РФ из-за появления большого количества «дублирующего софта». На этом фоне некоторые российские компании полностью уходят из страны, выбирая глобальный рынок. Кроме того, многие отечественные разработчики открывают дочерние организации за рубежом, но их выручка не учитывается в показателях головной структуры: в результате, общие оценочные значения экспорта снижаются. По данным «Руссофта», совокупный оборот российских IT-компаний в 2024 году увеличился на 33,2 %, составив 2,7 трлн руб. Основным драйвером отрасли аналитики называют продолжающееся импортозамещение.

11.04.2025 [17:28], Руслан Авдеев

Galaxy Digital променяла «крипту» на ИИ, сдав CoreWeave свой 200-МВт дата-центрКомпания Galaxy Digital Holdings решила кардинально сменить профиль. Она преобразует свой флагманский дата-центр Helios в Западном Техасе, изначально предназначавшийся для криптомайнинга, в объект для ИИ-облака CoreWeave, сообщает Datacenter Dynamics. Компании заключили соглашение об аренде сроком на 15 лет, в рамках которой Galaxy обеспечит 133 МВт критической IT-нагрузки (200 МВт общей) для ИИ- и HPC-платформ CoreWeave. В рамках реформ Galaxy Digital избавит дата-центр от оборудования для майнинга. Мощности будут вводиться поэтапно, так что все 133 МВт станут доступны к концу I половины 2026 года. К завершению развёртыванию обещана надёжность уровня Tier III. В Galaxy рассчитывают, что общая выручка за 15 лет составит около $4,5 млрд. В последнем финансовом отчёте Galaxy заявила, что уже начала выборочный демонтаж на объекте площадью 11,7 тыс. м2. Майнинговое оборудование начнут отключать во II квартале 2025 года. Сейчас компания изучает варианты «монетизации» имеющихся у неё Bitmain Antminer A6. Кампус Helios расположен на участке площадью 65 га, который Galaxy выкупила у Argo Blockchain за $65 млн. Galaxy получила разрешение от техасского энергооператора ERCOT на получение для Helios ещё 600 МВт, которые при желании достанутся CoreWeave. В целом же компания рассчитывает получить для данного кампуса ещё 1,7 ГВт, но поэтапная выдача разрешений может затянуться на несколько месяцев.

Источник изображения: Ben Rosett/unsplash.com Помимо Helios, у Galaxy Mining состоялась закладка собственного кампуса в Техасе, запустить который планировалось в 2023 году, но статус объекта до сих пор не ясен. Компания участвовала в продвижении провалившейся криптовалюты Luna и чудом избежала серьёзных санкций, заключив с генеральным прокурором Нью-Йорка соглашение на $200 млн. Galaxy позиционирует себя как компанию, которая занимается цифровыми активами и блокчейн-технологиями в самых разных сферах, от стратегического консалтинга до майнинга. CoreWeave, недавно вышедшая на IPO, и сама в своё время занималась майнингом, но теперь сочла более выгодным предоставлять другим компаниям доступ к ускорителям для выполнения ИИ-задач. Её крупнейшими клиентами являются Microsoft с OpenAI и NVIDIA. В конце 2024 года в компании заявляли, что располагают 32 ЦОД с более 250 тыс. ускорителей и более 360 МВт введённых мощностей. Также на 2025 год запланирован ввод в эксплуатацию ещё 10 новых ЦОД, а законтрактованные мощности составляют 1,3 ГВт. Компания получает как готовые ЦОД, созданные под неё, так и арендует площадки у крупных традиционных операторов и всё тех же майнеров. В прошлом году она попыталась купить Core Scientific, но та решила не отказываться от майнинга, хотя в стан ИИ уже «переметнулись» Hive Digital Technologies, Northern Data, Applied Digital, Iris Energy, Mawson Infrastructure, Crusoe и др.

11.04.2025 [16:54], Руслан Авдеев

xAI без спроса построила импровизированную газовую электростанцию для ИИ-суперкомпьютера ColossusКомпания xAI более чем вдвое увеличила число мобильных газовых турбин на площадке суперкомпьютера Colossus в Мемфисе, чем, похоже, нарушила разрешения на выработку энергии на выделенной территории, сообщает Datacenter Dynamics. «Лишние» турбины обнаружили на аэрофотоснимках местности — их теперь 35 вместо изначально разрешённых к эксплуатации 15. По оценкам, их совокупная мощность составляет 422 МВт, тогда как мощность расположенной неподалёку обычной газовой электростанции равна 425 МВт. Защитники природы из группы Southern Environmental Law Center (SELC), что это прямое нарушение Закона о чистом воздухе (Clean Air Act). По мнению юристов SELC, речь фактически идёт о строительстве xAI электростанции без надзора, без разрешений и без учёта интересов местных жителей. Десятки газовых турбин, по их словам, наносят вред окружающей среде. Экоактивисты рассчитывают, что местные власти немедленно примут меры по привлечению xAI к ответственности.

Источник изображения: xAI SLRC и другие группы уже подали жалобу в Департамент здравоохранения округа Шелби (SCHD). Утверждается, что турбины, вероятно, делают xAI крупнейшим промышленным источником оксидов азота в Мемфисе, давно борющемся со смогом. На заседании окружного комитета жители уже выразили неодобрение проекту и требуют внимательнее изучить последствия для населения. Местный совет настоятельно рекомендовал SCHD отложить одобрение использования новых генераторов до тех пор, пока не будет проведено публичное собрание для сбора мнений жителей, которые могут пострадать от турбин. SCHD обязался провести публичные слушания по данному вопросу 25 апреля. Ранее SELC уже обращалась в Департамент здравоохранения Шелби по поводу размещения газовых турбин на объекте. В августе 2024 года группа заявила, что xAI, вероятно, установила 18 газовых генераторов без разрешения, что создает неоправданные риски для здоровья жителей окрестностей. Фактическая эксплуатация суперкомпьютера Colossus началась в июле. На тот момент местная энергокомпания TVA выделила объекту лишь 8 МВт, к концу года поставки были увеличены до 150 МВт. Всё это время ЦОД полагался именно на газовые генераторы Дата-центр используется для обучения и эксплуатации чат-бота компании Grok. ЦОД расположен в технопарке на юго-западе Мемфиса. В прошлом году основатель xAI Илон Маск (Elon Musk) объявил, что мощность дата-центра будет удвоена и объект находится в процессе установки ещё 100 тыс. ускорителей NVIDIA. Со временем планируется развернуть 1 млн ускорителей. В феврале сообщалось, что компания рассматривает создание ещё одного ЦОД.

11.04.2025 [11:43], Алексей Степин

NERPA представила универсальные высокопроизводительные серверы NORD D5720Российская IT-сфера сегодня как никогда нуждается в отечественных аппаратных решениях, отвечающих современным стандартам производительности, расширяемости и совместимости. Отвечая на этот запрос, компания NERPA, производящая широкий спектр ИТ-оборудования для OCS Distribution, представила новые универсальные серверы NERPA NORD D5720 (НН 3000029184), сочетающие в себе поддержку современных процессоров Intel Xeon, памяти DDR5, гибко конфигурируемую дисковую подсистему и возможность установки современных мощных ускорителей. В основе новинки лежит серверная платформа Intel на базе чипсета C741 с двумя сокетами LGA 4677, поддерживающая процессоры Xeon Scalable четвёртого (Sapphire Rapids) и пятого (Emerald Rapids) поколений. Это делает NORD D5720 одним из самых производительных решений, доступных российскому заказчику. Эти процессоры имеют высокоскоростную восьмиканальную подсистему памяти DDR5. В реализации NORD D5720 используется материнская плата с 32 слотами DIMM, позволяющая устанавливать по 16 модулей (L)RDIMM процессор. Вкупе с поддержкой модулей LDRIMM объёмом 128 Гбайт это позволяет комплектовать серверы оперативной памятью DDR5-5200 объёмом до 2 Тбайт. Конфигурация дисковой подсистемы NORD D5720 может варьироваться в широки пределах, и, в зависимости от потребностей заказчика, выглядеть следующим образом:

Помимо этого, в задней части сервера может присутствовать дополнительная корзина для четырёх накопителей формата 2,5″, что позволяет довести количество дисков в системе до 28. За счёт возможностей платформы поддерживаются массивы SATA RAID 0/1/10/5, опционально доступна конфигурация с дополнительным HBA/RAID-контроллером. Доступ к передним дисковым корзинам может блокироваться при помощи декоративной панели с замком. Здесь же, на передней панели, расположена пара портов USB 3.0 и разъём VGA, что упрощает процедуру непосредственного администрирования. Как и у всех современных серверных платформ, у NORD D5720 имеется выделенный сетевой порт удалённого управления (BMC ASPEED AST 2600). Система NORD D5720 выполнена в форм-факторе 2U, но при этом имеет широкие возможности расширения — она, в зависимости от конфигурации дисковых корзин, может иметь до восьми слотов PCIe 5.0 (три райзера) и слот для высокоскоростного NIC OCP 3.0 (PCIe x16). Из восьми слотов PCIe три имеют подключение x16, остальные — x8. Все они рассчитаны на установку FHHL-карт. Подсистема питания может оснащатсья двумя (1+1) блоками питания мощностью по 1300 Вт каждый, либо одним блоком мощностью 1600 Ватт, оба варианта соответствуют стандарту 80 PLUS Platinum. За продувку и отвод тепла отвечают четыре вентилятора типоразмера 80 × 80 × 38 мм со скоростью вращения до 16300 об/мин. BMC в новых моделях NERPA NORD D5720 снабжена расширенной функциональностью, ранее в решениях NERPA недоступной. Это, например, возможность конфигурирования и управления RAID-массивами из графического интерфейса BMC. Также производитель заявляет о планах в ближайшее время полностью локализовать интерфейс BIOS и добавить поддержку группового управления для новых моделей. Серверы NERPA NORD D5720 уже доступны для заказа, стоимость, наличие на складе и сроки поставки можно уточнить непосредственно на сайте производителя или у представителей сети OCS Distribution.

11.04.2025 [11:00], Сергей Карасёв

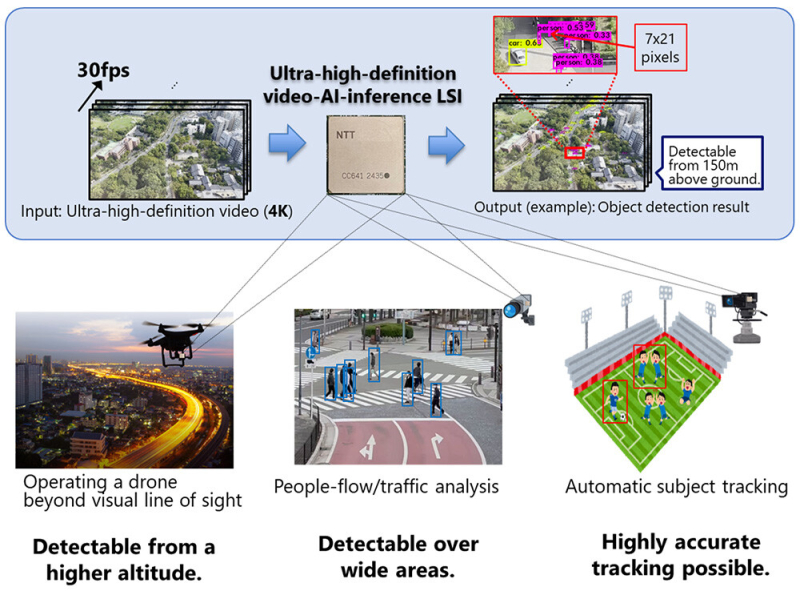

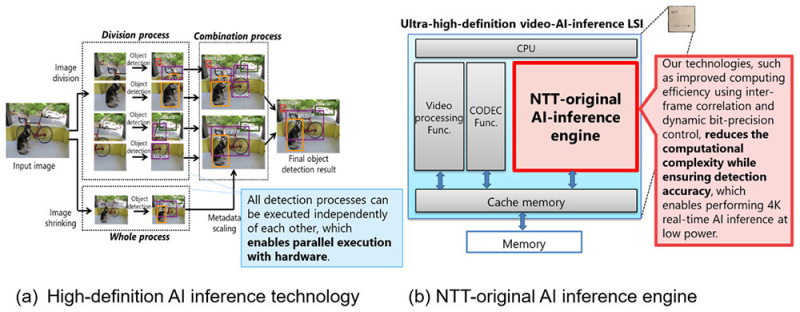

NTT представила ИИ-чип для обработки видео на периферииКомпания NTT объявила о создании ИИ-чипа, предназначенного для задач инференса на периферии. Изделие может применяться для обработки видео высокой чёткости, в том числе в формате 4K, в реальном времени на устройствах со строгими ограничениями по мощности. В качестве сфер применения новинки NTT выделяет беспилотные летательные аппараты и камеры видеонаблюдения. Например, благодаря представленному чипу дроны могут использоваться для обнаружения прохожих и объектов, таких как автомобили, с высоты до 150 м. Для повышения эффективности инференса при одновременном снижении энергопотребления задействованы специальные алгоритмы. Входное изображение высокого разрешения сегментируется на фрагменты, после чего производится независимая обработка каждого из них. Это позволяет обнаруживать объекты небольшого размера. Параллельно с этим выполняется анализ целого изображения в сжатом виде для обнаружения крупных объектов. После этого полученные результаты объединяются: таким образом, могут быть идентифицированы как небольшие, так и крупные детали. При этом все операции могут выполняться независимо друг от друга, что обеспечивает высокую эффективность. По заявлениям NTT, в случае нового изделия обнаружение объектов в реальном времени при разрешении 4K (30 к/с) возможно с тем же или более низким энергопотреблением (менее 20 Вт), что и при выполнении задачи с пониженным разрешением — 608 × 608 пикселей. Повышение эффективности вычислений достигается с помощью межкадровой корреляции и динамического управления точностью вычислений. Это позволяет добиться ИИ-инференса в реальном времени при низкой затрачиваемой мощности. На коммерческий рынок изделие планируется вывести в течение 2025 года через операционную компанию NTT Innovative Devices Corporation. Отмечается также, что NTT продолжат разработку дополнительных технологий, связанных с новым чипом.

11.04.2025 [08:56], Руслан Авдеев

Конец «зелёной повестки»: Трамп поддержал угольный сектор в США ради удовлетворения спроса ИИ ЦОД на энергиюПрезидент США Дональд Трамп (Donald Trump) подписал указы для реанимации угольного сектора страны. Ожидается, что это поможет удовлетворить растущий спрос на электричество со стороны ИИ ЦОД, сообщает Datacenter Dynamics. В прошлом году Международное энергетическое агентство (IEA) отметило, что мировое использование угля для электростанций уже достигло рекордных значений. Указ 14241 (Executive Order 14241) призван устранить федеральные нормативные барьеры, «подрывающие добычу угля». Теперь использование угля для генерации электричества для ЦОД будет поощряться, заодно будет увеличен экспорт американского угля, а также будут приняты меры, гарантирующие, что федеральная политика не будет дискриминационной в отношении угледобычи и генерации электричества с помощью угольных электростанций. Указ разрешает работать нескольким угольным электростанциям, которые ранее планировалось закрыть. Некоторые коммунальные компании уже продлили работу своих угольных электростанций в последние месяцы — рост спроса со стороны ЦОД считается главным драйвером новых процессов. Недавним примером стала Southern Company, в феврале объявившая, что намерена продлить срок работы трёх электростанций общей мощностью 8,2 ГВт — сроки закрытия перенесены с 2028 года на 2035. Похоже, что новый указ поощрит аналогичные шаги и других коммунальных компаний, особенно в районах концентрации ЦОД.

Источник изображения: Pawel Czerwinski / Unsplash Указ также предписывает федеральным ведомствам выявить запасы угля на федеральных землях, устранить нормативные барьеры для их добычи и обеспечить приоритетную выдачу лицензий на извлечение угля из недр. Также президент подписал указ, который обеспечивает угольным электростанциям иммунитет на два года от требований снизить токсичные выбросы. Поддержка угольного сектора названа «национальным приоритетом» для развития растущей промышленности и рынка дата-центров — при этом новая политика резко контрастирует с мерами принимавшимися властями в последние 25 лет. Доля угольного топлива, используемого в США, упала до приблизительно 15 % в сравнении с 2001 годом, когда он обеспечивал генерацию 51 % энергии Соединённых Штатов. Кроме того, согласно недавним данным аналитического центра Ember, хотя нынешняя администрация сокращает федеральную поддержку возобновляемой энергии, за cчёт ветра и солнца сегодня генерируется больше электричества в США, чем за счёт угля. Так, генерация солнечной энергии в США увеличилась на 64 ТВт∙ч, ветряной — на 32 ТВт∙ч, а угольной — упала на 22 ТВт∙ч. Более того, в последние годы солнечная энергетика стала более дешёвой альтернативой угольной. В 2023 году исследователи Energy Innovation выяснили, что 99 % существующих в США угольных электростанций дороже в эксплуатации в сравнении с новыми солнечными или ветряными — солнечные в среднем минимум на 30 % дешевле в этом отношении. Несмотря на это, действующая администрация, похоже, нацелена на продолжительную поддержку использования ископаемого топлива в качестве решения задачи роста рынка ЦОД. В первые несколько дней Трамп провозгласил «чрезвычайное энергетическое положение», подписал приказы, продвигающие добычу нефти и газа на Аляске, отозвал лицензии на ветряную энергетику на внешнем континентальном шельфе США и вышел из Парижского климатического соглашения. Реанимация угольного сектора приведёт к значительному росту выбросов электростанциями, угольная энергетика — одна из вреднейших для окружающей среды. Так, в сравнении с природным газом, при использовании угля выбрасывается вдвое больше углекислого газа — при этом такое топливо значительно менее энергетически эффективно. Ранее сообщалось, что Трамп уже дал «зелёный свет» ископаемому топливу и компании от Chevron до Crusoe уже готовят собственные проекты. Кроме того, ещё раньше появилась информация, что уголь может вновь стать одним из драйверов роста энергетики. Ранее сообщалось, что достижение нулевых выбросов в стране гиперскейлерами может оказаться под вопросом, но с нынешней политикой этот вопрос стал, скорее всего, второстепенным.

10.04.2025 [19:31], Руслан Авдеев

ИИ-континент: Евросоюз намерен как минимум утроить ёмкость дата-центров в ближайшие годыВ следующие пять-семь лет Евросоюз намеревается более чем втрое нарастить ёмкость своих дата-центров. Это позволит снизить зависимость от вычислительных мощностей, находящихся в других регионах мира, сообщает Computer Weekly, и сформировать крупный единый рынок общим набором «правил безопасности», которые обеспечат ИИ-технологий. Основные векторы развития подробно изложены в проекте ЕС AI Continent Action Plan. В проекте документа заявляется, что сейчас ЕС отстаёт по объёму доступных мощностей ЦОД от США и Китая, в значительной степени используя облачную инфраструктуру из других регионов мира. Это вызывает обеспокоенность у бизнеса и политиков. Для того, чтобы удовлетворить потребности предприятий и государственных органов в ИИ и вычислениях в целом, а также обеспечить суверенитет и конкурентоспособность, предлагается наращивать собственные облачные мощности и мощности ЦОД вообще. Для этого проводятся консультации по разработке «Закона о развитии облачных технологий и ИИ» (Cloud and AI Development Act), который позволит ускоренно строить новые ЦОД в Евросоюзе. В документе указывается, что сегодня среднее время получения разрешения на строительство и эколицензий в Европе часто превышает 48 месяцев, при этом площадки для строек и энергию ещё поискать надо. Новый закон должен устранить препятствия. Проектам ЦОД, соответствующим требованиям по эффективному использованию энергии и воды, разрешения будут выдавать в упрощённом порядке. Также предполагается «улучшить» конкуренцию на рынке облачных услуг, предоставив возможность выхода на него большему числу облачных провайдеров. Эти и другие действия — часть проекта Евросоюза по созданию собственного, особого подхода к развитию искусственного интеллекта, основанного на сильных сторонах объединения, позволяющих превратить ЕС в «континент ИИ».

Источник изображения: Maks Key/unsplash.com В документе упоминается, что в ЕС действуют 6300 стартапов в области ИИ, более 600 из них работают над созданием систем генеративного ИИ. Тем не менее, нужно принимать меры, чтобы обеспечить компании и исследователей ресурсами, необходимые для успешной реализации проектов. Для этого необходимо будет расширить общедоступную ИИ-инфраструктуру с созданием «гигафабрик» с энергоэффективными и высокопроизводительными вычислительными системами, которые можно будет объединить в сети. ЕС уже обязался выделить €20 млрд на финансирование ИИ-инфраструктуры, чтобы частично компенсировать расходы на создание в Европе пяти ИИ-фабрик, также стороны приглашаются к созданию государственно-частных партнёрств для ускоренного строительства соответствующих объектов. Гигафабрики станут своеобразными центрами притяжения для сотрудничества исследователей, предпринимателей и инвесторов в проектах разной направленности, от здравоохранения до робототехники и науки в целом. Превращение Евросоюза в «ИИ-сверхдержаву» также потребует доступа к более качественным данным, и активной разработки ИИ в самом ЕС, а также поощрения внедрения ИИ-систем в стратегически важных секторах. Также в документе упоминается необходимость наращивания базы талантов в сфере искусственного интеллекта — этого можно будет добиться, упростив легальную миграцию профильных квалифицированных специалистов. Документ ЕС во многом перекликается с недавно представленным проектом превращения Великобритании в «ИИ-сверхдержаву». В частности, там тоже намерены стимулировать инновации в области ИИ, наращивать вычислительные и энергетические мощности и др.

10.04.2025 [19:23], Владимир Мироненко

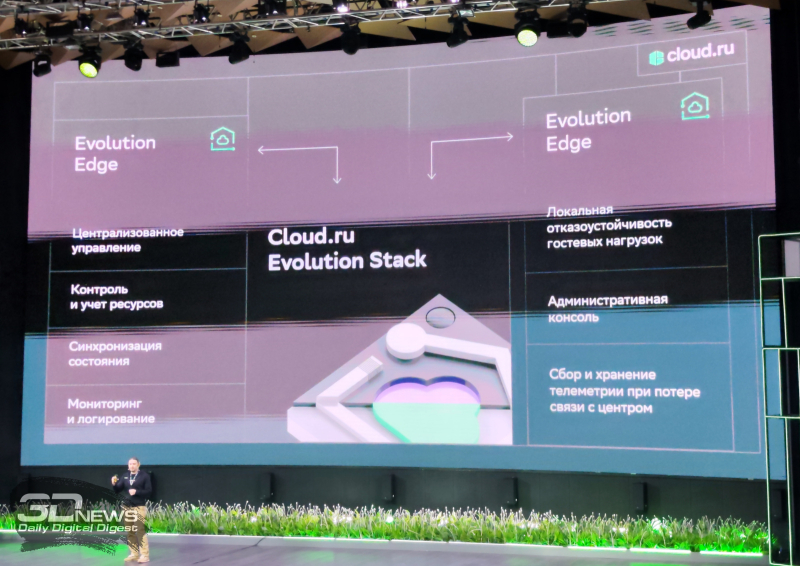

Cloud.ru готовит облачную платформу для локального развёртывания ИИ-сервисовПровайдер облачных и ИИ-технологий Cloud.ru объявил о разработке новой платформы для локального развёртывания ИИ-сервисов Cloud.ru Evolution Stack AI-bundle, представляющей собой конфигурацию решения Cloud.ru Evolution Stack, оптимизированную под выполнение ML- и ИИ-задач. Новая платформа объединит возможности частного и гибридного облака Cloud.ru с набором инструментов для быстрой и безопасной разработки ИИ-продуктов с полным контролем данных. Решение будет востребовано представителями финансового и государственного секторов, операторами облачных ЦОД, крупным ретейлом и промышленными предприятиями. Использование платформы позволит упростить запуск и масштабирование ИИ-сервисов, снизит для пользователей порог входа в разработку ИИ-решений и ускорит их внедрение предприятиями. Cloud.ru Evolution Stack AI-bundle будет включать сервисы для end-to-end ML-разработки и локального развёртывания, кастомизации и дальнейшего масштабирования моделей, в том числе:

Новая платформа будет базироваться на собственных разработках Cloud.ru в сфере ИИ, используемых в облачной платформе Cloud.ru Evolution, и свободно распространяемых компонентах. С её помощью можно будет решать ИИ-задачи в гибридном сценарии: например, обучать модели в публичном облаке, а инференс выполнять в частном контуре клиента, или, наоборот, переносить процесс в публичное облако в периоды высокой нагрузки. Используя OSS/BSS-инструменты, платформа поддерживает мультитенантную архитектуру, централизованное управление доступом, мониторинг сервисов и определение квот на используемые ресурсы. При необходимости Cloud.ru Evolution Stack AI-bundle будет дополняться другими IaaS/PaaS провайдера при создании облачного решения под ключ для использования на уровне всей инфраструктуры клиента. Также можно будет дополнять предложение Cloud.ru Evolution Stack ИИ-решениями из портфеля Evolution Stack AI-bundle. Платформа для создания гибридного и частного облака Cloud.ru входит в реестр российского программного обеспечения и соответствует требованиям импортозамещения. Помимо лицензионного ПО, разрабатываемая платформа будет доступна в составе программно-аппаратных комплексов для ИИ-задач с поставкой по подписке. По словам Cloud.ru, новая платформа обеспечит крупному бизнесу и государственным организациям возможность использования ИИ-сервисов и полного набора инструментов публичного облака Cloud.ru Evolution on-premise. |

|