Материалы по тегу: nvidia

|

09.04.2025 [17:03], Руслан Авдеев

NVIDIA и Cassava Technologies построят в Африке ИИ-фабрику за $720 млнАфриканская технологическая компания Cassava Technologies может инвестировать до $720 млн в первую в Африке «ИИ-фабрику» на базе решений NVIDIA, сообщает Bloomberg. Действующая на территории всего африканского континента компания зимбабвийского происхождения намерена развернуть ИИ-кластеры и сервисы в Южной Африке, Египте, Нигерии, Кении и Марокко. Как сообщает представитель Cassava, если компания не сделает первый шаг в деле инвестиций в ИИ, какими бы ограниченными они ни были, нельзя рассчитывать, что это сделают и другие. В компании уверены, что нельзя позволить, чтобы Африка осталась позади в деле мирового развития искусственного интеллекта. «ИИ-фабрика» Cassava рассчитана на исследователей в университетах, стартапы и разработчиков в самых разных секторах — здравоохранении, финтехе, государственном управлении. Первый кластер из 3 тыс. ускорителей NVIDIA к июню будет развёрнут в Южной Африке. В течение трёх-четырёх лет Cassava рассчитывает довести общее количество ускорителей в Африке до 12 тыс. Впрочем, сами ускорители, по словам компании — это лишь основа, а инвестиции в целом направлены на создание ИИ-экосистемы. Кроме того, компания рассчитывает продавать избыточные вычислительные мощности другим заказчикам со всего мира.

07.04.2025 [09:25], Сергей Карасёв

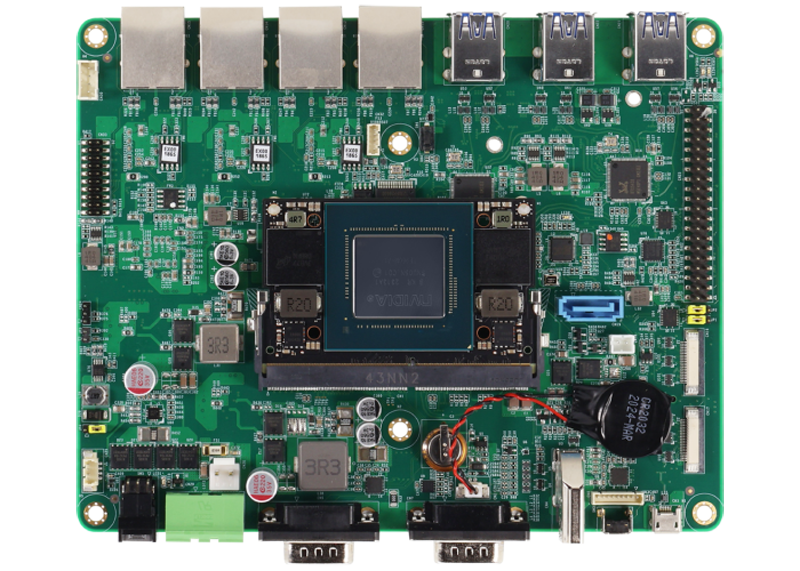

Комплект для ИИ-разработчиков AAEON NV8600-Nano содержит модуль NVIDIA Jetson Orin NanoКомпания AAEON представила под брендом UP комплект NV8600-Nano AI Developer Kit для разработчиков, создающих устройства с поддержкой ИИ. В основу новинки положен модуль NVIDIA Jetson Orin Nano Super с производительностью 67 TOPS (на операциях INT8). Названное изделие содержит процессор с шестью вычислительными ядрами Arm Cortex-A78AE и 8 Гбайт оперативной памяти LPDDR5. Присутствует GPU на архитектуре NVIDIA Ampere с 1024 ядрами CUDA и 32 тензорными ядрами. Интерфейсная плата набора NV8600-Nano AI Developer Kit располагает четырьмя сетевыми портами 1GbE с опциональной поддержкой PoE (25,6 Вт на каждый порт), шестью разъёмами USB 3.2 Gen2 Type-A, коннектором HDMI 1.4a, последовательным портом RS-232(RX/TX/GND)/422/485, SATA-разъёмом для подключения накопителя, двумя коннекторами MIPI-CSI, а также 40-контактной колодкой, совместимой с NVIDIA Jetson Orin Nano Developer Kit.

Источник изображения: AAEON На тыльной стороне платы находятся коннекторы M.2 2230 E-Key для комбинированного модуля Wi-Fi / Bluetooth, M.2 2242/3042/3052 B-Key (плюс слот для SIM-карт) для сотового модема и M.2 2280 M-Key для накопителя. Установлен NVMe SSD вместимостью 256 Гбайт. Диапазон рабочих температур простирается от -25 до +70 °C. Габариты составляют 166 × 133 мм, масса — около 190 г. В комплект поставки входят внешний адаптер питания мощностью 60 Вт, кулер с радиатором и вентилятором, а также камера Raspberry Pi Camera Module 2. Говорится о совместимости с Linux (NVIDIA Jetpack 6.0 и выше). Приобрести набор NV8600-Nano AI Developer Kit можно по ориентировочной цене $650.

05.04.2025 [10:36], Сергей Карасёв

Европейский суперкомпьютер Discoverer получил обновление в виде NVIDIA DGX H200Европейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) объявило о модернизации суперкомпьютера Discoverer, установленного в Софийском технологическом парке в Болгарии. Обновленная НРС-система получила название Discoverer+. Комплекс Discoverer, построенный на платформе BullSequana XH2000, был введён в эксплуатацию в 2021 году. Изначальная конфигурация включала 1128 вычислительных узлов, каждый из которых содержит два 64-ядерных процессора AMD EPYC 7H12 поколения Rome. Производительность (FP64) достигала 4,52 Пфлопс с пиковым значением в 5,94 Пфлопс. С такими показателями система находится на 221-й позиции в ноябрьском рейтинге мощнейших суперкомпьютеров мира TOP500. В рамках модернизации добавлен GPU-раздел на основе четырёх модулей NVIDIA DGX H200. Каждый из них содержит восемь ускорителей H200 и два процессора Intel Xeon Platinum 8480C поколения Sapphire Rapids с 56 ядрами (до 3,8 ГГц). Модули обладают быстродействием до 32 Пфлопс каждый в режиме FP8. Кроме того, обновлённый комплекс получил Lustre-хранилище вместимостью 5,1 Пбайт, систему хранения Weka ёмкостью 273 Тбайт и дополнительную ИБП-систему.

Источник изображения: EuroHPC JU Как отмечается, Discoverer стал первым суперкомпьютером EuroHPC, прошедшим серьёзную модернизацию с момента своего первоначального запуска. После наращивания мощностей комплекс планируется использовать для крупномасштабных проектов в области ИИ, таких как обучение нейронных сетей, создание цифровых двойников сложных объектов и пр. В декабре 2024 года консорциум EuroHPC выбрал площадки для первых европейских ИИ-фабрик (AI Factory): они расположатся в Финляндии, Германии, Греции, Италии, Люксембурге, Испании и Швеции. Кроме того, такие объекты планируется создать в Австрии, Болгарии, Франции, Германии, Польше и Словении. Эти площадки станут частью высококонкурентной и инновационной экосистемы ИИ в Европе.

04.04.2025 [11:29], Руслан Авдеев

NVIDIA может переключиться на выполнение заказов только из Китая в преддверии усиления санкций СШАНе исключено, что NVIDIA может заставить подождать с выполнением заказов клиентов… всех, кроме представителей китайского бизнеса. Клиенты из Поднебесной, по слухам, заказали ускорители H20 на огромную сумму $16 млрд — до того, как США, возможно, запретит продавать их в КНР, сообщает The Information. По данным китайских инсайдеров, ByteDance, Alibaba Group, Tencent Holdings и др. заказали огромное количество H20 в первые три месяца текущего года. Имеются данные о том, что таких чипов уже не хватает в Китае, и NVIDIA может сфокусировать усилия на производстве большего количества H20 для удовлетворения спроса огромного рынка до того, как предложенный запрет вступит в действие. Может быть выполнено заказов минимум на $16 млрд — это приведёт к тому, что выпуск прочих чипов компании замедлится и приведёт к ещё большему дефициту передовых ускорителей на рынке. В результате американским и европейским клиентам придётся ждать выполнения своих заказов дольше обычного.

Источник изображения: Glsun Mall/unsplash.com H20 является самым производительным ИИ-ускорителем, допущенным для поставок в Китай в соответствии с американскими экспортными ограничениями, введёнными в октябре 2023 года. Тем не менее, США могут вскоре и вовсе запретить поставки любых ускорителей. В то же время Пекин, по слухам, ужесточает контроль над продажами чипов иностранного производства — соответствующие правила уже действуют. Это предпринимается для того, чтобы китайские компании приобрели ускорители местного производства. В IDC уже заявляли, что китайские власти поддерживают и субсидируют местных производителей для выпуска чипов на архитектуре Arm. Впервые США ввели связанный с поставками в Китай чипов экспортный контроль в октябре 2022 года для замедления технологического развития Китая. В частности, были запрещены продажи передовых на тот момент ускорителей NVIDIA A100 и H100, специально ослабленные A800 и H800 запретили позже. После триумфального дебюта open source ИИ-моделей китайского стартапа DeepSeek в январе 2025 года спрос на H20 значительно вырос. И, хотя H20, по некоторым данным, в 15 раз «медленнее», чем новейшие модели серии NVIDIA Blackwell, только их ещё разрешено официально продавать в Китай после ограничений, введённых в октябре 2023 года. Ускорители применяются китайскими компаниями для обучения ИИ-моделей, хотя изначально чипы позиционировались как решения для инференса. Впрочем, как считают эксперты Moor Insights & Strategy, наращивание производства H20 не повлияет на поставки в США и Европе, поскольку для выпуска современных ускорителей Blackwell используется другой техпроцесс, т.е. другие производственные линии.

01.04.2025 [14:53], Владимир Мироненко

Arm намерена занять 50 % рынка чипов для ЦОД к концу 2025 года — NVIDIA ей в этом поможетСогласно прогнозу Arm Holdings, к концу 2025 года доля процессоров с Arm-архитектурой на мировом рынке CPU для ЦОД вырастет до 50 % с 15 % в 2024 году. В интервью агентству Reuters Мохамед Авад (Mohamed Awad), руководитель подразделения инфраструктурных решений Arm, отметил, что благодаря более низкому энергопотреблению, чем у процессоров Intel и AMD, Arm-чипы становятся все более популярными среди компаний, занимающихся облачными вычислениями. Журналист ресурса The Register обратился в Arm Holdings с просьбой пояснить, благодаря чему компания рассчитывает добиться столь стремительного роста доли на рынке. Как сообщили в британской компании, принадлежащей японскому конгломерату Softbank, её прогноз в значительной степени основан на росте поставок ИИ-серверов. Мохамед Авад сообщил The Register, что в течение следующих нескольких лет, как ожидает компания, продажи ИИ-серверов вырастут на 300 %. «Для этого увеличения энергоэффективность больше не является конкурентным преимуществом — это базовое отраслевое требование. Именно здесь вычислительная платформа Arm Neoverse является явным лидером и предпочтительной платформой для ведущих партнёров отрасли, включая AWS, Google, Microsoft и NVIDIA», — заявил он. Как утверждает Arm Holdings, Arm-архитектура всё чаще используется гиперскейлерами AWS, Google, Microsoft в своих чипах. По оценкам Bernstein Research, в 2023 году почти 10 % серверов по всему миру содержат Arm-процессоры приложений в качестве «основных мозгов», и половина из них была развёрнута Amazon, сообщившей, что у нее в облаке используется более 2 млн чипов Graviton собственной разработки. В свою очередь, Google объявила в 2024 году о выпуске собственного процессора Axion на базе Neoverse V2 для своих ЦОД, а Microsoft сообщила в конце прошлого года об общедоступности в облаке Azure инстансов с использованием процессоров собственной разработки Cobalt 100. Расширение использования этими провайдерами облачных услуг Arm-процессоров может объяснить часть роста, который Авад прогнозирует на этот год, но продукты NVIDIA также, вероятно, составят значительную долю, полагает The Register. Например, система DGX GB200 NVL72 включает 36 процессора NVIDIA Grace и 72 ускорителя Blackwell B200, что составляет 2592 ядра Arm Neoverse V2, и они, вероятно, будут востребованы в этом году, отметил ресурс. Также не следует забывать о других решениях для ЦОД, которые имеют ядра на базе Arm-архитектуры, такие как SmartNIC и DPU — BlueField-3 от NVIDIA, а также карты Nitro в серверах AWS.

31.03.2025 [10:49], Руслан Авдеев

Новые нормы энергоэффективности ИИ-ускорителей угрожают бизнесу NVIDIA в КитаеПекин представил новые нормы энергоэффективности для ИИ-ускорителей. Весьма вероятно, что они помешают китайским компаниям приобретать наиболее востребованные в Китае ускорители NVIDIA, если регуляторы всерьёз возьмутся за контроль их исполнения, сообщает The Financial Times. Национальная комиссия по развитию и реформам (NDRC) настоятельно рекомендует местным игрокам рынка ЦОД использовать ускорители, соответствующие требованиям к энергоэффективности, при строительстве новых дата-центров и расширении уже существующих объектов. Популярный в Китае ИИ-ускоритель NVIDIA H20 менее производителен, чем флагманские модели компании, но его можно официально поставлять в страну. Однако, по данным издания, на сегодняшний день H20 не соответствует новым требованиям комиссии. По информации источников, в последние несколько месяцев китайский регулятор без лишнего шума «отговаривает» местные IT-гиганты, такие как Alibaba, ByteDance и Tencent, от использования H20. Впрочем, пока правила применяются не слишком жёстко, и эти ускорители NVIDIA по-прежнему востребованы на китайском рынке. Последствия для бизнеса NVIDIA могут оказаться серьёзнее, если комиссия решит ужесточить запрет — это поставит под угрозу многомиллиардные доходы компании в Китае. Несмотря на активное строительство дата-центров, американский разработчик рискует потерять заказы, а его место займёт Huawei, чьи продукты лучше соответствуют новым «зелёным» требованиям. В настоящее время NVIDIA ищет способы повысить энергоэффективность своих решений и стремится провести переговоры с руководством NDRC для обсуждения сложившейся ситуации. Однако это приведёт к снижению производительности H20 и, соответственно, конкурентоспособности на китайском рынке.

Источник изображения: Henry Chen/unsplash.com Поскольку ограничения распространяются главным образом на новые, строящиеся ЦОД, некоторые компании обходят правила, заменяя в уже действующих дата-центрах старые ускорители на H20. В других случаях несоблюдение норм может привести к проверкам и штрафам. Хотя ограничения вступили в силу ещё в прошлом году, до недавнего времени о них не сообщалось — Китай всеми силами стремится к технологическому суверенитету в полупроводниковой сфере и активно содействует отказу местных компаний от продукции NVIDIA. Прямым конкурентом H20 считается Huawei Ascend 910B, на подходе и вариант 910C. NRDC недвусмысленно намекает на будущее отношений Пекина и NVIDIA. После ужесточения экспортных ограничений США в отношении Китая в октябре 2023 года компания специально разработала ослабленную экспортную версию H20. Однако на фоне триумфа китайских ИИ-моделей стартапа DeepSeek в стране разразился настоящий бум ИИ-технологий, и компании вроде Alibaba и Tencent активно закупают H20, особенно с учётом вероятного дальнейшего ужесточения американских санкций, включая возможный запрет на поставки даже ослабленных ускорителей. Китай — четвёртый по величине рынок для NVIDIA в мире: в 2025 фискальном году выручка компании здесь составила $17,1 млрд, или 13 % от всех продаж. Помимо Huawei, конкуренцию NVIDIA на китайском рынке может составить и Intel с её ускорителями HL328 и HL388, однако они также не соответствуют новым китайским требованиям по энергоэффективности. Впрочем, их доля в китайском импорте изначально была незначительной.

28.03.2025 [11:17], Сергей Карасёв

NVIDIA близка к приобретению облачного ИИ-провайдера Lepton AIКомпания NVIDIA, по сообщению The Information, ведёт переговоры о покупке облачного стартапа Lepton AI, который специализируется на сдаче в аренду ИИ-серверов. Стоимость сделки, как утверждается, может составить «сотни миллионов долларов». Фирма Lepton AI была основана в 2023 году: её соучредителями являются Янцин Цзя (Yangqing Jia) и Цзюньцзе Бай (Junjie Bai), бывшие исследователи лаборатории искусственного интеллекта Meta✴ Platforms. Они, в частности, принимали участие в разработке PyTorch.

Источник изображения: NVIDIA Lepton AI предоставляет облачные ресурсы, оптимизированные для различных задач ИИ, включая обучение больших языковых моделей (LLM) и инференс. Клиентам доступны разные ускорители NVIDIA, а также специальный инструмент для централизованного управления выделенными мощностями при работе одновременно с несколькими проектами. Платформа Lepton AI содержит функции для обнаружения возможных ошибок на этапе обучения LLM и всевозможных проблем технического характера, например, связанных с выделением памяти. После завершения разработки ИИ-модели клиенты могут развернуть её в облаке Lepton AI с применением инстансов, оптимизированных для задач инференса. Говорится о производительности более 600 токенов в секунду при задержках менее 10 мс. Отмечается, что Lepton AI в ходе начального раунда финансирования получила $11 млн. В число инвесторов входят CRV и Fusion Fund. На сегодняшний день штат стартапа насчитывает около 20 сотрудников. Ожидается, что приобретение Lepton AI поможет NVIDIA укрепить позиции в сегменте облачных вычислений для ИИ.

26.03.2025 [01:00], Владимир Мироненко

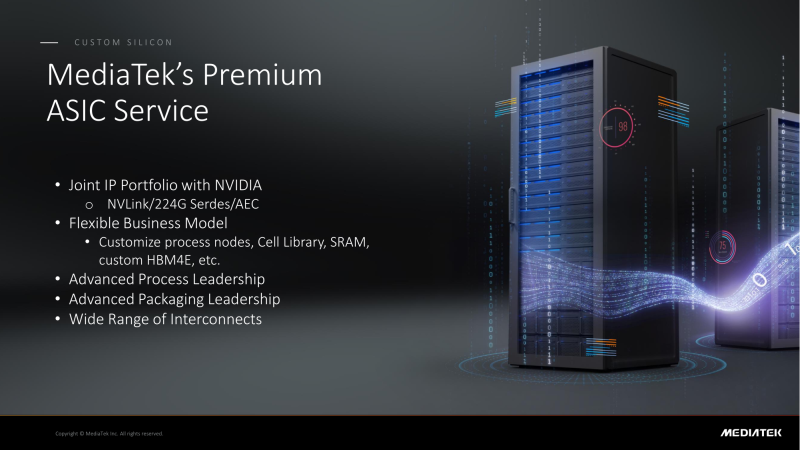

NVIDIA поделится с MediaTek фирменным интерконнектом NVLink для создания кастомных ASICMediaTek объявила о планах расширить сотрудничество с NVIDIA, интегрировав NVLink в разрабатываемые ей ASIC, сообщил ресурс DigiTimes. В свою очередь, ресурс smbom.com пишет, что партнёры намерены совместно разрабатывать передовые решения с использованием NVLink и 224G SerDes. Аналитики предполагают, что выход NVIDIA в сектор ASIC позволит ей ускорить дальнейшее продвижение на рынке с использованием опыта MediaTek и при этом решать имеющиеся проблемы. Как ожидают аналитики, по мере развития сотрудничества двух компаний всё больше провайдеров облачных услуг будет проявлять интерес к работе с MediaTek. Внедрение NVLink в ASIC MediaTek может значительно повысить привлекательность сетевых решений NVIDIA. Объединив усилия, NVIDIA и MediaTek смогут предложить комплексную разработку кастомных ASIC, которая будет включать поддержку HBM4e, обширную библиотеку IP-блоков, передовые процессы производства и упаковки. MediaTek отдельно подчеркнула, что её SerDes-блоки является ключевым преимуществом при разработке ASIC. Компании расширяют сотрудничество с ведущими мировыми производствами полупроводников, ориентируясь на передовые техпроцессы. Применяя технологию совместной оптимизации проектирования (DTCO), они стремятся достичь оптимального соотношения между производительностью, энергопотреблением и площадью (PPA). Сообщается, что несколько облачных провайдеров уже изучают объединённое IP-портфолио NVIDIA и MediaTek. По неофициальным данным, Google уже прибегла к услугам MediaTek при разработке 3-нм TPU седьмого поколения, которое поступит в массовое производство к III кварталу 2026 года. Ожидается, что переход на 3-нм процесс принесет MediaTek более $2 млрд дополнительных поступлений. По данным источников в цепочке поставок, восьмое поколение TPU перейдёт на 2-нм процесс TSMC, что вновь укрепит позиции MediaTek. Также прогнозируется, что предстоящий выход чипа GB10 совместной разработки NVIDIA и MediaTek, и долгожданного чипа N1x, значительно улучшат бизнес-операции MediaTek и ещё больше укрепят позиции компании в полупроводниковой отрасли. Эксперты отрасли считают, что MediaTek имеет все возможности для того, что стать ключевым бенефициаром роста спроса на ИИ-технологии, особенно для малых и средних предприятий.

25.03.2025 [21:13], Владимир Мироненко

Из-за проблем с ИИ Apple резко поменяла курс и решила потратить $1 млрд на суперускорители NVIDIA GB300 NVL72В отличие от других крупных технологических компаний, которые активно инвестируют в развёртывание ИИ ЦОД, Apple долгое время избегала резкого увеличения капитальных вложений в это направление. Но, похоже, ситуация изменилась, и Apple тоже начала наращивать инвестиции в это направление, пишет ресурс Investor's Business Daily (IBD). Аналитик Loop Capital Ананда Баруа (Ananda Baruah) сообщил в понедельник в записке для инвесторов, что Apple размещает заказы на поставку систем NVIDIA GB300 NVL72 на сумму около $1 млрд. Речь идёт о приблизительно 250 системах стоимостью $3,7– $4 млн каждая, пояснил аналитик. Баруа также сообщил, что Apple привлекла Dell и Supermicro к работе над собственным большим серверным кластером для поддержки приложений генеративного ИИ. Аналитик рассказал, что на текущий момент об этом проекте мало данных, но, похоже, Apple намерена использовать кластер для работы с большими языковыми моделями (LLM). Ранее компания сотрудничала с Google Cloud и использовала TPU для обучения своих ИИ-моделей. Для безопасного инференса компания использует серверы на базе собственных чипов серии M. По слухам, компания также работает над собственными серверными ИИ-ускорителями при поддержке Broadcom. Ананда Баруа считает, что резкая смена стратегии Apple связана с проблемами с выводом на рынок своего обновленного цифрового помощника Siri с поддержкой ИИ, который был анонсирован в прошлом году на конференции WWDC 2024. Компания планировала запустить новые функции Siri в начале этого года, но, похоже, что это произойдёт только в 2026 году. Один из топ-менеджеров Apple назвал задержки и промахи с запуском функций ИИ-платформы Apple Intelligence «отвратительными» и «позорными», поскольку компания продвигала возможности ИИ в телевизионной рекламе, сообщил ранее Bloomberg. В связи с этим на компанию уже подали в суд. В итоге новым руководителем направления ИИ вместо Джона Джаннандреа (John Giannandrea) был назначен Майк Роквелл (Mike Rockwell), глава отдела разработки Vision Pro.

25.03.2025 [12:52], Сергей Карасёв

«Скала^р» представила Машину для искусственного интеллекта — отечественный аналог NVIDIA DGX SuperPODКомпания «Скала^р» анонсировала специализированный программно-аппаратный комплекс (ПАК) для работы с ИИ-моделями — Машину Скала^р МБД.ИИ. Эта система, как утверждается, представляет собой функциональный аналог платформ NVIDIA DGX SuperPOD и Huawei Atlas 900 PoD. Полностью технические характеристики новинки пока не раскрываются. Известно, что Машина Скала^р МБД.ИИ использует интерконнект NVLink с возможностью объединения двух, четырёх или восьми ускорителей. Задействованы технологии GPUDirect и NVMe-oF для обработки и передачи данных, а также система прямого доступа к ресурсам RDMA. Заявлена поддержка всех популярных фреймворков для машинного обучения: TensorFlow, PyTorch, Keras и др. Вычислительный комплекс будет предлагаться в конфигурациях с ускорителями NVIDIA и в вариантах с альтернативными ИИ-картами, в том числе на основе неназванных тензорных процессоров. Кроме того, в разработке находятся решения с поддержкой отечественных ускорителей. Возможно развёртывание системы как в дата-центре заказчика, так и в составе частных и гетерогенных облачных систем. Машина может интегрироваться с другими ПАК семейства Скала^р, предназначенными для работы с большими данными. Для нового комплекса подтверждена совместимость с различными платформами машинного обучения и моделями ИИ, в том числе MTS AI Cotype Pro, T1 Сайбокс, Red_Mad_Robot Neuraldeep.tech, WaveAccess ValueAI, DeepSeek и LLaMA. По заявлениям разработчика, система имеет гибкую унифицированную архитектуру, соответствующую отраслевым стандартам, что позволяет использовать её с YandexGPT, GigaChat и др. Развёртывание приложений ИИ в контейнерной среде обеспечивает эффективное использование аппаратных ресурсов, а реализация интерконнекта с применением топологий Fat-tree, HyperCube, DragonFly или классической архитектуры Leaf-Spine даёт возможность более гибко масштабировать вычислительный кластер. Среди преимуществ Машины Скала^р МБД.ИИ названы:

«Машина Скала^р МБД.ИИ позволяет создать надёжную и производительную инфраструктуру для работы с искусственным интеллектом, используя проверенные технологии и компоненты из реестра Минпромторга и Минцифры РФ с подтверждённой производительностью до 1,5 Пфлопс на вычислительный кластер. Мы видим большой потенциал применения комплекса в различных отраслях экономики, включая промышленность и финансы, где использование ИИ помогает существенно повысить эффективность бизнес-процессов», — говорит директор по технологическим инновациям Скала^р. |

|