Материалы по тегу: google

|

17.02.2025 [17:42], Руслан Авдеев

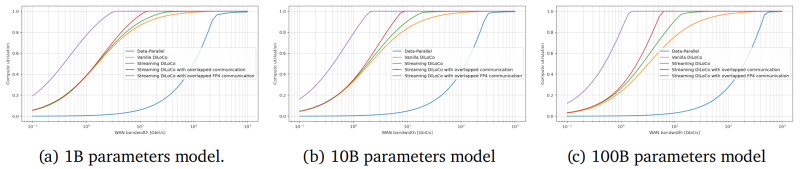

Исследователи DeepMind предложили распределённое обучение больших ИИ-моделей, которое может изменить всю индустриюПосле того, как ИИ-индустрия немного отошла от шока, вызванного неожиданным триумфом китайской DeepSeek, эксперты пришли к выводу, что отрасли, возможно, придётся пересмотреть методики обучения моделей. Так, исследователи DeepMind заявили о модернизации распределённого обучения, сообщает The Register. Недавно представившая передовые ИИ-модели DeepSeek вызвала некоторую панику в США — компания утверждает, что способна обучать модели с гораздо меньшими затратами, чем, например, OpenAI (что оспаривается), и использованием относительно небольшого числа ускорителей NVIDIA. Хотя заявления компании оспариваются многими экспертами, индустрии пришлось задуматься — насколько эффективно тратить десятки миллиардов долларов на всё более масштабные модели, если сопоставимых результатов можно добиться в разы дешевле, с использованием меньшего числа энергоёмких ЦОД. Дочерняя структура Google — компания DeepMind опубликовала результаты исследования, в котором описывается методика распределённого обучения ИИ-моделей с миллиардами параметров с помощью удалённых друг от друга кластеров при сохранении необходимого уровня качества обучения. В статье «Потоковое обучение DiLoCo с перекрывающейся коммуникацией» (Streaming DiLoCo with overlapping communication) исследователи развивают идеи DiLoCo (Distributed Low-Communication Training или «распределённое обучение с низким уровнем коммуникации»). Благодаря этому модели можно будет обучать на «островках» относительно плохо связанных устройств.

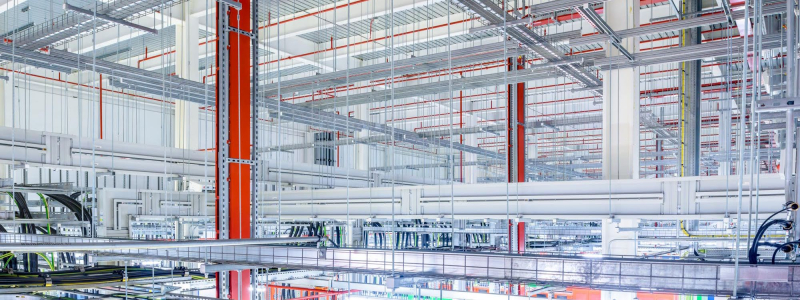

Источник изображения: Igor Omilaev/unsplash.com Сегодня для обучения больших языковых моделей могут потребоваться десятки тысяч ускорителей и эффективный интерконнект с большой пропускной способностью и низкой задержкой. При этом расходы на сетевую часть стремительно растут с увеличением числа ускорителей. Поэтому гиперскейлеры вместо одного большого кластера создают «острова», скорость сетевой коммуникации и связность внутри которых значительно выше, чем между ними. DeepMind же предлагает использовать распределённые кластеры с относительно редкой синхронизацией — потребуется намного меньшая пропускная способность каналов связи, но при этом без ущерба качеству обучения. Технология Streaming DiLoCo представляет собой усовершенствованную версию методики с синхронизацией подмножеств параметров по расписанию и сокращением объёма подлежащих обмену данных без потери производительности. Новый подход, по словам исследователей, требует в 400 раз меньшей пропускной способности сети. Важность и потенциальную перспективность DiLoCo отмечают, например, и в Anthropic. В компании сообщают, что Streaming DiLoCo намного эффективнее обычного варианта DiLoCo, причём преимущества растут по мере масштабирования модели. В результате допускается, что обучение моделей в перспективе сможет непрерывно осуществляться с использованием тысяч разнесённых достаточно далеко друг от друга систем, что существенно снизит порог входа для мелких ИИ-компаний, не имеющих ресурсов на крупные ЦОД. В Gartner утверждают, что методы, уже применяемые DeepSeek и DeepMind, уже становятся нормой. В конечном счёте ресурсы ЦОД будут использоваться всё более эффективно. Впрочем, в самой DeepMind рассматривают Streaming DiLoCo лишь как первый шаг на пути совершенствования технологий, требуется дополнительная разработка и тестирование. Сообщается, что возможность объединения многих ЦОД в единый виртуальный мегакластер сейчас рассматривает NVIDIA, часть HPC-систем которой уже работает по схожей схеме.

08.02.2025 [16:14], Сергей Карасёв

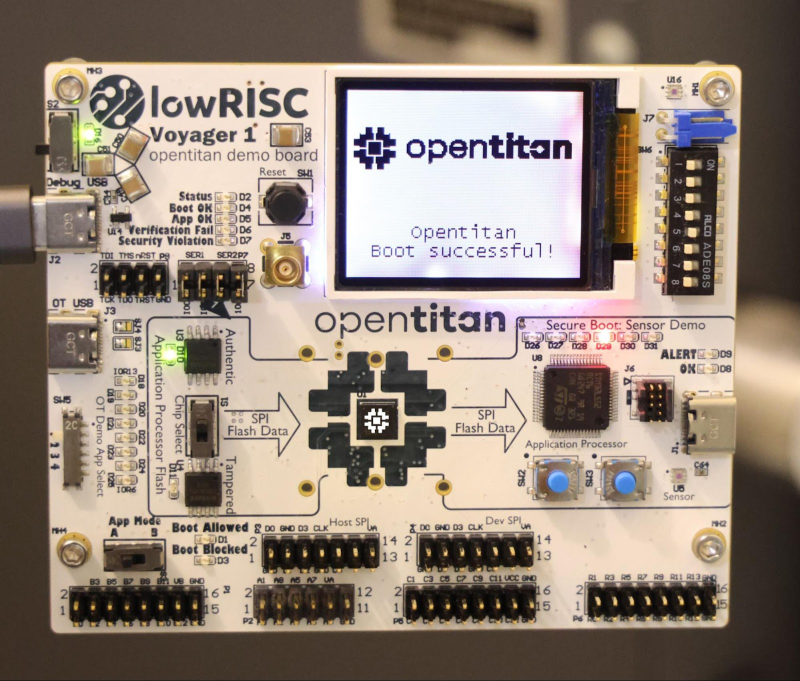

Начато производство первых чипов безопасности на открытой платформе OpenTitanКорпорация Google объявила о начале производства первого чипа, построенного на аппаратной платформе с открытым исходным кодом OpenTitan. Целью инициативы является создание открытой, доступной и надёжной аппаратной реализации Root of Trust (RoT). Проект OpenTitan был начат с нуля в 2018 году. Помимо Google, в нём участвуют Nuvoton, Швейцарская высшая техническая школа Цюриха (ETH Zurich), G+D Mobile Security, lowRISC, Rivos, Seagate, Western Digital, Winbond, zeroRISC и др. Первый чип на базе OpenTitan, пока не получивший определённого названия, изготавливается компанией Nuvoton. Изделие использует архитектуру RISC-V. Отмечается, что в ближайшее время чип станет доступен в составе демонстрационной платы Voyager 1 от lowRISC, а позднее в текущем году появится в хромбуках и решениях для дата-центров. Целью проекта OpenTitan является обеспечение безопасной загрузки критически важных компонентов системы с использованием авторизованного и открытого кода. Чипы OpenTitan могут применяться в самом разном оборудовании — от серверных материнских плат, сетевых карт и маршрутизаторов до потребительских устройств и IoT-продуктов. Google и другие участники инициативы предоставляют исходный код, а также руководства по интеграции и эталонную прошивку. Ожидается, что в перспективе OpenTitan создаст основу, позволяющую повысить уровень доверия к ИТ-платформам и снизить издержки при разработке специализированных чипов для обеспечения безопасности. В настоящее время Nuvoton поставляет образцы изделий OpenTitan для тестирования и оценки, а массовое производство намечено на весну нынешнего года.

06.02.2025 [19:27], Руслан Авдеев

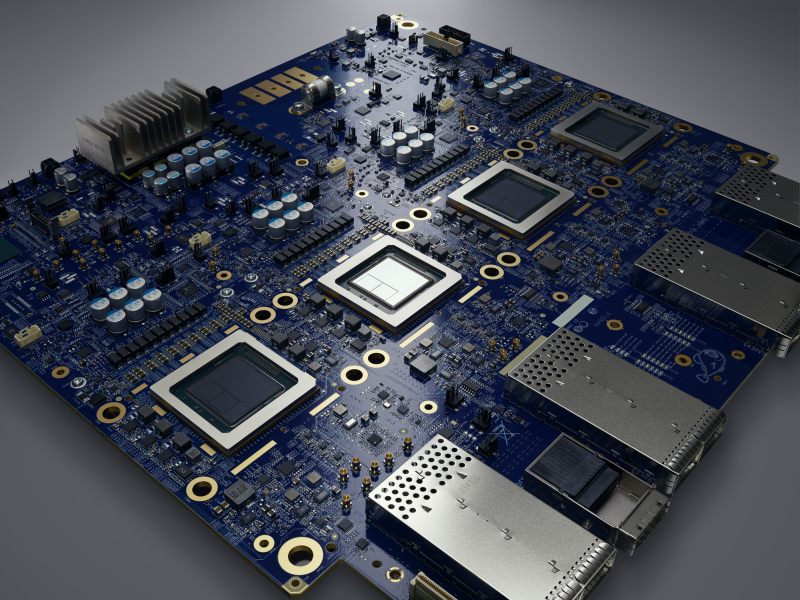

Грамм на экзафлоп — Google ввела новую метрику CCI для оценки углеродных выбросов ИИ-ускорителейGoogle опубликовала результаты внутреннего исследования, показавшие прогресс в повышении углеродной эффективности своих ИИ-ускорителей TPU. По словам компании, за два поколения — от TPU v4 до Trillium (v6) — усовершенствование аппаратной оборудования привело к трёхкратному повышению экологичности выполняемых ИИ-нагрузок. Оценка всего жизненного цикла (LCA) ускорителей позволяет подробно проанализировать статистику выбросов, связанных с ИИ-ускорителями Google, используя полный набор данных — от добычи сырья и производства чипов до потребления электричества во время работы. Компания даже ввела новую метрику Compute Carbon Intensity (CCI), позволяющую оценить углеродные выбросы относительно производительности. CCI показывает, сколько граммов выбросов CO2 приходится на каждый экзафлоп проделанной работы. Чем ниже CCI, тем ниже выброс оборудования для заданной рабочей нагрузки. Для оценки прогресса Google сравнила пять моделей TPU в течение всего их жизненного цикла и пришла к выводу, что TPU новых поколений стали значительно экологичнее, поскольку CCI за четыре года улучшился втрое. TPU Trillium, очевидно, показали наилучшие результаты. Google отмечает, что за весь жизненный цикл TPU 70 % выбросов относятся к эксплуатационным, т.е. связаны с потреблением электричества. Это подчёркивает важность повышения энергоэффективности чипов и снижения выбросов углерода, связанных с энергообеспечением. Однако доля выбросов, связанных с производством, по-прежнему весьма заметна. Более того, со временем она может даже увеличиться, поскольку к 2030 году Google намерена добиться использования полностью безуглеродной энергии в каждой энергосети, питающей её оборудование. Если компания захочет и далее повышать экологичность своих решений, ей придётся вмешаться в цепочки поставок. Кроме того, постоянная оптимизация ИИ-моделей позволит сократить объёмы необходимых вычислений (при прочих равных). Впрочем, повышение эффективности моделей, скорее всего, приведёт к ещё большему использованию ИИ. В будущем Google намерена анализировать углеродные выбросы отдельных ИИ-моделей и влияние на их оптимизации ПО. А пока что выбросы парниковых газов Google из-за ИИ только растут — +48 % за пять лет.

05.02.2025 [23:04], Владимир Мироненко

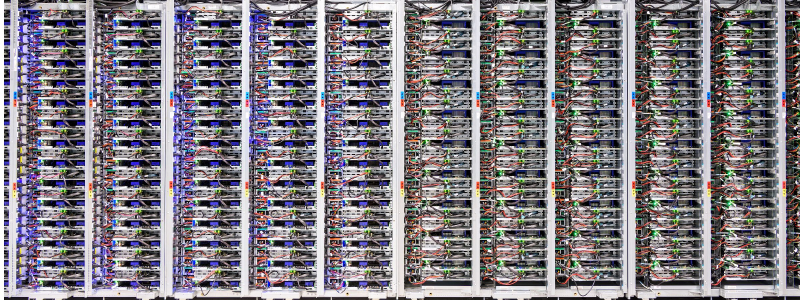

Рост Google Cloud замедлился, но ради ИИ компания готова потратить $75 млрд на серверы и ЦОД в 2025 годуХолдинг Alphabet, материнская структура Google, сообщил финансовые результаты IV квартала и всего 2024 финансового года, завершившегося 31 декабря. По итогам 2024 года чистая прибыль Alphabet впервые превысила отметку в $100 млрд, составив $100,12 млрд при выручке в $ 350,02 млрд, выросшей год к году на 14 %. Результаты Alphabet оказались ниже прогнозов Уолл-стрит, поэтому акции холдинга упали на 9 % во вторник на внебиржевых торгах. Консолидированная выручка Alphabet в IV квартале 2024 года выросла на 12 % в годовом исчислении до $96,47 млрд США, что, как утверждает холдинг, отражает устойчивую динамику во всём бизнесе. Вместе с тем показатель оказался ниже консенсус-прогноза аналитиков, опрошенных LSEG, полагавших, что выручка должна быть выше — в пределах $96,56 млрд. Также аналитиков разочаровал квартальный доход облачного подразделения Google Cloud, составивший $11,96 млрд, что на 30 % выше прошлогоднего результата, но ниже консенсус-прогноза в размере $12,19 млрд экспертов, опрошенных StreetAccount. Чистая прибыль Alphabet выросла на 28 % до $26,54 млрд, превысив прогноз аналитиков LSEG в размере $26,0 млрд, при этом чистая прибыль на акцию выросла на 31 % до $2,15, что выше ожиданий аналитиков, опрошенных LSEG, в размере $2,13 на акцию. Alphabet объявил, что выделит $75 млрд на капитальные затраты в 2025 году по сравнению с $52,5 млрд в прошлом году. Это тоже вызвало вопросы у инвесторов, поскольку разница более чем в $22 млрд могла быть добавлена к прибыли холдинга. При этом другие гиперскейлеры также увеличат траты на инфраструктуру: Meta✴ готова вложить $60–65 млрд, а Microsoft — $80 млрд. В свою очередь, руководство Alphabet настаивает на том, что инвестиции оправданны, поскольку Google Cloud сейчас не в состоянии удовлетворить спрос на ИИ-технологии. Финансовый директор Alphabet Анат Ашкенази (Anat Ashkenazi) заявила в ходе онлайн-конференции с аналитиками, что холдинг прилагает все усилия, чтобы развернуть больше мощностей и справиться со спросом. По её словам, эти цифры в первую очередь отражат инвестиции в техническую инфраструктуру, причем крупнейшим компонентом являются инвестиции в серверы, за которыми следуют ЦОД «для поддержки роста бизнеса Google Services, Google Cloud и Google DeepMind». «Мы находимся в ситуации с дефицитом предложения при высоком спросе, и усердно работаем над тем, чтобы ввести больше мощностей в эксплуатацию», — отметила Ашкенази. Она сообщила, что темпы роста облачного подразделения Google могут измениться в 2025 году, поскольку компания продолжает закупать всё больше оборудования и строить больше объектов. По её словам, капитальные затраты Alphabet в I квартале составят от $16 до $18 млрд, и квартальный показатель изменится в течение года. Это выше прогноза аналитиков FactSet в размере $14,3 млрд. Капитальные затраты Alphabet за IV квартал составили $14 млрд превысив ожидания Уолл-стрит в $13,26 млрд, согласно StreetAccount. Сомнения инвесторов в правильности инвестиционной политики Alphabet усилились после анонса китайским стартапом DeepSeek ряда ИИ-моделей, расходы на обучение которых оказались гораздо ниже, чем у Google. «Неутешительные результаты Cloud говорят о том, что импульс, основанный на ИИ, может начать ослабевать как раз в то время, как стратегия Google с закрытой моделью ставится под сомнение DeepSeek», — отметила Эвелин Митчелл-Вольф (Evelyn Mitchell-Wolf), аналитик исследовательской компании Emarketer. Что касается остальных подразделений Alphabet, то рост доходов от рекламы Google составил 10,6 % по сравнению с 11 % годом ранее. Доходы от поиска выросли год к году на 12,0 % до $54,03 млрд по сравнению с ростом на 12,7 % в IV квартале 2023 года. Доходы от рекламы на YouTube выросли на 13,8 % до $10,47 млрд по сравнению с 15,5 % роста годом ранее, а рост всех доходов сервисов (Google Services) составил 10,2 % по сравнению с 12, % годом ранее.

26.12.2024 [18:17], Руслан Авдеев

Omdia: быстрый рост спроса на TPU Google ставит под вопрос доминирование NVIDIA на рынке ИИ-ускорителейНовейшее исследование Omdia показывает, что быстрый рост спроса на кастомные ИИ-ускорители Google (TPU) формирует особый тренд. Не исключено, что он станет достаточно сильным для того, чтобы начать процесс, способный прекратить доминирование NVIDIA на рынке ускорителей, сообщает Omdia. Результаты III квартала компании Broadcom, чьё подразделение Semiconductor Solutions выполняет аутсорс-заказы Google, Meta✴ и некоторых других IT-гигантов, дают по-новому взглянуть на рынок ускорителей. В частности, они позволяют оценить покупательские тенденции и косвенно получить информацию, которая обычно скрывается. Например, как много кастомных процессоров покупает Google. Глава Broadcom Хок Тан (Hock Tan) неоднократно пересматривал планы выручки от ИИ-полупроводников, в этом году компания намерена заработать $12 млрд. Исходя из этого ожидается, что на TPU Google придётся от $6 млрд (близко к текущим оценкам Omdia) до $9 млрд, в зависимости от распределения выручки между вычислительными и сетевыми решениями. В сумму целиком входит и выручка от чипов Meta✴ MTIA. В следующем году у Broadcom, вероятно, появится и загадочный третий заказчик. Им может стать Apple, которая сейчас активно использует для обучения моделей именно TPU. По словам экспертов Omdia, даже с учётом того, что соотношение выручки от вычислительных и сетевых устройств точно не определено, поставки TPU даже «по нижней границе» в $6 млрд свидетельствуют о росте достаточно быстром, чтобы впервые отвоевать часть доли рынка у NVIDIA. По оценкам TechInsights, в 2023 году поставки TPU достигли 2 млн шт., а ускорителей NVIDIA для ЦОД — 3,8 млн шт. Стоит отметить, что выручка бизнеса Google Cloud Platform продолжает расти как часть выручки Google, при этом растёт и рентабельность подразделения. Это может свидетельствовать о том, что инстансы на основе TPU выступают драйверами роста Google Cloud и являются высокоприбыльными продуктами. В середине ноября Google и NVIDIA показали первые результаты TPU v6 и B200 в ИИ-бенчмарке MLPerf Training, где ускорители продемонстрировали неоднозначные результаты в разных сравнениях.

12.12.2024 [08:57], Владимир Мироненко

Google попросила регулятора разорвать эксклюзивное облачное соглашение Microsoft и OpenAI из-за вреда конкуренцииGoogle попросила Федеральную торговую комиссию США (FTC) разорвать эксклюзивное облачное соглашение Microsoft с OpenAI, в рамках которого разработчик ИИ-чат-бота ChatGPT использует её облачную инфраструктуру для функционирования своих сервисов и других задач, сообщил ресурс The Information. Просьба Google поступила после того, как FTC запросила у неё отзыв о деловой практике Microsoft в рамках более широкого расследования, касающегося лицензирования софтверным гигантом ПО, а также облачных вычислений, предложений по обеспечению кибербезопасности и услуг ИИ. По словам Google, соглашение о партнёрстве Microsoft и OpenAI, которое позволяет Microsoft быть единственным поставщиком облачных сервисов, размещающим передовые модели OpenAI, создает значительные рыночные барьеры и потенциально увеличивает затраты для клиентов облачных сервисов, желающих получить доступ к передовым технологиям ИИ То, что Microsoft является крупнейшим инвестором OpenAI, вложившим в неё более $13 млрд, объясняет столь тесное сотрудничество двух компаний, но другим технологическим компаниям, которые конкурируют с Microsoft на облачном рынке, таким как Google и Amazon, тоже хотелось бы размещать у себя в облаке модели OpenAI, чтобы их облачным клиентам не нужно было обращаться к услугам Microsoft для получения доступа к технологии стартапа, говорится в публикации The Information. Ведущие игроки считают, что нынешнее эксклюзивное соглашение ограничивает конкуренцию на облачном рынке и выбор клиентов. Как утверждают источники ресурса, компании, которые приобретают технологию OpenAI через Microsoft, могут столкнуться с дополнительными расходами, если они не используют решения Microsoft для своей работы. Google и другие участники рынка отметили, что такой подход к ценообразованию может навредить клиентам и ограничить доступ к ИИ-технологиям.

02.12.2024 [21:29], Руслан Авдеев

Google предлагала европейским облакам миллионы евро для продолжения борьбы с MicrosoftСогласно закрытым документам, тексты которых попали в распоряжение The Register, в своё время Google Cloud предлагала «финансовые стимулы» на сотни миллионов евро для организации европейских облачных провайдеров CISPE, жаловавшихся регуляторам на Microsoft. Как свидетельствуют источники, представитель Google общался как с руководством группы, так и со всему участниками организации CISPE. В ходе одной из презентаций предлагалось создать для участников организации Фонд инноваций в объёме €4 млн, который использовался бы для финансирования проектов и лицензионных сборов участников CISPE, для поддержки инноваций в открытых облачных экосистемах. На каждого участника пришлось бы порядка €100 тыс. — сейчас в CISPE 36 членов, в том числе Oxya, Leaseweb, UpCloud и даже AWS, единственная «неевропейская» компания. Ещё в июле группа включала лишь 27 компаний. Дополнительно Google предложила выделить CISPE ещё €10 млн в качестве «ресурсов на участие и членство». Наконец, Google предложила участникам CISPE кредиты на использование Google Distributed Cloud в размере €100 млн в течение пяти лет. При этом в презентации подчёркивалось, что фонд инноваций и программная платформа будут доступны действующим членам CISPE с условием «сохранения организацией неограниченных возможностей в продвижении принципов справедливого ПО».

Источник изображения: David Clode/unsplash.com Предполагается, что предложение было сделано с целью убедить участников CISPE не отказываться от жалоб на Microsoft, связанных с политикой лицензирования последней, которая делает использование продуктов редмондского гиганта в чужих облаках неоправданно дорогим. Жалобу подали в ноябре 2022 года, но позже Microsoft небезвозмездно уговорила большинство участников CISPE (кроме гиперскейлеров) отказаться от претензий — о попытках Google остановить этот процесс сообщалось ранее. Правда, в самой Google заявляют, что жалоба и финансовые стимулы с её стороны никак не связаны. Несмотря на отчаянные попытки Google, CISPE приняла решение отказаться от тяжб с Microsoft. По слухам, последняя потратила на улаживание претензий €10–€30 млн. При этом членам CISPE станет доступно решение Azure Local (Stack HCI) для развёртывания облака на базе собственной инфраструктуры. Источники в CISPE сообщают, что устали бороться с Microsoft и хотят просто решить проблему лицензирования, а не начинать новую войну, навязываемую Google. Microsoft, вполне возможно, тоже так или иначе заплатила участникам CISPE за отказ от преследования. Сама Google создала Open Cloud Coalition (OCC), в которую входят преимущественно небольшие британские облачные операторы и один испанский провайдер. Microsoft уже назвала группу «искусственным газоном, созданным Google» для дискредитации компании и введения регуляторов в заблуждение. OCC заявляет, что выступает за открытые стандарты и против ограничительного лицензирования и иных барьеров, мешающих конкуренции и инновациям — в Google обеспокоены тем, что массовый переход в облако Microsoft фактически лишает её клиентов. OCC можно использовать для лоббирования и жалоб в Управлении по конкуренции и рынкам Великобритании (CMA). В Евросоюзе Google также подавала жалобу на антиконкурентные практики и доминирование Microsoft в сфере облачного ПО в сентябре. Впрочем, большую часть облачного рынка Европы и так занимают AWS, Microsoft и Google. По данным Synergy Research, во II квартале 2024 года расходы на облачный рынок в Европе составили $16 млрд. На долю AWS пришлось 32 % рынка, Microsoft — 26 %, а на Google — 15 %. Крупнейшие конкуренты Microsoft называют политику лицензирования её ПО несправедливой. Так, за использование Windows Server вне Azure обходится вчетверо дороже. Тем не менее, по словам представителя CISPE, общавшегося с The Register, участники организации проголосовали за предложения Microsoft, оптимальные для европейского облачного сектора. Ранее представитель Google уклонился от прямого ответа на вопрос о том, предлагала ли компания заплатить участникам CISPE за продолжение тяжбы с Microsoft. Ранее топ-менеджмент Google официально заявлял, что оплата не предлагалась.

30.11.2024 [22:21], Руслан Авдеев

Google купила в Финляндии 1400 га земли для строительства новых ЦОДGoogle купила у финского государственного лесного ведомства Metsähallitus земли в окрестностях Каяани (Kajaani) и Мухос (Muhos) для строительства дата-центров. Сделка стоимостью €27 млн ($28,5 млн) обеспечит компанию четырьмя участками общей площадью 1400 га, сообщает Datacenter Dynamics. Мухос является муниципалитетом на севере страны, а Каяани — городом, расположенным к востоку от него в муниципалитете Кайнуу. По словам мэра Каяани Яри Толонена (Jari Tolonen), экосистема ЦОД Финляндии быстро росла в последние годы, и план Google, предусматривающий дальнейшее развитие цифровой инфраструктуры — очень позитивный сигнал для городов и целых регионов Финляндии, в частности, её северной и восточной частей. Власти Каяани также вложили немало средств в развитие экосистемы ЦОД. В том же городе находится самый мощный в Европе суперкомпьютер LUMI, а также правительственный ЦОД и объект Borealis. Все три находятся на месте старой бумажной фабрики.

Источник изображения: Google Уже действующий ЦОД Google тоже построен на территории перепрофилированной бумажной фабрики в Хамине (Hamina). Компания использует существующую инфраструктуру для охлаждения дата-центра морской водой. В мае Google объявила о намерении потратить на расширение площадки €1 млрд ($1,055 млрд), в результате чего общий объём инвестиций компании в Финляндии превысит €4,5 млрд. В следующем году ЦОД начнёт обеспечивать 80 % потребностей местного округа в отоплении. По словам представителя Google, компания сотрудничала с властями Хамины задолго до принятия инвестиционного решения о развитии площадок в Каяни и Мухосе. Однако покупка земли не даёт гарантии того, что компания построит там ЦОД. У неё уже есть опыт перепродажи купленных для ЦОД участков. Премьер-министр Финляндии Петтери Орпо (Petteri Orpo) заявил, что очень рад новым проектам Google, а приобретение земель может стать основой для новых будущих инвестиций. Это своего рода сигнал о том, что Финляндии удалось стать безопасной и интересной для инвестиций страной, и местные реформы направлены на то, чтобы сделать её ещё привлекательнее. Впрочем, не всё так благополучно, как кажется. Недавно в Балтийском море были повреждены кабели, связывавшие Литву и Швецию, а также Финляндию и Германию.

26.11.2024 [16:45], Руслан Авдеев

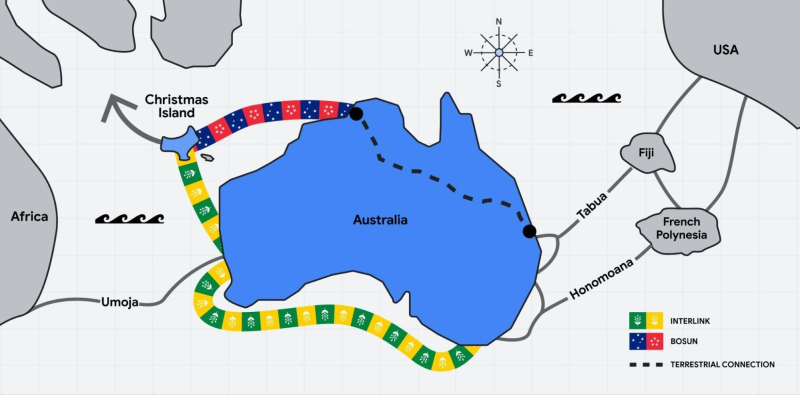

Google протянет подводный кабель из Австралии до острова РождестваПринадлежащему Австралии острову Рождества в Индийском океане обеспечат кабельное интернет-подключение к материку — вторая посадочная станция будет построена в североавстралийском гарнизонном городе Дарвин. Проект поддерживается компанией Google, сообщает Reuters. Остров Рождества расположен в 1500 км к западу от побережья Австралии, его население составляет всего 1250 человек, но стратегическое положение в Индийском океане делает локацию весьма важной для Австралии — австралийские владения находятся всего в 350 км от Джакарты. Информация появилась на фоне сведений о модернизации американскими и австралийскими военными аэродромов на севере австралийского континента, в следующем году к ротации войск в регионе должна присоединиться и Япония. Google объявила, что кабель Bosun — не единственный новый проект. Ещё один подводный кабель свяжет Мельбурн (восточное побережье континента) с Пертом (западное побережье), а также с островом Рождества и Сингапуром. Австралия в перспективе стремится снизить уязвимость своей интернет-инфраструктуры, прокладывая больше собственных подводных цифровых магистралей — в Азию и через южную часть Тихого океана в Соединённые Штаты.

Источник изображения: Google Партнёрами кабельного проекта также являются австралийский строитель ЦОД NextDC, а также поддерживаемая Macquarie телекоммуникационная группа Vocus и Subco. Ранее Subco уже проложила кабель в Индийском океане из Перта в Оман с ответвлениями к американской военной базе на Диего-Гарсии, а также к Кокосовым островам. Австралия в настоящее время модернизирует взлётно-посадочную полосу на этих островах для самолётов-шпионов. Хотя от острова Рождества до Кокосовых островов 900 км, они считаются «соседями» в Индийском океане и играют ключевую роль в операциях по наблюдению за регионом. Здесь Китай активно развивает деятельность своего подводного флота. Дополнительно кабели планируется подключить к сети, которая строится для тихоокеанских островов. Этот проект осуществляется Google при поддержке американских инвестиций. Сеть соединит США и Австралию через хабы на Фиджи и во Французской Полинезии. Vocus уже объявила, что новые сети сформируют крупнейшую в мире систему оптоволоконных кабелей общей протяжённостью 42,5 тыс. км, проложенную между США и Азией через Австралию.

14.11.2024 [23:07], Владимир Мироненко

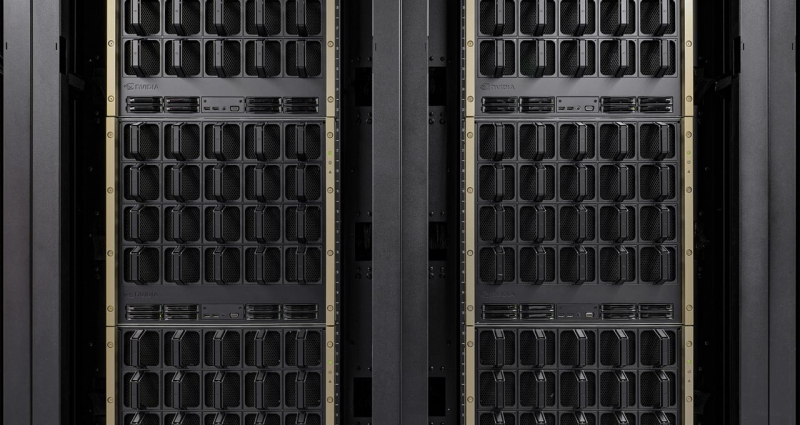

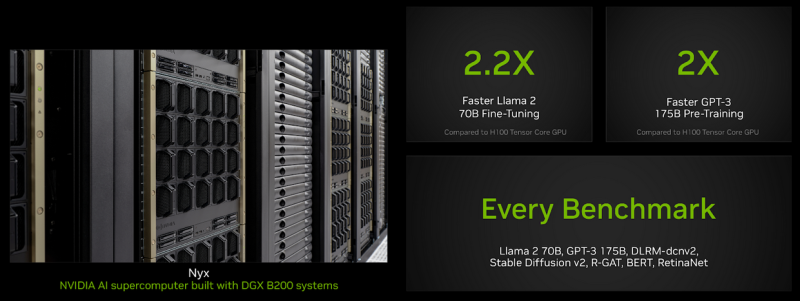

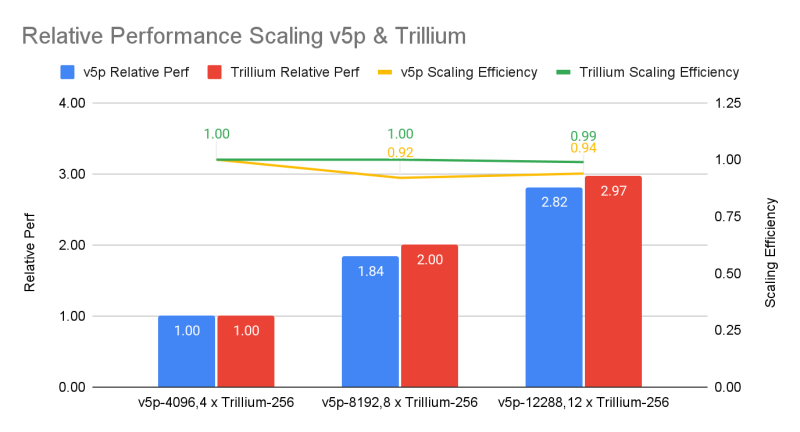

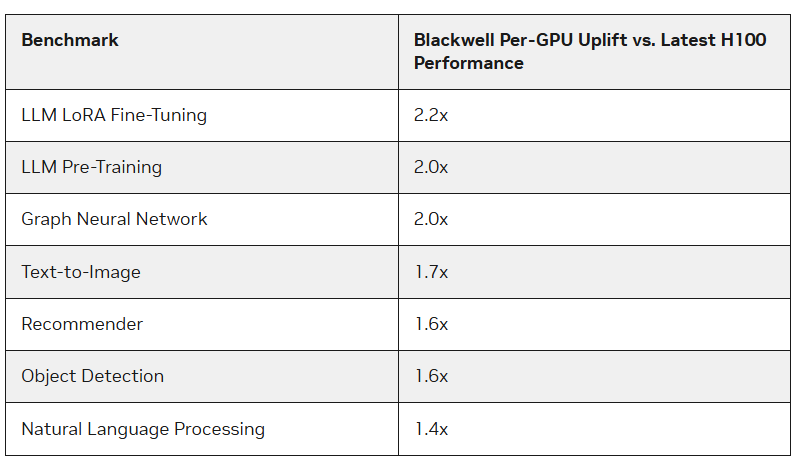

Google и NVIDIA показали первые результаты TPU v6 и B200 в ИИ-бенчмарке MLPerf TrainingУскорители Blackwell компании NVIDIA опередили в бенчмарках MLPerf Training 4.1 чипы H100 более чем в 2,2 раза, сообщил The Register. По словам NVIDIA, более высокая пропускная способность памяти в Blackwell также сыграла свою роль. Тесты были проведены с использование собственного суперкомпьютера NVIDIA Nyx на базе DGX B200. Новые ускорители имеют примерно в 2,27 раза более высокую пиковую производительность в вычисления FP8, FP16, BF16 и TF32, чем системы H100 последнего поколения. B200 показал в 2,2 раза более высокую производительность при тюнинге модели Llama 2 70B и в два раза большую производительность при предварительном обучении (Pre-training) модели GPT-3 175B. Для рекомендательных систем и генерации изображений прирост составил 64 % и 62 % соответственно. Компания также отметила преимущества используемой в B200 памяти HBM3e, благодаря которой бенчмарк GPT-3 успешно отработал всего на 64 ускорителях Blackwell без ущерба для производительности каждого GPU, тогда как для достижения такого же результата понадобилось бы 256 ускорителей H100. Впрочем, про Hopper компания тоже не забывает — в новом раунде компания смогла масштабировать тест GPT-3 175B до 11 616 ускорителей H100. Компания отметила, что платформа NVIDIA Blackwell обеспечивает значительный скачок производительности по сравнению с платформой Hopper, особенно при работе с LLM. В то же время чипы поколения Hopper по-прежнему остаются актуальными благодаря непрерывным оптимизациям ПО, порой кратно повышающим производительность в некоторых задач. Интрига в том, что в этот раз NVIDIA решила не показывать результаты GB200, хотя такие системы есть и у неё, и у партнёров.  В свою очередь, Google представила первые результаты тестирования 6-го поколения TPU под названием Trillium, о доступности которого было объявлено в прошлом месяце, и второй раунд результатов ускорителей 5-го поколения TPU v5p. Ранее Google тестировала только TPU v5e. По сравнению с последним вариантом, Trillium обеспечивает прирост производительности в 3,8 раза в задаче обучения GPT-3, отмечает IEEE Spectrum. Если же сравнивать результаты с показателями NVIDIA, то всё выглядит не так оптимистично. Система из 6144 TPU v5p достигла контрольной точки обучения GPT-3 за 11,77 мин, отстав от системы с 11 616 H100, которая выполнила задачу примерно за 3,44 мин. При одинаковом же количестве ускорителей решения Google почти вдвое отстают от решений NVIDIA, а разница между v5p и v6e составляет менее 10 %. В тесте Stable Diffusion система из 1024 TPU v5p заняла второе место, завершив работу за 2,44 мин, тогда как система того же размера на основе NVIDIA H100 справилась с задачей за 1,37 мин. В остальных тестах на кластерах меньшего масштаба разрыв остаётся примерно полуторакратным. Впрочем, Google упирает на масштабируемость и лучшее соотношение цены и производительности в сравнении как с решениями конкурентов, так и с собственными ускорителями прошлых поколений. Также в новом раунде MLPerf появился единственный результат измерения энергопотребления во время проведения бенчмарка. Система из восьми серверов Dell XE9680, каждый из которых включал восемь ускорителей NVIDIA H100 и два процессора Intel Xeon Platinum 8480+ (Sapphire Rapids), в задаче тюнинга Llama2 70B потребила 16,38 мДж энергии, потратив на работу 5,05 мин. — средняя мощность составила 54,07 кВт. |

|