Материалы по тегу: ии

|

16.12.2024 [19:35], Руслан Авдеев

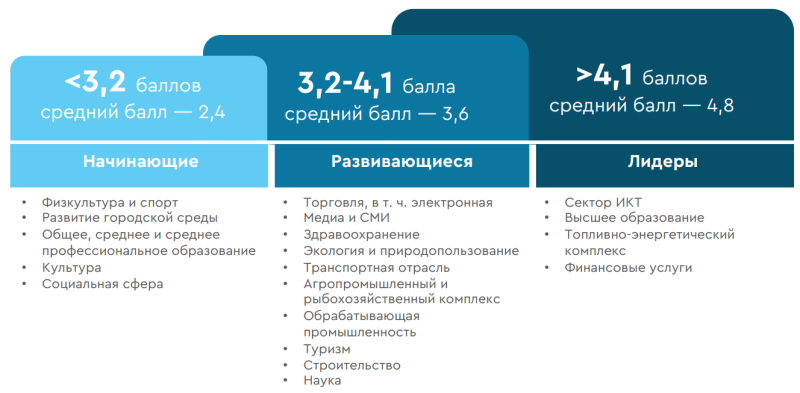

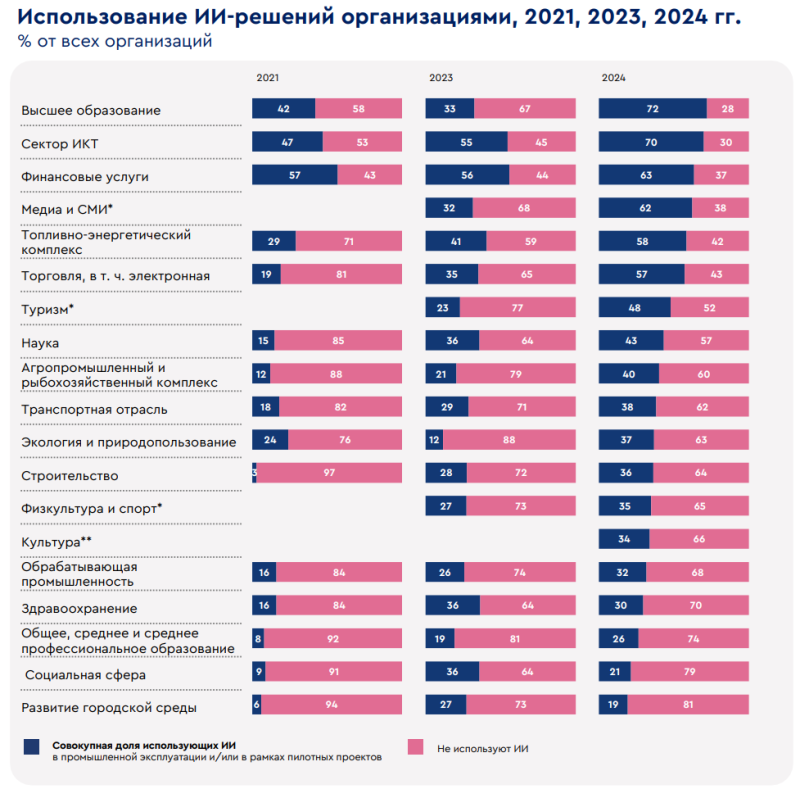

Нет денег, знаний, данных и людей: в России снизилась готовность компаний к внедрению ИИРоссийский бизнес оказался менее готов к внедрению ИИ в уходящем 2024 году, чем в прошлом. Национальный центр развития ИИ детально рассказал о сложившейся ситуации, во многом обусловленной дефицитом как данных, так и кадров для успешной работы, передаёт «Коммерсантъ». Среди главных причин также называются отсутствие в организациях знаний о возможностях технологии и нехватка средств, которая усугубляется недостатком единых критериев оценки эффективности ИИ. Центр, созданный на базе НИУ ВШЭ, призван обеспечивать экспертное сопровождение управления внедрением ИИ — как в экономике, так и в государственном управлении. В его докладе оценивалась готовность отраслей по 11 направлениям, в т.ч. инфраструктуры, кадрового обеспечения и научного сопровождения разработок, а также производства готовых продуктов с ИИ-основой и применение соответствующих технологий на практике. Проводился мониторинг 19 отраслей, в ходе которого выяснилось, что с 3,7 баллов из 10 возможных в 2023 году (что тоже является невысоким показателем) общая готовность снизилась на 0,2 балла, до 3,5. Минимально готовы оказались преимущественно сферы, представленные бюджетными организациями: культура (отрасль впервые оценивалась в 2024 году), общее образование, социальная сфера и отрасль физкультуры и спорта. В лидерах (более 4,1 баллов) с точки зрения готовности к развитию и использованию ИИ по-прежнему сфера финансовых услуг и ИКТ, хотя в 2024 к ним присоединились ТЭК и высшее образование. 27 % опрошенных назвали в 2024 году одним из главных препятствий отсутствие финансирования, особенно в отраслях с низкой готовностью к ИИ. Именно поэтому отмечается необходимость государственной поддержки развития и использования искусственного интеллекта, в первую очередь в бюджетных организациях. Впрочем, финансирование часто, наоборот, зависит от эффективности внедряемых технологий, а единые критерии оценки возврата инвестиций в ИИ и эффективности вообще до сих пор не выработаны. Наибольшее положительное влияние ИИ сосредоточено в крупных организациях, но эффекты применения ИИ отмечаются и в целом — в 36 % организаций в 2024 году против 29 % в 2023-м. Применение искусственного интеллекта более всего отразилось на росте качества продуктов и услуг. Ранее сообщалось, что каждая пятая крупная компания в России уже применяет генеративный ИИ. В целом рынок ИИ в России по разным показателям развивается довольно активно. В октябре сообщалось, что у российских государственных компаний значительно вырос спрос на ИИ-серверы. В начале декабря появилась информация о том, что в стране выросли инвестиции в оборудование для ИИ.

16.12.2024 [19:04], Руслан Авдеев

Databricks завершает раунд мегафинансирования на сумму $10 млрд [Обновлено]Основанная в 2013 году авторами Apache Spark компания Databricks завершает один из рекордных для венчурного капитала раундов финансирования, сообщает Reuters. Сообщается, что компания получит практически вдвое больше, чем рассчитывала — более $9,5 млрд. Но и эта сумма может вырасти, поскольку инвесторы горят желанием приобрести часть перспективной компании. Капитализация Databricks, которая предлагает инструментарий для анализа и обработки больших массивов данных, после завершения раунда, вероятно, превысит $60 млрд. Раунд, вероятно, будет возглавлен новым инвестором Thrive Capital, также участие примут Andreessen Horowitz, Insight Partners и GIC, уже снабжавшие компанию деньгами. Помимо прямых инвестиций обсуждается и долговое финансирование на $4,5 млрд, в том числе кредит на $2,5 млрд. При этом выручка компании в следующем финансовом году, по прогнозам, составит всего $3,8 млрд. Компания начинала деятельность с анализа больших данных, а затем вышла на рынок ИИ, создав облачную платформу для управления информацией, необходимой ИИ-приложениям, и семейство собственных LLM Dolly и DBRX. В сентябре стоимость компании оценивалась в $43 млрд. От бума систем искусственного интеллекта компания только выиграла. Платформа используется клиентами для хранения растущих объёмов данных, предназначенных для обучения ИИ. Если раунд финансирования завершится удачно, немало выиграют её первые сотрудники — полученные средства используют для выкупа акций с ограниченным сроком действия и покрытия налоговых затрат на покупки. Позже компания намерена выпустить для инвесторов привилегированные акции. По имеющимся данным, раунд организовали для решения вопросов с принадлежащими сотрудникам опционами с истекающим сроком действия. Нечто подобное в своё время провела платёжная компания Stripe Inc., в прошлом году получившая таким образом $6,5 млрд для выкупа акций. Databricks является конкурентом Snowflake, рыночная капитализация которой составляет $56 млрд (в пике было $120 млрд). IPO последней в своё время было названо крупнейшим за всю историю софтверной индустрии. Предполагается, что в Databricks пока не очень спешат с выходом на биржу, хотя эксперты прогнозируют серию выходов на IPO в следующем году. UPD 18.12.2024: Databricks объявила, что в ходе раунда J намерена собрать $10 млрд и уже получила $8,6 млрд при оценке капитализации в $62 млрд. В случае успешного завершения раунда общий объём инвестиций с момента основания компании в 2013 году составит $14 млрд.

16.12.2024 [16:08], Руслан Авдеев

Южнокорейская FuriosaAI включается в ИИ-гонку с собственным ускорителем RNGDСеульский стартап FuriosaAI, основанный в 2017 году, анонсировал в августе 2024 года ИИ-ускорители RNGD для гиперскейлеров и других корпоративных клиентов. Недавно компания начала тестирование новинки и рассылку образцов некоторым потенциальным клиентам, включая LG AI Research и Aramco, сообщает DigiTimes. RNGD позиционируется как решение, способное бросить вызов продуктам NVIDIA. По словам создателей, новинка на 40 % энергоэффективнее NVIDIA H100 при сопоставимых вычислительных характеристиках. Представитель компании недавно сообщил журналистам, что изначально компания сконцентрировалась исключительно на разработке, отложив производство до получения значительных инвестиций. Чип первого поколения был разработан ещё в 2021 году. Несмотря на скромный бюджет в $6 млн, компании удалось добиться результатов, достаточных для того, чтобы в раунде финансирования серии B компания получила $60 млн, что и позволило разработать модель RNGD.

Источник изображения: FuriosaAI RNGD создан совместно с Global Unichip Corporation (GUC) и TSMC и рассчитан на работу с большими языковыми моделями (LLM). Ускоритель использует память HBM3 и выполнен по 5-нм техпроцессу. Компания разрабатывала его с прицелом на инференс моделей уровня GPT-3 и новее. Соблюдению баланса производительности и энергопотребления способствовала проприетарная архитектура Tensor Construction Processor. В августе 2024 года LG AI Research начала интегрировать RNGD в свою ИИ-инфраструктуру, чтобы снизить зависимость от NVIDIA и способствовать развитию южнокорейского полупроводникового бизнеса. При этом FuriosaAI прилагает все усилия для программной поддержки своего продукта. В стартапе уверены, что рынок ИИ достаточно велик, чтобы места хватило и игрокам помельче NVIDIA. В компании сравнивают амбиции FuriosaAI с усилиями создателей первых электромобилей, которые в итоге произвели революцию во всей индустрии. Стартап укрепляет международные связи для экспансии в США, Азии и других регионах. В сентябре был подписан меморандум о взаимопонимании с арабской Aramco. Дополнительно ведутся переговоры с потенциальными партнёрами в Японии и Индии. Первые коммерческие поставки RNGD ожидаются в I квартале 2025 года. Подчёркивается и важность Тайваня для экосистемы FuriosaAI — в качестве хаба для передового производства остров играет ключевую роль. Потенциально рассматривается открытие офиса на Тайване для укрепления сотрудничества.

16.12.2024 [13:59], Руслан Авдеев

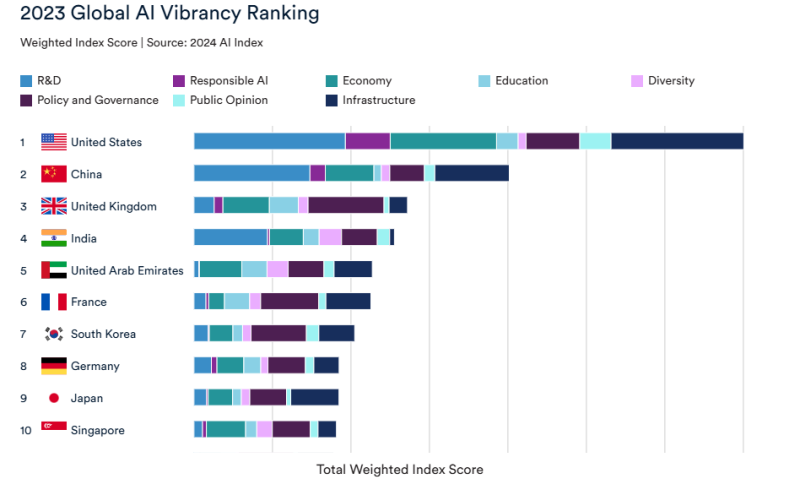

Исследователи Стэнфордского университета заявили о значительном отставании китайской ИИ-индустрии от американскойИнститут искусственного интеллекта, ориентированного на человека (Institute for Human-Centered Artificial Intelligence, HAI) Стэнфордского университета опубликовал доклад по метрике 2024 Global AI Vibrancy Tool. Он продемонстрировал сильную диспропорцию в развитии ИИ-технологий в США и Китае в 2023 году, сообщает eWeek. В докладе США обозначены безусловным мировым лидером в сфере технологий искусственного интеллекта, Китай с большим отрывом занял лишь второе место. Всего учитывались 42 показателя по восьми критически важным сферам: оценивался не только уровень разработок и исследований, но и экономические данные, образовательный уровень, политические факторы и даже «разнообразие», помимо, конечно, инфраструктуры. Подобный инструмент обеспечивает политикам, бизнесам и исследователям углубленный взгляд на ИИ-экосистемы 36 стран, говорят его создатели. Лидеры отрасли определяются по объёмам частных инвестиций и количеством связанных с ИИ патентов, оцениваются исследовательские публикации и политические инициативы, а также многие другие параметры. США названы непревзойдённым лидером 2023 года с индексом 70,06 балла — это почти вдвое больше, чем у Китая с 40,17 балла. Ключевыми драйверами, обусловившими доминирование Соединённых Штатов, названы:

Впрочем, Китай довольно силён в любом случае. Страна лидирует по количеству связанных с ИИ патентов и сохраняет прочную и результативную научную базу, но доминирование страны касается только отдельных сфер. Китайские компании вроде Baidu добились прогресса в сфере генеративного ИИ, но страна не может потягаться с США по объёмам частных инвестиций и «мировому влиянию». В десятку лидеров также входят Великобритания, Индия, ОАЭ, Франция, Южная Корея, Германия, Япония и Сингапур. Входящие в пятёрку Индия и ОАЭ — весьма перспективные игроки с некоторыми, весьма сильными характеристиками и очевидными намерениями добиться лучших результатов. Например, Индия активно вкладывает деньги в ИИ-инфраструктуру, в Эмиратах приблизительно на то же тратятся огромные средства, в том числе при участии партнёров вроде Microsoft. Впрочем, объективность самого рейтинга может быть подвергнута сомнению. Россия, например, в нём далеко отстала от Люксембурга и лишь на пару позиций обогнала Эстонию.

16.12.2024 [11:19], Сергей Карасёв

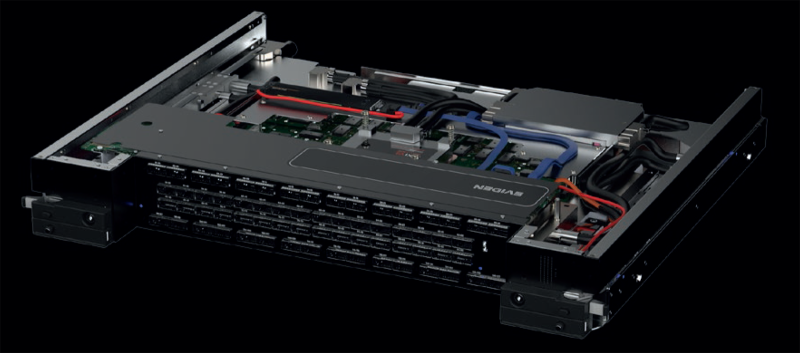

Раскрыты характеристики сетевых устройств Eviden с технологией BXI v3В ноябре текущего года компания Eviden (дочерняя структура Atos) представила интерконнект третьего поколения BullSequana eXascale Interconnect (BXI v3) для рабочих нагрузок ИИ и HPC. Теперь, как сообщает ресурс Next Platform, раскрыты некоторые характеристики устройств с поддержкой данной технологии. BXI v3 в качестве базового протокола связи использует Ethernet. Технология BXI v3 ляжет в основу интеллектуального сетевого адаптера (Smart NIC) и соответствующего коммутатора. Говорится, что для изготовления чипов ASIC с поддержкой BXI v3 компания Eviden рассматривает возможность применения 3-нм или 4-нм методики TSMC. Коммутатор BXI v3 располагает 64 портами, работающими на скорости 800 Гбит/с. Их можно переконфигурировать в 128 портов с пропускной способностью 400 Гбит/с. В свою очередь, адаптер Smart NIC функционирует на скорости 400 Гбит/с. Он будет предлагаться в виде двухслотовой карты расширения PCIe или OCP-3 (с интерфейсом PCIe 5.0). Возможны варианты адаптеров с двумя портами 400 Гбит/с. Карта BXI v3 способна управлять пакетами объёмом до 9 Мбайт, что полезно в нагруженных инфраструктурах ИИ. Платформа BXI v3 поддерживает топологии fat tree и dragonfly+, а также fat tree с оптимизацией маршрутов (используется при обучении больших языковых моделей). Для BXI v3 заявлена поддержка до 64 тыс. конечных точек, а задержка составляет менее 200 нс от порта к порту. Изделия с поддержкой BXI v3 поступит в продажу в 2025 году. Осенью 2027 года ожидается появление интерконнекта BXI v4, который предусматривает повышение пропускной способности портов на сетевых картах и коммутаторах до 1,6 Тбит/с. При этом сетевые адаптеры получат поддержку интерфейса PCIe 6.0. В 2029-м планируется переход на интерконнект BXI v5: он обеспечит скорость портов на коммутаторах до 3,2 Тбит/с, тогда как сетевые адаптеры продолжат работать на скоростях до 1,6 Тбит/с, но получат поддержку PCIe 7.0.

15.12.2024 [13:17], Руслан Авдеев

Ciena верит в значительный рост трафика ИИ ЦОД, другие ставят на замедление роста всего мирового трафикаКомпания Ciena, один из крупнейших поставщиков оптических сетевых решений, отчиталась о работе в IV квартале. Выручка составила $1,12 млрд, хотя отраслевые эксперты ожидали, что она вряд ли превысит $1,103 млрд., сообщает блог IEEE Comsoc. В сегментах бизнеса, ответственных за продажу ПО и сервисов, рост составил 20,6 % год к году, а вот в подразделении, отвечающем за маршрутизаторы и коммутаторы, отмечен спад на 38,4 % год к году. Вырос спрос на реконфигурируемые линейные системы (Reconfigurable Line Systems, RLS), во многом благодаря крупным облачным провайдерам. В Ciena утверждают, что неплохо продавались и когерентные оптические модули WaveLogic, подходящие для обслуживания в ЦОД систем ИИ и машинного обучения. Ещё одна популярная технология — Managed Optical Fiber Networks (MOFN), предназначенная для тех, кто строит частные оптические сети для облачных провайдеров. В ряде стран провайдерам запрещено строить собственные ВОЛС, поэтому они используют сети местных операторов. MOFN позволяет избежать сопутствующих проблем, поскольку фактически арендуется имеющаяся инфраструктура, а управление осуществляется с помощью технологий Ciena. Хотя ранее предполагалось, что решение будет нишевым, в последние 6–9 мес. выяснилось, что оно вполне востребовано и широко применяется. Также в компании объявили, что в следующие три года среднегодовой рост выручки составит около 8–11 %. В компании подчёркивают, что бизнес тесно связан с ростом пропускной способности сетей по всему миру, и утверждают, что ежегодный прирост трафика в последние два десятилетия составлял 20–40 %. В Ciena уверены, что масштабные инвестиции в ИИ ЦОД приведут к росту трафика как в США, так и по всему миру, поскольку данные из ЦОД должны циркулировать по широкополосным сетям. Топ-менеджеры компании уверены, что ИИ ЦОД станут одним из ключевых драйверов этого роста. А это станет драйвером роста и для бизнеса Ciena. Примечательно, что многие эксперты, наоборот, ожидают замедления роста трафика в глобальных сетях. OpenVault недавно заявила, что среднемесячный широкополосный трафик в III квартале вырос на 7,2 % — это самые низкие темпы с начала измерений компанией в 2012 году. В докладе Ericsson отмечается, что мобильный трафик продолжил расти, но более низкими темпами. С «историческим» замедлением роста трафика столкнулись и CDN-провайдеры Akamai, Fastly и Edgio. В Akamai заявляют, что рост очень медленный, темпы худшие за 25 лет. Тем временем в Ciena сохраняют оптимизм и заявляют, что сами облачные провайдеры укрупняют инфраструктуру и сети, создавая основу для еще большего роста в будущем, при этом всё больше трафика, связанного с ИИ, выходит за пределы дата-центров. Именно поэтому в Ciena прогнозируют в ближайшие три года рост значительно больший, чем обычно. Сама Ciena довольно активно готовится к росту трафика. Так, компания ещё в марте объявила о намерении обновить подводный кабель SEA-ME-WE 4, связывающий Европу и Азию. Благодаря внедряемым технологиям GeoMesh Extreme и WaveLogic 5 Extreme, его пропускная способность поднимется с 65 Тбит/с до 122 Тбит/с.

15.12.2024 [13:00], Сергей Карасёв

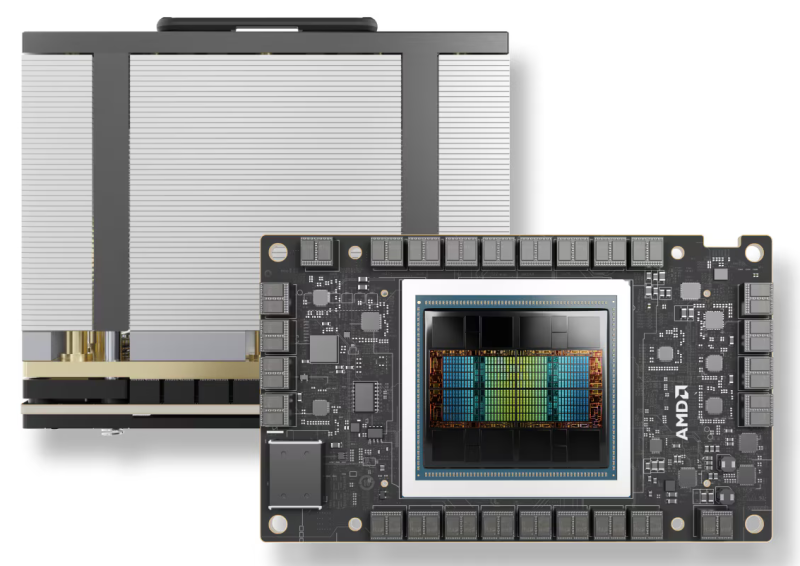

Vultr запустил облачный ИИ-кластер на базе AMD Instinct MI300XКрупнейший в мире частный облачный провайдер Vultr объявил о заключении соглашения о четырёхстороннем стратегическом сотрудничестве с целью развёртывания нового суперкомпьютерного кластера. В проекте принимают участие AMD, Broadcom и Juniper Networks. Применяются ускорители AMD Instinct MI300X и открытый программный стек ROCm. Данные о количестве ускорителей и общей производительности платформы пока не раскрываются. Кластер размещён в дата-центре Vultr Centersquare в Лайле (юго-западный пригород Чикаго; Иллинойс; США). Новая НРС-система построена с использованием Ethernet-коммутаторов Broadcom и оптимизированных для ИИ-задач сетевых Ethernet-решений Juniper Networks. Благодаря этим компонентам, как утверждается, возможно построение безопасной высокопроизводительной инфраструктуры. Кластер ориентирован прежде всего на обучение ИИ-моделей и ресурсоёмкие нагрузки инференса. «Сотрудничество с AMD, Broadcom и Juniper Networks позволяет предприятиям и специалистам в области ИИ использовать весь потенциал ускоренных вычислений при одновременном обеспечении гибкости, масштабируемости и безопасности», — говорит Джей Джей Кардвелл (J.J. Kardwell), генеральный директор Vultr. О доступности Instinct MI300X в своей облачной инфраструктуре компания Vultr сообщила в сентябре нынешнего года. Ускорители AMD интегрируются с Vultr Kubernetes Engine for Cloud GPU для формирования кластеров Kubernetes, использующих ускорители. Предложение ориентировано на задачи ИИ и НРС. Vultr ставит своей целью сделать высокопроизводительные облачные вычисления простыми в использовании и доступными для предприятий и разработчиков по всему миру. На сегодняшний день экосистема Vultr включает 32 облачные зоны, в том числе площадки в Северной Америке, Южной Америке, Европе, Азии, Австралии и Африке.

14.12.2024 [15:25], Сергей Карасёв

HPE создаст HPC-систему Blue Lion для Суперкомпьютерного центра имени ЛейбницаСуперкомпьютерный центр имени Лейбница (LRZ) в Германии, управляемый Баварской академией наук в Мюнхене (BADW), объявил о подписании соглашения с HPE на строительство HPC-комплекса нового поколения. Проект получил название Blue Lion. LRZ, входящий в состав Суперкомпьютерный центр имени Гаусса (GCS), намерен запустить систему Blue Lion в 2027 году. Предполагается, что комплекс не только ускорит выполнение задач в области классического моделирования, но и откроет новые возможности для достижений в сфере ИИ. В основу Blue Lion ляжет платформа HPE Cray нового поколения с ускорителями NVIDIA. Говорится о применении интерконнекта HPE Slingshot с пропускной способностью до 400 Гбит/с. По производительности Blue Lion примерно в 30 раз превзойдёт предшественника — систему SuperMUC-NG, которая обеспечивает теоретическое пиковое быстродействие в 26,9 Пфлопс.

Источник изображения: GCS Blue Lion будет использовать на 100 % прямое жидкостное охлаждение тёплой водой температурой до +40 °C, протекающей по медным трубкам. Нагретую воду планируется повторно использовать для отопления помещений самого LRZ, а также соседних учреждений в Гархинге. Утверждается, что такая СЖО расходует примерно на 94 % меньше энергии в процессе работы, чем сопоставимая по классу система воздушного охлаждения. Blue Lion также потребует значительно меньше места для размещения благодаря более высокой плотности монтажа. Проект Blue Lion в равных долях финансируется Министерством науки и искусства Баварии (StMWK) и Федеральным министерством образования и исследований (BMBF). Затраты на создание суперкомпьютера оцениваются в €250 млн с учётом эксплуатационных расходов до 2032 года.

14.12.2024 [15:20], Сергей Карасёв

Liquid AI получила $250 млн на развитие «жидких» ИИ-моделей, в том числе от AMDСтартап Liquid AI, специализирующийся на разработке моделей генеративного ИИ с принципиально новой архитектурой, объявил о проведении раунда финансирования Series A, в ходе которого на развитие привлечено $250 млн. Деньги в числе прочих предоставила AMD. Liquid AI, связанная с Массачусетским технологическим институтом (MIT), базируется в Бостоне. Её специализация — ИИ-модели LFM, или Liquid Foundation Models. Утверждается, что такие решения по производительности идентичны или превосходят традиционные большие языковые модели (LLM), представленные на рынке. В основе современных популярных чат-ботов, таких как OpenAI ChatGPT и Google Gemini, лежит генеративный предобученный трансформер — Generative Pre-trained Transformer (GPT): для обучения применяются обширные массивы информации. Модели LFM, в свою очередь, основаны на концепции «жидких» нейронных сетей. Для работы LFM требуется меньше памяти по сравнению с GPT, что открывает новые возможности при использовании ИИ на платформах с ограниченными аппаратными ресурсами. В частности, Liquid AI предлагает три варианта моделей: LFM-1B с 1,3 млрд параметров для маломощных устройств, таких как смартфоны, LFM-3B с 3,1 млрд параметров для периферийных развертываний и LFM-40B Mixture of Experts с 40 млрд параметров для решения сложных задач. Такие модели могут использоваться корпоративными клиентами разного масштаба. В 2023 году в ходе посевного раунда стартап Liquid AI получил $46,6 млн. В программе Series A, помимо AMD, приняли участие OSS Capital, Duke Capital Partners и PagsGroup. Полученные средства будут использованы для дальнейшей разработки LFM разного размера. Кроме того, компания намерена предлагать решения, оптимизированные для конкретных отраслей, таких как потребительская электроника, биотехнологии, телекоммуникации, финансовые услуги и электронная коммерция.

14.12.2024 [15:15], Сергей Карасёв

Представлен ПАК Tantor XData 2.0 на основе СУБД Tantor 16.6 и серверов «Аквариус»Компания «Тантор Лабс», входящая в «Группу Астра», анонсировала программно-аппаратный комплекс (ПАК) Tantor XData 2.0 для поддержания работы СУБД Tantor. По сравнению с платформой предыдущего поколения новинка, как утверждается, демонстрирует более высокую производительность, а также обладает улучшенным интерфейсом. Оригинальная версия Tantor XData дебютировала в феврале нынешнего года: в разработке решения приняли участие специалисты группы компаний «Аквариус». Говорилось о применении серверов на процессорах Intel Xeon Cascade Lake-SP, AMD EPYC, Baikal-S или Kunpeng 920, а также ОС Astra Linux Special Edition. А в апреле 2024-го «Группа Астра» создала компанию «Иксдата» по выпуску ПАК для высоконагруженных СУБД. Говорится, что в Tantor XData 2.0 применяется аппаратно-программное RAID-решение собственной разработки, которое обеспечивает трёхкратное сжатие данных и увеличивает производительность подсистемы хранения до 102 тыс. TPS (транзакций в секунду) в тестах pgbench (операции чтения/записи). Это на 25 % больше по сравнению с ПАК предыдущей версии. В состав комплекса включено S3-совместимое хранилище, позволяющее гибко масштабировать ресурсы. При этом обеспечивается высокая доступность данных благодаря возможности дублирования и распределения между разными узлами. Реализована новая встроенная система резервного копирования на основе WAL-G: благодаря использованию объектного хранилища S3 упрощается восстановление информации из резервных копий. Кроме того, возможна миграция резервных копий баз данных между различными площадками или регионами. Применяется СУБД Tantor 16.6. Усовершенствованный графический интерфейс с модулем управления и мониторинга аппаратных ресурсов DCImanager позволяет централизованно взаимодействовать как с программной, так и с аппаратной частью ПАК в режиме «одного окна»: это повышает удобство и прозрачность административных операций. В Tantor XData 2.0 улучшены возможности работы с кластерами баз данных: остановка и запуск для планового обслуживания, ведение реестра задействованных ресурсов, автоматизированное выделение сетевых и дисковых ресурсов при формировании кластера, усиленный механизм работы с секретами для повышения уровня безопасности. Интерфейс для проведения полного цикла инсталляции/обновления и конфигурирования ПАК XData 2.0 обеспечивает автоматизацию ключевых этапов: монтажа, коммутации и первичной настройки аппаратного комплекса, установки и конфигурации операционной системы на управляющие и вычислительные серверы, на серверы хранения данных, установку, настройку, диагностику и обновление компонентов ПАК, предварительную проверку перед вводом в промышленную эксплуатацию. |

|