Материалы по тегу: llm

|

02.04.2025 [11:04], Владимир Мироненко

MTS AI выпустила ИИ-модель Cotype Pro 2, которая станет основой ИИ-агентов для бизнесаКомпания MTS AI, дочерняя структура МТС, сообщила о выходе большой языковой модели (LLM) Cotype Pro 2 второго поколения, предназначенной для корпоративного сегмента. Новая модель значительно превосходит по целому ряду показателей предыдущую версию, адаптирована под выполнение более чем 100 сценариев использования компаниями в России и может быть запущена на собственной инфраструктуре предприятия без подключения к внешним серверам, чем обеспечивается защита от утечки данных. На основе Cotype Pro 2 компания подготовит в 2025–2026 гг. новую линейку ИИ-решений для семи отраслей: госсектора, банков, промышленности, ретейла, телекома, медицины и IT. Сначала будут созданы ИИ-помощники, затем — ИИ-агенты с большей автономностью, способные решать, как общие задачи (HR, клиентская поддержка, документооборот и другие), так и специфичные для каждой из этих отраслей. Cotype Pro 2 вошла в пятерку лучших русскоязычных LLM в бенчмарке MERA от Альянса в сфере ИИ. Она на 40 % быстрее предыдущей версии и на 50 % точнее обрабатывает длинные тексты — до 128 тыс. токенов, что соответствует примерно 900 тыс. символов с пробелами, сообщила компания. По сравнению с предшественником её эффективность в области генерации идей возросла с 44 до 57 %, точность в задаче извлечения информации выросла с 81 до 86 %, в части общения на общие темы зафиксировано улучшение с 55 до 64 %, благодаря чему обеспечивается более плавное и осмысленное взаимодействие. Также осталась на высоком уровне эффективность в классификации — 87 %, отмечены улучшения в суммаризации (с 79 до 85 %) и креативном письме (с 61 до 65 %). Для оценки эффективности сравнивалось количество ответов, схожих или превосходящих по качеству ответы модели GPT-4o. Как отметил директор по LLM-продуктам MTS AI, для ИИ-агентов важно не только работать с большим объёмом информации, но и давать ответы в структурированном виде, понятном другим системам. Чтобы оценить качество таких ответов компания разработала специальный бенчмарк, который включает задания с разным объёмом контекста и разной сложностью. В этом тесте Cotype Pro 2 справилась с 94 % задач, а GPT-4o — с 93 %. Также по данным бенчмарка длинного контекста LIBRA, качество работы Cotype Pro 2 в два раза выше, чем у Cotype Pro на задачах длиной 64 и 128 тыс. токенов (до 500 тыс. символов). В дополнение к выполнению базовых задач Cotype Pro 2 поддерживает «ролевой отыгрыш» — способность вести диалог от лица специалиста, адаптируя стиль общения под особенности профессии, что повышает качество взаимодействия в клиентской поддержке, обучении сотрудников и т.д. Перед анонсом Cotype Pro 2 прошла тестирование в реальных условиях. В течение трёх месяцев она автоматически сортировала обращения в поддержку банка, а для МТС Live создавала описания мероприятий. Также тестирование подтвердило возможность интеграции с инструментами RAG (Retrieval-Augmented Generation) для извлечения информации из баз знаний с генерацией текста, что будет востребовано, например, в чат-ботах, где нужно регулярно обновлять данные и в течение нескольких секунд предоставлять ответы на запросы. Как сообщили в MTS AI ресурсу Forbes, семейство корпоративных отраслевых ИИ-агентов, над которыми сейчас ведётся работа, будет, в частности, включать следующие решения:

Сообщается, что МТС также начала предоставлять консалтинговые услуги по внедрению ИИ-продуктов в эти сферы. Как ожидает компания, к 2027 году коммерциализация ИИ-агентов будет приносить её ИИ-направлению более половины выручки.

31.03.2025 [14:20], Сергей Карасёв

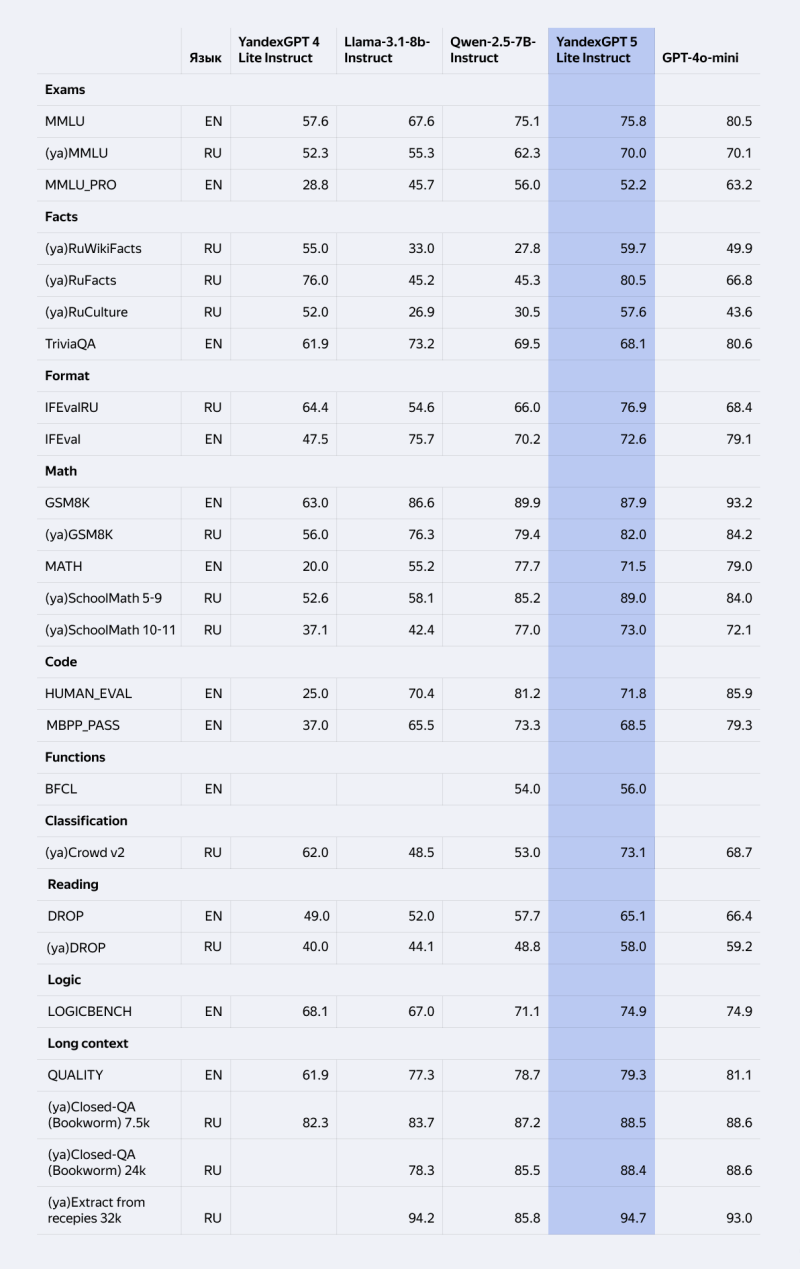

«Яндекс» выпустил открытую ИИ-модель YandexGPT 5 Lite: её можно запускать на обычной рабочей станцииКомпания «Яндекс» сообщила о появлении в открытом доступе Instruct-версии ИИ-модели YandexGPT 5 Lite: применять её можно в некоммерческих и в коммерческих целях. Благодаря сравнительно низким требованиям к оборудованию опробовать модель можно на обычном компьютере без специального оборудования. Модель подверглась стандартному обучению на больших объёмах данных, а также прошла дополнительный этап настройки — так называемое выравнивание (alignment). Это позволяет ей решать конкретные задачи по запросам или инструкциям. Для сравнения: другую открытую версию YandexGPT 5 Lite — Pretrain — пользователям нужно дообучать под свои потребности. Instruct-модификация YandexGPT 5 Lite насчитывает 8 млрд параметров и поддерживает контекст до 32 тыс. токенов. Говорится о совместимости с библиотекой llama.cpp и поддержке GGUF-формата (GPT-Generated Unified Format). По результатам международных тестов и их адаптаций для русского языка (MMLU, IFEval, RuFacts и других) модель соперничает с китайской Qwen2.5-7B-Instruct, превосходя её в таких сценариях, как задачи классификации и разметки текстов, знание русской культуры и фактов, умение отвечать в заданном формате. Более того, YandexGPT 5 Lite Instruct сравнима по качеству ответов с GPT-4o Mini в решении стандартных задач сервисов «Яндекса». Благодаря обновлённой лицензии YandexGPT 5 Lite применять модель можно в коммерческих проектах, если объём выходных токенов не превышает 10 млн в месяц. Утверждается, что этого достаточно для создания и поддержки чат-ботов на небольших и средних сайтах, для генерации описаний товаров в интернет-магазинах с ограниченным ассортиментом, для автоматизации ответов клиентам в сервисных центрах или для анализа отзывов пользователей на площадках с умеренным трафиком. Модель YandexGPT 5 Lite Instruct доступна бесплатно исследователям и разработчикам на Hugging Face. Бизнес-пользователям доступ предоставляется через API в Yandex Cloud: при этом можно дообучить модель для конкретных задач. Причём API стал совместим с OpenAI API: теперь модели «Яндекса» можно использовать с библиотеками OpenAI на Python, JavaScript и других языках программирования. Упрощена интеграция с популярными решениями для работы с технологиями машинного обучения: например, с платформой для запуска ИИ-ассистентов AutoGPT и с инструментом для создания приложений на базе нейросетей LangChain. Пользователи могут протестировать модель в чате с «Алисой».

24.03.2025 [11:59], Руслан Авдеев

OpenAI и Meta✴ ведут переговоры с индийской Reliance Jio о сотрудничестве в сфере ИИMeta✴ и OpenAI по отдельности ведут переговоры с индийской Reliance Industries о потенциальном сотрудничестве для расширения ИИ-сервисов, сообщает The Information. Так, OpenAI хотела бы при помощи Reliance Jio расширить использование ChatGPT в Индии — об этом изданию сообщили два независимых источника, знакомых с вопросом. Более того, OpenAI обсуждала с сотрудниками сокращение стоимости подписок на платный вариант ChatGPT с $20/мес. до всего нескольких долларов. Пока неизвестно, велись ли разговоры об этом в ходе переговоров с Reliance. С последней, как утверждается, обсуждали продажу ИИ-моделей OpenAI корпоративным клиентам (через API). Также индийская компания заинтересована в локальном хостинге моделей OpenAI, чтобы данные местных клиентов будут храниться в пределах Индии. По имеющимся данным, с OpenAI и Meta✴ велись переговоры о запуске ИИ-моделей компаний в 3-ГВт ЦОД, который Reliance пока только планирует построить. Утверждается, что это будет «крупнейший дата-центр в мире» — его возведут в Джамнагаре (штат Гуджарат). Стоит отметить, что Reliance Industries является одним из крупнейших конгломератов Индии, имеющих интересы как в нефтегазовой отрасли, так и в IT и смежных отраслях, а также в сфере «зелёной» энергетики.

Источник изображения: Shivam Mistry/unsplash.com Индия в целом считается очень перспективной страной для развития инвестиций в ИИ. Например, в конце прошлого года глава NVIDIA Дженсен Хуанг (Jensen Huang) заявил, что страна должна стать одним из лидеров в области ИИ и создать собственную инфраструктуру. Тогда сообщалось, что Индия на государственном уровне обсуждает с NVIDIA совместную разработку чипов для ИИ-проектов, адаптированных к местным задачам. Также страна осваивает связанные с ИИ технологии — например, она затратит $1,2 млрд на суверенный ИИ-суперкомпьютер с 10 тыс. ускорителей и собственные LLM, а также готова покупать много ускорителей, включая ослабленные варианты, которые не достались Китаю после ужесточения американских санкций. И это далеко не все проекты, находящиеся сейчас на стадии разработки и реализации.

24.03.2025 [08:30], Владимир Мироненко

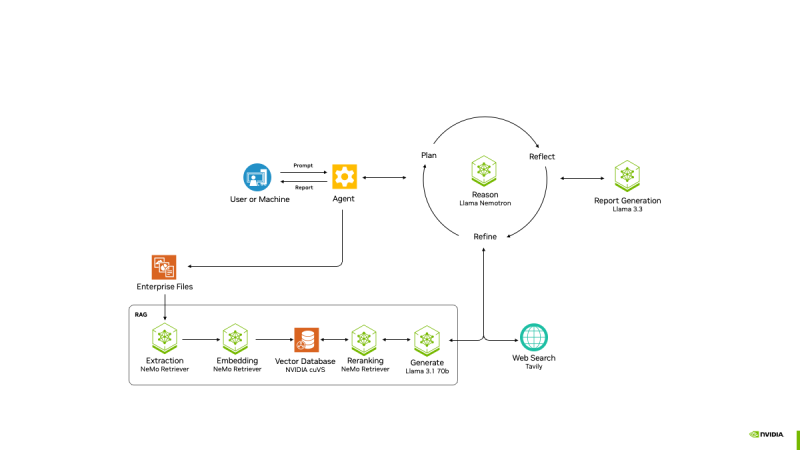

NVIDIA представила проект AI-Q Blueprint Platform для создания продвинутых ИИ-агентовПризнавая, что одних моделей, включая свежие Llama Nemotron с регулируемым «уровнем интеллекта», недостаточно для развёртывания ИИ на предприятии, NVIDIA анонсировала проект AI-Q Blueprint, представляющий собой фреймворк с открытым исходным кодом, позволяющий разработчикам подключать базы знаний к ИИ-агентам, которые могут действовать автономно. Blueprint был создан с помощью микросервисов NVIDIA NIM и интегрируется с NVIDIA NeMo Retriever, что упрощает для ИИ-агентов извлечение мультимодальных данных в различных форматах. С помощью AI-Q агенты суммируют большие наборы данных, генерируя токены в 5 раз быстрее и поглощая данные петабайтного масштаба в 15 раз быстрее с лучшей семантической точностью. Проект основан на новом наборе инструментов NVIDIA AgentIQ для бесшовного, гетерогенного соединения между агентами, инструментами и данными, опубликованном на GitHub. Он представляет собой программную библиотеку с открытым исходным кодом для подключения, профилирования и оптимизации команд агентов ИИ, работающих на основе корпоративных данных для создания многоагентных комплексных (end-to-end) систем. Его можно легко интегрировать с существующими многоагентными системами — как по частям, так и в качестве комплексного решения — с помощью простого процесса адаптации, который обеспечивает полную поддержку. Набор инструментов AgentIQ также повышает прозрачность с полной отслеживаемостью и профилированием системы, что позволяет организациям контролировать производительность, выявлять неэффективность и иметь детальное представление о том, как генерируется бизнес-аналитика. Эти данные профилирования можно использовать с NVIDIA NIM и библиотекой с открытым исходным кодом NVIDIA Dynamo для оптимизации производительности агентских систем. Благодаря этим инструментам предприятиям будет проще объединять команды ИИ-агентов в таких решениях, как Agentforce от Salesforce, поиск Atlassian Rovo в Confluence и Jira, а также ИИ-платформа ServiceNow для трансформации бизнеса, чтобы устранить разрозненность, оптимизировать задачи и сократить время ответа с дней до часов. AgentIQ также интегрируется с такими фреймворками и инструментами, как CrewAI, LangGraph, Llama Stack, Microsoft Azure AI Agent Service и Letta, позволяя разработчикам работать в своей предпочтительной среде. Azure AI Agent Service интегрирован с AgentIQ для обеспечения более эффективных агентов ИИ и оркестровки многоагентных фреймворков с использованием семантического ядра, которое полностью поддерживается в AgentIQ. Возможности ИИ-агентов уже широко используются в различных отраслях. Например, платёжная система Visa использует ИИ-агентов для оптимизации кибербезопасности, автоматизируя анализ фишинговых писем в масштабе. Используя функцию профилирования AI-Q, Visa может оптимизировать производительность и затраты агентов, максимально увеличивая роль ИИ в эффективном реагировании на угрозы, сообщила NVIDIA.

24.03.2025 [01:37], Владимир Мироненко

NVIDIA анонсировала ИИ-модели Llama Nemotron с регулируемым «уровнем интеллекта»NVIDIA анонсировала новое семейство ИИ-моделей Llama Nemotron с расширенными возможностями рассуждения. Основанные на моделях Llama с открытым исходным кодом от Meta✴ Platforms, модели от NVIDIA предназначены для предоставления разработчикам основы для создания продвинутых ИИ-агентов, которые могут от имени своих пользователей независимо или с минимальным контролем работать в составе связанных команд для решения сложных задач. «Агенты — это автономные программные системы, предназначенные для рассуждений, планирования, действий и критики своей работы», — сообщила Кари Бриски (Kari Briski), вице-президент по управлению программными продуктами Generative AI в NVIDIA на брифинге с прессой, пишет VentureBeat. «Как и люди, агенты должны понимать контекст, чтобы разбивать сложные запросы, понимать намерения пользователя и адаптироваться в реальном времени», — добавила она. По словам Бриски, взяв Llama за основу, NVIDIA оптимизировала модель с точки зрения требований к вычислениям, сохранив точность ответов. NVIDIA сообщила, что улучшила новое семейство моделей рассуждений в ходе дообучения, чтобы улучшить многошаговые математические расчёты, кодирование, рассуждения и принятие сложных решений. Это позволило повысить точность ответов моделей до 20 % по сравнению с базовой моделью и увеличить скорость инференса в пять раз по сравнению с другими ведущими рассуждающими open source моделями. Повышение производительности инференса означают, что модели могут справляться с более сложными задачами рассуждений, имеют расширенные возможности принятия решений и позволяют сократить эксплуатационные расходы для предприятий, пояснила компания. Модели Llama Nemotron доступны в микросервисах NVIDIA NIM в версиях Nano, Super и Ultra. Они оптимизированы для разных вариантов развёртывания: Nano для ПК и периферийных устройств с сохранением высокой точности рассуждения, Super для оптимальной пропускной способности и точности при работе с одним ускорителем, а Ultra — для максимальной «агентской точности» в средах ЦОД с несколькими ускорителями. Как сообщает NVIDIA, обширное дообучение было проведено в сервисе NVIDIA DGX Cloud с использованием высококачественных курируемых синтетических данных, сгенерированных NVIDIA Nemotron и другими открытыми моделями, а также дополнительных курируемых наборов данных, совместно созданных NVIDIA. Обучение включало 360 тыс. часов инференса с использованием ускорителей H100 и 45 тыс. часов аннотирования человеком для улучшения возможностей рассуждения. По словам компании, инструменты, наборы данных и методы оптимизации, используемые для разработки моделей, будут в открытом доступе, что предоставит предприятиям гибкость в создании собственных пользовательских рвссуждающих моделей. Одной из ключевых функций NVIDIA Llama Nemotron является возможность включать и выключать опцию рассуждения. Это новая возможность на рынке ИИ, утверждает компания. Anthropic Claude 3.7 имеет несколько схожую функциональность, хотя она является закрытой проприетарной моделью. Среди моделей с открытым исходным кодом IBM Granite 3.2 тоже имеет переключатель рассуждений, который IBM называет «условным рассуждением». Особенность гибридного или условного рассуждения заключается в том, что оно позволяет системам исключать вычислительно затратные этапы рассуждений для простых запросов. NVIDIA продемонстрировала, как модель может задействовать сложные рассуждения при решении комбинаторной задачи, но переключаться в режим прямого ответа для простых фактических запросов. NVIDIA сообщила, что целый ряд партнёров уже использует модели Llama Nemotron для создания новых мощных ИИ-агентов. Например, Microsoft добавила Llama Nemotron и микросервисы NIM в Microsoft Azure AI Foundry. SAP SE использует модели Llama Nemotron для улучшения возможностей своего ИИ-помощника Joule и портфеля решений SAP Business AI. Кроме того, компания использует микросервисы NVIDIA NIM и NVIDIA NeMo для повышения точности завершения кода для языка ABAP. ServiceNow использует модели Llama Nemotron для создания ИИ-агентов, которые обеспечивают повышение производительности и точности исполнения задач предприятий в различных отраслях. Accenture сделала рассуждающие модели NVIDIA Llama Nemotron доступными на своей платформе AI Refinery. Deloitte планирует включить модели Llama Nemotron в свою недавно анонсированную платформу агентского ИИ Zora AI. Atlassian и Box также работают с NVIDIA, чтобы гарантировать своим клиентам доступ к моделям Llama Nemotron.

23.02.2025 [22:52], Владимир Мироненко

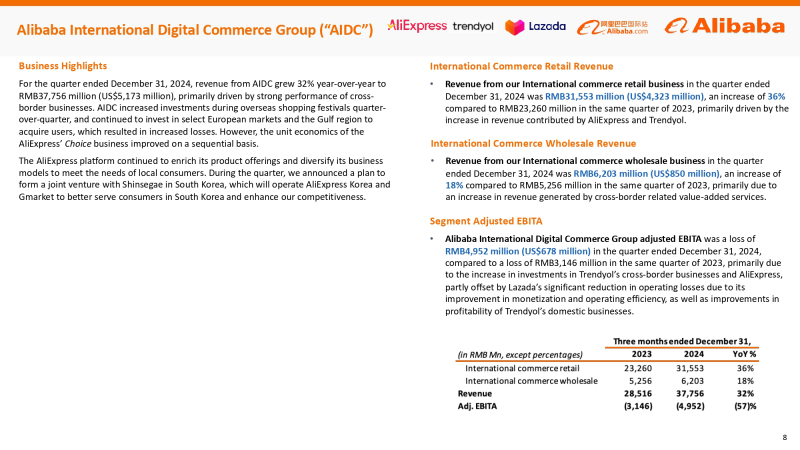

Alibaba в ближайшие три года инвестирует в ИИ и облака $52 млрд — больше, чем за десять лет до этогоAlibaba Group Holding Limited сообщила финансовые результаты III квартала 2024 финансового года, закончившегося 31 декабря 2024 года, которые превысили прогнозы аналитиков. Выручка компании составила ¥280,15 млрд ($38,38 млрд), что на 8 % больше результата аналогичного квартала предыдущего финансового года и выше консенсус-прогноза 17 аналитиков, опрошенных LSEG, в размере ¥279,34 млрд. Инвесторы позитивно оценили квартальные итоги, а также планы китайского технологического гиганта больше инвестировать в электронную коммерцию и ИИ. Благодаря этому на торгах Гонконгской фондовой биржи акции Alibaba поднялись в цене более чем на 10 %, достигнув самого высокого уровня за более чем три года, пишет Reuters. Американские депозитарные расписки компании выросли примерно на 12 % на утренних торгах в Нью-Йорке после публикации результатов, демонстрируя самый большой однодневный процентный прирост с сентября прошлого года, сообщила газета The Wall Street Journal. Согласно Reuters, стоимость акции Alibaba выросла с начала года на 60 %. Чистая прибыль (GAAP), причитающаяся держателям обыкновенных акций, составила ¥48,95 млрд ($6,71 млрд), что значительно превышает прошлогодний результат в размере ¥14,43 млрд ($1,98 млрд) и консенсус-прогноз аналитиков от LSEG в размере ¥40,6 млрд ($5,56 млрд). Чистая прибыль (GAAP) на разводнённую акцию составила ¥2,55 ($0,35). Скорректированная чистая прибыль (Non-GAAP) за квартал составила ¥51,07 млрд ($7,0 млрд), что на 6 % больше результата за III квартал 2023 финансового года. Скорректированная разводнённая прибыль на акцию (Non-GAAP) составила ¥2,67 ($0,37), превысив на 13 % прошлогодний показатель. Скорректированная EBITA выросла на 33 % в годовом исчислении до ¥3,14 млрд ($430 млн). Рост произошёл в основном за счёт сдвига в ассортименте продукции в сторону более прибыльных публичных облачных продуктов и повышения операционной эффективности, что частично компенсировалось ростом инвестиций в развитие клиентской базы и технологий. Международный бизнес электронной коммерции, включающий платформу AliExpress, B2B-площадку Alibaba.com и другие региональные платформы, остался одним из самых быстрорастущих в компании, увеличив выручку на 32 % до ¥37,76 млрд ($5,18 млрд). Выручка подразделения Cloud Intelligence Group компании Alibaba выросла на 13 % с ¥28,07 млрд ($3,85 млрд) в прошлом году до ¥31,74 млрд ($4,35 млрд). Как сообщает компания, рост был обусловлен увеличением внедрения продуктов, связанных с ИИ, выручка от которых сохраняла трехзначный процентный годовой рост шестой квартал подряд. Компания подчеркнула приверженность продвижению мультимодального ИИ и open source. В январе 2025 года Alibaba открыла исходный код Qwen2.5-VL, мультимодальной модели следующего поколения, и запустила флагманскую MoE-модель Qwen2.5-Max. Обе модели доступны пользователям и предприятиям через Qwen Chat и собственную платформу Bailian. С августа 2023 года компания открыла целый ряд различных LLM Qwen. По состоянию на 31 января 2025 года на Hugging Face было разработано более 90 тыс. производных моделей на основе семейства Qwen, что делает его одним из крупнейших семейств ИИ-моделей. Alibaba добилась «значительных успехов» в развитии своего облачного бизнеса в области ИИ после запуска своей флагманской модели Qwen 2.5-Max AI Foundation, сообщила компания Barclays в заметке для инвесторов, добавив, что наблюдается резкий рост спроса на инференс, на который приходится до 70 % всех заказов клиентов. Глава Alibaba Эдди Ву (Eddie Wu) сообщил на встрече с аналитиками, что ИИ — это «та возможность для трансформации отрасли, которая появляется только раз в несколько десятилетий». Он также сказал, что Alibaba вложит в течение следующих трёх лет больше средств в ИИ и облачные вычисления, чем за последнее десятилетие, но не назвал точную сумму. По оценкам Barclays, запланированные инвестиции превысят ¥270 млрд ($37,0 млрд). В этом месяце Alibaba Cloud открыла второй ЦОД в Таиланде в рамках стратегии по расширению присутствия в Юго-Восточной Азии, сообщил ресурс Data Center Dynamics. UPD 24.02.2024: компания официально объявила о намерении инвестировать не менее ¥380 млрд ($52,44 млрд) в облачную и ИИ-инфраструктуру в течение трёх лет.

13.02.2025 [23:58], Руслан Авдеев

Big Data для Большого Брата: глава Oracle предложил собрать все-все данные американцев и обучить на них сверхмощный «присматривающий» ИИ

big data

llm

oracle

software

база данных

государство

ии

информационная безопасность

конфиденциальность

сша

По словам главы Oracle Ларри Эллисона (Larry Ellison), если правительства хотят, чтобы ИИ повысил качество обслуживания и защиту граждан, то необходимо собрать буквально всю информацию о них, включая даже ДНК, в единой базе, которую и использовать для обучения ИИ, сообщает The Register. Таким мнением Эллисон поделился с бывшим премьер-министром Великобритании Тони Блэром (Tony Blair) на мероприятии World Governments Summit в Дубае. Глава Oracle считает, что вскоре искусственный интеллект изменит жизнь каждого обитателя Земли во всех отношениях. По его мнению, нужно сообщить правительству как можно больше информации. Для этого необходимо свести воедино все национальные данные, включая геопространственные данные, информацию об экономике, электронные медицинские записи, в т.ч. информацию о ДНК, сведения об инфраструктуре и др. Т.е. передать буквально всё, обучить на этом массиве ИИ, а потом задавать ему любые вопросы. Подобный проект первым можно реализовать в США, говорит Эллисон. Результатами, по мнению мультимиллиардера, станет рост качества здравоохранения благодаря персонализации медицинской помощи, возможность прогнозировать урожайность и оптимизировать на этой основе производство продовольствия. Можно будет анализировать качество почв, чтобы дать рекомендации фермерам — где именно вносить удобрения и улучшать орошение и др. По словам Эллисона, когда все данные будут храниться в одном месте, можно будет лучше заботиться о пациентах и населении в целом, управлять всевозможными социальными сервисами и избавиться от мошенничества. Конечно, такая система баз данных может стать предшественницей тотальной системы наблюдения — о необходимости чего-то подобного мультимиллиардер говорил ещё в прошлом году, намекая, что реализовать такой проект могла бы именно Oracle. Постоянный надзор за населением в режиме реального времени с анализом данных системами машинного обучения Oracle, по его словам, позволит всем «вести себя наилучшим образом». Oracle уже является крупным правительственным и военным подрядчиком в США и готова помочь другим странам реализовать подобные всеобъемлющие ИИ-проекты. Все данные, конечно, предполагается поместить в одну большую систему за авторством Oracle. Как заявил Эллисон, Oracle уже строит ЦОД ёмкостью 2,2 ГВт и стоимостью $50–$100 млрд. Именно на таких площадках будет учиться «сверхмощный» ИИ. Поскольку такие модели очень дороги, свои собственные клиентам, вероятно, обучать и не придётся, зато такие площадки позволят сделать несколько разных крупных моделей. В мире всего несколько компаний, способных обучать модели такого масштаба. В их числе, конечно, Oracle с собственной инфраструктурой. Компания присоединилась к ИИ-мегапроекту Stargate, реализация которого в течение следующих четырёх лет обойдётся в $500 млрд.

06.02.2025 [16:46], Руслан Авдеев

Индия должна стать лидером в создании малых «рассуждающих» ИИ-моделей, заявил Сэм АльтманНа заключительном этапе азиатского турне глава OpenAI Сэм Альтман (Sam Altman) заявил, что Индия способна стать одним из лидеров в гонке ИИ, особенно — в деле создании малых «рассуждающих» моделей (SLM). Альтман выразил интерес к динамичной экосистеме местных разработчиков, которая может стать ключевым элементом расширения OpenAI, сообщает DigiTimes. По словам Альтмана, Индия стала вторым по величине рынком для компании, поскольку за последний год число пользователей утроилось. Во время визита Альтман встретился с представителями правительства страны. Хотя затраты на разработку новых моделей по-прежнему высоки, Альтман признал, что прогресс в области ИИ может значительно снизить зависимость от дорогостоящего оборудования, а отдача от вложений в ИИ будет расти экспоненциально. Это приведёт к ежегодному десятикратному снижению стоимости «единиц интеллекта» — условного измерения вычислительной эффективности ИИ. По словам бизнесмена, мир достиг стадии невероятного прогресса в сфере «дистилляции» моделей. Хотя обучение даже малых моделей остаётся довольно дорогим, именно небольшие модели с возможностью «рассуждений» приведут буквально к взрыву креативности. И Индия должна быть на переднем крае прогресса. Альтман особенно выделил потенциал проектов в здравоохранении и образовании, где ИИ способен стать движущей силой преобразований. Сейчас индийские компании обратили внимание на открытые модели, включая DeepSeek. Стоит отметить, что в ходе визита в Индию в июне 2023 года Альтман охарактеризовал шансы страны на создание ИИ-моделей уровня ChatGPT как «совершенно безнадёжные». Теперь же он приятно удивлён достижениями Индии в этой области. Глава OpenAI отдельно пояснил, что прежние высказывания относились к трудностям конкуренции с IT-гигантами при создании экономически эффективных моделей. Альтман отдельно подчеркнул, что стоимость API OpenAI значительно упала, и намекнул, что в будущем тоже возможно появление open source инициатив. Индия активно продвигает ИИ-проекты в рамках инициативы IndiaAI, подкреплённой инвестициями в объёме ₹103,7 млрд рупий ($1,2 млрд). Местную большую языковую модель (LLM) власти намерены создать в течение десяти месяцев. Представители Министерства коммуникаций и информационных технологий Индии заявили, что создание базовой структуры уже завершено, теперь усилия разработчиков направлены на создание вариантов моделей, соответствующих уникальным языковым и культурным требованиям страны.

03.02.2025 [15:21], Сергей Карасёв

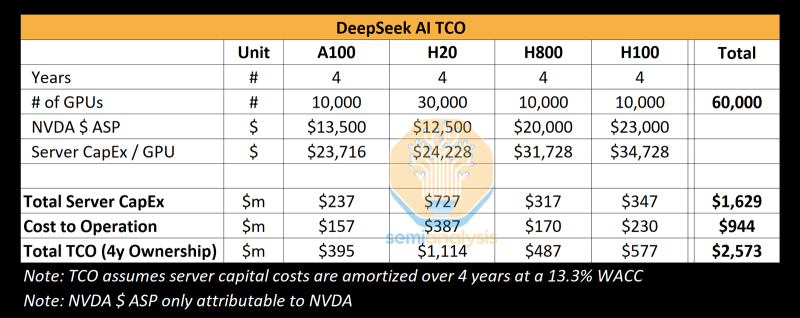

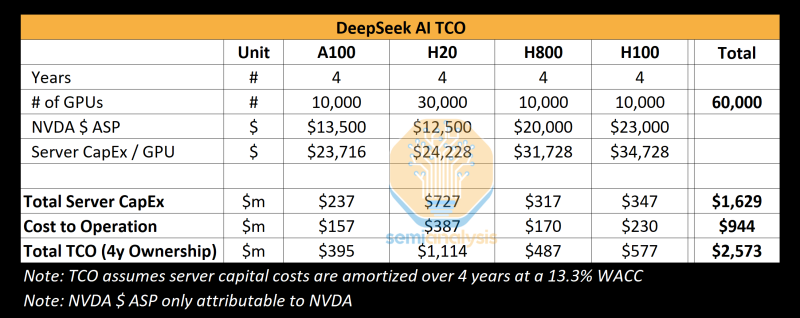

Реальные затраты DeepSeek на создание ИИ-моделей на порядки выше заявленных, но достижений компании это не умаляетКитайский стартап DeepSeek наделал много шума в Кремниевой долине, анонсировав «рассуждающую» ИИ-модель DeepSeek R1 c 671 млрд параметров. Утверждается, что при её обучении были задействованы только 2048 ИИ-ускорителей NVIDIA H800, а затраты на данные работы составили около $6 млн. Это бросило вызов многим западным конкурентам, таким как OpenAI, а акции ряда крупных ИИ-компаний начали падать в цене. Однако, как сообщает ресурс SemiAnalysis, фактические расходы DeepSeek на создание ИИ-инфраструктуры и обучение нейросетей могут быть гораздо выше. Стартап DeepSeek берёт начало от китайского хедж-фонда High-Flyer. В 2021 году, ещё до введения каких-либо экспортных ограничений, эта структура приобрела 10 тыс. ускорителей NVIDIA A100. В мае 2023 года с целью дальнейшего развития направления ИИ из High-Flyer была выделена компания DeepSeek. После этого стартап начал более активное расширение вычислительной ИИ-инфраструктуры. По данным SemiAnalysis, на сегодняшний день DeepSeek имеет доступ примерно к 10 тыс. изделий NVIDIA H800 и 10 тыс. NVIDIA H100. Кроме того, говорится о наличии около 30 тыс. ускорителей NVIDIA H20, которые совместно используются High-Flyer и DeepSeek для обучения ИИ, научных исследований и финансового моделирования. Таким образом, в общей сложности DeepSeek может использовать до 50 тыс. ускорителей NVIDIA при работе с ИИ, что в разы больше заявленной цифры в 2048 ускорителей. Кроме того, SemiAnalysis сообщает, что общие капитальные затраты на ИИ-серверы для DeepSeek составили около $1,6 млрд, тогда как операционные расходы могут достигать $944 млн. Это подрывает заявления о том, что DeepSeek заново изобрела процесс обучения ИИ и инференса с существенно меньшими инвестициями, чем лидеры отрасли. Цифра в $6 млн не учитывает затраты на исследования, тюнинг модели, обработку данных и пр. На самом деле, как подчёркивается, DeepSeek потратила более $500 млн на разработки с момента своего создания. И всё же DeepSeek имеет ряд преимуществ перед другими участниками глобального ИИ-рынка. В то время как многие ИИ-стартапы полагаются на внешних поставщиков облачных услуг, DeepSeek эксплуатирует собственные дата-центры, что позволяет быстрее внедрять инновации и полностью контролировать разработку, оптимизируя расходы. Кроме того, DeepSeek остаётся самофинансируемой компанией, что обеспечивает гибкость и позволяет более оперативно принимать решения. Плюс к этому DeepSeek нанимает специалистов исключительно из Китая, уделяя особое внимание не формальным записям в аттестатах, а практическим навыкам работы и способностям эффективно выполнять поставленные задачи. Некоторые ИИ-исследователи в DeepSeek зарабатывают более $1,3 млн в год, что говорит об их высочайшей квалификации.

03.02.2025 [09:20], Руслан Авдеев

The Register: Успех DeepSeek показал важность обдуманных инвестиций в ИИ, но потребность в развитии инфраструктуры никуда не денетсяШок, вызванный недавним триумфом китайского ИИ-стартапа DeepSeek, представившего дешёвые и эффективные ИИ-модели, заставил многих усомниться в результативности масштабных вложений в инфраструктуру на базе дорогих ИИ-ускорителей, сообщает The Register. Тем не менее эксперты уверены, что отказываться от инвестиций было бы нецелесообразно. На прошлой неделе акции ряда крупнейших американских ИИ-брендов после дебюта весьма эффективной модели DeepSeek R1, использующей, со слов создателей, сравнительно мало ускорителей NVIDIA, буквально обрушились в цене. Из-за этого многие эксперты усомнились в том, что траты миллиардов на аппаратную инфраструктуру для ИИ себя оправдывают, если Китай способен добиться хороших результатов, используя не самое мощное оборудование. Например, NVIDIA «в моменте» потеряла $600 млрд рыночной стоимости. Настоящая истерия наложилась на растущее беспокойство в связи с тем, что всё больше денег тратится на инфраструктуру и её поддержку, а особенной отдачи пока не видно. Впрочем, паника может быть неуместной, поскольку обрушение акций прекратилось, а DeepSeek обвиняется в использовании ИИ-моделей Anthropic и OpenAI. Как отмечает The Register, нет и реальных подтверждений того, что производительность моделей DeepSeek находится на уровне лучших из актуальных моделей, а также того, что на обучение китайского ИИ ушло всего $6 млн. По оценкам SemiAnalysis, доступная DeepSeek инфраструктура гораздо больше, чем утверждает компания, и стоит более чем $1,5 млрд. По словам экспертов Omdia, опасения относительно «сокрушительных» инноваций DeepSeek сильно преувеличены. В компании подтверждают, что китайский стартап использовал некоторые «гениальные инновации», но они приведут лишь к массовому использованию аналогичных решений и строительству новой ИИ-инфраструктуры. В Omdia прогнозируют, что в ближайшие годы рынок ИИ-инфраструктуры, скорее всего, значительно вырастет. В компании полагают, что до 2028 года поставки серверов для инференса будут расти на 17 % ежегодно. В TrendForce придерживаются несколько иного мнения и предполагают, что в будущем организации всё же станут более строго оценивать инвестиции в инфраструктуру ИИ и станут применять более эффективные модели для того, чтобы снизить зависимость от доступности ускорителей. Также не исключается, что чаще будут использоваться кастомные ASIC вместо сторонних ИИ-ускорителей и спрос на «классические» модели может претерпеть с 2025 года заметные изменения. Если раньше индустрия полагалась в первую очередь на масштабирование моделей, увеличение объёмов данных и повышение производительности оборудования, то теперь стратегия меняется. DeepSeek прибегла к «дистилляции» моделей, повышению скорости инференса и снижения зависимости от оборудования. Не так давно генеральный директор IBM Арвинд Кришна (Arvind Krishna) объявил, что деятельность DeepSeek подтвердила правильность подхода к ИИ его собственной компании, считающей, что модели могут быть меньше, как и время их обучения. При использовании подобных подходов затраты на инференс могут снизиться в 30 раз, что очень хорошо для корпоративных клиентов. Ещё в 2023 году компания начала развивать серию «экономичных» базовых моделей Granite. Вероятно, по этому пути пойдут и другие. Gartner также сообщает, что именно эффективное масштабирование ИИ будет целесообразнее простого наращивания вычислительных ресурсов. Впрочем, китайский ИИ не устанавливает новый стандарт эффективности моделей, поскольку те соответствуют показателям уже существующих, но не превосходят их. Кроме того, нет доказательств, что добавление дополнительных вычислительных ресурсов и данных не имеет значения. The Register прогнозирует, что продукты и технологии DeepSeek не вызовут резкого падения спроса на ИИ-инфраструктуру, поэтому инвесторам NVIDIA и строителям ЦОД, вероятно, можно не бояться того, что «пузырь» ИИ лопнет, как этого ожидают некоторые эксперты. Во всяком случае одни из крупнейших инвесторов в сектор ЦОД — Blackstone и Brookfield — заявили, что следят за успехами DeepSeek, но отказываться от инвестиций не собираются. Тем не менее, успех китайского стартапа напоминает о том, что «всегда можно сделать ещё лучше» и экстенсивное вливание денег и вычислительных ресурсов не всегда лучший вариант. |

|