Материалы по тегу: cloud

|

30.01.2024 [15:35], Сергей Карасёв

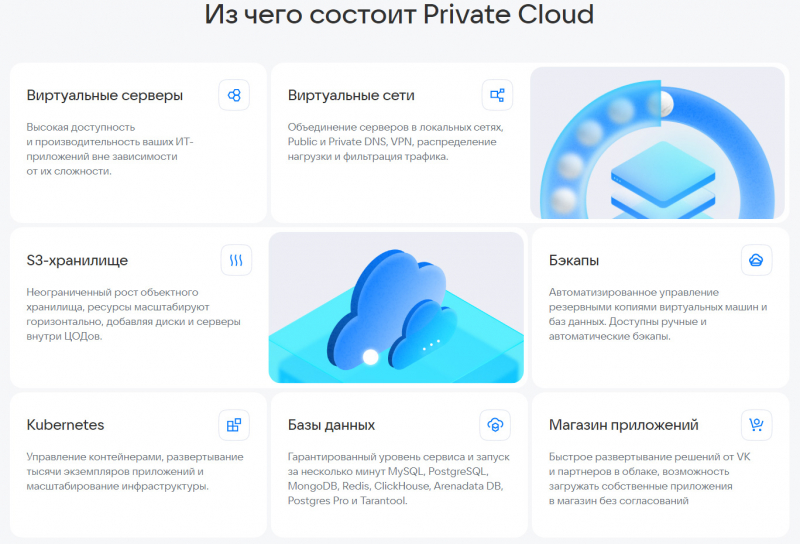

VK Сloud запустила улучшенную версию частного облака для бизнесаVK Сloud представила платформу Private Cloud версии 4.0, предназначенную для построения частного облака на базе дата-центра заказчика. Усовершенствованное решение, как утверждается, обеспечивает повышенный уровень защищённости: ядро облака соответствует 17-му приказу ФСТЭК (Об утверждении требований о защите информации, не составляющей государственную тайну, содержащейся в государственных информационных системах). На обновлённой платформе разработчикам стал доступен маркетплейс приложений. Магазин помогает осуществлять быстрое развёртывание продуктов VK и партнёров в облаке, а также предоставляет возможность загружать собственные приложения и сервисы для внутренних команд. Платформа Private Cloud 4.0 поддерживает сертифицированные ФСТЭК операционные системы Alt Linux, Astra и РЕД ОС. Таким образом, в частном облаке можно размещать критическую информационную инфраструктуру и хранить персональные данные любых типов, в том числе биометрические и специальные. В рамках Private Cloud предлагаются готовые программно-аппаратные комплексы — оборудование с уже инсталлированным ПО частного облака. Поставщиками серверов и СХД являются Aquarius, DEPO, Fplus, ICL, Kraftway, OpenYard, Sitronix, Yadro, «Гравитон» и «Тринити». Среди ключевых преимуществ частного облака VK Сloud называет размещение IT-сервисов в периметре компании с возможностью хранения конфиденциальной информации; построение геораспределённой платформы; сокращение затрат на обслуживание и поддержку инфраструктуры благодаря автоматизации; создание импортонезависимого ЦОД с масштабированием на тысячи серверов; постоянно обновляемый стек технологий для разработки конкурентоспособных продуктов и пр. Стоимость ПО рассчитывается индивидуально в соответствии с требованиями каждого клиента.

26.01.2024 [21:55], Сергей Карасёв

Beeline cloud запустил сервис Cloud SD-WAN на базе решений «Лаборатории Касперского»Beeline cloud объявил о запуске платформы Cloud SD-WAN — специализированного решения для управления сетевой инфраструктурой предприятий. Утверждается, что система обеспечивает высокий уровень отказоустойчивости, гибкость настройки и надёжную защиту от киберугроз. В создании нового облачного сервиса приняла участие «Лаборатория Касперского», а в основу продукта положена платформа Kaspersky SD-WAN. К преимуществам Cloud SD-WAN провайдер относит возможность быстрого масштабирования сетевой инфраструктуры в соответствии с потребностями бизнеса. Кроме того, достигается повышение отказоустойчивости сети благодаря использованию всех доступных каналов связи одновременно с автоматически выбором лучшего соединения в качестве основного и резервированием остальных. Вместе с тем интегрированные механизмы безопасности отвечают за защиту от угроз и атак в реальном времени.

Источник изображения: pixabay.com В целом, как отмечается, решение Cloud SD-WAN предоставляет клиентам возможность упростить свои сетевые процессы, значительно улучшить производительность и обеспечить безопасность данных в условиях постоянно меняющейся цифровой среды. «Cloud SD-WAN привнесёт значительные изменения в область сетевых технологий отечественных компаний. Наше совместное усилие направлено на предоставление клиентам инновационных решений, которые сочетают в себе передовые технологии и безопасность данных»,— говорит глава beeline cloud.

04.01.2024 [00:31], Владимир Мироненко

Китай построил 500-Пфлопс публичную ИИ-платформу Shangzhuang, которая вскоре станет втрое мощнееКитай запустил облачную ИИ-платформу, управляемую окологосударственным холдингом Beijing Energy Holding (BEH). «Пекинская публичная вычислительная платформа» (Beijing AI Public Computing Platform), также известная как проект Shangzhuang, поможет смягчить «острую нехватку вычислительных мощностей» в стране, необходимых для развития технологий ИИ. Платформа доступна для использования образовательными учреждениями, исследовательскими центрами, а также малыми и средними предприятиями. Её первая фаза с вычислительной мощностью 500 Пфлопс (FP16) была официально запущена в самом конце 2023 года. В I квартале 2024 года планируется завершить вторую фазу строительства, доведя производительность Shangzhuang до 1,5 Эфлопс. А в будущем остаётся возможность построить ещё 2 Эфлопс мощностей. BEH заявил о своём стремлении сделать проект максимально экологически дружественным, выразив намерение в будущем полностью обеспечивать платформу чистой энергией. С этой целью BEH подписал соглашения о стратегическом сотрудничестве с Alibaba Cloud Computing, Sugon Information Industry и стартапом Zhipu AI для совместной работы в области зелёной энергетики, публичного облака и инфраструктуры интеллектуальных вычислений.

28.11.2023 [22:20], Игорь Осколков

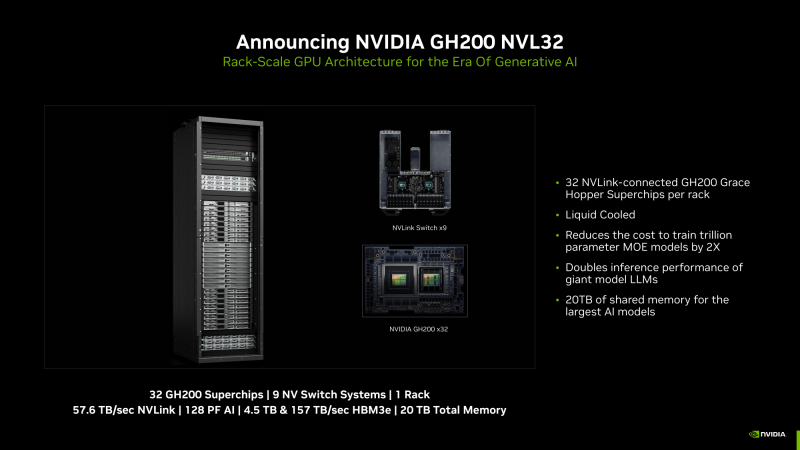

NVIDIA анонсировала суперускоритель GH200 NVL32 и очередной самый мощный в мире ИИ-суперкомпьютер Project CeibaAWS и NVIDIA анонсировали сразу несколько новых совместно разработанных решений для генеративного ИИ. Основным анонсом формально является появление ИИ-облака DGX Cloud в инфраструктуре AWS, вот только облако это отличается от немногочисленных представленных ранее платформ DGX Cloud тем, что оно первом получило гибридные суперчипах GH200 (Grace Hoppper), причём в необычной конфигурации.

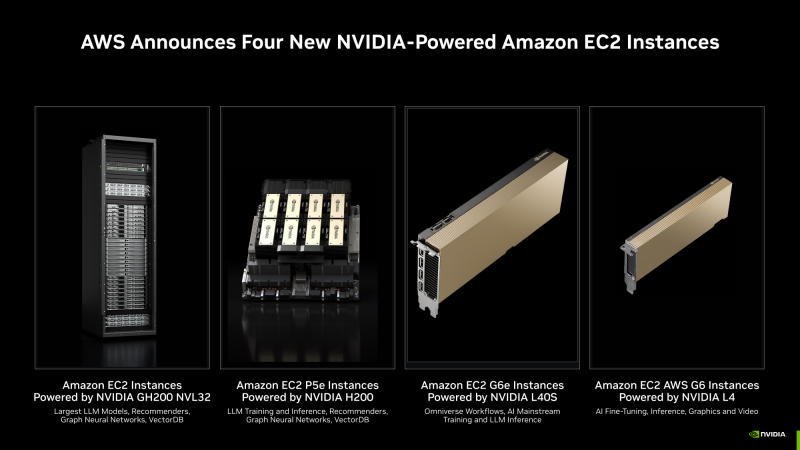

Изображения: NVIDIA В основе AWS DGX Cloud лежит платформа GH200 NVL32, но это уже не какой-нибудь сдвоенный акселератор вроде H100 NVL, а целая, готовая к развёртыванию стойка, включающая сразу 32 ускорителя GH200, провязанных 900-Гбайт/с интерконнектом NVLink. В состав такого суперускорителя входят 9 коммутаторов NVSwitch и 16 двухчиповых узлов с жидкостным охлаждением. По словам NVIDIA, GH200 NVL32 идеально подходит как для обучения, так и для инференса действительно больших LLM с 1 трлн параметров. Простым перемножением количества GH200 на характеристики каждого ускорителя получаются впечатляющие показатели: 128 Пфлопс (FP8), 20 Тбайт оперативной памяти, из которых 4,5 Тбайт приходится на HBM3e с суммарной ПСП 157 Тбайтс, и агрегированная скорость NVLink 57,6 Тбайт/с. И всё это с составе одного EC2-инстанса! Да, новая платформа использует фирменные DPU AWS Nitro и EFA-подключение (400 Гбит/с на каждый GH200). Новые инстансы, пока что безымянные, можно объединять в кластеры EC2 UltraClasters. Одним из таких кластеров станет Project Ceiba, очередной самый мощный в мире ИИ-суперкомпьютер с FP8-производительность 65 Эфлопс, объединяющий сразу 16 384 ускорителя GH200 и имеющий 9,1 Пбайт памяти, а также агрегированную пропускную способность интерконнекта на уровне 410 Тбайт/с (28,8 Тбайт/с NVLink). Он и станет частью облака AWS DGX Cloud, которое будет доступно в начале 2024 года. В скором времени появятся и EC2-инстансы попроще: P5e с NVIDIA H200, G6e с L40S и G6 с L4.

18.11.2023 [00:38], Владимир Мироненко

NVIDIA и Microsoft развернули в облаке Azure платформу для создания приложений генеративного ИИКомпания NVIDIA представила на конференции Microsoft Ignite 2023 сервис NVIDIA AI Foundry, который позволит предприятиям ускорить разработку и настройку пользовательских приложений генеративного ИИ с использованием собственных данных, развёртываемых в облаке Microsoft Azure. NVIDIA AI Foundry объединяет три элемента: набор базовых моделей NVIDIA AI Foundation, платформу и инструменты NVIDIA NeMo, а также суперкомпьютерные сервисы NVIDIA DGX Cloud AI. Вместе они предоставляют предприятиям комплексное решение для создания пользовательских моделей генеративного ИИ. Компании смогут затем развёртывать свои индивидуальные модели с помощью платформы NVIDIA AI Enterprise для создания приложений ИИ, включая интеллектуальный поиск, обобщение и генерацию контента. «Предприятиям нужны кастомные модели для реализации специализированных навыков, основанных на собственной ДНК их компании — их данных, — сообщил глава NVIDIA Дженсен Хуанг (Jensen Huang), — Сервис NVIDIA AI Foundry сочетает в себе наши технологии моделей генеративного ИИ, опыт обучения LLM и гигантскую фабрику ИИ. Мы создали это в Microsoft Azure, чтобы предприятия по всему миру могли подключить свою собственную модель к ведущим в мире облачным сервисам Microsoft».

Источник изображения: NVIDIA Сервис NVIDIA AI Foundry можно использовать для настройки моделей для приложений на базе генеративного ИИ в различных отраслях, включая корпоративное ПО, телекоммуникации и медиа. При их развёртывании компании смогут использовать метод генерации с расширенным поиском (RAG), чтобы привязать свои модели к базе корпоративных данных для получения актуальных ответов. В сервисе NVIDIA Foundry клиенты смогут выбирать из нескольких моделей NVIDIA AI Foundation, включая новое семейство Nemotron-3 8B в составе каталога моделей Azure AI. Разработчики также могут получить доступ к моделям Nemotron-3 8B в каталоге NVIDIA NGC и к популярным моделям Llama 2, Mistral и Stable Diffusion XL. NVIDIA сообщила, что одними из первых новым сервисом для создания моделей воспользовались SAP, Amdocs и Getty Images. Наконец, в Azure стала доступна и платформа NVIDIA DGX Cloud AI, в рамках которой клиенты смогут арендовать кластеры, состоящие из тысяч ускорителей NVIDIA и воспользоваться ПО NVIDIA AI Enterprise, включая NeMo, для ускорения настройки LLM. Клиенты Azure смогут использовать существующие кредиты Microsoft Azure Consumption Commitment для ускорения разработки ИИ-моделей. Отметим, что первым сервис DGX Cloud получило облако Oracle, где Microsoft арендует ускорители той же NVIDIA для собственных нужд. По слухам, компания также использует ускорители CoreWeave и Lambda Labs, а также разрабатывает более экономичные ИИ-модели. По-видимому, продавать доступ к аппаратным и иным решениям NVIDIA для Microsoft выгоднее, чем использовать для своих нужд. Впрочем, если всё сложится удачно, то компания перейдёт на ИИ-ускорители Maia 100 собственной разработки.

17.11.2023 [13:33], Сергей Карасёв

Alibaba отказалась от выделения облачного бизнеса в самостоятельную публичную компаниюКитайский IT-гигант Alibaba Group Holding в финансовом отчёте за квартал, завершившийся 30 сентября 2023 года, сообщил о том, что не будет выделять облачный бизнес в самостоятельную компанию с последующим выходом на биржу. Причина — ужесточившиеся санкции со стороны США в отношении КНР. Весной нынешнего года Alibaba объявила о намерении провести масштабную реорганизацию, в ходе которой на базе облачных активов планировалось создать отдельную структуру. В дальнейшем Alibaba рассчитывала провести IPO этой компании. Около двух месяцев назад, в середине сентября 2023-го, генеральный директор Alibaba Даниэль Чжан (Daniel Zhang), также возглавлявший облачное подразделение компании, неожиданно подал в отставку. Тогда сообщалось, что его место займёт Эдди Ву (Eddie Wu) — один из соучредителей Alibaba и один из первых её разработчиков. И вот теперь говорится, что планы по трансформации облачного бизнеса пересмотрены.

Источник изображения: Alibaba В финансовом отчёте сказано, что после того, как США расширили свои правила экспортного контроля, чтобы еще больше ограничить поставки в Китай современных компьютерных чипов и оборудования для производства полупроводников, сформировались неопределённости в отношении перспектив подразделения Alibaba Cloud Intelligence Group. Санкции могут негативно повлиять на возможности группы предлагать облачные продукты и услуги и выполнять обязательства по существующим контрактам. Кроме того, ограничивается потенциал модернизации оборудования. «Мы считаем, что полное выделение Cloud Intelligence Group в самостоятельную структуру может не дать желаемого эффекта. Поэтому мы решили не приступать к реализации данного плана, а вместо этого сосредоточимся на разработке модели устойчивого роста для Cloud Intelligence Group в нынешней нестабильной ситуации», — говорится в заявлении Alibaba. По итогам закрытого квартала выручка Alibaba Group составила ¥224,79 млрд ($30,81 млрд), что на 9 % больше прошлогоднего результата. Чистая прибыль оказалась на уровне ¥27,71 млрд ($3,80 млрд). Облачное подразделение Cloud Intelligence Group показало квартальную выручку в размере ¥27,65 млрд ($3,79 млрд), что соответствует росту примерно на 2 % в годовом исчислении.

11.11.2023 [14:53], Владимир Мироненко

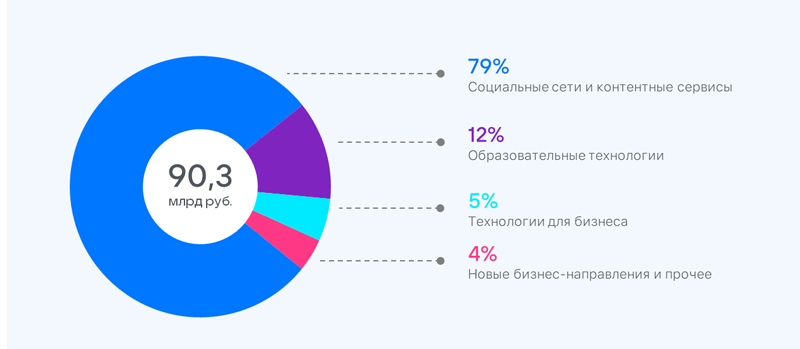

Выручка сервисов платформы VK Cloud выросла за 9 месяцев 2023 года на 58 %VK сообщила результаты работы в III квартале и за 9 месяцев 2023 года. Выручка компании в квартале выросла на 37 % год к году, составив 33 млрд руб. Аналогичный рост выручки был зафиксирован по итогам 9 месяцев, выручка составила 90,3 млрд руб. В сегменте «Технологии для бизнеса» (VK Tech) выручка за 9 месяцев выросла на 63 % в годовом выражении, составив 4,8 млрд руб. Драйвером роста были коммуникационные сервисы VK WorkSpace, чья выручка выросла за 9 месяцев в 2,5 раза год к году, а за квартал — на 214 %, и облачные сервисы платформы VK Cloud, выручка которых с начала года выросла на 58 %. Выручка от HR-сервисов увеличилась за этот период в 2,5 раза (рост на 217 % за квартал). В сентябре 2023 года VK Tech запустил единую партнёрскую программу для бизнеса, которая позволит масштабировать экспертизу внедрения ИТ-продуктов VK.

Источник изображения: VK За III квартал средняя месячная аудитория сервиса «Облако Mail.ru» составила 20 млн, а средняя дневная аудитория — 2,2 млн. За отчётный период пользователи загрузили в «Облако Mail.ru» около 7,5 млрд файлов. В августе 2023 года состоялся запуск сервиса «Облако на ПК», который позволил пользователям перенести файлы из других облачных хранилищ. На данный момент доступна интеграция с 11 облачными сервисами.

08.11.2023 [20:00], Игорь Осколков

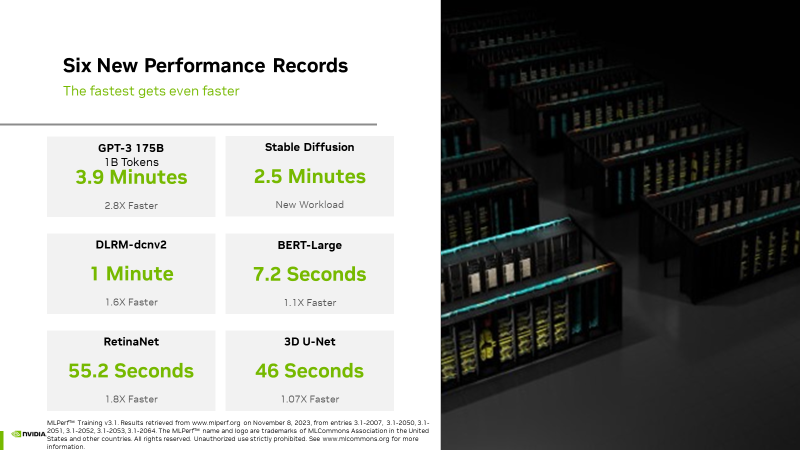

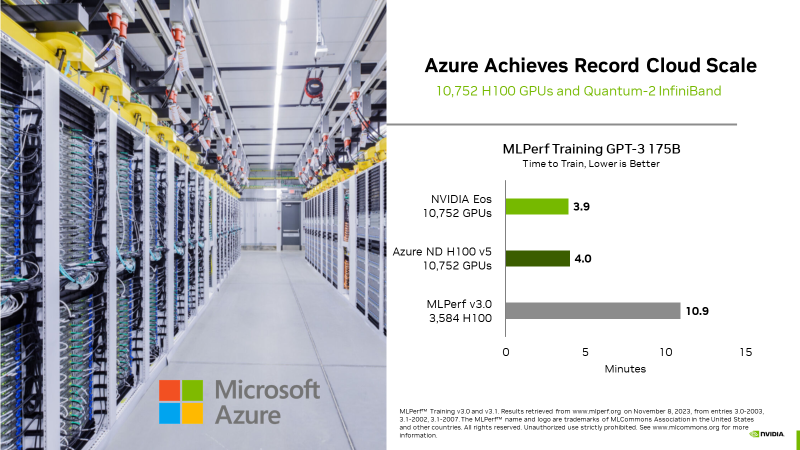

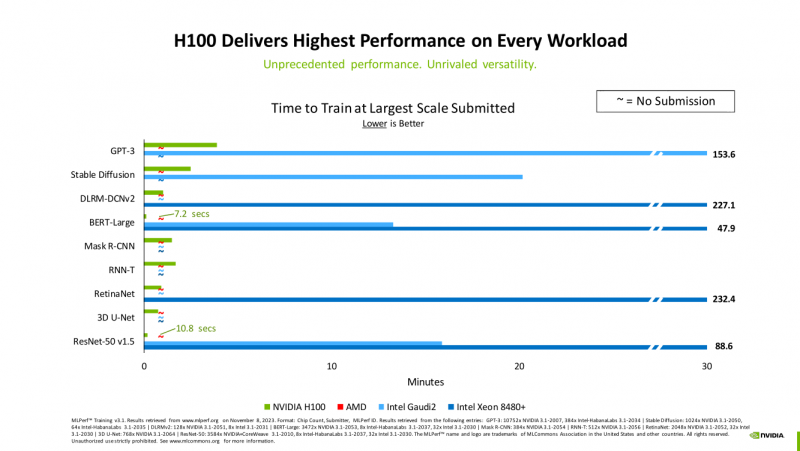

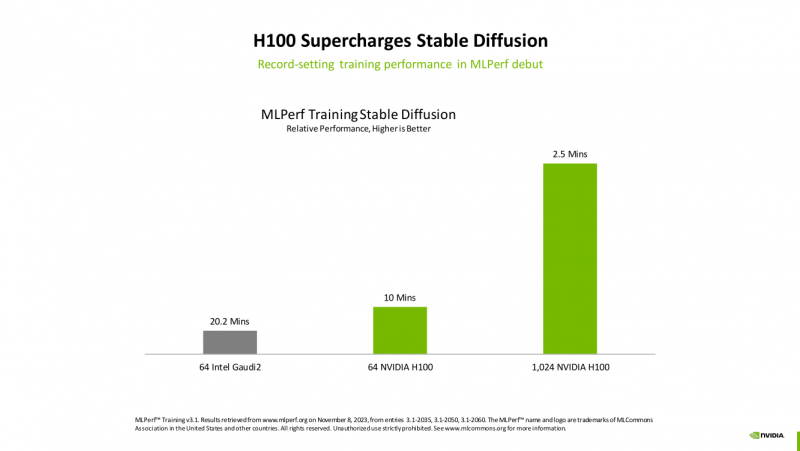

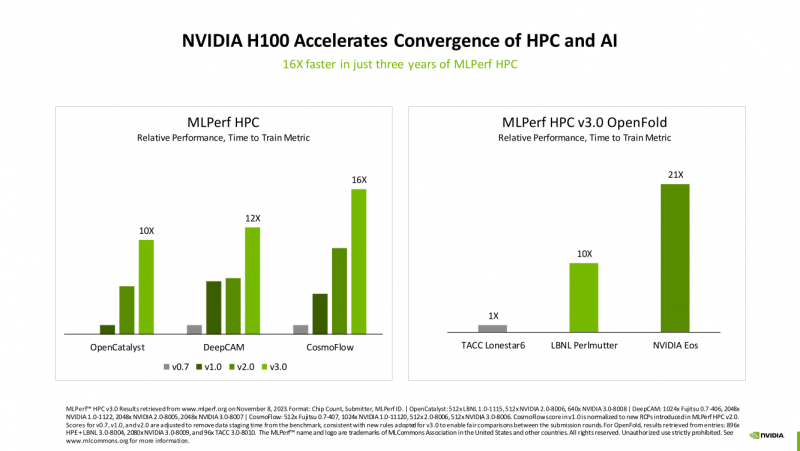

Счёт на секунды: ИИ-суперкомпьютер NVIDIA EOS с 11 тыс. ускорителей H100 поставил рекорды в бенчмарках MLPerf TrainingВместе с публикацией результатов MLPerf Traning 3.1 компания NVIDIA официально представила новый ИИ-суперкомпьютер EOS, анонсированный ещё весной прошлого года. Правда, с того момента машина подросла — теперь включает сразу 10 752 ускорителя H100, а её FP8-производительность составляет 42,6 Эфлопс. Более того, практически такая же система есть и в распоряжении Microsoft Azure, и её «кусочек» может арендовать каждый, у кого найдётся достаточная сумма денег. Суммарно EOS обладает порядка 860 Тбайт памяти HBM3 с агрегированной пропускной способностью 36 Пбайт/с. У интерконнекта этот показатель составляет 1,1 Пбайт/с. В данном случае 32 узла DGX H100 объединены посредством NVLink в блок SuperPOD, а за весь остальной обмен данными отвечает 400G-сеть на базе коммутаторов Quantum-2 (InfiniBand NDR). В случае Microsoft Azure конфигурация машины практически идентичная с той лишь разницей, что для неё организован облачный доступ к кластерам. Но и сам EOS базируется на платформе DGX Cloud, хотя и развёрнутой локально. В рамках MLPerf Training установила шесть абсолютных рекордов в бенчмарках GPT-3 175B, Stable Diffusion (появился только в этом раунде), DLRM-dcnv2, BERT-Large, RetinaNet и 3D U-Net. NVIDIA на этот раз снова не удержалась и добавила щепотку маркетинга на свои графики — когда у тебя время исполнения теста исчисляется десятками секунд, сравнивать свои результаты с кратно меньшими по количеству ускорителей кластерами несколько неспортивно. Любопытно, что и на этот раз сравнивать H100 приходится с Habana Gaudi 2, поскольку Intel не стесняется показывать результаты тестов. NVIDIA очередной раз подчеркнула, что рекорды достигнуты благодаря оптимизациям аппаратной части (Transformer Engine) и программной, в том числе совместно с MLPerf, а также благодаря интерконнекту. Последний позволяет добиться эффективного масштабирования, близкого к линейному, что в столь крупных кластерах выходит на первый план. Это же справедливо и для бенчмарков из набора MLPerf HPC, где система EOS тоже поставила рекорд.

29.10.2023 [23:16], Владимир Мироненко

Yandex Cloud увеличил на 60 % выручку в III квартале«Яндекс» сообщил неаудированные финансовые результаты за III квартал 2023 года. Выручка компании выросла год к году на 54 % до 204,77 млрд руб., в то время как чистая прибыль сократилась на 83 % с 45,54 млрд руб. в III квартале 2022 года до 7,68 млрд руб. в отчётном. Выручка «Яндекса» по основному направлению «Поиск и портал» выросла на 48 % до 90,4 млрд руб. Доля «Яндекса» на российском поисковом рынке составила 62,6 %, увеличившись на 0,6 п.п. Облачное подразделение Yandex Cloud стало драйвером роста сегмента «Прочих бизнес-юнитов и инициатив», который также включает направление разработки беспилотных автомобилей (Yandex SDG), Yandex Cloud, «Яндекс 360», «Яндекс Образование» («Яндекс.Практикум» и другие образовательные инициативы), «Устройства и «Алису», «Финтех» (в том числе Yandex Pay и Яндекс ID) и т. д. Выручка Yandex Cloud выросла на 60 % год к году благодаря расширению предоставляемых услуг и увеличению доли рынка на фоне растущего спроса на сервисы Yandex Cloud. Выручка направления «Устройств» и «Алисы» увеличилась на 94 % год к году до 7,2 млрд руб. благодаря увеличению ассортимента доступных моделей и маркетинговой поддержке. Общая выручка в сегменте «Прочих бизнес-юнитов и инициатив» увеличилась в III квартале на 68 % до 18,81 млрд руб.

04.10.2023 [14:59], Сергей Карасёв

Без гиперскейлеров: NVIDIA хочет арендовать ЦОД для облачного сервиса DGX CloudКомпания NVIDIA, по сообщению ресурса The Information, ведёт переговоры об аренде площадей у одного из операторов ЦОД, но о ком именно идёт речь, не сообщается. Предполагается, что площадка будет использоваться для поддержания работы собственного облачного сервиса DGX Cloud, предназначенного для обучения передовых моделей для генеративного ИИ. О доступности облака DGX Cloud компания NVIDIA объявила в июле нынешнего года. Тогда сообщалось, что соответствующая вычислительная инфраструктура достанется в первую очередь США и Великобритании. Стоимость доступа к DGX Cloud начинается с $36 999 в месяц. Говорилось, что NVIDIA намерена продвигать DGX Cloud в партнёрстве с ведущими гиперскейлерами. Первым сервис появился в облаке Oracle Cloud Infrastructure (OCI), на очереди Microsoft Azure, Google Cloud Platform и другие. Большая часть выручки в этом случае достаётся именно NVIDIA, а не облакам.

Источник изображения: NVIDIA Теперь же, судя по всему, NVIDIA решила частично отказаться от услуг облачных провайдеров и развернуть DGX Cloud на арендованных ЦОД-площадях. Впрочем, как отмечается, переговоры всё ещё находятся на начальной стадии, а поэтому говорить о том, что NVIDIA сама превратится в гиперскейлера, преждевременно. При этом компания неоднократно упрекали в том, что в последнее время она более благосклонна к небольшим и специализированным облачным провайдерам, которые не пытаются создавать собственные ИИ-ускорители, могущие составить прямую конкуренцию продуктам NVIDIA. |

|