Материалы по тегу: 200gbe

|

26.02.2025 [08:32], Сергей Карасёв

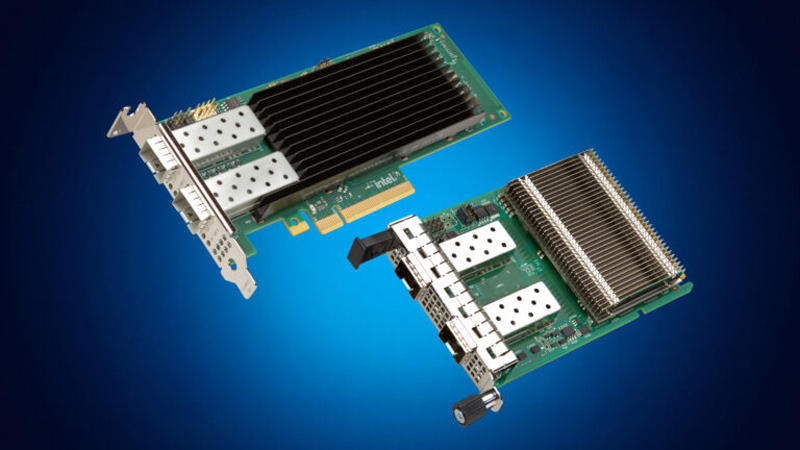

Intel представила 200GbE-адаптеры E830 и 10GbE-адаптеры E610Корпорация Intel анонсировала сетевые контроллеры и адаптеры серий Ethernet E830 и Ethernet E610, разработанные для удовлетворения растущих потребностей в пропускной способности каналов связи. Решения могут применяться в том числе в составе облачных платформ, систем НРС, ИИ и пр. По заявлениям Intel, Ethernet-изделия нового поколения вкупе с серверными процессорами Xeon 6 закладывают основу для масштабируемых приложений с интенсивным использованием данных. Адаптеры обеспечивают надёжное подключение на высоких скоростях при одновременном повышении энергоэффективности и снижении совокупной стоимости владения (TCO). Устройства серии Intel Ethernet E830 оптимизированы для высокоплотных виртуализированных рабочих сред. Эти контроллеры и адаптеры подходят для корпоративных, облачных и периферийных развёртываний. Кроме того, они могут применяться в составе телекоммуникационных инфраструктур. На начальном этапе будут доступны двухпортовые адаптеры 25GbE PCIe и OCP 3.0. В дальнейшем появятся модели в других конфигурациях, включая 1 × 200GbE, 2 × 100/50/25/10GbE и 8 × 25/10GbE. В целом, пропускная способность может достигать 200 Гбит/с при использовании интерфейса PCIe 5.0. Для изделий Intel Ethernet E830 заявлена поддержка различных функций обеспечения безопасности, включая Secure Boot, Secure Firmware Upgrade и Root of Trust на аппаратном уровне. Среди прочего заявлена поддержка PTM (Precision Time Measurement), 1588 PTP, SyncE и GNSS, что важно для финансовых и телекоммуникационных приложений, а также обучения моделей ИИ и инференса. Говорится о совместимости на уровне программного обеспечения и драйверов с продуктами серии Intel Ethernet E810.

Источник изображений: Intel В свою очередь, решения семейства Intel Ethernet E610 предлагают оптимальное сочетание управляемости, энергоэффективности и безопасности. Такие изделия могут применяться в рабочих станциях и на периферии. Заявлена поддержка стандартов 10GbE, 5GbE, 2.5GbE и 1GbE. Устройства будут доступны в различных форм-факторах. Intel говорит о сокращении энергопотребления на 50 % по сравнению с адаптерами предыдущего поколения. Реализована поддержка Root of Trust и современных криптографических функций.

23.12.2024 [12:20], Сергей Карасёв

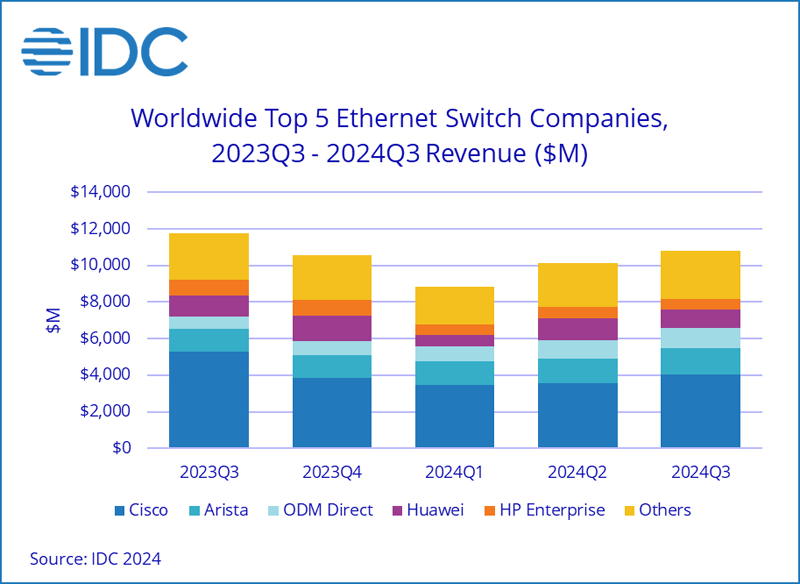

Продажи Ethernet-коммутаторов и маршрутизаторов корпоративного класса падают, но 200/400GbE-решения для ЦОД только растутКомпания International Data Corporation (IDC) подвела итоги исследования мирового рынка сетевого оборудования корпоративного класса в III квартале уходящего года. Продажи Ethernet-коммутаторов и маршрутизаторов сократились в годовом исчислении. В сегменте коммутаторов выручка в период с июля по сентябрь включительно составила $10,8 млрд. Это на 7,9 % меньше по сравнению с III четвертью 2023 года. В секторе решений для дата-центров выручка поднялась на 18,0 % в годовом исчислении, в секторе решений для прочих корпоративных заказчиков, напротив, сократилась на 24,7 %. Аналитики отмечают, что спрос на ЦОД-оборудование подпитывается внедрением ИИ-приложений, которые создают высокую нагрузку на каналы передачи данных. Объём реализации коммутаторов стандартов 200/400GbE для дата-центров увеличился в денежном выражении на 126,3 % по отношению к III кварталу 2023 года. В сегменте коммутаторов, не связанных с ЦОД, продажи устройств 1GbE рухнули на 25,6 % в годовом исчислении.

Источник изображения: IDC С географической точки зрения в США общий рынок коммутаторов Ethernet сократился на 6,5 % год к году. В Западной Европе падение составило 11,9 %, в Центральной и Восточной Европе — 17,8 %. В Азиатско-Тихоокеанском регионе, за исключением Японии и Китая, отмечено снижение на 8,7 % в годовом исчислении. В КНР продажи остались примерно на прошлогоднем уровне. В список крупнейших мировых поставщиков коммутаторов Ethernet входят Cisco, Arista Networks, Huawei, HPE и H3C с долями соответственно 37,2 %, 13,6 %, 9,7 %, 5,3 % и 4,1 %. Продажи маршрутизаторов в III квартале 2024 года сократились на 17,4 % по сравнению с 2023-м — до $3,1 млрд. На поставщиков услуг пришлось 70,8 % от общего объёма рынка, а падение год к году составило 22,3 %. Корпоративный сегмент обеспечил 29,2 % продаж с падением на 2,4 %.

21.07.2023 [23:10], Алексей Степин

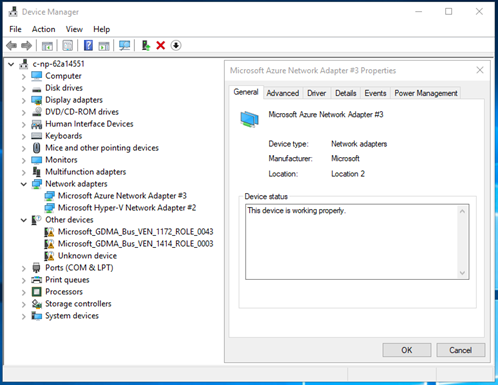

Microsoft предлагает протестировать DPU MANA с Azure BoostКрупные облачные провайдеры давно осознали пользу, которую могут принести DPU и активно применяют подобного рода решения. В частности, AWS давно использует платформу Nitro, Google разработала DPU при поддержке Intel, а Microsoft активно готовит к запуску собственную платформу под названием MANA. Основой MANA является кастомный чип SoC, разработанный специально с учётом обеспечения высокой пропускной способности, стабильности подключения и низкой латентности. DPU на его основе обеспечивает пропускную способность до 200 Гбит/с, а также поддерживает подключение удалённого хранилища данных на скоростях до 10 Гбайт/с при производительности до 400 тыс. IOPS. Отметим, что ранее AMD заявила о появлении DPU Pensando в облаке Azure, а сама Microsoft в прошлом году поглотила разработчика DPU Fungible.

Изображение: Microsoft MANA является частью услуги Azure Boost и берёт на себя управление всеми аспектами виртуализации, включая работу с сетью и данными, а также функции управления хост-системой. Перенос этих функций на отдельную платформу не просто улучшает производительность и масштабируемость, но и обеспечивает дополнительный слой безопасности. MANA уже задействованы в инфраструктуре Azure и подтвердили высочайшую скорость при работе с внешними хранилищами данных для инстансов Ebsv5, а также отличную пропускную способность и низкую латентность сетевого канала для всех инстансов семейств Ev5 и Dv5. MANA поддерживает Windows и Linux, а для более тонкой работы с аппаратной частью ускорителя можно задействовать DPDK. В части информационной безопасности следует отметить наличие криптоядра, соответствующего стандартам FIPS 140. В настоящее время сервис Azure Boost доступен в качестве превью. Компания приглашает к сотрудничеству партнёров и клиентов с высокими запросами к характеристикам сетевого канала и хранилищ.

22.06.2023 [17:04], Алексей Степин

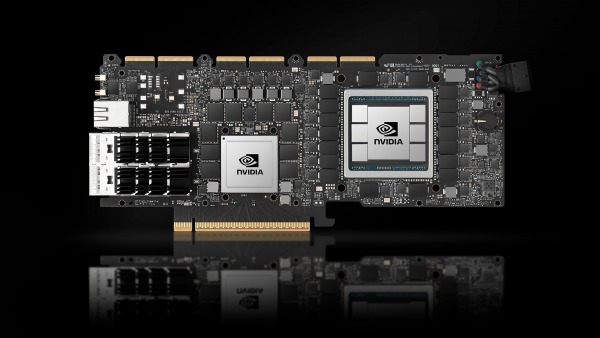

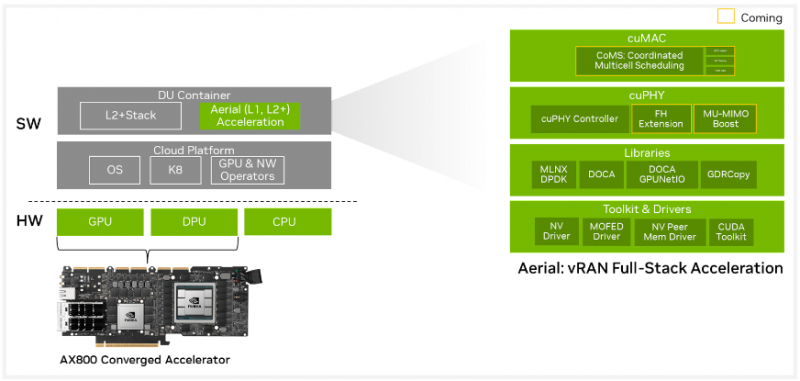

NVIDIA AX800: ИИ-сервер для 5G в форм-факторе PCIe-картыВ форм-факторе плат расширения PCIe существует множество устройств, включая, к примеру, маршрутизаторы. Но NVIDIA AX800 выводит это понятие на новый уровень — здесь плата расширения являет собой полноценный высокопроизводительный сервер. Плата включает DPU BlueField-3, который располагает 16 ядрами Cortex Arm-A78, дополненных 32 Гбайт RAM, а также ускоритель A100 (80 Гбайт). Новинкая является наследницей карты A100X, но с гораздо более производительным DPU. На борту также имеется eMMC объёмом 40 Гбайт, два 200GbEпорта (QSFP56). Плата выполнена в форм-факторе FHFL, имеет пассивное охлаждение и предельный теплопакет 350 Вт. Дополнительно предусмотрен порт 1GbE для удалённого управления для BMC ASPEED AST2600, так что речь действительно идёт о полноценном сервере. На PCB имеются гребёнки разъёмов NVLink — данное решение может работать не в одиночку, а в составе высокоплотного многопроцессорного сервера. NVIDIA позиционирует новинку как решение для систем 5G vRAN, но также она может найти место и в высокоплотных системах периферийных системах для ИИ-задач. В качестве программной платформы предлагается Aerial 5G vRAN. Плата ускоряет обработку L1/L2-трафика 5G и способна предложить до 36,56 и 4,794 Гбит/с нисходящей и восходящей пропускной способности (4T4R). Платформа поддерживает масштабирование от 2T2R до 64T64R (massive MIMO). А поддержка MIG позволяет гибко перераспределять нагрузки ИИ и 5G.

19.08.2021 [18:04], Алексей Степин

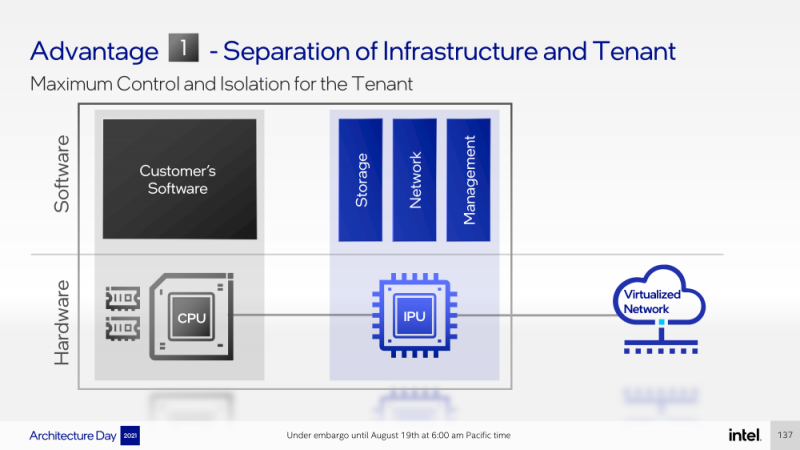

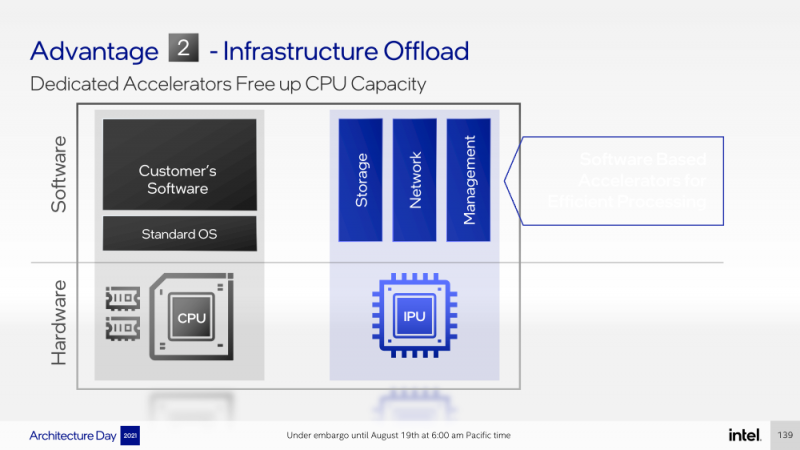

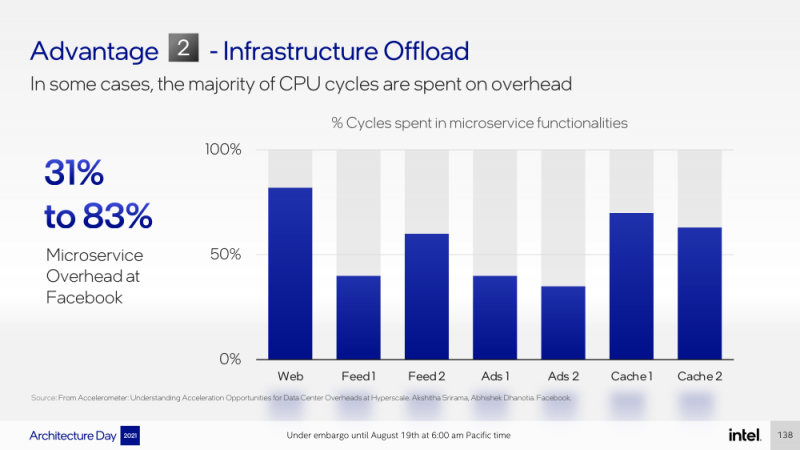

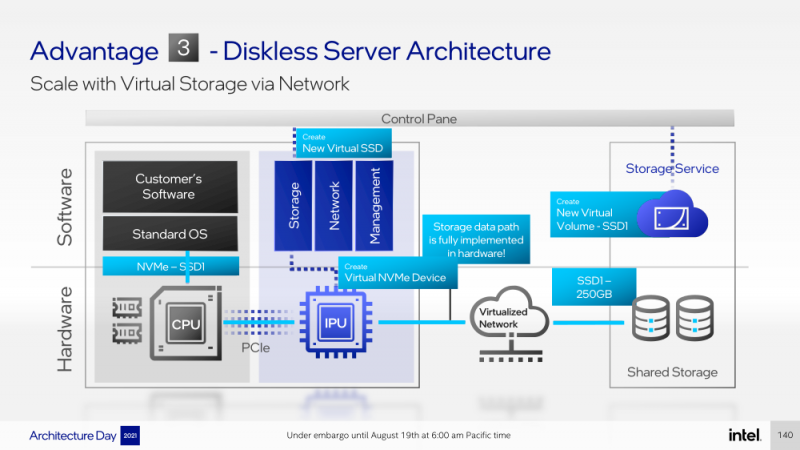

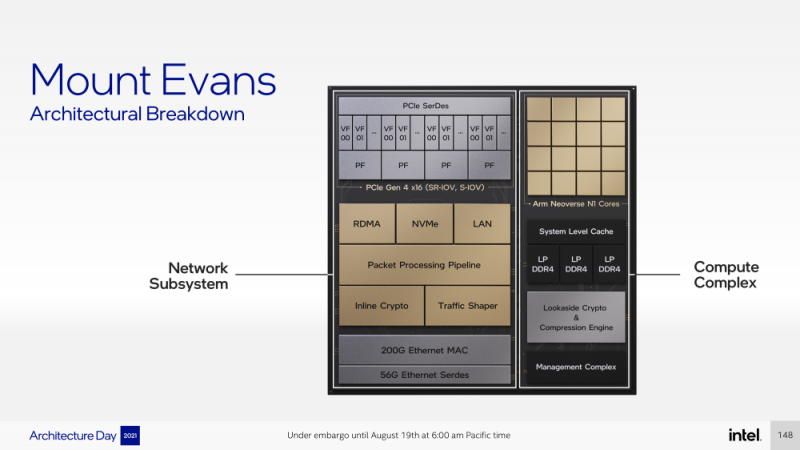

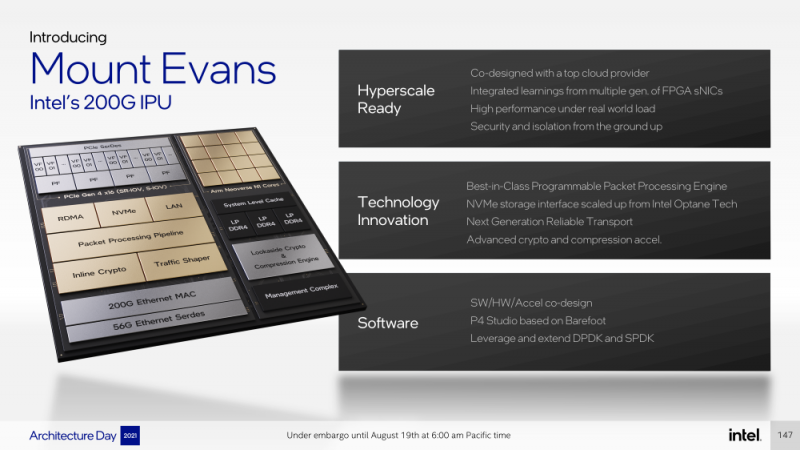

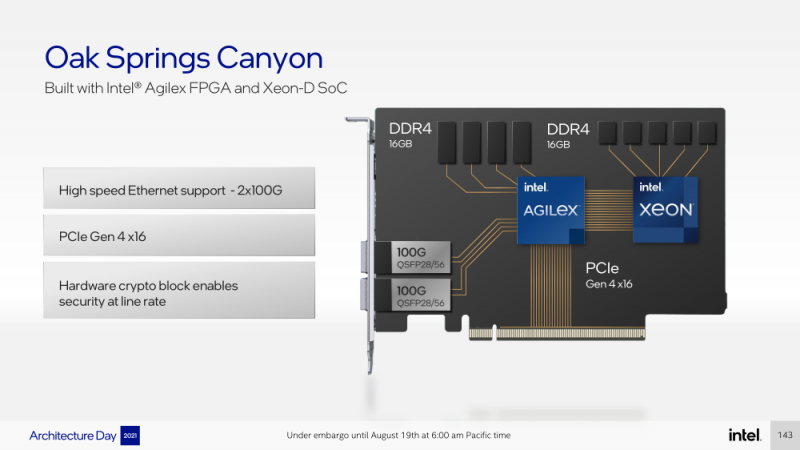

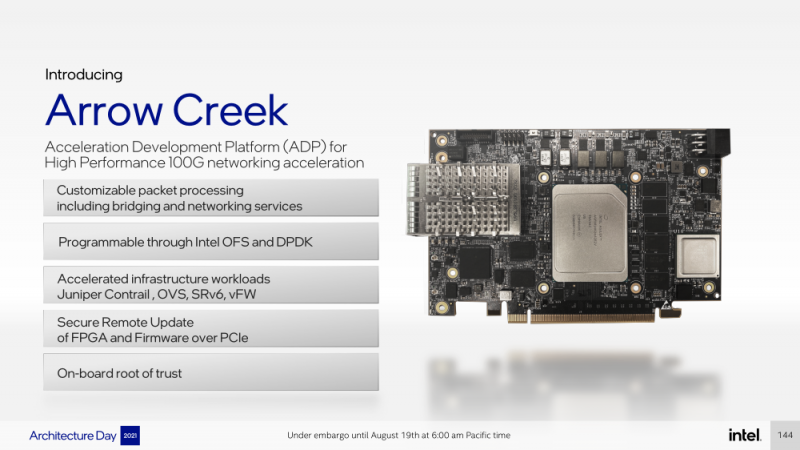

Intel представила IPU Mount Evans и Oak Springs Canyon, а также ODM-платформу N6000 Arrow CreekВесной Intel анонсировала свои первые DPU (Data Processing Unit), которые она предпочитает называть IPU (Infrastructure Processing Unit), утверждая, что такое именования является более корректным. Впрочем, цели у этого класса устройств, как их не называй, одинаковые — перенос части функций CPU по обслуживанию ряда подсистем на выделенные аппаратные блоки и ускорители. Классическая архитектура серверных систем такова, что при работе с сетью, хранилищем, безопасностью значительная часть нагрузки ложится на плечи центральных процессоров. Это далеко не всегда приемлемо — такая нагрузка может отъедать существенную часть ресурсов CPU, которые могли бы быть использованы более рационально, особенно в современных средах с активным использованием виртуализации, контейнеризации и микросервисов. Для решения этой проблемы и были созданы DPU, которые эволюционировали из SmartNIC, бравших на себя «тяжёлые» задачи по обработке трафика и данных. DPU имеют на борту солидный пул вычислительных возможностей, что позволяет на некоторых из них запускать даже гипервизор. Однако Intel IPU имеют свои особенности, отличающие их и от SmartNIC, и от виденных ранее DPU. Новый класс сопроцессоров Intel должен взять на себя все заботы по обслуживанию инфраструктуры во всех её проявлениях, будь то работа с сетью, с подсистемами хранения данных или удалённое управление. При этом и DPU, и IPU в отличие от SmartNIC полностью независим от хост-системы. Полное разделение инфраструктуры и гостевых задач обеспечивает дополнительную прослойку безопасности, поскольку аппаратный Root of Trust включён в IPU. Это не единственное преимущество нового подхода. Компания приводит статистику Facebook✴, из которой видно, что иногда более 50% процессорных тактов серверы тратят на «обслуживание самих себя». Все эти такты могут быть пущены в дело, если за это обслуживание возьмётся IPU. Кроме того, новый класс сетевых ускорителей открывает дорогу к бездисковой серверной инфраструктуре: виртуальные диски создаются и обслуживаются также чипом IPU. Первый чип в новом семействе IPU, получивший имя Mount Evans, создавался в сотрудничестве с крупными облачными провайдерами. Поэтому в нём широко используется кремний специального назначения (ASIC), обеспечивающий, однако, и нужную степень гибкости, За основу взяты ядра общего назначения Arm Neoverse N1 (до 16 шт.), дополненные тремя банками памяти LPDRR4 и различными ускорителями. Сетевая часть представлена 200GbE-интерфейсом с выделенным P4-программируемым движком для обработки сетевых пакетов и управления QoS. Дополняет его выделенный IPSec-движок, способный на лету шифровать весь трафик без потери скорости. Естественно, есть поддержка RDMA (RoCEv2) и разгрузки NVMe-oF, причём отличительной чертой является возможность создавать для хоста виртуальные NVMe-накопители — всё благодаря контроллеру, который был позаимствован у Optane SSD. Дополняют этот комплекс ускорители (де-)компресии и шифрования данных на лету. Они базируются на технологиях Intel QAT и, в частности, предложат поддержку современного алгоритма сжатия Zstandard. Наконец, у IPU будет выделенный блок для независимого внешнего управления. Работать с устройством можно будет посредством привычных SPDK и DPDK. Один IPU Mount Evans может обслуживать до четырёх процессоров. В целом, новинку можно назвать интересной и более доступной альтернативной AWS Nitro. Также Intel представила платформу Oak Springs Canyon с двумя 100GbE-интерфейсами, которая сочетает процессоры Xeon-D и FPGA семейства Agilex. Каждому чипу которых полагается по 16 Гбайт собственной памяти DDR4. Платформа может использоваться для ускорения Open vSwitch и NVMe-oF с поддержкой RDMA/RocE, имеет аппаратные криптодвижки т.д. Наличие FPGA позволяет выполнять специфичные для конкретного заказчика задачи, но вместе с тем совместимость с x86 существенно упрощает разработку ПО для этой платформы. В дополнение к SPDK и DPDK доступны и инструменты OFS. Наконец, компания показала и референсную плаформу для разработчиков Intel N6000 Acceleration Development Platform (Arrow Creek). Она несколько отличается от других IPU и относится скорее к SmartNIC, посколько сочетает FPGA Agilex, CPLD Max10 и сетевые контроллеры Intel Ethernet 800 (2 × 100GbE). Дополняет их аппаратный Root of Trust, а также PTP-блок. Работать с устройством можно также с помощью DPDK и OFS, да и функциональность во многом совпадает с Oak Springs Canyon. Но это всё же платформа для разработки конечных решений ODM-партнёрами Intel, которые могут с её помощью имплементировать какие-то специфические протоколы или функции с ускорением на FPGA, например, SRv6 или Juniper Contrail. IPU могут стать частью высокоинтегрированной ЦОД-платформы Intel, и на этом поле она будет соревноваться в первую очередь с NVIDIA, которая активно продвигает DPU BluefIeld, а вскоре обзаведётся ещё и собственным процессором. Из ближайших интересных анонсов, вероятно, стоит ждать поддержку Project Monterey, о которой уже заявили NVIDIA и Pensando. |

|