Материалы по тегу: rubin

|

05.07.2024 [09:18], Владимир Мироненко

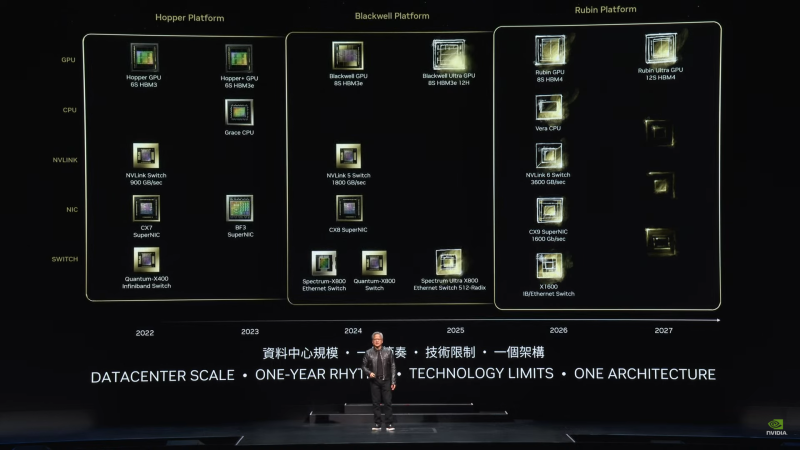

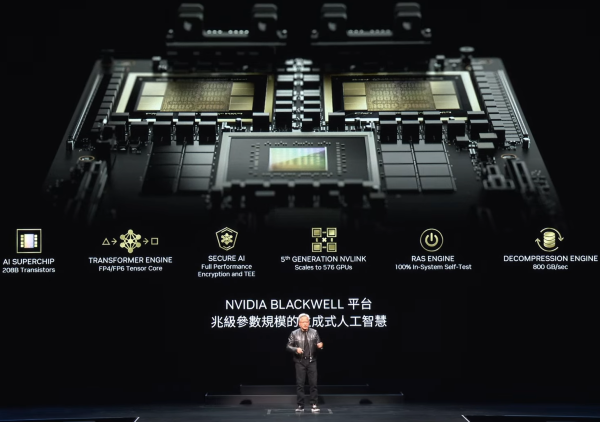

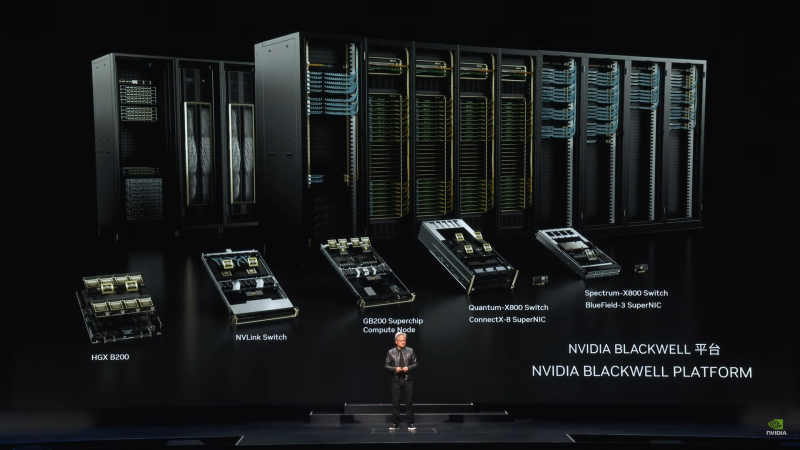

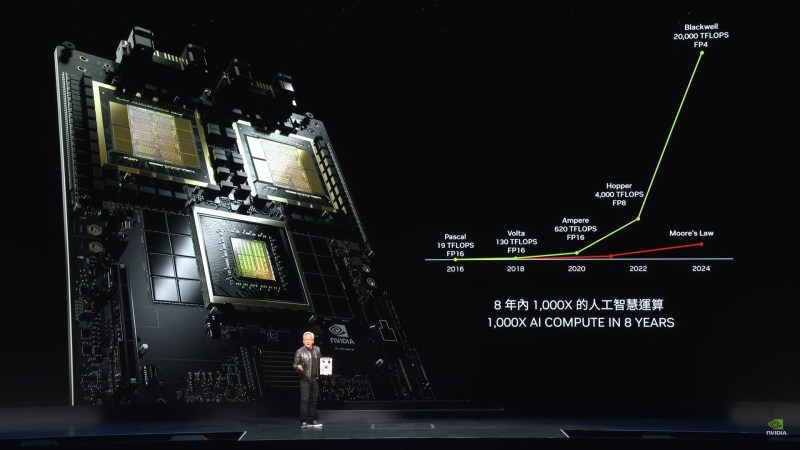

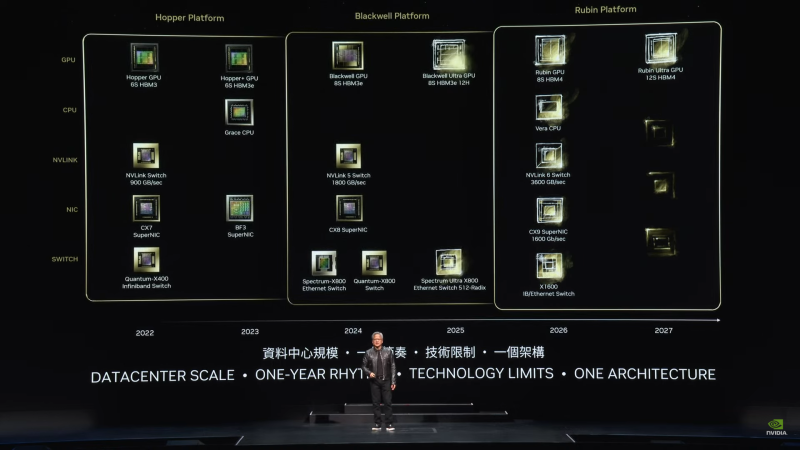

Потрать доллар — получи семь: ИИ-арифметика от NVIDIANVIDIA заявила, что инвестиции в покупку её ускорителей весьма выгодны, передаёт ресурс HPCwire. По словам NVIDIA, компании, строящие огромные ЦОД, получат большую прибыль в течение четырёх-пяти лет их эксплуатации. Заказчики готовы платить миллиарды долларов, чтобы не отстать в ИИ-гонке. «Каждый доллар, вложенный провайдером облачных услуг в ускорители, вернётся пятью долларами через четыре года», — заявил Иэн Бак (Ian Buck), вице-президент HPC-подразделения NVIDIA на конференции BofA Securities 2024 Global Technology Conference. Он отметил, что использование ускорителей для инференса несёт ещё больше выгоды, позволяя получить уже семь долларов за тот же период. Как сообщается, инференс ИИ-моделей Llama, Mistral и Gemma становится всё масштабнее. Для удобства NVIDIA упаковывает открытые ИИ-модели в оптимизированные и готовые к запуску контейнеры NIM. Компания отметила, что её новейшие ускорители Blackwell оптимизированы для инференса. Они, в частности, поддерживают типы данных FP4/FP6, что повышает энергоэффективность оборудования при выполнении рабочих нагрузок ИИ с низкой интенсивностью. Провайдеры облачных услуг планируют строительство ЦОД на пару лет вперёд и хотят иметь представление о том, какими будут ускорители в обозримом будущем. Бак отметил, что провайдерам важно знать, как будут выглядеть ЦОД с серверами на базе чипов Blackwell и чем они будут отличаться от дата-центров на Hopper. Скоро на смену Blackwell придут ускорители Rubin. Их выпуск начнётся в 2026 году, так что гиперскейлерам уже можно готовиться к обновлению дата-центров. Как ожидается, чипы Blackwell, первые партии которых будут поставлены к концу года, будут в дефиците. «С каждым новым технологическим переходом возникает… сочетание проблем спроса и предложения», — отметил Бак. По его словам, операторы ЦОД постепенно отказываются от инфраструктуры на базе CPU, освобождая место под большее количество ускорителей. Ускорители Hopper пока остаются в ЦОД и всё ещё будут основными «рабочими лошадками» для ИИ, но вот решения на базе архитектур Ampere и Volta уже перепродаются. Microsoft и Google сделали ставку на ИИ и сейчас работают над более функциональными большими языковыми моделями, причём Microsoft (и OpenAI) в значительной степени полагается на ускорители NVIDIA, тогда как Google опирается на TPU собственной разработки для использования в своей ИИ-инфраструктуре. Пока что самая крупная модель насчитывает порядка 1,8 трлн параметров, но по словам Бака, это только начало. В дальнейшем появятся модели с триллионами параметров, вокруг которой будут построены более мелкие и более специализированные модели. Так, свежая GPT-модель (вероятно, речь о GPT-4o) включает 16 отдельных нейросетей. NVIDIA уже адаптирует свои ускорители к архитектуре Mixture of Experts (MoE, набор экспертов), где процесс обработки запроса пользователя делится между несколькими специализированными «экспертными» нейросетями. GB200 NVL72, по словам Бака, идеально подходит для MoE благодаря множеству ускорителей связанных быстрым интерконнектом, каждый из которых может обрабатывать часть запроса и быстро делится ответом с другими.

02.06.2024 [16:20], Сергей Карасёв

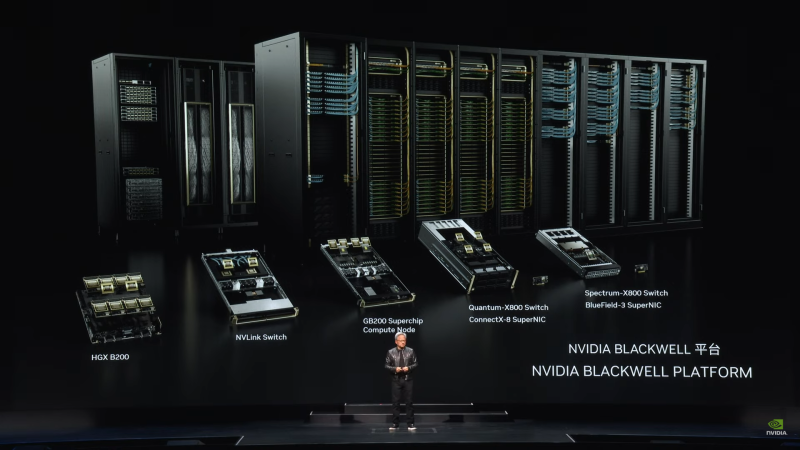

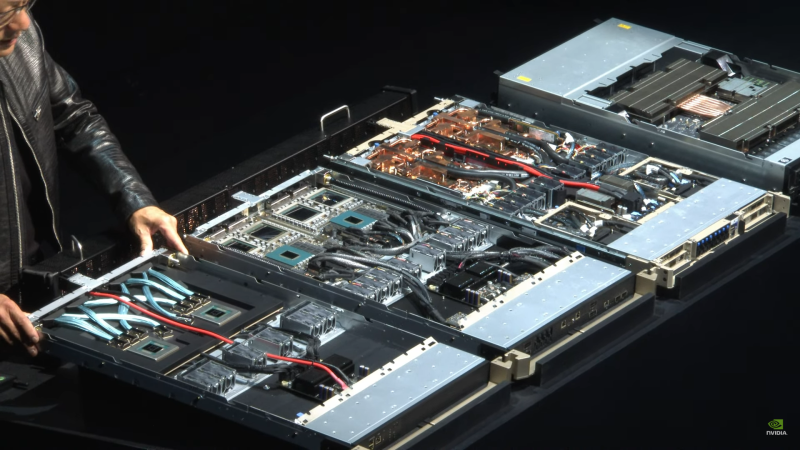

NVIDIA представила ускорители GB200 NVL2, платформы HGX B100/B200 и анонсировала экосистему следуюшего поколения Vera RubinNVIDIA сообщила о широкой отраслевой поддержке своей архитектуры нового поколения Blackwell. Эти ускорители, а также чипы Grace легли в основу многочисленных систем для ИИ-фабрик и дата-центров, которые, как ожидается, будут способствовать «следующей промышленной революции». Генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) объявил о том, что серверы на базе Blackwell выпустят ASRock Rack, ASUS, Gigabyte, Ingrasys, Inventec, Pegatron, QCT, Supermicro, Wistron и Wiwynn. Речь идёт об устройствах разного уровня, рассчитанных на облачные платформы, периферийные вычисления и ЦОД клиентов. «Началась очередная промышленная революция. Компании и целые страны сотрудничают с NVIDIA, чтобы трансформировать традиционные дата-центры общей стоимостью в триллионы долларов в платформы нового типа — фабрики ИИ», — говорит Хуанг. Для решения ИИ-задач и поддержания других ресурсоёмких приложений будут выпущены серверы с CPU на архитектурах х86 и Arm (изделия Grace) с воздушным и жидкостным охлаждением. Заказчикам будут доступны модели с одним и несколькими ускорителями. В частности, сама NVIDIA предлагает DGX-системы Blackwell, а для сторонних производителей доступны готовые платформы HGX B100 и HGX B200. Кроме того, компания представила ускоритель GB200 NVL2, т.е. сборку из двух GB200, объединённых NVLink 5. NVIDIA также сообщила о том, что модульная архитектура NVIDIA MGX отныне поддерживает Blackwell, включая и GB200 NVL2. В целом, NVIDIA MGX предлагает свыше 100 различных конфигураций. На сегодняшний день на базе MGX выпущены или находятся в разработке более 90 серверов от более чем 25 партнёров NVIDIA по сравнению с 14 системами от шести партнёров в 2023 году. В составе MGX, в частности, впервые будут использоваться изделия AMD EPYC Turin и чипы Intel Xeon 6 (ранее — Granite Rapids). Отмечается, что глобальная партнёрская экосистема NVIDIA включает TSMC, а также поставщиков различных компонентов, включая серверные стойки, системы электропитания, решения для охлаждения и пр. В число поставщиков такой продукции входят Amphenol, Asia Vital Components (AVC), Cooler Master, Colder Products Company (CPC), Danfoss, Delta Electronics и Liteon. Серверы нового поколения готовят Dell Technologies, Hewlett Packard Enterprise (HPE) и Lenovo. В скором времени NVIDIA представит улучшенные ускорители Blackwell Ultra, которые получат более современную HBM3e-память. А уже в следующем году компания покажет решения на архитектуре следующего поколения: ускорители Rubin, процессоры Vera, NVLink 6 с удвоенной пропускной способностью (3,6 Тбайт/с), коммутаторы X1600 и DPU SuperNIC CX9 для сетей 1,6 Тбит/с. |

|