Материалы по тегу: instinct

|

01.11.2024 [12:28], Руслан Авдеев

1 ГВт для AMD Instinct: TECfusions сформирует для ИИ-облака TensorWave масштабную инфраструктуру ЦОДСпециализирующаяся на строительстве и управлении ЦОД американская TECfusions заключила соглашение с TensorWave, предусматривающее предоставление последней ИИ-инфраструктуры. По информации Datacenter Dynamics, в рамках договора TensorWave будет арендовать у оператора 1 ГВт ёмкости ЦОД. По словам представителя TECfusions, сотрудничество знаменует собой переломный момент в развитии ИИ-инфраструктуры. Как говорит компания, в ЦОД в Кларксвилле (Clarksville) уже размещён один из крупнейших в мире кластеров ускорителей, а сделка является свидетельством готовности TECfusions к самым ресурсоёмким проектам. Развёртывание 1 ГВт будет происходить поэтапно, но доступ к значимой доле ёмкости должен появиться уже к началу 2025 года. Tecfusion намерена использовать локальные генерирующие мощности, функционирующие в основном на природном газе, для обеспечения стабильных поставок энергии и во избежание скачков цен на неё. Компания уже владеет микросетями на территории ЦОД в Нью-Кенсингтоне (200 МВт, Пенсильвания) и Кларксвилле (220 МВт, Вирджиния).

Источник изображения: Henry Deng/unsplash.com Партнёрство сформировано по итогам SAFE-раунда финансирования TensorWaves, в ходе него привлечено $43 млн. Основанный в 2023 году стартап из Лас-Вегаса предоставляет клиентам доступ к вычислительным ИИ-мощностям на основе ускорителей AMD. На полученные средства TensorWave оснастит ЦОД ускорителями AMD Instinct MI300X, расширит команду и начнёт подготовку к внедрению следующего поколения ускорителей Instinct MI325X. На IV квартал намечен запуск новой инференс-платформы Manifest в IV. Как заявляют в TensorWave, способность TECfusions выводить на рынок масштабные, готовые к ИИ-задачам ёмкости за считанные месяцы значительно ускорит освоение рынка компанией. Партнёрство имеет ключевое значение для сохранения конкурентоспособности в ИИ-секторе. Сейчас TECfusions управляет тремя действующими ЦОД — в Аризоне, Пенсильвании и Вирджинии. В сентябре оператор объявил о завершении строительства третьего зала для ИИ-оборудования в Кларксвилле. Теперь общая ёмкость этого дата-центра достигла 34,5 МВт. До конца года будет оснащён четвёртый зал на 13,5 МВт.

31.10.2024 [11:33], Сергей Карасёв

Cisco представила ИИ-сервер UCS C885A M8 на базе NVIDIA H100/H200 или AMD Instinct MI300XКомпания Cisco анонсировала сервер высокой плотности UCS C885A M8, предназначенный для решения задач в области ИИ, таких как обучение больших языковых моделей (LLM), тонкая настройка моделей, инференс, RAG и пр. Устройство выполнено в форм-факторе 8U. В зависимости от модификации устанавливаются два процессора AMD EPYC 9554 поколения Genoa (64 ядра; 128 потоков; 3,1–3,75 ГГц; 360 Вт) или два чипа EPYC 9575F семейства Turin (64 ядра; 128 потоков; 3,3–5,0 ГГц; 400 Вт). Доступны 24 слота для модулей DDR5-600 суммарным объёмом 2,3 Тбайт. В максимальной конфигурации могут быть задействованы восемь SXM-ускорителей NVIDIA H100, H200 или AMD Instinct MI300X. Каждый ускоритель дополнен сетевым адаптером NVIDIA ConnectX-7 или NVIDIA BlueField-3 SuperNIC. Кроме того, в состав сервера входит DPU BlueField-3. Слоты расширения выполнены по схеме 5 × PCIe 5.0 x16 FHHL плюс 8 × PCIe 5.0 x16 HHHL и 1 × OCP 3.0 PCIe 5.0 x8 (для карты X710-T2L 2x10G RJ45 NIC). Новинка оборудована загрузочным SSD вместимостью 1 Тбайт (M.2 NVMe), а также 16 накопителями U.2 NVMe SSD на 1,92 Тбайт каждый. Установлены два блока питания мощностью 2700 Вт и шесть блоков на 3000 Вт с возможностью горячей замены. Cisco также представила инфраструктурные стеки AI POD, адаптированные для конкретных вариантов использования ИИ в различных отраслях. Они объединяют вычислительные узлы, сетевые компоненты, средства хранения и управления. Стеки, как утверждается, обеспечивают хорошую масштабируемость и высокую эффективность при решении ИИ-задач.

30.10.2024 [11:49], Сергей Карасёв

OpenAI разрабатывает собственные ИИ-чипы совместно с Broadcom и TSMC, а пока задействует AMD Instinct MI300XКомпания OpenAI, по информации Reuters, разрабатывает собственные чипы для обработки ИИ-задач. Партнёром в рамках данного проекта выступает Broadcom, а организовать производство изделий планируется на мощностях TSMC ориентировочно в 2026 году. Слухи о том, что OpenAI обсуждает с Broadcom возможность создания собственного ИИ-ускорителя, появились минувшим летом. Тогда говорилось, что эта инициатива является частью более масштабной программы OpenAI по увеличению вычислительных мощностей компании для разработки ИИ, преодолению дефицита ускорителей и снижению зависимости от NVIDIA. Как теперь стало известно, OpenAI уже несколько месяцев работает с Broadcom над своим первым чипом ИИ, ориентированным на задачи инференса. Соответствующая команда разработчиков насчитывает около 20 человек, включая специалистов, которые ранее принимали участие в проектировании ускорителей TPU в Google, в том числе Томаса Норри (Thomas Norrie) и Ричарда Хо (Richard Ho). Подробности о проекте не раскрываются. Reuters, ссылаясь на собственные источники, также сообщает, что OpenAI в дополнение к ИИ-ускорителям NVIDIA намерена взять на вооружение решения AMD, что позволит диверсифицировать поставки оборудования. Речь идёт о применении изделий Instinct MI300X, ресурсы которых будут использоваться через облачную платформу Microsoft Azure. Это позволит увеличить вычислительные мощности: компания OpenAI только в 2024 году намерена потратить на обучение ИИ-моделей и задачи инференса около $7 млрд. Вместе с тем, как отмечается, OpenAI пока отказалась от амбициозных планов по созданию собственного производства ИИ-чипов. Связано это с большими финансовыми и временными затратами, необходимыми для строительства предприятий.

18.10.2024 [00:10], Алексей Степин

Meta✴ представила свой вариант суперускорителя NVIDIA GB200 NVL72Meta✴ поделилась своими новинками в области аппаратной инфраструктуры и рассказала, каким именно видит будущее открытых ИИ-платформ. В своей презентации Meta✴ рассказала о новой ИИ-платформе, новых дизайнах стоек, включая варианты с повышенной мощностью питания, а также о новинках в области сетевой инфраструктуры.

Источник изображений: Meta✴ В настоящее время компания использует нейросеть Llama 3.1 405B. Контекстное окно у этой LLM достигает 128 тыс. токенов, всего же токенов свыше 15 трлн. Чтобы обучать такие модели, требуются очень серьёзные ресурсы и глубокая оптимизация всего программно-аппаратного стека. В обучении базовой модели Llama 3.1 405B участвовал кластер 16 тыс. ускорителей NVIDIA H100, один из первых такого масштаба. Но уже сейчас для обучения ИИ-моделей Meta✴ использует два кластера, каждый с 24 тыс. ускорителей. Проекты такого масштаба зависят не только от ускорителей. На передний план выходят проблемы питания, охлаждения и, главное, интерконнекта. В течение нескольких следующих лет Meta✴ ожидает скоростей в районе 1 Тбайт/с на каждый ускоритель. Всё это потребует новой, ещё более плотной архитектуры, которая, как считает Meta✴, должна базироваться на открытых аппаратных стандартах. Одной из новинок стала платформа Catalina. Это Orv3-стойка, сердцем которой являются гибридные процессоры NVIDIA GB200. Стойка относится к классу HPR (High Power Rack) и рассчитана на 140 КВт. Сейчас Microsoft и Meta✴ ведут работы над модульной и масштабируемой системой питания Mount Diablo. Свой вариант GB200 NVL72 у Microsoft тоже есть. Также Meta✴ обновила ИИ-серверы Grand Teton, впервые представленные в 2022 году. Это по-прежнему монолитные системы, но теперь они поддерживают не только ускорители NVIDIA, но и AMD Instinct MI300X и будущие MI325X.  Интерконнектом будущих платформ станет сеть DSF (Disaggregated Scheduled Fabric). Благодаря переходу на открытые стандарты компания планирует избежать ограничений, связанных с масштабированием, зависимостью от вендоров аппаратных компонентов и плотностью подсистем питания. В основе DSF лежит стандарт OCP-SAI и ОС Meta✴ FBOSS для коммутаторов. Аппаратная часть базируется на стандартном интерфейсе Ethernet/RoCE. Meta✴ уже разработала и воплотила в металл новые коммутаторы класса 51Т на базе кремния Broadcom и Cisco, а также сетевые адаптеры FBNIC, созданные при поддержке Marvell. FBNIC может иметь до четырёх 100GbE-портов. Используется интерфейс PCIe 5.0, причём могущий работать как четыре отдельных слайса. Новинка соответствует открытому стандарту OCP NIC 3.0 v1.2.0.

13.10.2024 [17:09], Сергей Карасёв

MiTAC анонсировала серверы с процессорами AMD EPYC 9005 TurinКорпорация MiTAC Computing Technology представила серверы и материнские платы, рассчитанные на работу с новейшими процессорами EPYC 9005 (Turin). Дебютировали системы разного уровня, в том числе решения для ИИ-нагрузок и НРС-задач. В частности, вышел двухсоктеный сервер MiTAC Tyan TN85-B8261 типоразмера 2U, разработанный специально для HPC и ML. Он поддерживает до четырёх двухслотовых GPU-ускорителей, 24 модуля DDR5 RDIMM и восемь SFF-накопителей NVMe U.2 с возможностью горячей замены. Кроме того, анонсирован односокетный GPU-сервер MiTAC Tyan FT65T-B8050 формата 4U. Есть восемь слотов для модулей DDR5, восемь посадочных мест для SATA-накопителей LFF и два отсека для SFF-устройств NVMe U.2 с возможностью горячей замены. Данная модель допускает установку двух GPU-ускорителей. Ещё одна новинка — MiTAC G8825Z5: это двухсокетный сервер 8U, поддерживающий ИИ-ускорители AMD Instinct MI325X. Машина может нести на борту до 4 Тбайт памяти DDR5-6000. Доступны восемь посадочных мест для SFF-накопителей U.2 с возможностью горячей замены. Система рассчитана на ресурсоёмкие задачи ИИ и НРС. Представлены 2U-серверы MiTAC Tyan TS70-B8056 и TS70A-B8056 для облачных хранилищ. Первый получил 12 фронтальных отсеков для LFF-накопителей и два тыльных отсека для SFF-устройств NVMe U.2. Вторая модель располагает 26 отсеками для накопителей SFF NVMe U.2 с возможностью горячей замены. Наконец, анонсированы компактный односокетный облачный сервер MiTAC Tyan GC68C-B8056 формата 1U с 24 слотами DDR5 и 12 отсеками для устройств SFF NVMe U.2, а также материнские платы MiTAC Tyan S8050 и MiTAC Tyan S8056.

13.10.2024 [16:54], Сергей Карасёв

Дебютировали серверы ASRock Rack с чипами AMD EPYC Turin и ускорителями Instinct MI325XКомпания ASRock Rack анонсировала широкий спектр решений, поддерживающих процессоры AMD EPYC 9005 (Turin). Дебютировали, в частности, серверы общего назначения, высокопроизводительные GPU-системы, серверы хранения, OCP-платформы, материнские платы и пр. Одной из ключевых новинок стал мощный сервер 6U8M-TURIN2 формата 6U. Эта модель поддерживает установку двух чипов в исполнении SP5, а также 24 модулей DDR5-6000. Во фронтальной части расположены 12 отсеков для SFF-накопителей NVMe (PCIe 5.0 x4). Кроме того, есть два коннектора М.2 (PCIe 3.0 x4 или SATA-3) для SSD формата 22110/2280. Доступны восемь слотов HHHL PCIe5.0 x16 и три слота FHHL PCIe5.0 x16. Система может комплектоваться ИИ-ускорителями AMD Instinct MI325X. В оснащение входят два сетевых порта 1GbE на базе Intel i350, выделенный сетевой порт на основе Realtek RTL8211F, контроллер ASPEED AST2600, четыре порта USB 3.2 Gen1 Type-A (USB 3.0), аналоговый разъём D-Sub. Установлены восемь блоков питания мощностью 3000 Вт с сертификатом 80 PLUS Titanium. За охлаждение отвечают 21 вентилятор диаметром 80 мм. В списке новинок значатся 4U-серверы 4U10G-TURIN2 и 4U8G-TURIN2 с поддержкой памяти DDR5-6000, двухсокетная материнская плата TURIN2D48G-2L+ с 48 слотами DIMM, а также платы TURIN2D24G-2L+ и TURIN2D24TM3-2L+ с 24 слотами для модулей ОЗУ. В число ранее доступных систем, которые получили поддержку EPYC 9005 после обновления BIOS, вошли: 1U4L4E-GENOA/2T, 1U4L-GENOA/2T, 1U8S4E-GENOA/2T, 1U12L4E-GENOA/2Q, 2U12L8E-GENOA2, 1U12E-GENOA/EVAC, 1U12E-GENOA/2L2T, 1U24E1S-GENOA/2L2T, 1U12E-GENOA2/EVAC, 1U12E-GENOA2, 2U24E-GENOA2, 4U36L8E-GENOA/2T, 4U60L8E-GENOA/2T, 2U4G-GENOA/M3, 4U4G-GENOAX, 4U10G-GENOA2 и 4U8G-GENOA2.

12.10.2024 [18:25], Сергей Карасёв

Supermicro представила широкий ассортимент серверов H14 на платформе AMD EPYC TurinКомпания Supermicro анонсировала серверы семейства H14 с новейшими процессорами серии AMD EPYC 9005 (Turin) и ускорителями Instinct MI325X. В серию вошло большое количество систем для различных задач, включая обучение языковых моделей, инференс, НРС-нагрузки и пр. В частности, дебютировали новые машины Hyper в форм-факторе 1U и 2U. Они допускают установку двух процессоров EPYC 9005 (до 192 ядер) с показателем TDP до 500 Вт и до 9 Тбайт памяти в 24 слотах DIMM. Младшая из этих моделей рассчитана на 12 накопителей SFF с интерфейсом NVMe/SATA, старшая — на 24. Вышли также новые серверы CloudDC: эта универсальная модель типоразмера 1U оптимизирована для использования в облачных дата-центрах. Она оснащена одним чипом EPYC 9005. Есть 12 отсеков для SFF-устройств NVMe/SATA. Система разработана в соответствии со стандартом DC-MHS (Data Center Modular Hardware System). Дебютировали четырёхузловые решения GrandTwin и FlexTwin формата 2U высокой плотности. В первом случае применяется один чип EPYC 9005 на узел, во втором — два. GrandTwin подходит для таких задач, как объектные хранилища, виртуализация и пр. Во FlexTwin применено жидкостное охлаждение: эти серверы предназначены для требовательных рабочих нагрузок. В семействе Н14 также представлены мощные серверы 5U GPU System, 4U GPU System (СЖО) и 8U GPU System для ИИ-задач. Первая из перечисленных систем может быть укомплектована десятью PCIe-ускорителями двойной ширины, вторая — восемью. Для модели формата 8U предусмотрено использование карт AMD Instinct MI325X.

12.10.2024 [18:06], Сергей Карасёв

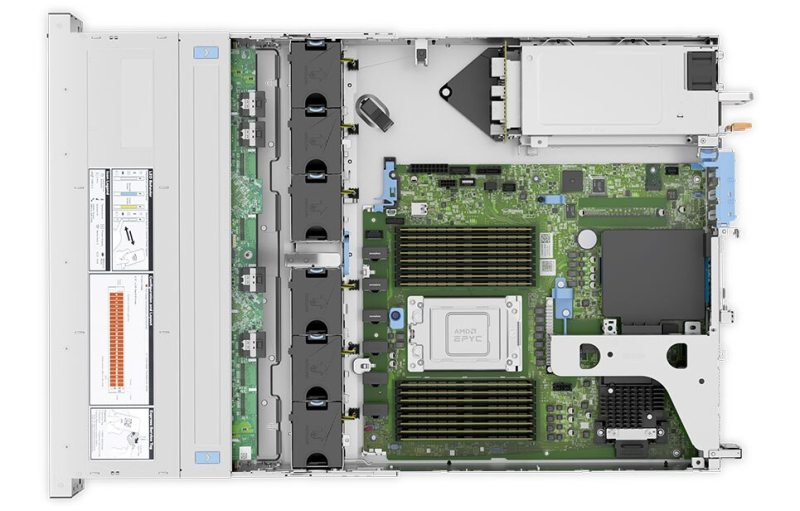

Lenovo анонсировала серверы ThinkSystem с чипами AMD EPYC Turin и ускорителями Instinct MI325XКомпания Lenovo объявила о выпуске серверов ThinkSystem на новейших процессорах EPYC 9005 Turin, которые AMD официально представила на этой неделе. Некоторые системы комплектуются мощными ИИ-ускорителями Instinct MI325X. Чипы EPYC 9005 Turin доступны для таких серверов, как ThinkSystem SR635 V3 и ThinkSystem SR645 V3 формата 1U, а также ThinkSystem SR655 V3 и ThinkSystem SR665 V3 типоразмера 2U. Все они могут работать с платформами Windows Server, SUSE Linux Enterprise Server, Red Hat Enterprise Linux и VMware vSphere. Односокетная модель ThinkSystem SR635 V3 оснащена 12 слотами для модулей памяти TruDDR5-6400 суммарным объёмом до 1,5 Тбайт. Возможна установка 12 накопителей SFF с интерфейсом SAS/SATA/NVMe или 16 устройств EDSFF. Кроме того, предусмотрены два коннектора M.2 и два отсека для системных SFF-накопителей в тыльной части. Есть четыре посадочных места для однослотовых PCIe-ускорителей. Вариант ThinkSystem SR645 V3, в свою очередь, поддерживает установку двух процессоров и 24 модулей ОЗУ суммарным объёмом до 6 Тбайт. Возможны следующие конфигурации подсистемы хранения данных: 4 × LFF, 12 × SFF или 16 × EDSFF. Упомянуты три слота PCIe 4.0, два разъёма PCIe 5.0 и слот OCP 3.0.

Источник изображения: Lenovo Серверы ThinkSystem SR655 V3 и ThinkSystem SR665 V3 поддерживают соответственно один и два процессора EPYC 9005 и 12 и 24 модуля TruDDR5-6400. У первого устройства есть десять слотов PCIe и разъём OCP 3.0, у второго — 12 слотов PCIe (9 стандарта PCIe 5.0) и разъём OCP 3.0. Обе модели могут нести на борту до 20 накопителей LFF или до 40 накопителей SFF.

12.10.2024 [17:54], Сергей Карасёв

Giga Computing выпустила серверы с чипами AMD EPYC Turin и ускорителями Instinct MI325XКомпания Giga Computing, серверное подразделение Gigabyte, объявила о поддержке новейших процессоров AMD EPYC 9005 Turin, дебютировавших на этой неделе. Эти чипы могут использоваться с более чем 60 моделями серверов и материнских плат. Компания также сообщила о намерении использовать в некоторых своих ИИ-системах ускорители AMD Instinct MI325X. Изделия Instinct входят в состав таких машин как G593-ZX1, G383-R80, G593-SX1 и др. Кроме того, представлены полностью новые продукты, в частности, сервер XV23-ZX0. Эта система выполнена в формате 2U с габаритами 438 × 87 × 900 мм. Возможна установка двух чипов в исполнении Socket SP5 с показателем cTDP до 500 Вт. Есть 24 слота для модулей DDR5-6000. Во фронтальной части расположены отсеки для шести SFF-накопителей NVMe/SATA/SAS-4. Кроме того, предусмотрены два коннектора M.2 2280/22110 PCIe 3.0 x2 и один разъём M.2 2280/22110 PCIe 3.0 x1 для SSD. В общей сложности доступны семь слотов PCIe 5.0 x16 для карт FHFL, в том числе четыре посадочных места для двухслотовых PCIe-ускорителей. В оснащение входят два сетевых порта 10GbE на базе Intel X550-AT2, выделенный сетевой порт управления, контроллер Aspeed AST2600. Спереди и сзади находятся по два порта USB 3.2 Gen1 Type-A. Кроме того, упомянут интерфейс Mini-DP.

Источник изображения: Giga Computing Питание обеспечивают четыре блока мощностью 2000 Вт каждый с сертификатом 80 PLUS Titanium. Применены четыре системных вентилятора охлаждения диаметром 80 мм (15 000 об/мин). Диапазон рабочих температур простирается от +10 до +35 °C.

12.10.2024 [17:51], Сергей Карасёв

Dell представила ИИ-серверы PowerEdge на базе AMD EPYC TurinКомпания Dell Technologies анонсировала обновлённые серверы PowerEdge, ориентированные на ресурсоёмкие рабочие нагрузки ИИ. В основу положены процессоры AMD серии EPYC 9005 (Turin), насчитывающие до 192 вычислительных ядер. В частности, дебютировала модель PowerEdge XE7745 для тюнинга ИИ-моделей, инференса, НРС-задач и пр. Сервер построен на шасси 4U с воздушным охлаждением. Возможна установка до восьми PCIe-ускорителей двойной ширины или до 16 ускорителей одинарной ширины. Кроме того, доступны восемь дополнительных слотов PCIe 5.0 для сетевых адаптеров. Представлены также серверы PowerEdge R6725 и PowerEdge R7725 стандарта Data Center Modular Hardware Systems (DC-MHS) с расширенными возможностями по организации воздушного охлаждения. Они могут нести на борту два чипа EPYC 9005 с показателем TDP до 500 Вт. Устройства, как утверждается, обеспечивают рекордную производительность при работе со средствами виртуализации, базами данных и ИИ-приложениями. Помимо этого, анонсированы односокетные модели PowerEdge R6715 и PowerEdge R7715, которые будут доступны в различных конфигурациях в форматах 1U и 2U. Говорится о поддержке 24 модулей DIMM (2DPC). Отмечается, что версия R6715 демонстрирует мировые рекорды производительности для задач ИИ и виртуализации. Более подробные технические характеристики всех новых серверов будут раскрыты позднее. Для клиентов, развёртывающих ИИ-системы в больших масштабах, Dell предложит поддержку новейших ускорителей AMD Instinct MI325X в серверах PowerEdge XE. Улучшенный контроллер iDRAC (Integrated Dell Remote Access Controller) благодаря более быстрому процессору, увеличенному объёму памяти и выделенному сопроцессору безопасности упрощает управление серверами и повышает уровень защиты. Решения PowerEdge R6715, R7715, R6725 и R7725 станут доступны в ноябре, тогда как PowerEdge XE7745 поступит в продажу в январе 2025 года. |

|