Материалы по тегу: amd

|

04.02.2025 [13:52], Сергей Карасёв

Уязвимость в процессорах AMD позволяет загрузить модифицированный микрокодСпециалисты Google Security Team сообщили об обнаружении опасной уязвимости в проверке подписи микрокода для процессоров AMD на архитектуре от Zen1 до Zen4. Уязвимость даёт возможность загрузить модифицированный микрокод, позволяющий скомпрометировать технологию виртуализации с шифрованием SEV (Secure Encrypted Virtualization) и SEV-SNP (Secure Nested Paging), а также вмешаться в работу Dynamic Root of Trust for Measurement (DRTM). Успешная эксплуатация «дыры» может привести к потере защиты конфиденциальности. Проблема заключается в том, что процессоры используют небезопасную хеш-функцию при проверке подписи обновлений микрокода. Брешь позволяет злоумышленнику с привилегиями локального администратора загрузить вредоносный микрокод CPU. Исследователи подготовили пример атаки на AMD EPYC 7B13 (Milan) и Ryzen 9 7940HS (Phoenix), в результате которой функция RDRAND вместо возврата случайного числа всегда возвращает 4. AMD подготовила патчи для защиты функций SEV в EPYC 7001 (Naples), EPYC 7002 (Rome), EPYC 7003 (Milan и Milan-X), а также EPYC 9004 (Genoa, Genoa-X и Bergamo/Siena) и Embedded-вариантов EPYC 7002/7003/9004. Для устранения проблемы требуется обновление микрокода чипов. Уязвимость получила идентификатор CVE-2024-56161. Они признана достаточно опасной — 7.2 (High) по шкале CVSS. Отмечается, что Google впервые уведомила AMD об уязвимости 25 сентября 2024 года. При этом в связи с широкой распространённостью процессоров AMD и разветвлённой сетью их поставок Google сделала единовременное исключение из стандартной политики раскрытия информации об уязвимостях и отложила публичное уведомление до 3 февраля 2025-го. Кроме того, Google не стала раскрывать полные детали о «дыре», чтобы предотвратить возможные атаки. Все подробности и инструменты будут опубликованы 5 марта 2024 года.

03.02.2025 [15:06], Сергей Карасёв

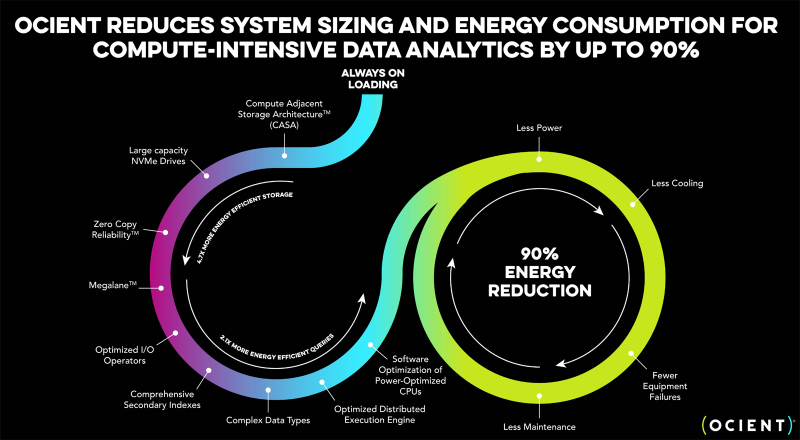

Разработчик гипермасштабируемых аналитических хранилищ Ocient выбрал чипы AMD EPYC GenoaКомпания Ocient, специализирующаяся на разработке гипермасштабируемых аналитических хранилищ данных, объявила о заключении соглашения о сотрудничестве с AMD с целью повышения производительности, снижения затрат и максимизации эффективности ресурсоёмких вычислений и рабочих нагрузок ИИ. Ocient была основана в 2016 году. Компания предлагает платформу на основе реляционной базы данных с массовым параллелизмом, которая способна анализировать огромные объёмы информации (триллионы строк) за секунды или минуты. Хранилище Ocient Hyperscale Data Warehouse (OHDW) использует архитектуру Compute Adjacent Storage Architecture (CASA) для устранения узких мест в сетевой инфраструктуре и обеспечения максимально быстрого доступа к данным. Функция Zero Copy Reliability отвечает за высокую надёжность хранения информации без репликации с помощью кодирования с контролем чётности. Генеральный директор Ocient Крис Гладвин (Chris Gladwin) отмечает, что задачи ИИ и аналитики больших данных создают огромную вычислительную нагрузку на ЦОД по всему миру. Это означает, что повышение эффективности оборудования и программного обеспечения имеет решающее значение для снижения расходов, уменьшения энергопотребления и улучшения производительности. В этой связи Ocient сделала выбор в пользу процессоров AMD EPYC 9654 поколения Genoa с 96 вычислительными ядрами, которые придут на смену 28-ядерным чипам Intel Xeon Gold 6348 семейства Ice Lake-SP. Говорится, что благодаря более высокой плотности ядер изделия AMD обеспечат трёхкратный рост производительности для ресурсоёмких вычислительных задач. При этом снизятся эксплуатационные расходы, что обусловлено повышением быстродействия и энергоэффективности. Плюс к этому достигается гибкость масштабирования.

19.01.2025 [23:24], Сергей Карасёв

Synology представила системы резервного копирования ActiveProtectКомпания Synology анонсировала устройства для бесшовного резервного копирования и быстрого восстановления данных семейства ActiveProtect. Решение объединяет специализированное ПО, серверы и хранилища резервных копий в единую унифицированную платформу. Утверждается, что ActiveProtect обеспечивает надёжную защиту всех корпоративных рабочих нагрузок. Это могут быть приложения SaaS, виртуальные машины, физические серверы, компьютеры с Windows и macOS, файловые серверы и базы данных. Благодаря встроенному гипервизору ActiveProtect пользователи могут в любое время тестировать резервные копии, а интуитивно понятный интерфейс упрощает управление. ActiveProtect предполагает применение стратегии 3-2-1-1-0, где:

Платформа ActiveProtect, как утверждается, позволяет выполнять резервное копирование с максимальной скоростью, устранять дублирование данных, увеличивать ёмкость хранилища и мгновенно восстанавливать информацию в случае необходимости. Консоль ActiveProtect Manager (APM) даёт возможность просматривать до 150 тыс. рабочих нагрузок, а также контролировать до 2500 систем. Возможно формирование среды с физической изоляцией (air-gap). В семейство устройств резервного копирования ActiveProtect вошли модели в настольном форм-факторе DP320 и DP340 на процессоре AMD Ryzen R1600. Первая оснащена 8 Гбайт RAM и двумя отсеками для LFF-накопителей (установлены два HDD по 8 Тбайт каждый). Возможна защита до 20 систем или 50 пользователей SaaS. Вторая модификация располагает 16 Гбайт ОЗУ и четырьмя отсеками для LFF-накопителей (установлены четыре HDD по 8 Тбайт каждый). Эта версия укомплектована двумя кеширующими SSD вместимостью по 400 Гбайт. Возможна защита до 60 систем или 150 пользователей SaaS. Младшая версия получила два сетевых порта 1GbE, старшая — по одному порту 1GbE и 10GbE. Кроме того, представлено стоечное устройство DP7400 типоразмера 2U с процессором AMD EPYC 7272 (12 ядер) и 64 Гбайт RAM (расширяется до 512 Гбайт). В оснащение входят десять LFF HDD ёмкостью 20 Тбайт каждый и два SFF SSD на 3,84 Тбайт. Есть один порт 1GbE и два порта 10GbE. Это решение может работать 2500 серверами или 150 тыс. рабочими нагрузками в кластере. Сетевые источники также сообщают, что к выпуску готовятся стоечные системы DP5200 и DP7300 в форм-факторе 1U и 2U соответственно, но их описание на момент подготовки материала отсутствовало на сайте производителя.

19.01.2025 [22:43], Сергей Карасёв

Германия запустила «переходный» 48-Пфлопс суперкомпьютер Hunter на базе AMD Instinct MI300AЦентр высокопроизводительных вычислений HLRS при Штутгартском университете в Германии объявил о вводе в эксплуатацию НРС-системы Hunter. Этот суперкомпьютер планируется использовать для решения широко спектра задач в области инженерии, моделирования погоды и климата, биомедицинских исследований, материаловедения и пр. Кроме того, комплекс будет применяться для крупномасштабного моделирования, ИИ-приложений и анализа данных. О создании Hunter сообщалось в конце 2023 года: соглашение на строительство системы стоимостью примерно €15 млн было заключено с HPE. Проект финансируется Федеральным министерством образования и исследований Германии и Министерством науки, исследований и искусств Баден-Вюртемберга. Hunter базируется на той же архитектуре, что El Capitan — самый мощный в мире суперкомпьютер. Задействована платформа Cray EX4000, а каждый из узлов оснащён четырьмя адаптерами HPE Slingshot. Суперкомпьютер использует комбинацию из APU Instinct MI300A и процессоров EPYC Genoa. Как отмечает The Register, в общей сложности система объединяет 188 узлов с жидкостным охлаждением и насчитывает суммарно 752 APU и 512 чипов Epyc с 32 ядрами. Применена СХД HPE Cray Supercomputing Storage Systems E2000, специально разработанная для суперкомпьютеров HPE Cray. HLRS оценивает пиковую теоретическую FP64-производительность Hunter в 48,1 Пфлопс на операциях двойной точности, что практически вдвое выше, чем у предшественника Hawk. В режимах BF16 и FP8 быстродействие, как ожидается, будет варьироваться от 736 Пфлопс до 1,47 Эфлопс. При этом Hunter потребляет на 80% меньше энергии, нежели Hawk. Отмечается, что Hunter задуман как переходная система, которая подготовит почву для суперкомпьютера HLRS следующего поколения под названием Herder. Ввести этот комплекс в эксплуатацию планируется в 2027 году. Предполагается, что он обеспечит производительность «в несколько сотен петафлопс».

18.01.2025 [22:48], Сергей Карасёв

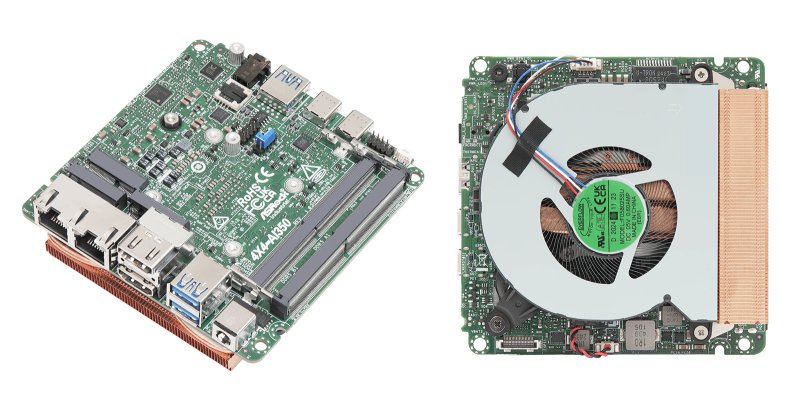

ASRock представила индустриальные мини-ПК и материнские платы на базе Intel Arrow Lake-H и AMD Ryzen 300 AIКомпания ASRock Industrial, по сообщению ресурса CNX-Software, представила индустриальные компьютеры небольшого форм-фактора NUC(S) Ultra 200 Box и материнские платы NUC Ultra 200 на новейших процессорах Intel Core Ultra 200H (Arrow Lake-H). Кроме того, дебютировали аналогичные устройства 4X4 Box AI300 и платы 4X4 AI300 на чипах AMD Ryzen AI 300. Модели NUC Ultra 200 Box, NUCS Ultra 200 Box и платы NUC Ultra 200 в зависимости от модификации комплектуются процессором Core Ultra 7 255H (6P+8E) с частотой до 5,1 ГГц или Core Ultra 5 225H (4P+8E) с частотой до 4,9 ГГц. В первом случае используется узел Intel Arc 140T GPU (74 TOPS), во втором — Intel Arc 130T GPU (63 TOPS). Оба чипа оснащены блоком Intel AI Boost с производительностью 13 TOPS. Новинки поддерживают до 96 Гбайт оперативной памяти DDR5-6400 в виде двух модулей SO-DIMM. Есть по одному разъёму M.2 Key M 2242 (PCIe 4.0 x4) и M.2 Key M 2242/2280 (PCIe 4.0 x4) для NVMe SSD, а также M.2 Key E 2230 (PCIe x1, USB 2.0, CNVi) для контроллера Wi-Fi/Bluetooth. Модели с обозначением NUC и материнские платы также снабжены портом SATA-3. В оснащение входят звуковой кодек Realtek ALC256 и сетевой адаптер 2.5GbE на базе Intel I226LM. Платы и модели NUC оснащены дополнительным портом 2.5GbE на основе Intel I226V. Кроме того, мини-компьютеры несут на борту комбинированный адаптер Wi-Fi 6E (802.11ax) + Bluetooth 5.3. Все изделия располагают двумя выходами HDMI 2.1 TMDS (4096 × 2160 точек @ 60 Гц) и двумя портами DisplayPort 2.1/1.4a, интерфейсом DP++/USB Type-C (4096 × 2160 @ 60 Гц), аудиогнездом на 3,5 мм, портами USB 3.2 Gen2 Type-A (три у NUCS и четыре у NUC), интерфейсом USB4/Thunderbolt 4, портом USB 3.2 Gen2 x2 Type-C. На плате есть разъёмы для двух портов USB 2.0 и последовательного порта RS232/RS422/RS485. Габариты NUC составляют 117,5 × 110,0 × 49 мм, NUCS — 117,5 × 110,0 × 38 мм, плат — 104 × 102 мм. Диапазон рабочих температур у мини-компьютеров простирается от 0 до +40 °C, у плат — от -20 до +70 °C. В свою очередь, компьютеры 4X4 Box AI300 и платы 4X4 AI300 могут комплектоваться процессором AMD Ryzen AI 7 350 (8 ядер; до 5,0 ГГц; AMD Radeon 860M) или AMD Ryzen AI 5 340 (6 ядер; до 4,8 ГГц; AMD Radeon 840M). В обоих случаях задействован нейропроцессор Ryzen AI на архитектуре XDNA 2 с производительностью до 50 TOPS. Объём памяти DDR5-5600 может достигать 96 Гбайт (два модуля SO-DIMM). Изделия наделены коннекторами M.2 Key M 2242 (PCIe 4.0 x4) и M.2 Key M 2242/2280 (PCIe 4.0 x4) для NVMe SSD, а также слотом M.2 Key E 2230 (PCIe x1, USB 2.0) для адаптера Wi-Fi/Bluetooth (мини-компьютеры несут на борту модуль Wi-Fi 6E). В оснащение входят сетевые адаптеры 2.5GbE (Realtek RTL8125BG) и 1GbE (Realtek RTL8111H), звуковой кодек Realtek ALC256. Набор разъёмов включает по два интерфейса HDMI 2.1 (7680 × 4320 @ 60 Гц) и DisplayPort 1.4a / USB Type-C (4096 × 2160 @ 60 Гц), аудиогнездо на 3,5 мм, три порта USB 3.2 Gen2 Type-A, два порта USB4/Thunderbolt 4, два порта USB 2.0 (через коннекторы на плате). Размеры компьютеров составляют 117,5 × 110,0 × 49 мм, плат — 104 × 102 мм. Диапазон рабочих температур — от 0 до +40 °C и от 0 до +70 °C соответственно.

17.01.2025 [15:02], Владимир Мироненко

Аналитики снизили рейтинг акций AMD из-за более низких ожиданий по продажам ускорителейАкции Advanced Micro Devices (AMD) могут потерять своё конкурентное преимущество, сообщил аналитик Wolfe Research Крис Касо (Chris Caso), понизив рейтинг акций производителя чипов с Buy (покупать) до Peer Perform (нейтральный), сообщает ресурс Barron's. Аналитик отметил, что после вчерашнего отчёта TSMC о прибыли выросли акции всех компаний по производству оборудования для изготовления пластин — Lam Research, KLA Corporation и Applied Materials. А у AMD, для которой TSMC производит чипы, такого же роста не наблюдалось. Наоборот, её акции упали в четверг на 1,3 % до $118,44. Понизив рейтинг акций AMD, Крис Касо также снял свою целевую цену в $210 за акцию, пояснив свой шаг более низкими, чем прогнозировалось, ожиданиями относительно доходов компании от производства ускорителей для ЦОД. Ускорители являются одним из ключевых продуктов AMD, и Касо утверждает, что бизнес компании по этому направлению «работает ниже ожиданий». Аналитик выразил мнение, что ситуация улучшится после выхода во II половине 2025 года ускорителей AMD Instinct MI350.

Источник изображения: AMD Ранее в этом месяце рейтинг AMD снизили Goldman Sachs и HSBC. Аналитики Goldman понизили свой рейтинг с «Покупать» (Buy) до «Нейтральный» (Peer Perform), сославшись на скромный рост продаж ускорителей для ЦОД на фоне жесткой конкуренции, в то время как команда HSBC понизила рейтинг AMD с «Покупать» (Buy) до «Сокращать позицию» (Reduce) из-за опасений, что акции могут упасть ещё ниже после трёхмесячного спада. Wolfe Research снизила прогнозы выручки и прибыли AMD за I квартал до $6,6 млрд и $0,80 на акцию соответственно, по сравнению с более ранними прогнозами выручки в $7,04 млрд и прибыли в $0,93 на акцию. Скорректированные цифры оказались ниже ожиданий Уолл-стрит в $7,04 млрд по выручке и $0,95 по прибыли на акцию. Компания тоже снизила свой годовой прогноз по выручке и прибыли до $29,9 млрд и $4,19 на акцию соответственно с предыдущих $33,6 млрд и $5,33 на акцию при консенсус-прогнозе аналитиков выручки в размере $32,3 млрд и прибыли в $5,02 на акцию.

14.01.2025 [23:08], Сергей Карасёв

Minisforum N5 Pro: настольный NAS с AMD Ryzen AI 9 HX PRO 370 и портом OCuLinkКомпания Minisforum, по сообщению ресурса NAS Compares, представила любопытную новинку — NAS N5 Pro в «настольном» форм-факторе с высокопроизводительной аппаратной частью. Устройство несёт на борту процессор AMD Ryzen AI 9 HX PRO 370 (Strix Point), который объединяет 12 ядер (24 потока) с базовой тактовой частотой 2 ГГц и возможностью повышения до 5,1 ГГц. В состав чипа входят графический ускоритель AMD Radeon 890M и движок AI Engine. Сетевое хранилище Minisforum N5 Pro оснащено двумя слотами SODIMM с поддержкой до 96 Гбайт DDR5-5600. Доступны пять отсеков для накопителей LFF/SFF с интерфейсом SATA-3 вместимостью до 22 Тбайт каждый. Кроме того, присутствуют три слота для NVMe SSD: по одному M.2 2230/2280 PCIe 4.0 x1, U.2/M.2 2280/22110 PCIe 4.0 x1 и U.2/M.2 2280/22110 PCIe 4.0 x2. В первый из этих разъёмов может быть установлен накопитель ёмкостью до 4 Тбайт, в два других — до 15 Тбайт. Таким образом, в максимальной конфигурации NAS предлагает 144 Тбайт пространства.

Источник изображения: Minisforum Новинка располагает слотом расширения PCIe x16 (PCIe 4.0 x4) и портом OCuLink 4i x1 (PCIe 4.0 x4). Присутствуют по одному сетевому порту 10GbE и 5GbE с разъёмами RJ45, два порта USB4 (40Gbps; DisplayPort Alt Mode), три разъёма USB 3.2 Gen2 Type-A (10Gbps), порт USB 2.0 Type-A, интерфейс HDMI 2.0, а также аудиогнездо 3,5 мм. Питание (19 В / 12,63 A) подаётся через DC-разъём. Отмечается, что материнская плата размещена на съёмном модуле, что упрощает обслуживание или обновление установленных компонентов. Во фронтальной части NAS располагается полупрозрачная декоративная панель с магнитным креплением.

11.01.2025 [02:00], Алексей Степин

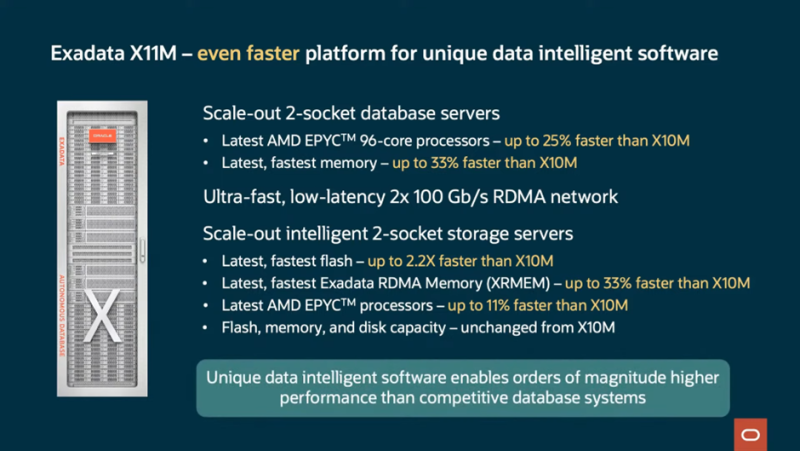

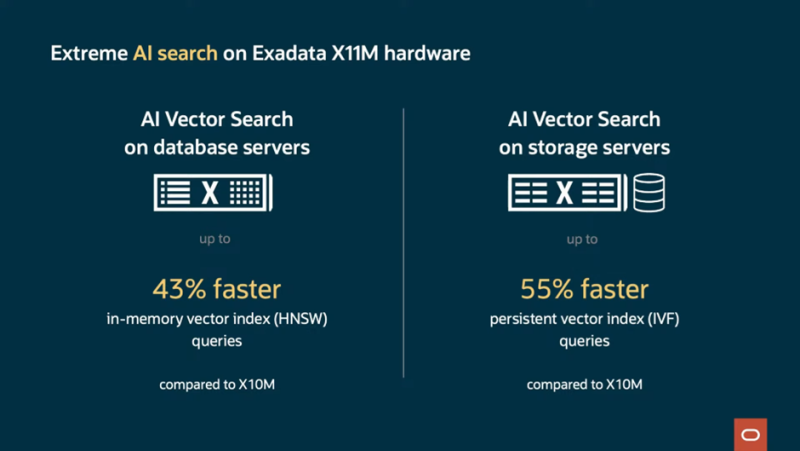

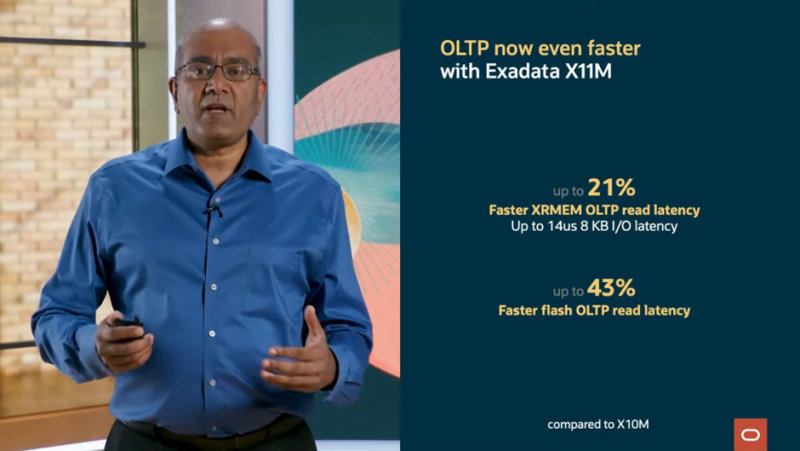

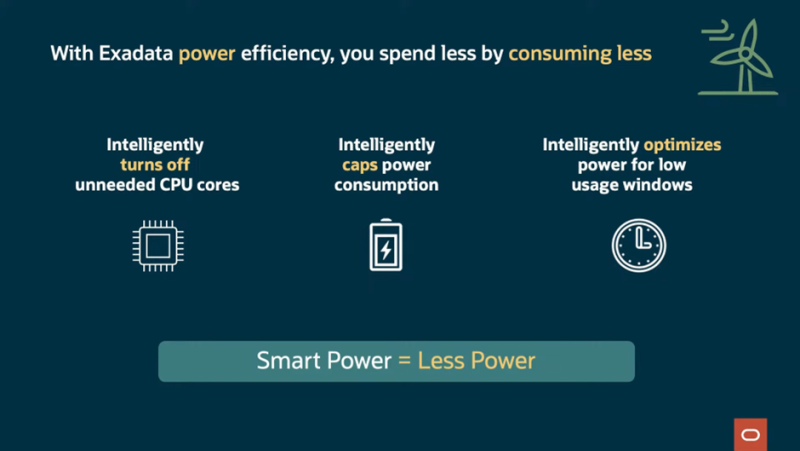

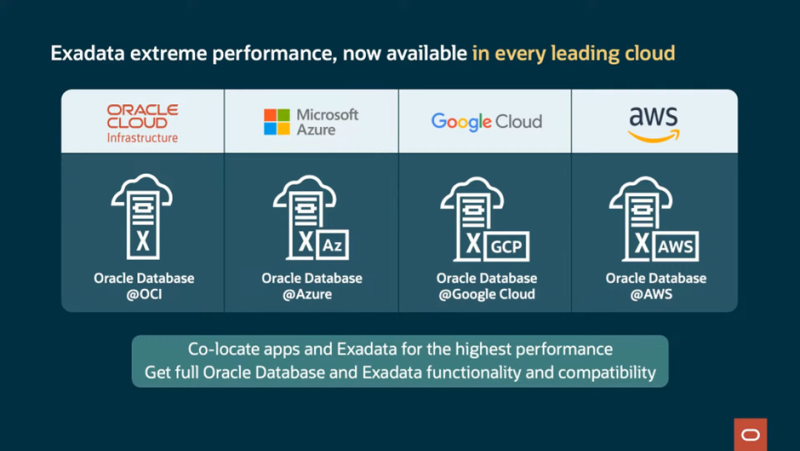

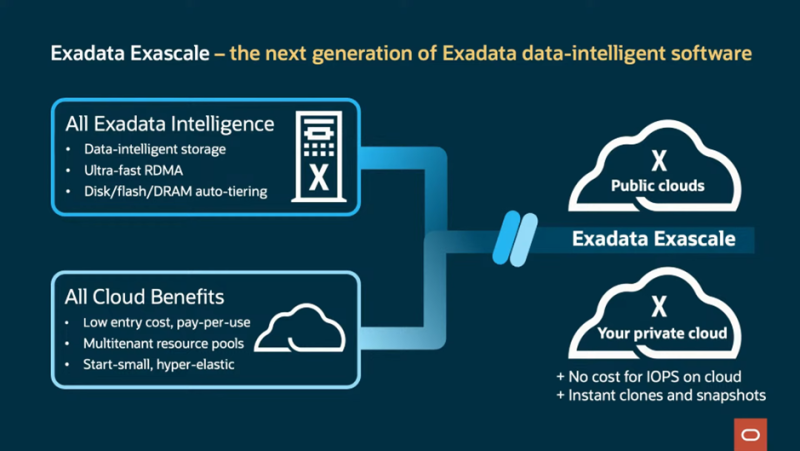

До 2280 ядер и 42 Тбайт RAM на стойку: Oracle представила СУБД-платформу Exadata X11MКомпания Oracle анонсировала новую версию СУБД-платформы Exadata. Ещё в предыдущем поколении, Exadata X10M, Oracle приняла решение отказаться от использования процессоров Intel Xeon. В Exadata X11M упор сделан на гибкость развёртывания: on-premise; в виде локального сервиса, управляемого Oracle; в сторонних облаках, в том числе в составе мультиоблачных конфигураций. Но и прирост производительности тоже заявлен солидный: новое поколение должно продемонстрировать на 55% возросшую скорость векторного поиска, который важен для обучения ИИ-моделей. Скорость сканирования данных выросла в 2,2 раза, а скорость обработки транзакций — на четверть. А на некоторых операциях прирост быстродействия достигает 32 раз. При этом новая платформа стоит столько же, сколько и предыдущая, говорит Oracle. Прирост производительности во многом обусловлен программными оптимизациями, но и аппаратную составляющую компания тоже подтянула. Основой Oracle Exadata X11M являются AMD EPYC, DDR5-6400, NVMe SSD и двухпортовые 100G-адаптеры. Каждый ДБ-сервер X11M содержит два 96-ядерных процессора AMD EPYC и 512 Гбайт RAM с возможностью расширения до 3 Тбайт. Впрочем, есть и конфигурация попроще — X11M-Z имеет один 32-ядерный EPYC и 768 Гбайт или 1,152 Тбайт памяти. В Exadata активно используется механизм RDMA, в том числе кеширующий слой Exadata RDMA Memory (XRMEM), на который уходит большая часть RAM. Серверы хранения данных представлены в трёх вариантах: с одним (HC-Z) либо двумя 32-ядерными процессорами (EF и HC) и памятью объёмом 768 Гбайт либо 1,5 Тбайт соответственно. Узлы хранения HC (High Capacity) включают четыре кеширующих 6,8-Тбайт NVMe-накопителя Flash Accelerator F680 v2 (PCIe 5.0) и двенадцать 22-Тбайт SAS HDD (7200 RPM). В узлах EF (Extreme Flash) вместо HDD используются четыре 30,72-Тбайт NVMe SSD. А узлы HC-Z от HC отличаются тем, что имеют лишь пару 6,8-Тбайт кеширующих NVMe SSD и шесть 22-Тбайт HDD. Минимальная конфигурация Exadata X11M состоит из двух серверов БД и трёх серверов хранения. Она обеспечивает скорость сканирования 135 Гбайт/с и предоставляет 1,9 Пбайт для хранения данных. Последнее достигнуто благодаря использованию гибридного сжатия Oracle Database Hybrid Columnar Compression. В максимальной конфигурации каждая стойка X11M может содержать до 2880 процессорных ядер, 42 Тбайт RAM, 462 Тбайт высокопроизводительной флеш-памяти и 2,2 Пбайт (SSD) или 4,4 Пбайт (HDD) общего дискового пространства. Сетевая часть представлена RoCE-фабрикой на базе двухпортовых адаптеров, работающих в режиме Active–Active. Всего в стойку можно установить от 3 до 15 серверов БД и от 3 до 17 серверов хранения данных. Конфигурация может быть расширена дополнительными стойками, подключаемыми посредством RoCE-интерконнекта, причём поддерживаются смешанные варианты, в которых совместно трудятся стойки Exadata X8M, X9M, X10M и X11M. Простоту масштабирования обеспечивают технологии Oracle Real Application Clusters (RAC) и Exadata Exascale and Automatic Storage Management (ASM). На сегодня Exadata X11M является наиболее продвинутой БД-платформой, сочетающей в себе высочайшую производительность работы с базами данных Oracle, гибкость конфигурации и широкие возможности выбора варианта развёртывания, будь то использование платформы в рамках AWS, Microsoft Azure и Google Cloud или размещение в ЦОД заказчика, говорит Oracle.

10.01.2025 [14:21], Руслан Авдеев

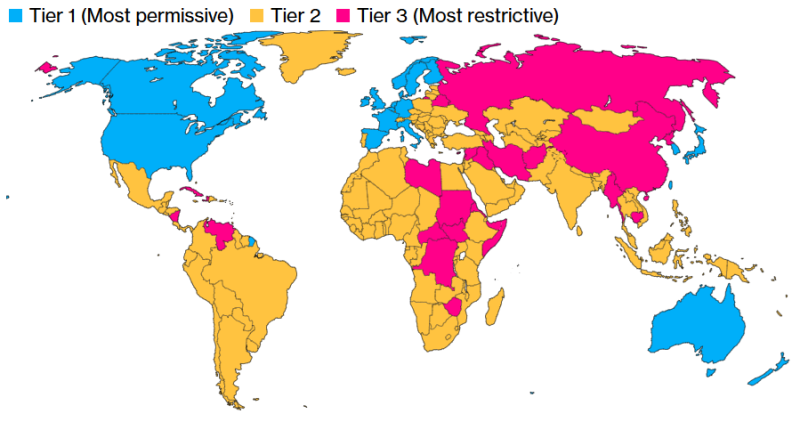

ИИ по квотам: США распространят ограничения на поставку ускорителей и обучение моделей почти на весь мирАдминистрация действующего президента США Джо Байдена (Joe Biden) до окончания своих полномочий намерена провести очередной раунд ограничений на экспорт ИИ-чипов. Это новая попытка перекрыть доступ к передовым технологиям Китаю, Ирану, России и другим странам, сообщает Bloomberg. После появления новостей акции NVIDIA и AMD несколько упали в цене. По данным источников, США намерены ограничить продажи ИИ-полупроводников для ЦОД как на уровне стран, так и на уровне отдельных компаний. Основная цель — обеспечить развитие передовых ИИ-систем только «дружественным» государствам и приведение мирового бизнеса в соответствие с американскими стандартами. В результате ограничения в той или иной степени распространятся почти на весь мир. Неограниченный доступ к современным технологиям сохранит только небольшая группа союзников США вроде Канады, ряда стран ЕС, Южной Кореи и Японии. Остальным доступ постараются перекрыть максимально, а большая часть мира, по мнению администрации, оказалась недостаточно благонадёжной, чтобы покупать ИИ-ускорители без ограничений. Появятся квоты, ограничивающие вычислительные способности каждой отдельной страны. Компании, базирующиеся в таких странах, могут обойти подобные ограничения — но для этого им необходимо будет привести свой бизнес в соответствие с американскими стандартами. Для этого вводится термин «проверенный конечный пользователь» (Validated End User, VEU). Разумеется, в NVIDIA выступили против инициативы, подчеркнув, что ограничение экспорта не прекратит злоупотребления, но создаст угрозу экономическому росту и поставит под вопрос лидерство США. Пока общемировой интерес к ускоренным вычислениям в повседневной жизни — невероятная возможность для экономики Соединённых Штатов. Многолетние санкции уже ограничивают возможности NVIDIA, AMD и др. компаний поставлять передовые чипы любому заказчику. Теперь США пытаются ограничить доступ к чипам через посредников на Ближнем Востоке и в Юго-Восточной Азии. Против инициативы выступает и Ассоциация полупроводниковой промышленности (Semiconductor Industry Association). Ассоциация не одобряет принятия решения в период смены президентов, без учёта мнения отрасли — это может сказаться на конкурентоспособности США в мире. Китай имеет собственные ИИ-чипы, хотя и не такие производительные и, возможно, будет поставлять их и другим странам, усиливая своё влияние. Новые меры готовятся ввести на фоне гигантского спроса на ИИ-ускорители. Буквально каждая страна намерена использовать их в своих ЦОД, в чём и заключается «уникальная возможность» США и в политической плоскости — чтобы, по словам конгрессменов, «увести компании и страны с орбиты Пекина». К первому «разряду» (Tier I), по данным источников издания, отнесут США и 18 союзников, включая Канаду, Австралию, Японию, Великобританию, Германию, Францию, Южную Корею и Тайвань. Компании из этих регионов могут свободно пользоваться вычислительными ресурсами, а их штаб-квартиры в этих странах смогут получить разрешение на поставку чипов в ЦОД практически по всему миру. Однако им запрещено размещать более 25 % вычислительных мощностей за пределами стран Tier I и более 7 % — в любой из стран Tier II. Кроме того, они должны будут соблюдать требования к безопасности, выдвигаемые американским правительством. Компании со штаб-квартирами в США должны будут размещать не менее половины вычислительных мощностей на американской земле. В целом США и приближённые страны, согласно новому плану, должны располагать большими вычислительными мощностями, чем весь остальной мир. Подавляющее большинство стран относится ко второму разряду (Tier II). Каждой из них можно внедрить порядка 50 тыс. ИИ-ускорителей с 2025 по 2027 гг. При этом отдельные компании могут добиться гораздо больших лимитов, если получат статус VEU в каждой стране, где намерены оснастить ЦОД. Для этого необходимо иметь доказанную историю соблюдения американских норм и стандартов в сфере прав человека, или, как минимум, иметь убедительные планы для достижения необходимых результатов. Если компания получит статус VEU, её импорт чипов не будет сказываться на общей квоте страны. Это поощряет бизнес приводить свою деятельность в соответствие с американскими стандартами. Вместе с тем накладываются и требования по физической безопасности объектов, кибербезопасности и отбору персонала. Наконец, больше всего ограничения коснутся России, Беларуси, Китая, Ирана, КНДР, а также всех стран, на которые распространяется американское эмбарго на поставки вооружений. Речь идёт приблизительно о двух дюжинах государств уровня Tier III. Поставки ИИ-ускорителей в ЦОД этих стран будут запрещены. Помимо контроля над полупроводниками, новые правила также ограничивают и экспорт закрытых ИИ-моделей. Компаниям будет запрещён их хостинг в странах Tier III, а страны Tier II должны будут выполнять ряд требований. Конечно, ограничения не распространяются на страны, получившие универсальный статус VEU. Открытых моделей эти правила не коснутся, то же касается и маломощных закрытых моделей, менее производительных, чем имеющиеся в свободном доступе. Тем не менее, если компания захочет настроить открытую модель для выполнения специальных задач и этот процесс потребует значительных вычислительных мощностей, ей также понадобится подавать заявку на получение разрешения США для выполнения подобных задач в странах Tier II. Ранее США запрещали поставки в страны вроде России на неопределённый срок. В Китай разрешено было поставлять версии с ограниченной функциональностью, а в ноябре прошлого года появилась новость, что США запретили TSMC выпускать передовые ускорители по заказу китайских компаний. На большинство стран мира ограничения не распространялись, что способствовало стремительному росту бизнеса NVIDIA.

29.12.2024 [15:25], Руслан Авдеев

AWS планирует сократить расходы на оборудование ZT Systems, покупаемой AMDAmazon Web Services (AWS) планирует сократить расходы на закупки оборудования для дата-центров у одного из ключевых поставщиков — всё больше аппаратного обеспечения гиперскейлер разрабатывает самостоятельно. Речь идёт о компании ZT Systems, которая в скором времени станет частью AMD, сообщает Business Insider. В прошлом году AWS потратила почти $2 млрд на дела с ZT Systems, разрабатывающей и выпускающей серверы и сетевые решения — об этом свидетельствует один из внутренних документов Amazon 2023 года, попавших в распоряжение журналистов. Согласно материалам AWS, компания намерена перейти на самостоятельную разработку некоторых «серверных и сетевых стоек». Эти изменения «потенциально повлияют» на сотрудничество с ZT Systems. Информацию подтвердили источники в AWS, также сообщившие, что компания снижает расходы на оборудование данного производителя. Правда, один из них уточнил, что сокращения будут происходить поэтапно, поскольку решения ZT Systems тесно интегрированы с серверами AWS. Официально в AWS утверждают, что компании продолжат сотрудничество. Правда, представитель гиперскейлера подчеркнул, что компания непреклонна в желании сократить расходы. И подход к покупкам инфраструктурных решений в этом отношении ничем не отличается. AWS считается крупнейшим облачным провайдером в мире. Несмотря на сокращение закупок у отдельных поставщиков, траты компании на оборудование вряд ли уменьшатся. Капитальные затраты Amazon должны составить в 2024 году $75 млрд. В основном средства будут направлены на развитие дата-центров. В последние годы AWS использует всё больше оборудования собственной разработки для снижения издержек, повышения эффективности и снижения зависимости от внешних поставщиков. Прочие облачные гиганты, включая Google, также разрабатывают собственные чипы и сетевое оборудование. Летом AMD согласилась приобрести ZT Systems за $4,9 млрд. Это, как ожидается, усилит её позиции в качестве поставщика решений для дата-центров. Несмотря на сокращение сотрудничества, AWS всё ещё может направлять ZT собственные разработки, чтобы та выпускала их на своих мощностях. Правда, ранее AMD сообщала, что планирует продать производственный бизнес ZT Systems после того, как сделка будет закрыта. В последние месяцы некоторые сотрудники AWS выражали обеспокоенность сотрудничеством с ZT Systems, поскольку AWS и AMD выпускают некоторые похожие продукты. Впрочем, AWS тесно сотрудничает с AMD и даже предлагает в облаках доступ к процессорам компании, но новейших ИИ-чипов последней в облачной линейке предложений Amazon пока нет. Отчасти, по данным источников, это объясняется низким спросом. |

|