Материалы по тегу: ии

|

06.12.2024 [16:42], Сергей Карасёв

iGenius анонсировала Colosseum — один из мощнейших в мире ИИ-суперкомпьютеров на базе NVIDIA DGX GB200 SuperPodКомпания iGenius, специализирующаяся на ИИ-моделях для отраслей со строгим регулированием, анонсировала вычислительную платформу Colosseum. Это, как утверждается, один из самых мощных в мире ИИ-суперкомпьютеров на платформе NVIDIA DGX SuperPOD с тысячами ускорителей GB200 (Blackwell). Известно, что комплекс Colosseum располагается в Европе. Полностью характеристики суперкомпьютера не раскрываются. Отмечается, что он обеспечивает производительность до 115 Эфлопс на операциях ИИ (FP4 с разреженностью). Говорится о применении передовой системы жидкостного охлаждения. Для питания используется энергия из возобновляемых источников в Италии. По информации Reuters, в состав Colosseum войдут около 80 суперускорителей GB200 NVL72. Таким образом, общее количество ускорителей Blackwell достигает 5760. Общее энергопотребление системы должно составить почти 10 МВт. Стоимость проекта не называется. Но глава iGenius Ульян Шарка (Uljan Sharka) отмечает, что компания в течение 2024 года привлекла на развитие примерно €650 млн и намерена получить дополнительное финансирование для проекта Colosseum. При этом подчёркивается, что iGenius — один из немногих стартапов в области ИИ в Европе, капитализация которого превышает $1 млрд. iGenius планирует применять Colosseum для ресурсоёмких приложений ИИ, включая обучение больших языковых моделей (LLM) с триллионом параметров, а также работу с открытыми моделями генеративного ИИ. Подчёркивается, что создание Colosseum станет основой для следующего этапа сотрудничества между iGenius и NVIDIA в области ИИ для поддержки задач, требующих максимальной безопасности данных, надёжности и точности: это может быть финансовый консалтинг, обслуживание пациентов в системе здравоохранения, государственное планирование и пр. Модели iGenius AI, созданные с использованием платформы NVIDIA AI Enterprise, NVIDIA Nemotron и фреймворка NVIDIA NeMo, будут предлагаться в виде микросервисов NVIDIA NIM. По заявлениям iGenius, Colosseum поможет удовлетворить растущие потребности в ИИ-вычислениях. Colosseum также будет служить неким хабом, объединяющим предприятия, академические учреждения и государственные структуры. Нужно отметить, что около месяца назад компания DeepL, специализирующаяся на разработке средств автоматического перевода на основе ИИ, объявила о намерении развернуть платформу на базе NVIDIA DGX GB200 SuperPod в Швеции. DeepL будет применять этот комплекс для исследовательских задач, в частности, для разработки передовых ИИ-моделей.

06.12.2024 [14:24], Андрей Крупин

«Группа Астра» купила «Платформу Боцман» — отечественного разработчика ПО для контейнеризации«Группа Астра» объявила о включении в свой контур и приобретении 100 % долей компании «Платформа Боцман», занимающейся разработкой одноимённого решения для управления мультикластерами на базе Kubernetes. Платформа контейнеризации «Боцман» включена в реестр Минцифры России и ориентирована на крупных корпоративных заказчиков. Решение может быть использовано для развёртывания мультитенантных кластеров, обеспечения поддержки оборудования, работы с прикладными сервисами, создания ИБ-решений для Enterprise-сегмента, соответствующих регуляторным требованиям по защите информации. В составе системы представлены инструменты для мониторинга, балансировки и автомасштабирования контейнерных нагрузок, настройки политик безопасности и резервного копирования. Сообщается, что одной из задач «Платформы Боцман» станет интеграция программного комплекса «Боцман» с Nodus — собственной разработкой «Группы Астра» для управления контейнеризацией. Объединённый продукт должен стать комплексным решением для контейнеризации, сочетающим возможности «Боцмана» с глубокой интеграцией с Nodus и встроенными в операционную систему Astra Linux средствами защиты информации. Nodus станет ядром новой платформы, а «Боцман» обеспечит управление, оркестрацию и поддержку прикладных сервисов.

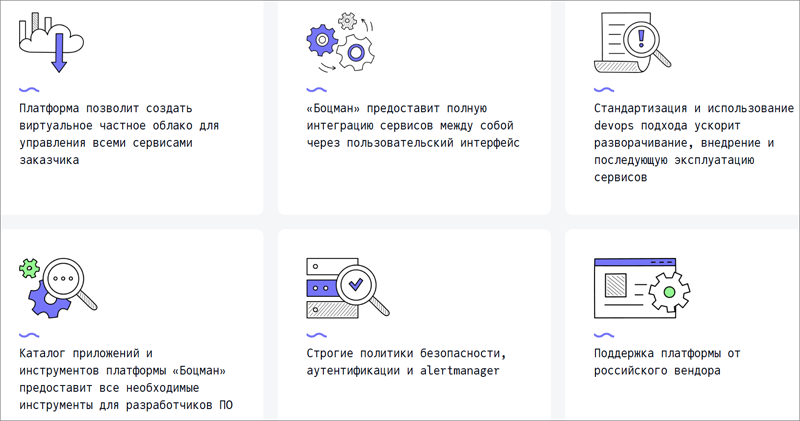

Функциональные возможности платформы «Боцман» (источник изображения: bootsman.pro) Кроме того, «Группа Астра» планирует интегрировать систему «Боцман» с облачными решениями Astra Cloud и Astra Infrastructure Cloud, а также усилить направление разработки ПО. Ожидается, что в результате заказчики и разработчики получат многофункциональный инструментарий для создания софта на базе контейнеров и микросервисов. Также в планах «Группы Астра» и команды компании «Боцман» — разработка программно-аппаратных комплексов под различные задачи и комплексные сценарии, начиная от управления данными и заканчивая приложениями, в основе которых — гибкая, масштабируемая и безопасная контейнеризация.

06.12.2024 [12:59], Сергей Карасёв

У NVIDIA появится центр исследований и разработок во ВьетнамеКомпания NVIDIA сообщила о намерении открыть свой первый центр исследований и разработок во Вьетнаме: основным направлением деятельности площадки станут проекты, связанные с ИИ. Кроме того, NVIDIA примет участие в строительстве дата-центров во Вьетнаме, также ориентированных на задачи ИИ. В рамках нового проекта NVIDIA сотрудничает с вьетнамскими властями. Как отмечает Reuters, соглашение о формировании центра исследований и разработок подписано в присутствии генерального директора NVIDIA Дженсена Хуанга (Jensen Huang) и премьер-министра Вьетнама Фам Минь Тиня (Pham Minh Chinh). Финансовые условия договора не раскрываются. Известно, что одним из основных направлений деятельности центра станет разработка специализированного софта. Кроме того, будут проводиться работы в области ИИ-платформ. Исследователи и стартапы смогут использовать инфраструктуру NVIDIA для создания ИИ-приложений для ключевых отраслей, включая здравоохранение, образование, транспорт и финансы.

Источник изображения: NVIDIA Хуанг во время визита в Ханой год назад заявил, что компания намерена развивать партнёрские отношения с ведущими технологическими предприятиями Вьетнама и оказывать стране поддержку в подготовке специалистов в области ИИ и цифровой инфраструктуры. Кроме того, NVIDIA заключила сделку по приобретению стартапа в сфере здравоохранения VinBrain — подразделения вьетнамского конгломерата Vingroup. А вьетнамская технологическая компания FPT в апреле текущего года сообщила о намерении развернуть ИИ-фабрику стоимостью $200 млн с использованием аппаратного и программного обеспечения NVIDIA. В целом, NVIDIA инвестирует средства в технологическую экосистему Вьетнама на протяжении восьми лет. Компания сотрудничает с более чем 100 вьетнамскими стартапами в области ИИ.

06.12.2024 [12:03], Сергей Карасёв

Delta Computers представила СХД Delta Marlin с поддержкой 36 NVMe SSD с интерфейсом PCIe 5.0Компания Delta Computers, российский производитель IT-оборудования и поставщик ПО, анонсировала СХД Delta Marlin, рассчитанную на работу с накопителями U.2 NVMe, оснащёнными интерфейсом PCIe 5.0. Кроме того, представлена платформа хранения Delta Guepard с гибкими вариантами конфигурации. Решение Delta Marlin — система высокой плотности, которая может использоваться как для расширения дискового пространства сервера, так и в составе высокоскоростных программного-определяемых СХД. Возможна организация двухконтроллерного сценария благодаря dual-port режиму SSD. Система в зависимости от варианта исполнения допускает установку 18 накопителей SFF толщиной 7мм или девяти SSD толщиной 15 мм. Кроме того, возможно подключение до 36 накопителей в 2OU-модуле. Предусмотрены два слота расширения для карт PCIe 5.0 х16 HHHL. Применяется встроенное ПО Delta BMC. Питание осуществляется от общей DC-шины OCP на 12 В. В системе охлаждения задействованы шесть вентиляторов с резервированием по схеме N+1. В свою очередь, Delta Guepard — это семейство СХД, оптимизированных для высокопроизводительных приложений, требующих низкой задержки ввода-вывода и высокой пропускной способности. Устройства основаны на модульной архитектуре. Модификации Delta Guepard Gen 1 в форм-факторах 4U и 6U/8U рассчитаны соответственно на 30 и 60 накопителей SFF/LFF SATA HDD или U.2 (7–15 мм) NVMe SSD. Максимальная суммарная вместимость — 720 (30 накопителей) и 1440 (60 накопителей) Тбайт. Варианты Delta Guepard Gen 2 в исполнениях 4U и 6U/8U допускают установку до 36 и 72 накопителей U.2 NVMe, а общая вместимость составляет до 276 и 552 Тбайт. Все устройства Delta Guepard наделены двумя контроллерами. Возможно формирование массивов RAID 0/1/5/6/10/50/60/70. Поддерживаются протоколы SMB v2/v3, NFS v3/v4, AFP, FTP, а также Fibre Channel; iSCSI; InfiniBand (FDR, QDR, DDR, EDR). Питание осуществляется от централизованного шинопровода OCP на 12 В. В продажу решения поступят в I квартале 2025 года.

05.12.2024 [22:47], Руслан Авдеев

Дженсен Хуанг пообещал Таиланду помочь в развитии ИИ и ЦОД, но путь этот будет непростымNVIDIA намерена сотрудничать с правительством Таиланда в деле создания инфраструктуры ИИ мирового класса. При этом вызывает вопрос способность Таиланда в полной мере использовать свои сильные стороны для формирования экосистемы ИИ ЦОД, сообщает DigiTimes. 3 декабря глава NVIDIA Дженсен Хуанг (Jensen Huang) встретился с премьер-министром Таиланда Пхэтхонгтхан Чиннават (Paetongtarn Shinawatra). Стороны пришли к соглашению об углублении взаимодействия в сфере ИИ-технологий. NVIDIA будет работать с правительством над созданием ИИ-инфраструктуры мирового уровня и предоставит талантливые кадры для поддержки таиландских инициатив в области ИИ. Кроме того, компания поддержит более 50 ИИ-стартапов и вложится в университетские программы обучения ИИ-специальностям. Хуанг также посетил мероприятие первого облачного партнёра NVIDIA в Таиланде — Siam.AI Cloud. Его руководство имеет заметное политическое влияние в стране и родственные связи как с бывшим, так и с действующим премьер-министрами. Визит Хуанга рассматривается как весьма положительное для ИИ-сектора страны событие. Не исключается даже, что в перспективе она сможет конкурировать с Малайзией и Индонезией и сможет привлечь в индустрию ЦОД ещё больше инвестиций, в том числе на производство серверного оборудования. Сотрудничество с NVIDIA также должно поспособствовать более широкому внедрению ИИ в стране. Вместе с тем всё ещё есть некоторые трудности для развития ИИ-экосистемы: высокие налоги на импорт, немалые расходы на передачу данных и дорогая электроэнергия. Из-за этого страна может оказаться не особенно привлекательной для крупных ЦОД. Некоторые эксперты и вовсе уверены, что создание ЦОД не повлияет на местную промышленность и не поможет сократить расходы на местные облака. Инвестиции в дата-центры способны обеспечить рост ВВП Таиланда, но они же увеличат и потребление электричества. Исследователи считают, что Таиланд может получить выгоду от ИИ ЦОД, используя свои компетенции в области ПО и SaaS. Однако в стране не хватает талантливых кадров в сфере полупроводников, что не позволяет ей играть значимую роль в мировых цепочках поставок. О возможном визите Хуанга в Бангкок сообщалось ещё в конце октября, но масштаб инвестиций значительно меньше объёмов вложений в страну со стороны AWS, Microsoft и Google. Так или иначе, страна активно ищет инвесторов для развития местной ИИ-экосистемы и полупроводниковой отрасли.

05.12.2024 [16:14], Сергей Карасёв

Запущен британский Arm-суперкомпьютер Isambard 3 с суперчипами NVIDIA GraceВ Великобритании введён в эксплуатацию суперкомпьютер Isambard 3, предназначенный для ресурсоёмких приложений ИИ и задач НРС. Реализация проекта обошлась приблизительно в £10 млн, или примерно $12,7 млн. Машина пришла на смену комплексу Isambard 2, который отправился на покой в сентябре нынешнего года. Система Isambard 3 создана в рамках сотрудничества между исследовательским консорциумом GW4 Alliance, в который входят университеты Бата, Бристоля, Кардиффа и Эксетера, а также компаниями HPE, NVIDIA и Arm. Суперкомпьютер назван в честь британского инженера Изамбарда Кингдома Брюнеля, внесшего значимый вклад в Промышленную революцию. Полностью технические характеристики Isambard 3 не раскрываются. Известно, что в основу машины положены 384 суперпроцессорами NVIDIA Grace со 144 ядрами (2 × 72) Arm Neoverse V2 (Demeter), общее количество которых превышает 55 тыс. Задействована высокопроизводительная СХД HPE, которая обеспечивает расширенные IO-возможности с интеллектуальным распределением данных по нескольким уровням. Благодаря этому достигается эффективная обработка задач с интенсивным использованием информации, таких как обучение моделей ИИ. Известно также, что в составе комплекса применяется фирменный интерконнект HPE Slingshot, а в качестве внутреннего интерконнекта служит технология NVLink-C2C, которая в семь раз быстрее PCIe 5.0. Каждый узел суперкомпьютера содержит один суперчип Grace и сетевой адаптер Cassini с пропускной способностью до 200 Гбит/с. Объём системной памяти составляет 2 × 120 Гбайт (240 Гбайт). Отмечается, что Isambard 3 демонстрирует в шесть раз более высокую производительность и в шесть раз лучшую энергоэффективность по сравнению с Isambard 2. Пиковое быстродействие FP64 у Isambard 3 достигает 2,7 Пфлопс при энергопотреблении менее 270 кВт. Применять новый суперкомпьютер планируется для таких задач, как проектирование оптимальной конфигурации ветряных электростанций на суше и воде, моделирование термоядерных реакторов, исследования в сфере здравоохранения и пр. Суперкомпьютер расположен в автономном дата-центре с системой самоохлаждения HPE Performance Optimized Data Center (POD) в Национальном центре композитов в Научном парке Бристоля и Бата. Там же ведётся монтаж ИИ-комплекса Isambard-AI стоимостью £225 млн ($286 млн), который должен стать самым быстрым и мощным суперкомпьютером в Великобритании. Проект Isambard-AI реализуется в несколько этапов. Первая фаза предполагает монтаж 42 узлов, каждый из которых несёт на борту четыре суперчипа NVIDIA GH200 Grace Hopper и 4 × 120 Гбайт памяти для CPU (доступно 460 Гбайт — по 115 Гбайт на CPU), а также 4 × 96 Гбайт памяти для GPU (H100). В ходе второй фазы будут добавлены 1320 узлов, насчитывающих в сумме 5280 суперчипов NVIDIA GH200 Grace Hopper. Кроме того, в состав Isambard 3 входит экспериментальный x86-модуль MACS (Multi-Architecture Comparison System), включающий сразу восемь разновидностей узлов на базе процессоров AMD EPYC и Intel Xeon нескольких поколений, часть из них также имеет ускорители AMD Instinct MI100 и NVIDIA H100/A100. Все они объединены 200G-интерконнектом HPE Slingshot.

05.12.2024 [14:28], Руслан Авдеев

OpenAI намерена построить в США собственные ИИ ЦОД для коммерциализации технологийКомпания OpenAI намерена построить собственные дата-центры в США в рамках плана по привлечению к своим сервисам 1 млрд пользователей и дальнейшей коммерциализации своих технологий. По словам представителя OpenAI, компания намерена получить в своё распоряжение ЦОД как для обучения, так и для инференса, сообщает Financial Times. По словам представителя компании, «чипы, данные и энергия» станут ключевыми факторами, которые помогу компании выиграть в гонке ИИ-технологий и создать AGI, потенциально соответствующий возможностям человеческого мозга или даже превосходящий его. OpenAI намерена построить кластеры ЦОД на Среднем Западе и юго-востоке США. Подробности пока не разглашаются, но подтверждается, что строительство дата-центров является частью стратегии коммерциализации ИИ-технологий компании. В своё время OpenAI была основана как некоммерческая организация, но теперь переходит к более традиционной для бизнеса корпоративной структуре. Как сообщает Financial Times, компания наняла своего первого главу по финансам и продуктам и теперь якобы рассматривает возможности интеграции рекламы в свои решения. Что касается действующей цифровой инфраструктуры OpenAI, которая ранее в этом году привлекла ещё $6,6 млрд, в основном полагается на дата-центры Microsoft Azure — именно Microsoft вложила в стартап миллиарды долларов. Недавно компания начала посматривать и на других облачных провайдеров, а в июне анонсировала партнёрство с Oracle, в рамках которого Oracle Cloud Infrastructure будет задействована для обучения ИИ-моделей (правда, тоже при посредничестве Microsoft). Запросы компании превышают мощности, которые способна предоставить ей Microsoft. Не так давно OpenAI пыталась убедить правительство США в необходимости создания 5-ГВт дата-центров, способных вместить сразу 2 млн ускорителей. Компания заявила, что это уже вопрос национальной безопасности, и даже подготовила целый ряд рекомендаций.

05.12.2024 [13:37], Сергей Карасёв

AWS представила инстансы EC2 P5en на базе NVIDIA H200 и кастомизированных чипов Intel XeonОблачная платформа AWS объявила о доступности инстансов EC2 P5en, рассчитанных на такие нагрузки, как глубокое обучение, генеративный ИИ, обработка данных в реальном времени и приложения HPC. В основу новых экземпляров положены аппаратные компоненты Intel и NVIDIA. В частности, задействованы кастомизированные процессоры Xeon Sapphire Rapids. У них все ядра могут одновременно работать на турбо-частоте 3,2 ГГц, а максимальная частота отдельных ядер достигает 3,8 ГГц. Кроме того, применяются ИИ-ускорители NVIDIA H200 и адаптеры AWS Elastic Fabric Adapter (EFA) v3 с пропускной способностью до 3,2 Тбит/с. Конфигурация инстансов EC2 P5en включает 192 vCPU, 2048 ГиБ памяти, восемь ускорителей H200 и восемь SSD вместимостью 3,84 Тбайт каждый. Пропускная способность EBS составляет 100 Гбит/с. Отмечается, что экземпляры P5en демонстрируют увеличение производительности локального хранилища до двух раз и пропускной способности EBS до 25 % по сравнению с инстансами P5 на базе NVIDIA H100.

Источник изображения: NVIDIA На сегодняшний день инстансы EC2 P5en доступны в американских регионах AWS US East (Огайо) и US West (Орегон), а также в Азиатско-Тихоокеанском регионе в Токио. Предлагаются различные тарифные опции, включая оплату по мере использования. Ранее были представлены инстансы EC2 P5e с процессорами AMD EPYC Milan, 2 ТиБ памяти, восемью ускорителями NVIDIA H200 и восемью NVMe SSD на 3,84 Тбайт каждый. У этих экземпляров пропускная способность EBS равна 80 Гбит/с.

05.12.2024 [09:13], Руслан Авдеев

AWS представила новую архитектуру ИИ ЦОД, энергоэффективную и экологичную

aws

hardware

pue

водоснабжение

дизель

ибп

ии

охлаждение

сжо

сша

цод

экология

электропитание

энергетика

энергоэффективность

AWS рассказала об инновациях, внедряемых в её ЦОД для поддержки ИИ-нагрузкок следующего поколения. По данным DataCenter Dynamics, нововведения связаны в первую очередь с электропитанием и охлаждением. Они направлены на повышение энергоэффективности дата-центров AWS. Первые ЦОД на базе новой архитектуры заработают в начале 2025 года. Новые решения в свежих новых дата-центрах компании по всему миру, а некоторые начнут применять уже на существующих объектах. В компании подчёркивают, что решения изначально спроектированы как модульные, поэтому возможная поэтапная модернизация площадок для внедрения СЖО, повышения энергоэффективности и снижения углеродного следа. Так, AWS упростит электрическую и механическую структуру новых ЦОД, чтобы облегчит их обслуживание и повысить надёжность. В частности, упростится подход к распределению энергии внутри ЦОД, а источники резервного питания будут размещаться ближе к стойкам. Это позволит повысить доступность инфраструктуры до 99,9999 % времени, а количество стоек, которых могут коснуться проблемы с энергоснабжением, снизится на 89 %. Также уменьшится количество вентиляторов для отвода горячего воздуха. Вместо этого будет применяться естественный перепад давления, что положительно скажется на энергопотреблении. Вместе с тем AWS намерено вшестеро увеличить мощность стойки в следующие два года, и ещё втрое — в будущем. Впрочем, в ИИ-серверах, где мощность ускорителей приближается к 1 кВт, без СЖО обойтись сложно. AWS готовит суперкластеры Project Rainier и Project Ceiba на базе AWS Tranium2 и NVIDIA Blackwell соответственно, поэтому она вместе с крупным производителем СЖО будет внедрять прямое жидкостное охлаждение и в новых, и в старых ЦОД. В некоторых случаях будет использоваться и гибридное охлаждение. Одним из главных плюсов новой архитектуры охлаждения является гибкость — акцент на воздушное или жидкостное охлаждение будет делаться в зависимости от потребностей оборудования и возможностей конкретных дата-центров. Заодно AWS использовала имеющиеся данные и генеративный ИИ для поиска наиболее эффективного способа размещения стоек в своих ЦОД, добавив ещё 12 % вычислительных мощностей на каждую площадку. Новая технология будет применяться как к новому оборудованию для ИИ-систем, так и для других типов техники. Также компания внедрила собственную систему управления механическими и электрическими устройствами — она поможет стандартизировать мониторинг и эксплуатацию дата-центров. Наконец, предприняты усилия по повышению экобезопасности дата-центров. AWS заявила, что новая архитектура охлаждения снизит потребление энергии на 46 % во времена пиковых нагрузок без увеличения потребления воды. Доля углеродных выбросов при производстве бетона, используемого при строительстве ЦОД, уменьшена на 35 % относительно средней по отрасли, кроме того, на 35 % сокращается потребление стали в целом, а та, что используется, поступает из электродуговых печей, а не газовых, что сокращает косвенные выбросы. Наконец, резервные генераторы AWS переведут на возобновляемое дизельное топливо. Дополнительно AWS совместно с Orbital Materials запустила пилотный проект по тестированию разработанного с помощью ИИ материала, помогающего захватывать в дата-центрах углекислый газ — речь идёт о «губке на атомном уровне», взаимодействующей только с молекулами углекислоты. Тестирование материала, три года разрабатывавшегося компаниями, начнётся в начале 2025 года. По данным Orbital, новый материал значительно дешевле аналогов. В дальнейшем стартап планирует испытать разработанные с помощью ИИ технологии для экономии воды и охлаждения чипов. DataCenter Dynamics также отмечает, что AWS впервые раскрыла показатель PUE своих дата-центров. В среднем он составляет 1,15, а самая лучшая площадка достигла 1,04. Для сравнения: у Google эти показатели составляют 1,1 и 1,06 соответственно, у Microsoft — 1,18 и 1,12 (у новых объектов). ЦОД Meta✴ в среднем имеют PUE около 1,08, а Oracle говорит об 1,15.

04.12.2024 [17:43], Сергей Карасёв

AWS построит распределённый ИИ-суперкомпьютер Project Rainier с десятками тысяч ИИ-ускорителей Trainium2Облачная платформа AWS официально представила инстансы EC2 Trn2 и Trn2 UltraServer — самые высокопроизводительные решения EC2, ориентированные на ИИ-приложения, машинное обучение и задачи инференса. В основу положены фирменные ускорители Amazon Trainium2 второго поколения. ИИ-ускорители Trainium2 содержат восемь ядер NeuronCore и 96 ГиБ памяти HBM с пропускной способностью 2,9 Тбайт/с. Ядра могут адресоваться и использоваться по отдельности или же пары физических ядер могут быть сгруппированы в один логический блок. Trainium2 обеспечивает FP8-быстродействие до 1,3 Пфлопс, а FP8-производительность в разреженных вычислениях достигает 5,2 Пфлопс. Инстансы EC2 Trn2 содержат 16 ускорителей Trainum2, связанных посредством интерконнекта NeuronLink. В сумме это даёт 128 ядер NeuronCore и 1,5 ТиБ памяти HBM с суммарной пропускной способностью 46 Тбайт/с. Производительность на операциях FP8 достигает 20,8 Пфлопс. Каждый инстанс включает 192 vCPU, 2 ТиБ памяти и адаптеры AWS Elastic Fabric Adapter (EFA) v3 на 3,2 Тбит/с. Утверждается, что инстансы Trn2 обеспечивают в четыре раза более высокую производительность, в четыре раза большую пропускную способность памяти и в три раза большую ёмкость памяти, нежели инстансы Trn1. Кроме того, экземпляры Trn2 предлагают на 30–40 % лучшее соотношение цены и производительности, чем EC2 P5e и P5en на базе GPU. Инстансы Trn2 доступны в регионе AWS US East (Огайо), а в ближайшем будущем появятся и в других зонах. В свою очередь, платформа UltraServer включает четыре инстанса Trn2 (64 ускорителя Trainum2) с интерконнектом NeuronLink с низкой задержкой. В сумме это даёт 512 ядер NeuronCore и 6 ТиБ памяти HBM с суммарной пропускной способностью 185 Тбайт/с. Быстродействие на операциях FP8 составляет 83 Пфлопс (332 Пфлопс в разреженных вычислениях). Новые узлы используют СЖО. Десятки тысяч ускорителей Trainium2 могут формировать кластеры EC2 UltraCluster. В частности, такую систему в рамках инициативы Project Rainier компания Amazon намерена создать в партнёрстве со стартапом Anthropic, который специализируются на технологиях генеративного ИИ. Интересно, что ИИ-суперкомпьютер Project Rainier будет распределённым — его узлы разместятся сразу в нескольких ЦОД. ВОЛС между дата-центрами организует Lumen. Одной из причин от попытки построить один гигантский кампус называется невозможность быстро получить достаточно энергии в одном месте, хотя у компании уже есть площадка рядом с АЭС. Недавно Amazon объявила о намерении удвоить инвестиции в Anthropic, доведя их до $8 млрд. Создание системы Rainier планируется завершить в следующем году. Ожидается, что она станет одним из крупнейших в мире вычислительных кластеров для обучения моделей ИИ. По заявлениям AWS, комплекс обеспечит в пять раз более высокую производительность по сравнению с платформой, которую Anthropic использовала до сих пор для разработки своих языковых моделей. Достанутся ли Anthropic и ресурсы ещё облачного ИИ-суперкомпьютера Project Ceiba, который получит 21 тыс. суперчипов NVIDIA Blackwell, не уточняется. Кроме того, по сообщению The Register, компания Amazon приоткрыла завесу тайны над ИИ-ускорителями следующего поколения — изделиями Trainium3. По сравнению с предшественниками они, как утверждается, обеспечат четырёхкратное увеличение быстродействия. Говорится, что Trainium3 станет первым специализированным ускорителем для ИИ и машинного обучения, созданным на основе 3-нм техпроцесса. Эффективность по сравнению с Trainium2 увеличится примерно на 40 %. Ожидается, что на коммерческом рынке изделия Trainium3 появятся в конце 2025 года. |

|