Материалы по тегу: techinsights

|

10.07.2024 [16:16], Руслан Авдеев

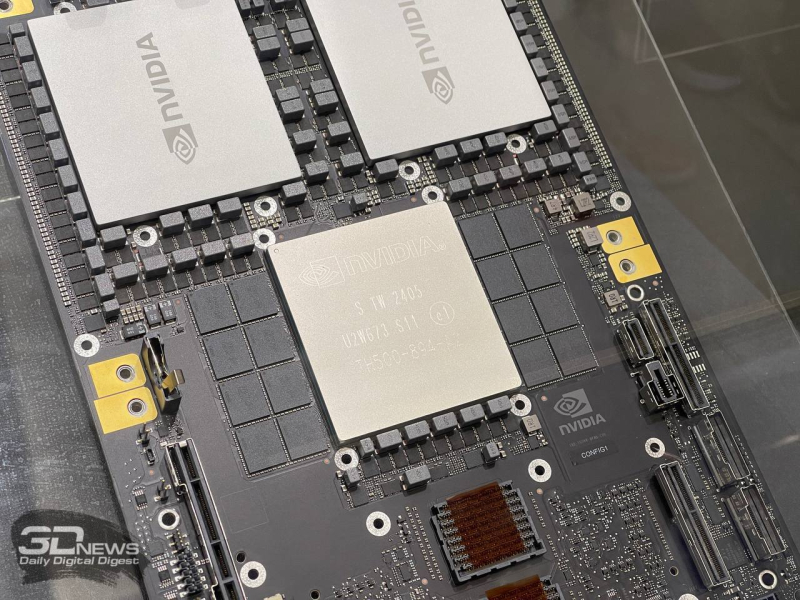

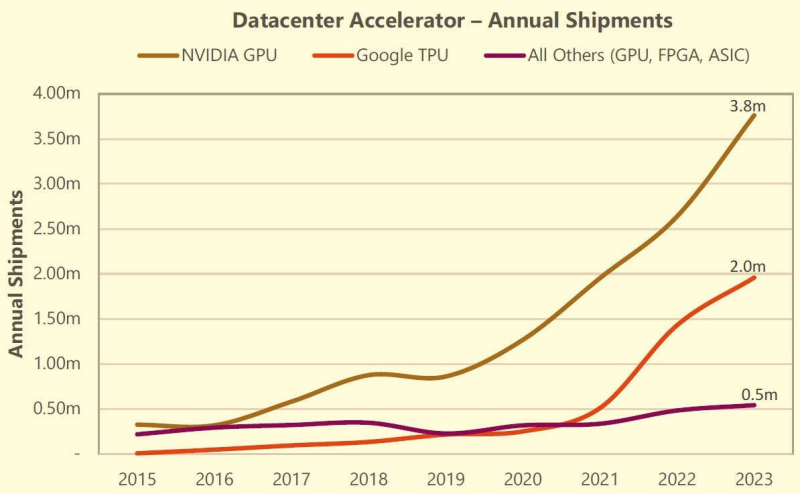

К 2029 году на ИИ-ускорители придётся 1,5 % всего энергопотребления на ЗемлеВ мире ожидается рост энергопотребления системами, связанными с генеративным ИИ. По данным HPC Wire, в следующие пять лет расход электричества на такие системы составит 1,5 % от общемирового — это весьма значимая доля, говорят эксперты. Соответствующее предположение выдвинули аналитики TechInsights. За основу взяты прогнозы Управления энергетической информации США (US Energy Information Administration, EIA) на 2025–2029 гг., в которых глобальное энергопотребление за этот период, по оценкам, составит 153 тыс. ТВт∙ч. Исследователи предполагают, что за то же время на ИИ-ускорители придётся 2318 ТВт∙ч. Расчёты исходят из того, что каждый ускоритель требует 700 Вт, а потребление флагманских NVIDIA Blackwell и вовсе составляет 1200 Вт, хотя новинки намного производительнее решений прошлых поколений. При составлении прогнозов учитывается лишь энергопотребление самих ускорителей — без модулей памяти, сетевого оборудования и прочих компонентов ИИ-систем. По мнению экспертов, «придётся попотеть», чтобы оправдать такие расходы. Согласно опросам McKinsey, 65 % респондентов намерены использовать генеративный ИИ. Для того, чтобы удовлетворить спрос, вкладываются огромные деньги в соответствующую отрасль. Если Microsoft полагается в основном на решения NVIDIA, то Meta✴ реализует и собственный проект, а её вычислительная экосистема будет эквивалентна около 600 тыс. H100. По данным TechInsights, в 2023 году NVIDIA поставила порядка 3,76 млн ускорителей — в сравнении с 2,6 млн в 2022 году. В прошлом году Gartner выступила даже с более смелым прогнозом — по её мнению, ИИ, возможно, будет потреблять и 3,5 % мирового электричества. Впрочем, методика компании не вполне ясна и, возможно, включает энергозатраты на сопутствующую экосистему помимо ускорителей. При этом расходы на электроэнергию в любом случае будут расти, а в случае дефицита поставщики энергии будут просто поднимать цены, а не пытаться разделить доступные мощности между потребителями. Поэтому сейчас всё острее становится вопрос разумного использования энергии. Так, на криптомайнинг в США, по данным EIA, приходится 2,3 % всего энергопотребления в стране, но эксперты сходятся во мнении, что использовать ресурсы для работы ИИ-систем намного рациональнее. Впрочем, и сами майнеры активно переключаются на ИИ-проекты. Кроме того, переход на СЖО и утилизация «мусорного» повышают общую энергоэффективность ЦОД. Но есть и другой путь. Так, Microsoft совместно с производителями «железа» довольно агрессивно продвигает т.н. ИИ ПК (AI PC), оснащённые NPU или иными ускорителями для локальных ИИ-вычислений. Это фактически позволяет перенести часть нагрузок на клиентские устройства, а в облаке обсчитываются те задачи, которые устройствам не под силу. Apple использует похожий подход.

11.06.2024 [15:22], Сергей Карасёв

3,76 млн ускорителей в 2023 году: NVIDIA захватила 98 % рынка GPU для ЦОДПо оценкам аналитической фирмы Tech Insights, которые приводит ресурс HPC Wire, компания NVIDIA в 2023 году отгрузила приблизительно 3,76 млн ускорителей на базе GPU, ориентированных на ЦОД. Это более чем на 1 млн штук превосходит результат 2022 года, когда поставки таких изделий оценивались в 2,64 млн единиц. С учётом решений AMD и Intel общий объём поставок GPU-ускорителей для ЦОД в 2023 году составил 3,85 млн единиц против примерно 2,67 млн штук в 2022 году. Правда, столь малая доля отгрузок решений AMD и Intel вызывает некоторые сомнения. Как отмечает аналитик Tech Insights Джеймс Сандерс (James Sanders), в настоящее время на рынке не хватает аппаратных ресурсов для удовлетворения всех ИИ-потребностей. А поэтому будет расти спрос на ускорители и специализированные чипы разработчиков, конкурирующих с NVIDIA. Согласно подсчётам TechInsights, по итогам 2023-го NVIDIA контролировала около 98 % мирового рынка ускорителей на базе GPU для дата-центров. Схожий результат компания продемонстрировала и годом ранее. Такой рост связан со стремительным развитием ИИ-приложений и увеличением спроса на НРС-системы. При этом на NVIDIA приходится и 98 % выручки от реализации таких ускорителей: в 2023 году они принесли компании $36,2 млрд, что более чем в три раза превышает прошлогодний показатель в $10,9 млрд. По данным TechInsights, в 2023 году AMD поставила около 50 тыс. ускорителей для ЦОД, а Intel — примерно 40 тыс. единиц (в оригинальном материале HPCWire указаны на порядок более высокие значения; корректировка сделана в соответствии с оставшейся долей в 2 % рынка). В 2024-м, как полагают эксперты, спрос на такие продукты в глобальном масштабе поднимется. Речь, в частности, идёт об ускорителях серии Instinct MI300, разработанных AMD. При этом AMD заявляет, что намерена выпускать новые решения ежегодно: ускоритель MI325X запланирован на 2024 год, MI350 — на 2025-й, а MI400 — на 2026-й. В свою очередь, Intel продвигает изделия Gaudi3. Специализированные ИИ-чипы проектируют и ведущие гиперскейлеры. Так, AWS в конце прошлого года представила ИИ-ускоритель Trainium2, предназначенный для обучения нейронных сетей. Google анонсировала изделия Cloud TPU v5p, а Microsoft — Maia 100. Meta✴ намерена активно внедрять собственные ИИ-ускорители Artemis.

22.05.2024 [21:45], Руслан Авдеев

Google обогнала AMD на рынке процессоров для ЦОД и вот-вот догонит Intel

cpu

google

google cloud platform

hardware

techinsights

tpu

анализ рынка

гиперскейлер

ии

облако

ускоритель

цод

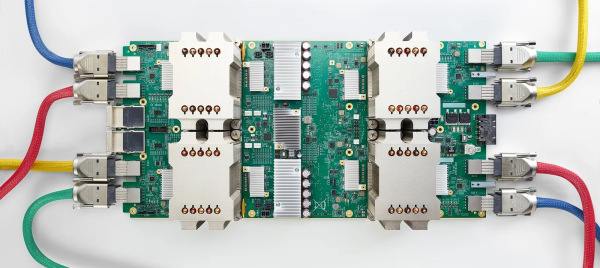

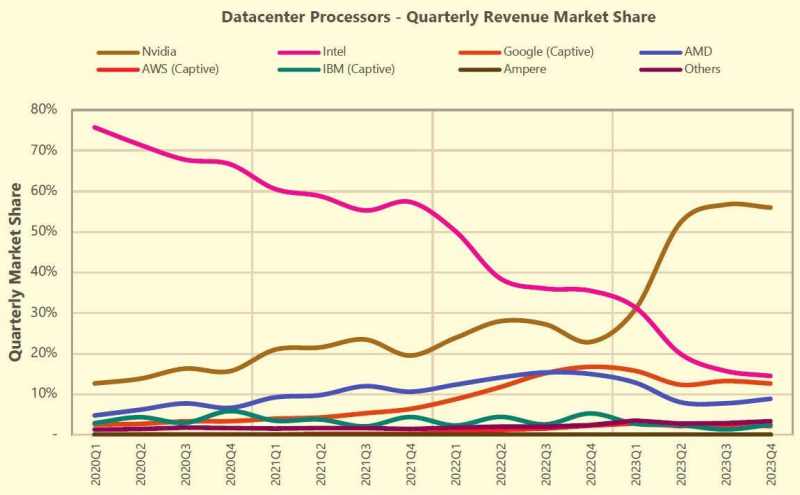

В прошлом месяце компания Google анонсировала долгожданный серверный CPU на архитектуре Arm. Впрочем, как сообщает The Register, она уже оказалась третьей на рынке процессоров для ЦОД (сюда входят не только CPU, но и GPU, TPU и иные ускорители). Согласно отчёту TechInsights, компания теперь уступает только NVIDIA и Intel и давно обогнала AMD. Как и другие крупные облачные операторы, IT-гигант выпускает собственные чипы TPU, шестое поколение которых было представлено на прошлой неделе. Хотя на сторону их не продают, компания заказывает огромные партии TPU для оснащения собственных ЦОД — только в прошлом году речь шла о 2 млн штук. Ключевым партнёром Google в создании кастомного «кремния» является Broadcom. Поставки TPU нарастают с каждым поколением, следуя за ростом самой компании. После премьеры TPU v4 в 2021 году в связи с развитием больших языковых моделей (LLM) объём полупроводникового бизнеса Google значительно вырос. TPU применяются компанией для внутренних задач, а ускорители NVIDIA — для облака. В TechInsights считают, что на сегодняшний день у Google имеется крупнейшая в отрасли база установленных ИИ-ускорителей и самая масштабная ИИ-инфраструктура. В прошлом году на серверным рынке произошла «масштабная коррекция запасов» — гиперскейлеры увеличили срок службы оборудования, отложив замену серверов общего назначения и повысив капитальные затраты на ИИ-серверы и ускорители NVIDIA. Аналитики Omdia говорят о таких тенденциях на рынке что в прошлом, что в начале этого года. В TechInsights считают, что по итогам I квартала 2024 года Google сможет догнать или даже перегнать Intel по доле на этом рынке. Конечно, Google — не единственная облачная компания, разрабатывающая собственные чипы. Microsoft работает над серверным CPU Azure Cobalt и ИИ-ускорителями Maia 100. AWS и вовсе годами использует собственные Arm-процессоры Graviton и ИИ-ускорители серий Trainium и Inferentia. В прошлогоднем докладе Bernstein Research сообщалось, что архитектуру Arm используют уже около 10 % серверов по всему миру, а более 50 % из них внедряется AWS. Softbank в начале 2023 года говорила о том, что Arm захватила 5 % облачного рынка. Впрочем, с появлением процессоров TPU V5e и TPU V5p решения Google будут использоваться всё шире из-за «взрывного роста» больших языковых моделей вроде Gemini. В 2024 году у Google появится Arm-процессор Axion. И его внедрение, по мнению TechInsights, будет происходить намного быстрее, чем Graviton, поскольку у Google уже имеется программная инфраструктура для такого чипа. Всё это необходимо компании, чтобы идти в ногу с AWS, Microsoft и, в меньшей степени, Alibaba. При этом в докладе упоминается, что рынок полупроводников для ЦОД быстро меняется — раньше на нём доминировала Intel с архитектурой x86. Теперь его структура определяется потребностями ИИ-систем. |

|