Материалы по тегу: llm

|

28.01.2024 [21:40], Сергей Карасёв

Google Cloud и Hugging Face упростят создание и внедрение генеративного ИИКомпании Google и Hugging Face объявили о новом стратегическом партнёрстве, которое позволит разработчикам использовать облачную инфраструктуру Google Cloud для всех сервисов Hugging Face. Инициатива нацелена на ускорение разработки приложений генеративного ИИ и инструментов машинного обучения. По условиям соглашения, Google Cloud становится стратегическим облачным партнёром Hugging Face, предоставляя ресурсы для обучения моделей и инференса. Разработчики смогут использовать ИИ-инфраструктуру Google Cloud, включая CPU, тензорные процессоры (TPU) и GPU, для обучения и обслуживания открытых моделей, а также для создания новых приложений генеративного ИИ. В частности, клиенты получат возможность обучать и настраивать модели Hugging Face с применением Vertex AI — комплексной ИИ-платформы Google Cloud. Разработчики смогут применять фирменные ИИ-ускорители Cloud TPU v5e. В будущем появится поддержка инстансов GCE A3 на базе NVIDIA H100. Говорится о поддержке развёртываний Google Kubernetes Engine (GKE). Для управления и выставления счетов на платформе Hugging Face может использоваться сервис Google Cloud Marketplace.

Источник изображения: pixabay.com Hugging Face, основанная в 2016 году, разрабатывает инструменты для создания приложений с использованием машинного обучения. В частности, она предлагает библиотеку Transformers для работы с ИИ-моделями. Ранее Hugging Face заключила соглашение о сотрудничестве с Dell: стороны помогут корпоративным клиентам в создании, настройке и использовании собственных систем на базе генеративного ИИ.

24.01.2024 [15:34], Руслан Авдеев

Oracle представила облачную ИИ-платформу OCI Generative AI, которая готова побороться с Microsoft Azure OpenAIOracle Corp. представила облачный сервис Oracle Cloud Infrastructure Generative AI (OCI Generative AI). Как сообщает пресс-служба компании, многочисленные инновации позволяют крупным компаниям применять новейшие достижения в сфере генеративного искусственного интеллекта для обучения собственных языковых моделей. Сервис позиционируется, как альтернатива решениям Azure OpenAI компании Microsoft. Сервис представляет собой решение, позволяющее бизнесам использовать большие языковые модели (LLM) вроде открытой Llama 2 или решения Cohere Inc., интегрируя их с существующими системами и данными клиентов. Благодаря этому последние смогут автоматизировать многие из процессов, выполнявшихся вручную. Сервис OCI Generative AI поддерживает более 100 языков и обеспечивает оптимизированное управление кластерами ускорителей. В Oracle уверены, что предлагаемые LLM помогут в генерации текстов, составлении резюме материалов и выполнении прочих задач, причём их можно будет интегрировать с уже существующими разработками. Корпоративные пользователи смогут безопасно дообучать модель на своих данных — пока проводится бета-тестирование с опцией тонкой настройки для получения ответов с учётом контекста. Сервис интегрируется с пакетом облачных бизнес-приложений Oracle, включая Oracle Enterprise Resource Planning, Human Capital Management, Supply Chain Management и Customer Experiences. Также будут расширены возможности платформы OCI Data Science, где в следующем месяце появится бета-версия функции AI Quick Actions, обеспечивающей доступ к различным моделям с открытым кодом без необходимости программирования. Это позволит клиентам строить, тренировать и внедрять LLM на основе открытого кода, а также управлять ими. В целом, Oracle ориентирована на предоставление готовых ИИ-сервисов и функций, взаимодействующих друг с другом для помощи клиентам в решении бизнес-задач. Oracle признаёт, что в сфере ИИ отстаёт от Microsoft, Google и Amazon, но возможность интеграции ИИ с ERP, HCM, SCM и CX-приложениями делает новые решения более привлекательными. При этом, по словам компании, у неё есть сразу несколько важных преимуществ перед конкурентами. Во-первых, производительная облачная СУБД, которой пользуются даже Microsoft и NVIDIA. Во-вторых, широкие инвестиции в облако, на что уходит до половины свободного денежного потока компании. В-третьих, решения Oracle для бизнеса обеспечивают уникальный опыт работы с ИИ, который не могут предложить конкуренты, сконцентрированные на PaaS и IaaS. Запуск новой службы должен помочь Oracle привлечь корпоративных клиентов. Кроме того, компания прилагает усилия для того, чтобы стать ключевым инфраструктурным игроком, обеспечивая доступ к передовым ускорителям NVIDIA. В декабре сообщалось, что компания построит 100 новых облачных ЦОД по всему миру. OCI Generative AI уже доступен в нескольких регионах Oracle Cloud, но может быть развёрнут и локально в рамках Dedicated Region.

23.01.2024 [16:27], Сергей Карасёв

«Ростелеком» внедрит российский ИИ для обработки звонков в контакт-центр«Ростелеком Контакт-центр», дочерняя структура «Ростелекома», объявил о внедрении большой языковой модели (LLM) в свою систему речевой аналитики. Ожидается, что ИИ-технологии помогут улучшить взаимодействие с клиентами и повысить эффективность обработки их обращений. В проекте участвует компания 3iTech — российский поставщик ИИ-решений для бизнеса. Модель 3iTechLLM ляжет в основу чат-ботов «Ростелекома», что, по заявлениям компании, сделает общение с роботом максимально похожим на разговор с человеком. Благодаря применению ИИ система речевой аналитики сможет автоматически оценивать звонки клиентов по чек-листам, хорошо понимать естественный язык и налету давать советы оператору. Кроме того, LLM позволит снизить нагрузку на обычных сотрудников, освободив их от формальных сценариев разговоров с клиентами. Это должно поднять качество обслуживания и обеспечить более высокий уровень комфорта для клиентов при решении тех или иных вопросов. ИИ также сможет более точно переадресовывать обращения профильным специалистам, если проблема не может быть решена автоматизированным способом.

Источник изображения: pixabay.com «Обращения клиентов теперь будут обрабатываться ещё более точно, но не менее человечно. Кроме того, прозрачность процессов даёт возможность для принятия оперативных бизнес-решений нашими заказчиками и партнёрами», — говорит генеральный директор «Ростелеком Контакт-центра». Отмечается, что применение LLM позволит частично решить проблему дефицита сотрудников контакт-центров. В 3iTech сообщили, что среди клиентов компании есть и другие операторы. В течение 2024 года 3iTech намерена вложить в исследования и разработки, связанные с LLM, около 100 млн руб.

14.01.2024 [21:18], Владимир Мироненко

Учёные ORNL сумели обучить LLM с 1 трлн параметров, задействовав всего 3072 ускорителя AMD Instinct MI250XКоманда специалистов Национальной лаборатории Ок-Ридж обучила большую языковую модель (LLM) с 1 трлн параметров на суперкомпьютере Frontier, используя лишь 3072 из имеющихся 37 888 ускорителей. LLM такого масштаба сравнима по возможностям с OpenAI GPT4. Кроме того, учёные смогли обучить LLM со 175 млрд параметров, задействовав всего лишь 1024 ускорителя. При обучении LLM с миллиардами параметров требуются значительные вычислительные ресурсы и большой объём памяти. Учёные ORNL занялись исследованием вопроса оптимизации этого процесса и изучили различные фреймворки, методы работы с данными и параллелизацией обучение, оценив их влияние на память, задержку коммуникаций и уровень эффективности использования ускорителей.

Источник изображения: ORNL Прорыва удалось достичь благодаря точной настройке гиперпараметров и оптимизации всего процесса обучения. Команда Frontier провела исчерпывающие тесты с различными параметрами, и в итоге стал возможен процесс обучения LLM с 1 трлн параметров с использованием всего 3 тыс. ускорителей AMD Instinct MI250X. Задача осложнялась тем, что для работы с ними используется ROCm, тогда как для подавляющего большинства ИИ-инструментов требуется поддержка NVIDIA CUDA. Результаты показали, что фактическая пропускная способность ускорителей составила 31,96 % для модели с 1 трлн параметров и 36,14 % для модели с 17 млрд параметров. Кроме того, для обеих моделей исследователи достигли 100-процентной эффективности слабого масштабирования и высокой эффективности сильного масштабирования: 89 % для модели со 175 млрд параметров и 87 % для модели с 1 трлн параметров. Впрочем, в исследовании не уточняется, сколько времени ушло на обучение этих моделей.

29.12.2023 [18:10], Руслан Авдеев

Reliance создаст индийскую языковую модель Bharat GPT и развернёт ИИ-экосистему Jio 2.0Глава индийской Reliance Jio Акаш Амбани (Akash Ambani) раскрыл планы компании на ближайшее будущее. По данным DigiTimes, компания намерена расширять работу над генеративными ИИ-решениями и, что не менее важно, обновить мобильную экосистему Jio, представив вариант 2.0, включающий продукты и сервисы на основе искусственного интеллекта. Как свидетельствует опрос, проведённый Automation Anywhere, 63 % индийских компаний инвестируют в ИИ и технологии машинного обучения для автоматизации собственных бизнес-процессов уже в ближайшие 12 месяцев. Рост инвестиций в ИИ-сектор составил 85 % год к году, а 33 % этих компаний полагаются на ИИ как на драйвер будущего роста.

Источник изображения: geralt/pixabay.com По информации индийских и зарубежных СМИ, на мероприятии IIT Bombay TechFest, проводившемся Индийским технологическим институтом Бомбея (IIT Bombay), компанией было объявлено о совместной разработке с институтом ИИ-проекта Bharat GPT. Преимущество Reliance Jio в её многопрофильности — это не просто телеком-оператор, но и поставщик потокового медиаконтента, оператор площадок для электронной коммерции и т.п. Сообщается, что Reliance планирует запустить ИИ-сервисы во всех сферах своей деятельности, включая медиа- и коммуникационные проекты, и даже внедрять их на предлагаемых компанией устройствах. Более того, по данным Амбани компания разрабатывает собственную ОС для смарт-телевизоров и уже обдумывает механизмы её внедрения. Более подробной информации об экосистеме Jio 2.0 бизнесмен не предоставил. Впрочем, о создании большой языковой модели и масштабной ИИ-инфраструктуры компанией Reliance совместно с NVIDIA сообщалось ещё в сентябре. По прогнозам экспертов EY India, генеративный ИИ, вероятно, совокупно добавит $1,2–1,5 трлн в ВВП страны в следующие семь лет. При этом в краткосрочной перспективе развитие отрасли, вероятно, столкнётся с проблемами из-за дефицита кадров.

18.12.2023 [16:20], Сергей Карасёв

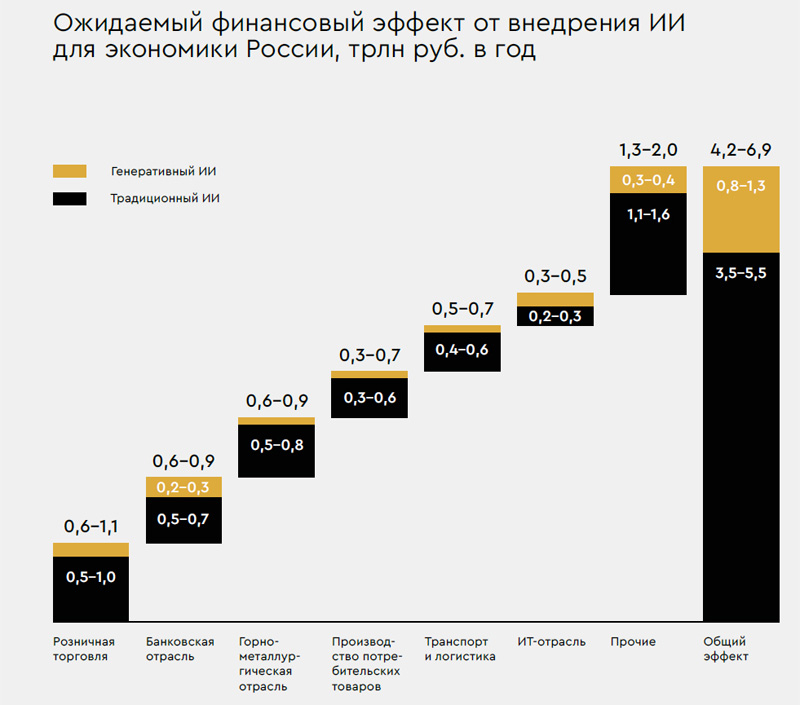

Каждая пятая крупная компания в России уже применяет генеративный ИИ, причём все они используют решения OpenAI«Яндекс» совместно с «Яков и Партнёры» опубликовал отчёт «Искусственный интеллект в России — 2023: тренды и перспективы». В документе рассматриваются состояние ИИ-рынка в России и мире, потенциальный экономический эффект от внедрения соответствующих технологий и ключевые тенденции. Отмечается, что ИИ занимает всё более значимое место в мировой экономике. По оценкам экспертов, потенциал влияния ИИ на экономику составляет $17–$26 трлн в год. При этом основная часть (около 70 %) приходится на внедрение традиционного ИИ (машинного обучения, глубокого обучения и продвинутой аналитики), оставшаяся часть в размере $6–$8 трлн в год — на генеративный ИИ. Общий объём глобальной отрасли ИИ в 2023 году, как полагают аналитики, составит приблизительно $185–$200 млрд, из которых около $30–$45 млрд придётся на генеративный сегмент (включая вычислительные мощности и услуги). Прогнозируется, что к 2028-му общий объём рынка составит от $860 млрд до $1,04 трлн, из которых сектор традиционного ИИ принесёт $690–$760 млрд, генеративного — $170–$280 млрд. Величина CAGR (среднегодовой темп роста в сложных процентах) в этих сферах ожидается на уровне 35–37 % и 43–45 % соответственно.

Источник изображения: «Яндекс» В России на сегодняшний день каждая пятая крупная компания (20 %) применяет генеративный ИИ для поддержания тех или иных бизнес-функций. Такие данные получены на основе опроса CTO 100 крупнейших предприятий и организаций в 15 ключевых для российской экономики индустриях. Около 12 % респондентов сообщили, что их компании уже определили приоритетные функции и сценарии для внедрения генеративного ИИ, а ещё четверть (около 27 %) — точечно экспериментируют с технологией. Решениями от OpenAI (GPT-4, GPT-3.5) пользуется все опрошенные российские компании, применяющие генеративный ИИ. Ещё примерно 80 % внедряют YandexGPT для решения задач по работе с текстами и более 40 % — Kandinsky для работы с изображениями. Чаще всего генеративный ИИ востребован в сферах маркетинга и продаж (66 % внедрений), клиентского сервиса (54 %), исследований и разработки (49 %), а также IT (31 %). По оценкам, полный экономический потенциал ИИ в России составляет 22–36 трлн руб. в номинальных ценах, а к 2028 году реализованный эффект на рост выручки и сокращение затрат компаний может достичь 4,2–6,9 трлн руб. Эффект от генеративного ИИ составит 0,8–1,3 трлн руб. (примерно 20%). Практически все опрошенные компании (94 %) отмечают сокращение затрат в качестве ключевого эффекта от внедрения ИИ в бизнес-процессы. Около трети компаний, работающих в потребительском секторе (банкинг, ретейл, медиа, телекоммуникации, электронная коммерция, ИТ), также ожидают, что ИИ способен увеличить выручку, повысить ценность продуктов для клиентов и, как следствие, лояльность последних.

14.12.2023 [14:53], Сергей Карасёв

Платформа Lightning AI Studios упростит создание и развертывание ИИ-приложенийКомпания Lightning AI, разработчик популярного фреймворка PyTorch Lightning, анонсировала платформу Lightning AI Studios, призванную упростить создание и развертывание ИИ-приложений. Решение предоставляет единую среду для подготовки данных, разработки моделей, распределённого обучения и пр. Новая платформа интегрирована с PyTorch Lightning: этот высокопроизводительный фреймворк, основанный на PyTorch, автоматизирует многие ручные задачи, связанные с разработкой ИИ-приложений. PyTorch Lightning также сокращает объём кода, который приходится писать разработчикам для использования различных аппаратных компонентов, таких как CPU и GPU.

Источник изображения: pixabay.com Благодаря Lightning AI Studios разработчики получают дополнительные инструменты, которые помогают интегрировать модели, созданные с помощью PyTorch Lightning, в полноценные и готовые к использованию ИИ-приложения. Запущенная платформа предоставляет все необходимые средства для реализации ИИ-проектов, говорят создатели. Таким образом, как утверждает Lightning AI, повышается скорость развертывания при одновременном снижении затрат — как для индивидуальных разработчиков, так и для корпоративных клиентов. Платформа Lightning AI Studios предоставляет готовые шаблоны для ускорения создания ИИ-моделей. Упомянута возможность масштабирования путём быстрого переключения с виртуальных машин на базе CPU на более мощные машины с GPU. Система также упрощает обучение больших языковых моделей (LLM) с нуля. Разработчики могут использовать Lightning AI Studios для точной настройки различных LLM, таких как Llama 2, Code Llama и Mistral 7B, на основе собственных данных. Клиенты могут создавать ИИ-продукты на базе облака AWS, которое используется по умолчанию, или же перейти на ресурсы в локальном дата-центре. Затраты отображаются в режиме реального времени, что позволяет эффективно масштабировать вычислительные мощности с учётом имеющегося бюджета.

14.12.2023 [00:49], Владимир Мироненко

ИИ-модель Gemini Pro появилась в Google Vertex AIGoogle объявила о доступности для разработчиков и компаний LLM Gemini Pro в Vertex AI, комплексной ИИ-платформе Google Cloud, включающей различные инструменты, полностью управляемую инфраструктуру и встроенные функции конфиденциальности и безопасности. С помощью Gemini Pro разработчики смогут создавать «агенты», способные обрабатывать входящую информацию и действовать на её основе. Vertex AI позволяет настраивать и развертывать Gemini Pro, обеспечивая возможность создавать новые и дифференцированные приложения, которые могут обрабатывать информацию в виде текста, кода, изображений и видео. Доступ к Gemini Pro осуществляется через Google AI Studio. Это бесплатный веб-инструмент, с помощью которого разработчики могут разрабатывать диалоговые системы, позволяющие тестировать и использовать модель. Даётся бесплатная квоту на обработку до 60 запросов в минуту. Впоследствии будет взиматься плата в размере $0,00025 за ввод 1000 символов или $0,0025 за ввод изображения и $0,00005 за вывод 1000 символов.

Источник изображения: geralt/Pixabay Google предлагает доступ к Gemini Pro, которая представляет собой текстовую модель с контекстным окном на 32 тыс. токенов, и к Gemini Pro Vision, которая принимает текст и изображения или видео в качестве входных данных и выводит текст. Модель поддерживает 38 языков и доступна в 180 странах. Google AI Studio позволяет экспортировать проделанную в работу в другие среды разработки, в том числе в Vertex AI. Для Gemini Pro также доступны комплекты разработки ПО, позволяющие создавать приложения с использованием Python, Node.js, Kotlin (Android), Swift (iOS) и JavaScript. По словам Google, одним из главных преимуществ Vertex AI с Gemini является то, что разработчики и корпоративные пользователи могут выполнять тюнинг моделей с использованием данных компании, а также дополнять их для генерации ответов в соответствии с особенностями стиля бренда или добавлять информацию в реальном времени из общедоступных и частных баз данных. Google также объявила об общедоступности Duet AI for Developers, набора вспомогательных ИИ-инструментов для дополнения и генерации кода. Ассистент Duet AI доступен в нескольких интегрированных средах разработки, используемых для написания, тестирования, компиляции и развёртывания кода: Cloud Shell Editor, Cloud Workstations, PyCharm и Visual Studio Code. Duet AI поддерживает более 20 языков программирования, включая C, C++, Go, Java, JavaScript и Python. В ближайшие недели Duet AI for Developers будет подключён к Gemini.

06.12.2023 [00:18], Руслан Авдеев

Индия намерена построить суверенную ИИ-инфраструктуруВ рамках масштабных инициатив, связанных с цифровизацией общества, Индия рассчитывает построить суверенную ИИ-инфраструктуру. Как сообщает Datacenter Knowledge, местные власти уверены в необходимости самостоятельного прогресса в данной сфере. По словам министра электроники Раджива Чандрасекара (Rajeev Chandrasekhar), стране необходим собственный независимый ИИ. Власти не готовы довольствоваться ИИ-экосистемой, управляемой Google, Meta✴, а также некоторыми индийскими стартапами и компаниями. Индия будет принимать участие в американских и европейских инициативах, параллельно разрабатывая собственную стратегию. В правительстве рассчитывают использовать новые технологии для социально-экономического развития. Идею в ходе недавнего визита в Индию поддержал глава IBM Арвинд Кришна (Arvind Krishna), который заявил, что каждая страна должна иметь определённый суверенитет в сфере ИИ, включая собственные большие языковые модели (LLM). Индия уже начала принимать меры по развитию собственных инициатив. Так, Министерство электроники и информационных технологий намерено предоставлять обезличенные данные из правительственных баз стартапам и научным организациям. Предполагается, что это будет способствовать совершенствованию системы управления и развитию экосистемы стартапов. Также рассматривается возможность получать по запросу массивы обезличенных данных и у IT-гигантов вроде Google и Meta✴. В последние годы Индия уделяет большое внимание строительству собственной цифровой инфраструктуры. В частности, она реализует крупные проекты т.н. «цифровой общественной инфраструктуры» (DPI) — вроде Aadhaar и Unified Payment Interface (UPI), вызывающие интерес далеко за пределами государства. Например, Aadhaar предполагает биометрическую идентификацию всех граждан Индии, а UPI представляет собой популярную платёжную платформу. Недавно Индия запустила и глобальный репозиторий Global Digital Public Infrastructure Repository (GDPIR) для объединения ресурсов и идей стран «большой двадцатки» G20 в области проектирования и создания DPI. Репозиторий объединяет программные решения и различные находки. Полученные решения и данные страна в числе прочего намерена использовать для создания «домашнего» ИИ, что поможет ей снизить зависимость от глобальных техногигантов.

04.12.2023 [09:36], Владимир Мироненко

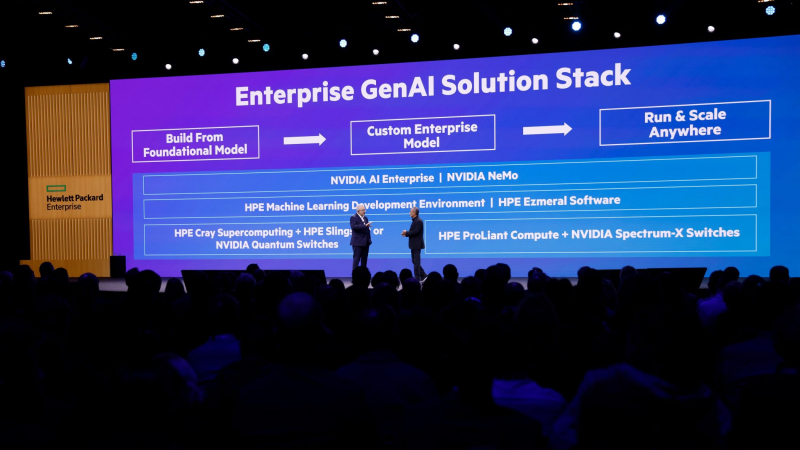

HPE и NVIDIA представили совместное решение для корпоративного ИИ, а HPE анонсировала LLM-платформу Project EthanHewlett Packard Enterprise (HPE) объявила о расширении стратегического сотрудничества с NVIDIA с целью создания инструментов для генеративного ИИ. Совместно разработанное, предварительно настроенное решение позволит предприятиям любого размера использовать собственные данные для быстрой настройки посредством RAG базовых ИИ-моделей, которые были обучены на больших наборах данных и могут быть адаптированы для выполнения различных задач от периферии до облака. HPE и NVIDIA также предоставляют в рамках сотрудничества полнофункциональные готовые решения для обработки приложений ИИ. Эти решения объединяют ПО фирменные среды разработки HPE для машинного обучения, HPE Ezmeral, платформы HPE ProLiant и HPE Cray, а также программный пакет NVIDIA AI Enterprise, включая NVIDIA NeMo. Аппаратная составляющая включает 16 серверов HPE ProLiant DL380a, несущих в общей сложности 64 ускорителя NVIDIA L40S и использующих DPU NVIDIA BlueField-3 и NVIDIA Spectrum-X.

Источник изображений: HPE Программно-аппаратный комплекс, например, позволяет дообучить на собственных данных модель Llama 2 с 70 млрд параметров. Решение включает ПО HPE Machine Learning Development Environment с новыми возможностями в области генеративного ИИ для быстрого прототипирования и тестирования моделей, а также ПО HPE Ezmeral с поддержкой ускорителей, которое упростит развёртывания и ускорит подготовку данных для ИИ-нагрузок в гибридном облаке. Партнёры HPE смогут заказать решение уже в I квартале 2024 года. Заодно HPE анонсировала платформу Project Ethan, ориентированную на оркестрацию ресурсов в локальных или публичных облаках для работы с большими языковыми моделями (LLM). Кроме того, компания сообщила, как планирует более полно адаптировать платформу Greenlake для работы с ИИ. Например, OpsRamp, ИИ-решение для управления ИТ-операциями (IT Operations Management, ITOM), приобретённое компанией в марте этого года, уже доступно по подписке в Greenlake. В OpsRamp добавлен HPE Sustainability Insight Center — инструмент для отслеживания и мониторинга энергопотребления ИТ-ресурсов, которыми управляет организация. Это было сделано для удобства клиентов, которые обучают и используют модели ИИ, и хотят контролировать потребление энергии. Обучение и инференс LLM, по словам компании, требует больших затрат электроэнергии — 1200 МВт·ч и 250 МВт·ч в день соответственно. Инструмент позволит управлять энергопотреблением с учётом возможностей компании. Также HPE представила пакет ПО Greenlake Hybrid Operations, объединяющий Ezmeral, OpsRamp с Sustainability Insight Center и набор решений для резервного копирования и восстановления HPE Data Protection Suite. Он позволит клиентам управлять, контролировать и защищать свои данные и рабочие нагрузки от периферии до облака.  В ближайшее время будет представлено и решение HPE Private Cloud Solutions для ИИ, основанное на аппаратных решениях HPE, обновлённой платформе HPE Greenlake for File Storage (эффективная ёмкость до 250 Пбайт, до 700 Гбайт/с на чтение и до 200 Гбайт/с на запись), OpsRamp и Zerto Cyber Resilience Vault. Последнее решение представляет собой автономную платформу для данных, которая помогает восстановить работу после атаки программы-вымогателя, если данные зашифрованы или удалены. Полная информация и даты доступности новых продуктов не разглашаются. Как сообщает ресурс The Register, решение объявить о них на мероприятии HPE Discover EMEA было принято в последнюю минуту. |

|