Материалы по тегу: cloud

|

11.05.2024 [00:11], Сергей Карасёв

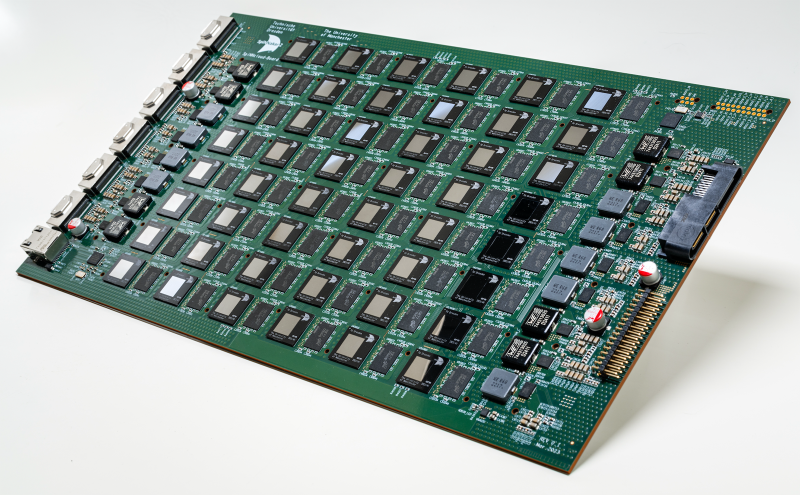

SpiNNcloud представила первый коммерческий «нейроморфный суперкомпьютер» SpiNNaker2 на базе ArmКомпания SpiNNcloud Systems анонсировала «нейроморфный суперкомпьютер» — гибридную высокопроизводительную вычислительную ИИ-систему, основанную, по словам компании, на принципах работы человеческого мозга. Утверждается, что это первое коммерчески доступное решение данного типа. Изделие базируется на архитектуре, разработанной Стивом Фербером (Steve Furber), одним из создателей оригинального процессора Arm. Идея заключается в применении большого количества маломощных чипов для более эффективной обработки ИИ-задач и других рабочих нагрузок. SpiNNaker2 представляет собой специализированную серверную плату с 48 чипами, каждый из которых насчитывает 152 ядра Arm. Таким образом, общее количество ядер составляет 7296. В состав чипов также входят различные дополнительные узлы, включая распределённые GPU-подобные блоки для ускорения обработки нейроморфных, гибридных и обычных моделей ИИ. В одну стойку могут монтироваться до 90 плат SpiNNaker2. Масштабирование осуществляется путём объединения таких стоек в кластер. В результате, как утверждается, возможно эмулирование в реальном времени как минимум 10 млрд взаимосвязанных нейронов. На операциях машинного обучения производительность может достигать 0,3 Эопс (1018 операций в секунду). Для сравнения — исследовательский нейроморфный компьютер Intel Hala Point поддерживает до 1,15 млрд нейронов и производительность до 30 Попс. От традиционных ИИ-платформ на базе GPU новое решение отличается универсальностью, говорит компания. Благодаря использованию многочисленных асинхронных блоков с низким энергопотреблением достигается более эффективное управление рабочими нагрузками. Со II половины 2024 года изделия SpiNNaker2 будут доступны в составе облачной платформы. В I половине 2025-го планируется организовать поставки самостоятельных систем. В число первых заказчиков SpiNNaker2 вошли Национальные лаборатории Сандия (Sandia National Laboratories), Технический университет Мюнхена (TUM) и Гёттингенский университет (Universität Göttingen).

09.05.2024 [23:56], Владимир Мироненко

Red Hat представила ИИ-дистрибутив RHEL AI, который требует минимум 320 Гбайт GPU-памяти

ibm

ibm cloud

linux

llm

open source

openshift

red hat

red hat enterprise linux

software

ии

разработка

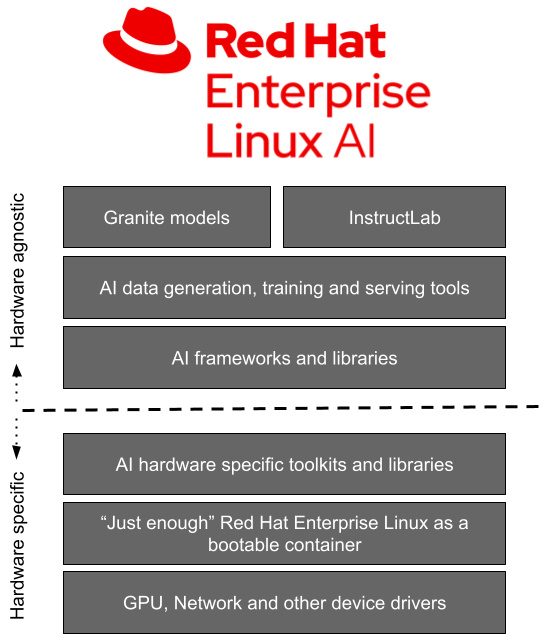

Red Hat представила Red Hat Enterprise Linux AI (RHEL AI), базовую платформу, которая позволит более эффективно разрабатывать, тестировать и запускать генеративные модели искусственного интеллекта (ИИ) для поддержки корпоративных приложений. Фактически это специализированный дистрибутив, включающий базовые модели, инструменты для работы с ними и необходимые драйверы.

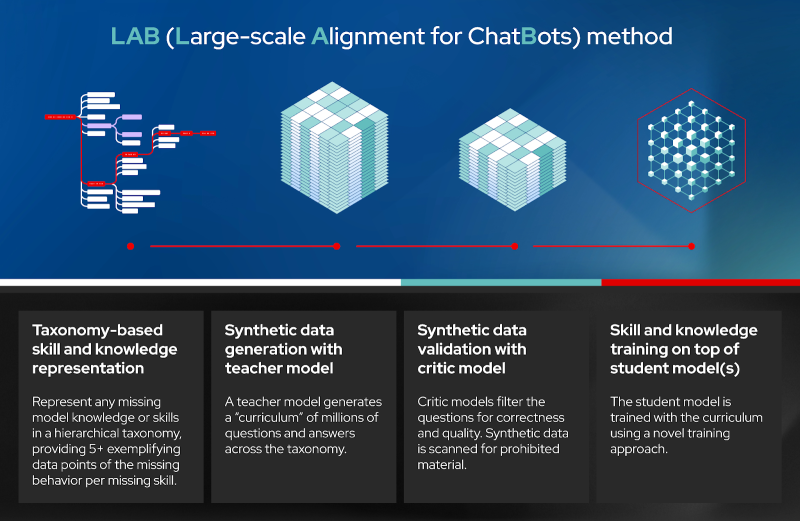

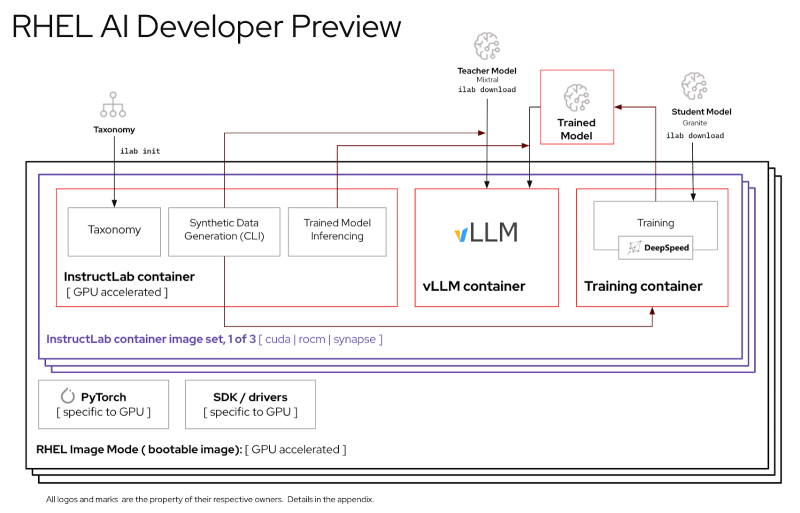

Источник изображений: Red Hat Доступная сейчас в качестве превью для разработчиков, платформа RHEL AI включает в себя семейство больших языковых моделей (LLM) IBM Granite, недавно ставших доступными под лицензией Apache 2.0, инструментом тюнинга и доработки моделей InstructLab посредством методики LAB (Large-Scale Alignment for Chatbots), а также различные библиотеки и фреймворки.  Решение представляется в виде готового для развёртывания образа и является частью MLOps-платформы OpenShift AI. По словам Red Hat, RHEL AI предоставляет поддерживаемую, готовую к корпоративному использованию среду для работы с ИИ-моделями на аппаратных платформах AMD, Intel и NVIDIA. По словам компании, open source подход позволит устранить препятствия на пути реализации стратегии в области ИИ, такие как недостаток навыков обработки данных и финансовых возможностей. Основная цель RHEL AI и проекта InstructLab — предоставить экспертам в предметной области возможность напрямую вносить свой вклад в большие языковые модели, используя свои знания и навыки. Новая платформа позволит им более эффективно создавать приложения с использованием ИИ, например, чат-боты. Впоследствии при наличии подписки RHEL AI компания предложит поддержку корпоративного уровня на протяжении всего жизненного цикла продукта, начиная с модели Granite 7B и ПО и заканчивая возможным возмещение ущерба в отношении интеллектуальной собственности. «Опираясь на инфраструктуру GPU, доступную в IBM Cloud, которая используется для обучения моделей Granite и поддержки InstructLab, IBM Cloud получит поддержку RHEL AI и OpenShift AI. Эта интеграция позволит предприятиям легче внедрять генеративный ИИ в свои критически важные приложения», — отметила компания. При этом прямо сейчас для запуска RHEL AI требуются весьма производительные сертифицированные системы с ускорителями, имеющими минимум 320 Гбайт памяти, а также хранилищем ёмкостью от 200 Гбайт. Среди протестированных указаны серверы Dell с четырьмя NVIDIA H100, Lenovo с восемью AMD Instinct MI300X, а также инстансы IBM Cloud GX3. Вскоре обещана поддержка инстансов AWS EC2 P5 с NVIDIA H100 и ускорителей Intel.

07.05.2024 [17:30], Руслан Авдеев

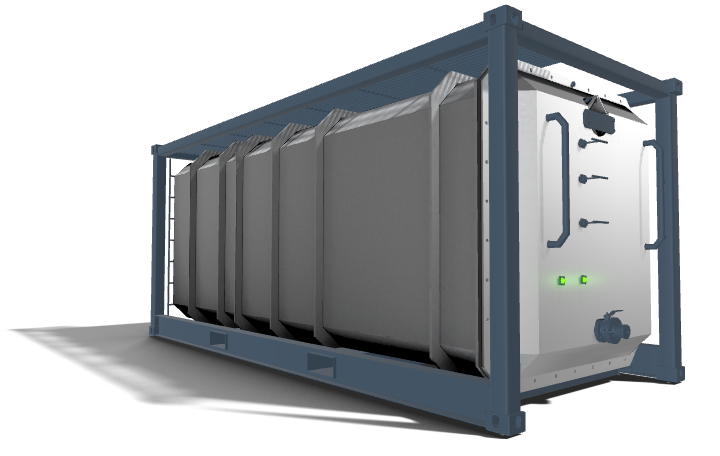

Subsea Cloud предложила протестировать её подводный дата-центр у берегов НорвегииОператор глубоководных дата-центров Subsea Cloud предложил потенциальным клиентам оценить возможности своего ЦОД в течение 90 дней. Как сообщает The Register, так компания пытается привлечь новых пользователей — если в последние три года дорогостоящие испытания проводились индивидуально, то теперь доступ к необычным дата-центрам упростится. В Subsea заявляют, её дата-центры имеют на 40 % меньше углеродных выбросов, а операционные расходы для клиентов на 30 % меньше в сравнении с наземными ЦОД. Наконец, затрат энергии и воды на охлаждение вовсе нет. Изюминка Subsea Cloud в том, что компания предлагает не просто подводные, а именно глубоководные (до 3000 м) решения. В 2022 году компания сообщала о внедрении первого коммерческого подводного проекта в районе Порт-Анджелеса (штат Вашингтон), дополнительные ЦОД планировалось развернуть в Мексиканском заливе и Северном море. В рамках Project OTTO компания предложит протетсировать возможности своего ЦОД недалеко от юго-западного побережья Норвегии. Первая фаза стартует в октябре. Участникам будут доступны тестовые периоди длительностью 30, 60 и 90 дней. При этом поучаствовать в тестировании можно только один раз — за исключением случаев, когда потенциальные клиенты захотят значительно изменить аппаратную составляющую своего оборудования, что потребует дальнейших тестов. О стоимости тестирования ничего не говорится, но компания предупреждает, что в случае отказать подписать соглашение о дальнейшем развёртывании мощностей продление тестирования не будет доступно. Базовый модуль Subsea Cloud представляет собой ёмкость размерами 6,1 × 2,6 м, практически тех же габаритов, что и стандартный 20-футовый контейнер — в нём можно разместить до 16 стоек мощностью до 150 кВт каждая (суммарно до 1,5 МВт) или 826 серверов. Для охлаждения используется погружная СЖО. Компания может предоставить клиентам и собственные серверы. В целом конфигурация ЦОД рассчитана на высокоплотное размещение энергоёмких систем, например, для ИИ- и HPC-нагрузок. Срок службы модуля составляет 25–30 лет.

Источник изображения: Subsea Cloud Подводные ЦОД пытаются внедрять не впервые. Microsoft в течение нескольких лет развивала Project Natick. Этот проект был признан успешным, но коммерциализировать компания его не стала в отличие от аналогичного проекта Highlander в Китае. Одним из сдерживающих клиентов факторов является отсутствие лёгкого доступа к оборудованию в подводных дата-центрах. По словам Subsea Cloud на то, чтобы добраться до модуля и заменить или обслужить серверы, уйдёт 4–16 часов. В Subsea Cloud рассчитывают на сотрудничество с офшорными ветряными электростанциями — это обеспечит подводным ЦОД удобный доступ к возобновляемой энергии. Кроме того, компания намерена подключать свои подводные кампусы непосредственно к подводным ВОЛС. При этом в компании подчёркивают, что общая стоимость обслуживания значительно ниже, чем у обычных ЦОД. Правда, сама же говорит, что экономически целесообразно развёртывание не менее 20 модулей.

30.04.2024 [13:02], Сергей Карасёв

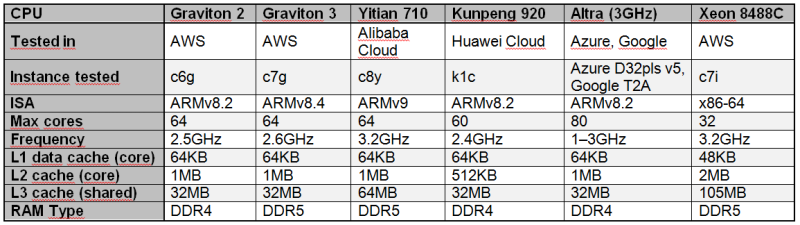

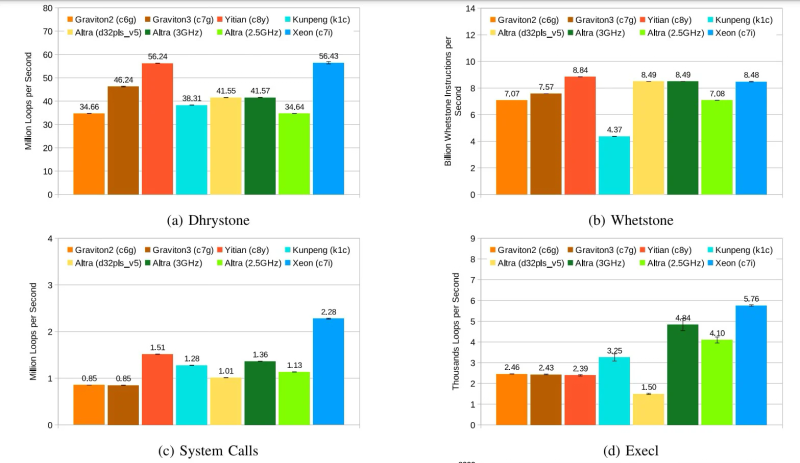

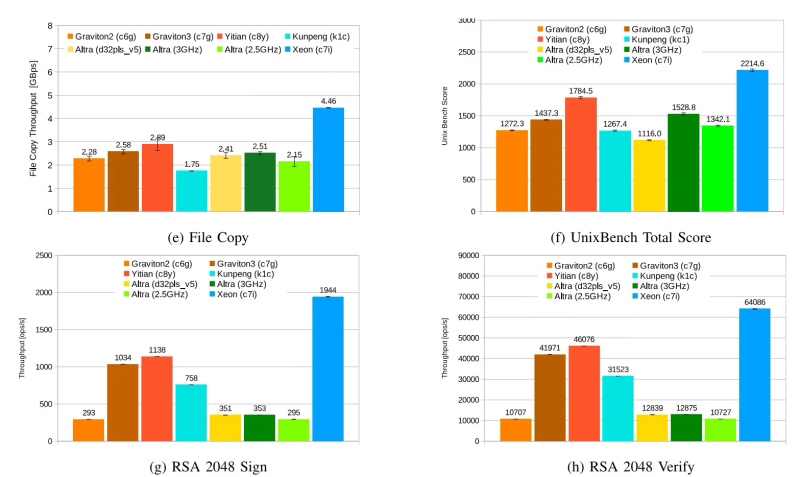

Alibaba Yitian 710 признан самым быстрым облачным Arm-процессором в ряде бенчмарковСогласно результатам исследования, обнародованным Институтом инженеров электротехники и электроники (IEEE) в журнале Transactions on Cloud Computing, процессор Alibaba Yitian 710 на сегодняшний день является самым производительным серверным чипом с архитектурой Arm из тех, которые доступны в составе различных облачных платформ, передаёт The Register. Изделие Yitian 710 было создано подразделением T-Head специально для нужд Alibaba Cloud и дебютировало в 2021 году. Этот 5-нм процессор на базе Armv9 насчитывает до 128 ядер с частотой до 3,2 ГГц. Обеспечивается поддержка восьми каналов памяти DDR5 и 96 линий PCIe 5.0. При этом чипы отличаются высокой энергетической эффективностью. Alibaba Cloud рассчитывала перенести пятую часть своих мощностей на собственные Arm-чипы к 2025 году. В ходе исследования чип Yitian 710 в конфигурации с 64 ядрами сравнивался с Arm-процессорами Amazon Graviton 2/3 (64 ядра), Huawei Kunpeng 920 (60 ядер) и Ampere Altra (80 ядер), а также с х86-чипом Intel Xeon Platinum 8488C поколения Sapphire Rapids. Тестирование проводилось в различных облачных средах, включая Amazon Web Services (AWS), Alibaba Cloud, Huawei Cloud, Microsoft Azure, Google Cloud Platform. Оценивалось быстродействие при выполнении различных задач: классические бенчмарки Dhrystone и Whetstone, ряд системных вызовов ядра и вызовов execl, скорость копирования файлов, показатель UnixBench, подписи и аутентификация с использованием криптографического алгоритма RSA 2048, а также работа с СУБД. Как отмечается, практически во всех перечисленных тестах процессор Alibaba опережал конкурирующие чипы с архитектурой Arm. В задачах Whetstone изделие Yitian 710 также превзошло процессор Xeon Platinum и чип Altra. Вместе с тем Graviton 3 показал превосходство в тесте Redis. Тем не менее, Yitian 710 сохранил своё преимущество в двух из трёх задач RocksDB. В плане эффективности чипам Arm требуется больше системных вызовов, чем их конкурентам Intel. Но в некоторых сценариях использования решения Arm всё равно оказываются более предпочтительными.

30.04.2024 [11:27], Сергей Карасёв

M1Cloud предложил частные облака для среднего и крупного бизнесаСервис-провайдер M1Cloud (Stack Group) анонсировал новую услугу, в рамках которой предприятиям среднего и крупного бизнеса предлагается построение частного облака на выделенном оборудовании. Сервис ориентирован прежде всего на те организации, которые переносят информационные системы из собственного дата-центра на облачную платформу. Новая услуга предполагает, что выделяемые ресурсы использует исключительно организация — заказчик. Это обеспечивает высокий уровень безопасности и гарантирует максимальную производительность, стабильность и надёжность работы IT-служб компании. «Частное облако гибко интегрируется в имеющийся IT-ландшафт. В ходе проработки архитектуры решения сервис-провайдер M1Cloud подбирает нужные технологии и сервисы, объём вычислительных ресурсов с учётом необходимой производительности и доступности данных», — говорит провайдер. В состав частного облака входит вычислительный кластер с серверами. Ещё один компонент — СХД с накопителями разного типа: это могут быть HDD с интерфейсом SATA/SAS, а также SSD. Администрирование и поддержка осуществляются экспертной технической службой M1Cloud. Дополнительно могут быть настроены аудит действий администратора и мониторинг инфраструктуры, шифрование накопителей, микросегментация сети для виртуальных машин и роутинг с существующей сетью организации. По желанию заказчика могут быть определены гранулярные права доступа и роли пользователей. Предусмотрены различные варианты маршрутизации сетей и портал для самостоятельной настройки резервного копирования. Отмечается, что частные облака формируются под конкретные задачи клиента, а архитектура таких решений максимально соответствует специфики операционных процессов и особенностям отрасли. В результате, заказчик получает наиболее эффективную облачную среду, оптимизированную с точки зрения оборудования и финансовых возможностей бизнеса.

29.04.2024 [20:11], Владимир Мироненко

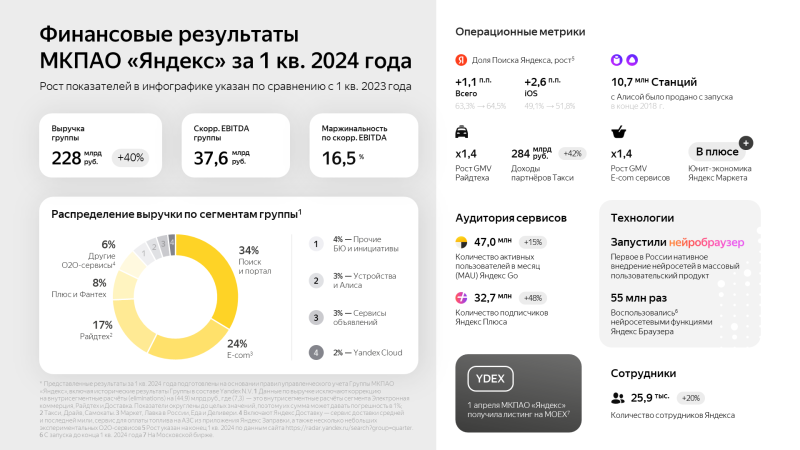

Выручка Yandex Cloud выросла в I квартале 2024 года на 58 % благодаря росту спроса на облачные сервисыМКПАО «Яндекс», российская частная независимая IT-компания, объявила неаудированные финансовые результаты за I квартал 2024 года. Выручка в I квартале 2024 года выросла на 40 % год к году до 228,3 млрд руб., чистая прибыль увеличилась на 47 % до 19,4 млрд руб. Ещё больше вырос скорректированный показатель EBITDA — на 107 % до 37,6 млрд руб. Также увеличился штат сотрудников компании, составивший на конец отчётного периода 25,9 тыс. человек, что на 20 % больше, чем годом ранее. Чтобы лучше отражать операционные показатели, начиная с I квартала 2024 года «Яндекс» внёс ряд изменений в структуру сегментов. Помимо, например, облачной платформы Yandex Cloud сегмент «Прочих бизнес-юнитов и инициатив» теперь включает направление разработки беспилотных автомобилей (Yandex SDG), «Яндекс 360», «Яндекс Образование» («Яндекс Практикум» и другие образовательные инициативы), «Устройства и Алису», «Финтех» (в том числе «Яндекс Пэй» и «Яндекс ID») и другие экспериментальные продукты, а также корпоративные расходы, не относящиеся к сегментам напрямую. В I квартале 2024 года этот сегмент принёс компании выручку в размере 22,8 млрд руб. (рост год к году на 69 %). Вместе с тем убыток по скорректированному показателю EBITDA составил 9,3 млрд руб., что на 64 % больше, чем в прошлом году. Рентабельность скорректированного показателя EBITDA/(убыток) равна −40,8 % (убыток на 1,2 п.п. меньше год к году). Как отмечено в пресс-релизе, рост выручки связан в основном с увеличением доходов направлений «Финтеха» и Yandex Cloud, а также «Устройств и Алисы». Выручка Yandex Cloud увеличилась на 58 % год к году благодаря расширению спектра предоставляемых услуг и увеличению доли на рынке на фоне растущего спроса на облачные сервисы «Яндекса». Рост убытка по скорректированному показателю EBITDA в абсолютных значениях в основном обусловлен инвестициями в рост бизнесов, а также увеличением нераспределённых корпоративных расходов, которые были частично скомпенсированы результатами Yandex Cloud. Убыток по скорректированному показателю EBITDA «Прочих бизнес-юнитов и инициатив» в проценте от выручки сегмента уменьшился на 1,2 п.п. благодаря улучшению операционной эффективности по ряду направлений, включая «Финтех».

24.04.2024 [23:45], Владимир Мироненко

NVIDIA приобрела за $700 млн платформу оркестрации ИИ-нагрузок Run:aiКомпания NVIDIA объявила о приобретении стартапа Run:ai из Тель-Авива (Израиль), занимающегося разработкой ПО для управления рабочими нагрузками и оркестрации на базе Kubernetes, которое позволяет более эффективно использовать вычислительные ресурсы при работе с ИИ-приложениями. Стоимость сделки не раскрывается. По данным TechCrunch, покупка обошлась NVIDIA в $700 млн. Это одно из крупнейших приобретений Nvidia с момента покупки Mellanox за $6,9 млрд в марте 2019 года. Два года назад NVIDIA купила Bright Computing, разработчика решений для управления НРС-кластерами. NVIDIA отметила, что развёртывание ИИ-приложениЙ становится всё более сложным. Оркестрация генеративного ИИ, рекомендательных и поисковых систем, а также других рабочих нагрузок требует сложного планирования для оптимизации производительности. ПО Run:ai позволяет управлять и оптимизировать вычислительную инфраструктуру как локально, так и в облаке или в гибридных средах.

Источник изображения: NVIDIA Созданная стартапом открытая платформа поддерживает все популярные варианты Kubernetes и интегрируется со сторонними инструментами и платформами ИИ. Компании из различных отраслей используют платформу Run:ai для управления кластерами ускорителей в масштабе ЦОД. Как сообщается, на относительно раннем этапе деятельности Run:ai удалось создать большую клиентскую базу из компаний из списка Fortune 500, что позволило привлечь венчурные инвестиции. Перед сделкой Run:ai привлекла капитал в размере $118 млн от ряда инвесторов, включая Insight Partners, Tiger Global, S Capital и TLV Partners. NVIDIA заявила, что в ближайшем будущем продолжит предлагать продукты Run:ai в рамках той же бизнес-модели, а также продолжит инвестировать в развитие Run:ai в рамках платформы NVIDIA DGX Cloud, предоставляющей корпоративным клиентам доступ к вычислительной инфраструктуре и ПО для обучения моделей генеративного и других форм ИИ. Решения Run:ai уже интегрированы с NVIDIA DGX, NVIDIA DGX SuperPOD, NVIDIA Base Command, контейнерами NGC, ПО NVIDIA AI Enterprise и другими продуктами. По словам NVIDIA, пользователи серверов и рабочих станций NVIDIA DGX, а также DGX Cloud также получат доступ к возможностям Run:ai, что особенно полезно при развёртывании генеративного ИИ в нескольких ЦОД.

11.04.2024 [17:57], Владимир Мироненко

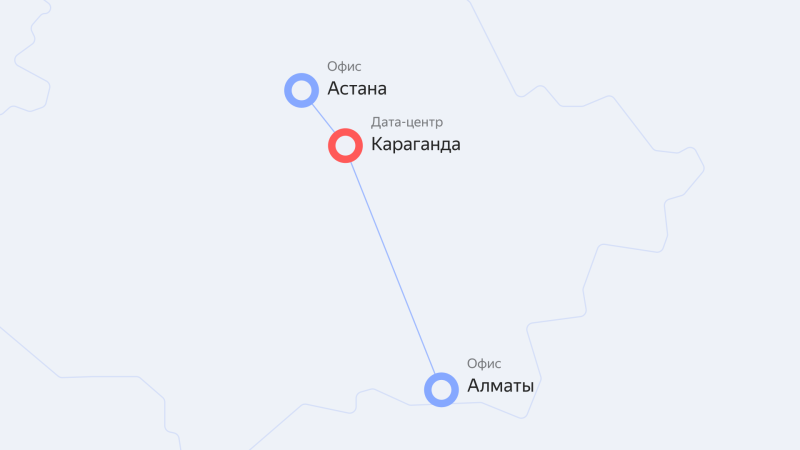

Yandex Cloud запустила облачные сервисы для пользователей в Казахстане и Центральной Азии на базе ЦОД в КарагандеОблачная платформа Yandex Cloud объявила о запуске нового региона kz1 на базе ЦОД в Казахстане, благодаря чему пользователям республики и Центральной Азии стал доступен широкий выбор облачных сервисов и технологий Yandex. Тарификация сервисов производится в тенге. А для развития IT-рынка в Казахстане компания выделила гранты 74 компаниям на сумму свыше 160 млн тенге в рамках программы Yandex Cloud Boost. Компании региона получили возможность использовать решения Yandex Cloud для хранения и обработки данных, технологии искусственного интеллекта (ИИ), машинного обучения, а также различные инструменты для разработки, тестирования и запуска собственных цифровых продуктов. ЦОД с серверной инфраструктурой находится в Караганде, а офисы компании — в Астане и Алматы. В казахстанском офисе работает команда технических специалистов и экспертов. С помощью сервиса распознавания и синтеза речи Yandex SpeechKit с поддержкой казахского и узбекского языков компании смогут создавать голосовых помощников и роботов для кол-центров. Также они смогут использовать решения для хранения, обработки и анализа данных, средства мониторинга и управления ресурсами облака, а также решения для обеспечения безопасности облачной инфраструктуры Yandex Cloud. Запуск нового региона выполнен в рамках долгосрочной стратегии развития Yandex Cloud в Казахстане и Центральной Азии. Как сообщает компания, её сервисы и решения уже используют в своей работе десятки казахстанских компаний крупного и среднего бизнеса, стартапы и организации государственного сектора, включая Kolesa Group, Technodom, Бухта, HR Messenger, TargetAI, 1Fit, Demetra и Rocket Firm.

08.04.2024 [22:49], Руслан Авдеев

Alibaba снизит стоимость облачных сервисов в попытке вернуть бизнес к ростуКитайский IT-гигант Alibaba Group Holding Ltd. инициировала масштабное снижение цен на свои облачные сервисы для клиентов по всему миру. По данным Bloomberg, речь идёт о дисконте до 59 % — ранее стоимость услуг уже была снижена в КНР в попытке потеснить локальных соперников и вернуть бизнес к росту. Новые меры совпали с ростом спроса на облачные вычисления для ИИ-решений, а также сложной внутренней реструктуризацией бизнеса компании. Её глава надеется придать второе дыхание основному бизнесу холдинга, включая, например, сегмент электронной коммерции. В своё время облачное подразделение отказалось от идеи отделиться и выйти на IPO, сославшись на трудности с получением необходимых ей чипов NVIDIA, а также растущую конкуренцию с китайской же Tencent Holdings Ltd. и рядом поддерживаемых государством облачных провайдеров.

Источник изображения: Alibaba В понедельник она снизила цены в среднем на 23 % на порядка 500 вариантов облачных продуктов. Такие дисконты теперь доступны в 13 регионах. На сегодня Alibaba Cloud является крупнейшим облачным провайдером в Китае, но на мировом рынке это сравнительно небольшой игрок, особенно на фоне AWS или Microsoft Azure. В последние годы компания потеряла часть позиций в Китае, уступив долю рынка окологосударственным бизнесам, а экономическая война США с Китаем помешала экспансии Alibaba за рубежом. Хотя в прошлом фискальном году выручка превысила $11 млрд, в I квартале этого года она, как ожидается, упадёт на 2 %. На прошлой неделе представители компании заявили, что ограничения на поставку чипов составляют большую проблему для китайских облачных провайдеров — запасов хватит на обучение больших языковых моделей (LLM) ещё в течение 12–18 мес., но ограниченный доступ к передовым ускорителям NVIDIA не может не сказаться на конкурентоспособности компании в среднесрочной перспективе, пока не появятся сильные альтернативы китайского производства. В Bloomberg считают, что снижение цен свидетельствует о желании поднять выручку, но не прибыльность в фискальном году, заканчивающемся в марте 2025-го. Рост EBITA на 2 п.п. год к году в тот же период оценивается экспертами как «чересчур оптимистичный» прогноз. Изменения на международном рынке последовали за февральским снижением цен на более 100 облачных предложений Alibaba в КНР, которое начало ценовую войну, поскольку конкуренты вроде JD тут же предложили собственные дисконты. Более того, это уже второе понижение цен Alibaba Cloud за последний год. Новые дисконты, в частности, ожидают существующих международных клиентов. Дополнительно компания обещает увеличить дисконты и улучшить другие условия для продавцов-посредников. Также ИИ-платформа PAI-Lingjun станет доступна в Сингапуре. В целом в Alibaba Cloud намерены не только смягчить условия для клиентов, но и дать понять, что компанией заложена основа для долгосрочного стратегического развития.

08.04.2024 [15:47], Андрей Крупин

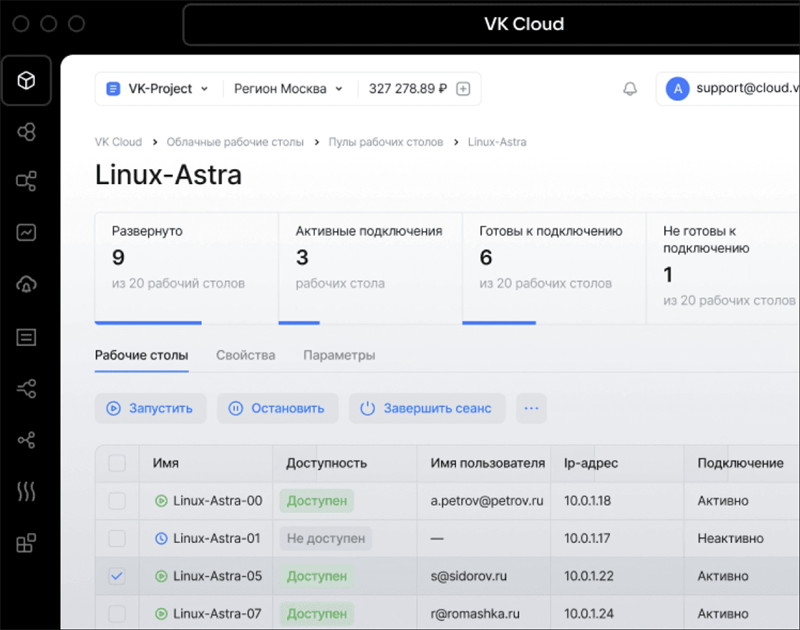

VK Cloud представила облачный сервис для создания виртуальных рабочих местОблачная платформа VK Cloud дополнилась сервисом Cloud Desktop, построенным на базе решения для удалённого доступа Termidesk компании «Увеон — облачные технологии» (входит в «Группу Астра»). Cloud Desktop относится к категории VDI-решений (Virtual Desktop Infrastructure) и предназначен для развёртывания инфраструктуры виртуальных рабочих мест и организации безопасной удалённой работы сотрудников. Продукт поддерживает интеграцию со службами каталогов Active Directory/OpenLDAP, включает средства разграничения прав доступа к пулам виртуальных рабочих столов для отдельных пользователей или их групп и позволяет объединить все корпоративные приложения компании в единую рабочую область, обеспечивая масштабирование и гибкость виртуальных рабочих мест сотрудников.  Предусмотрена поддержка Windows и Linux. Ограничений по приложениям нет — можно установить как стандартные, так и специализированные программы. Передача данных выполняется через протокол RDP. Системный администратор компании может централизованно управлять развёрнутой в облаке VDI-инфраструктурой, что упрощает настройку, техническую поддержку и работу с обновлениями. С помощью сервиса можно выделять вычислительные ресурсы, выбирать операционную систему и настраивать политики доступа, добавлять или отключать удалённых сотрудников. Шифрование и защищённый шлюз для подключения внешних пользователей обеспечивает безопасность работы сервиса. Обработка корпоративной информации разного уровня конфиденциальности происходит изолированно. Решение поддерживает регистрацию событий безопасности, защиту от несанкционированного копирования и потери данных. Данные размещаются на облачной платформе VK Cloud, инфраструктура которой соответствует требованиям 152-ФЗ по уровню защищённости УЗ-1. |

|