Компания NVIDIA представила микросервис NIM, входящий в платформу NVIDIA AI Enterprise 5.0 и предназначенный для оптимизации запуска различных популярных моделей ИИ от NVIDIA и её партнёров. NVIDIA NIM позволяет развёртывать ИИ-модели в различных инфраструктурах: от локальных рабочих станций до облаков.

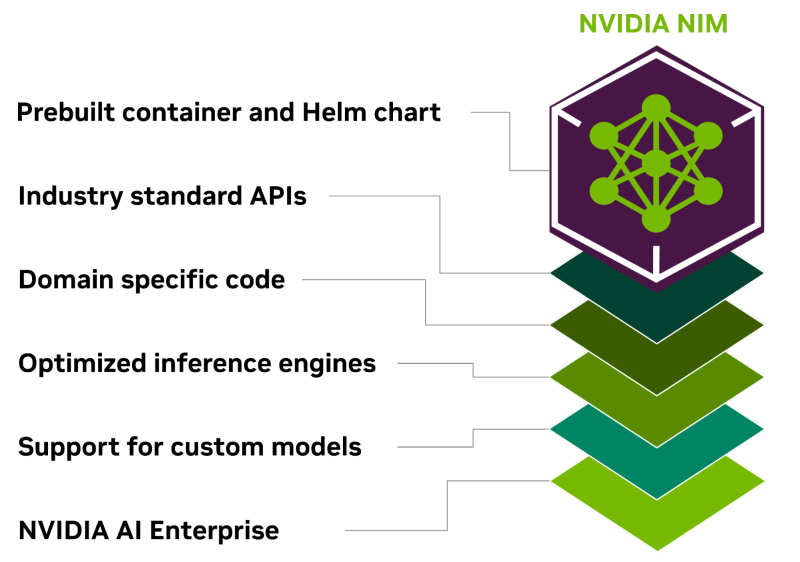

Предварительно созданные контейнеры и Helm Chart'ы с оптимизированными моделями тщательно проверяются и тестируются на различных аппаратных платформах NVIDIA, у поставщиков облачных услуг и на дистрибутивах Kubernetes. Это обеспечивает поддержку всех сред с ускорителями NVIDIA и гарантирует, что компании смогут развёртывать свои приложения генеративного ИИ где угодно, сохраняя полный контроль над своими приложениями и данными, которые они обрабатывают. Разработчики могут получить доступ к моделям посредством стандартизированных API, что упрощает разработку и обновление приложений.

NIM также может использоваться для оптимизации исполнения специализированных решений, поскольку не только использует NVIDIA CUDA, но и предлагает адаптацию для различных областей, таких как большие языковые модели (LLM), визуальные модели (VLM), а также модели речи, изображений, видео, 3D, разработки лекарств, медицинской визуализации и т.д. NIM использует оптимизированные механизмы инференса для каждой модели и конфигурации оборудования, обеспечивая наилучшую задержку и пропускную способность и позволяя более просто и быстро масштабироваться по мере роста нагрузок.

В то же время NIM позволяет дообучить и настроить модели на собственных данных, поскольку можно не только воспользоваться облачными API NVIDIA для доступа к готовым моделями, но и самостоятельно развернуть NIM в Kubernetes-средах у крупных облачных провайдеров или локально, что сокращает время разработки, сложность и стоимость подобных проектов и позволяет интегрировать NIM в существующие приложения без необходимости глубокой настройки или специальных знаний.

Источник: