Материалы по тегу: облако

|

03.12.2024 [09:00], Андрей Крупин

Экосистема «Базиса» стала основой первого в России облака КИИ

software

базис

виртуализация

импортозамещение

информационная безопасность

кии

облако

ростелеком

сделано в россии

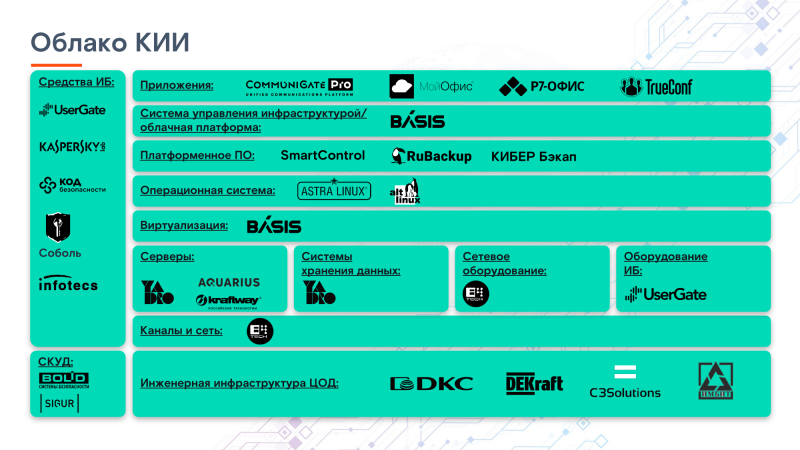

Решения виртуализации «Базис» стали основой «Облака КИИ» — первого на российском рынке защищённого облака, построенного на отечественных решениях и способным размещать объекты критической информационной инфраструктуры (КИИ). Решения были успешно проверены на совместимость с другими компонентами импортозамещённого облака: сетевым оборудованием, серверами и СХД, а также системным ПО, таким как российские ОС. Кроме того, клиентам «Облака КИИ» в ближайшее время станут доступны для использования и другие решения, входящие в экосистему «Базис»: платформа виртуализации рабочих мест Basis Workplace, DevOps-конвейер для организации полного цикла разработки и тестирования Basis Digital Energy, средство резервного копирования кластеров Kubernetes и виртуальных машин Basis Virtual Protect. «Облако КИИ» — первое в России мультитенантное защищённое облако, построенное на отечественных программных и аппаратных решениях, было запущено провайдером РТК-ЦОД в октябре текущего года. На данный момент это единственный такой продукт на рынке. Клиенты уже могут заказать IaaS-сервисы, т.е. разместить в облаке, например, системы геолокации и мониторинга, управления складом и логистики, аналитики производства, а также медицинские, банковские и другие ИС. На следующий год запланировано появление PaaS- и SaaS-сервисов. Безопасность «Облака КИИ» подтверждена аттестатом соответствия требованиям Приказа ФСТЭК №239, что позволяет размещать в нем объекты КИИ до 2 категории значимости включительно и обеспечивать защищённое подключение к нему пользователей. Вместе с тем данное облако аттестовано в соответствии с требованиями по обработке персональных данных 1 уровня защищённости, а также требованиями по защите информации государственных информационных систем 1 класса. Пользователями сервисов «Облака КИИ» в первую очередь могут быть организации-субъекты КИИ, но продукт также подойдёт крупным коммерческим компаниям, которые уделяют особое внимание защите своих информационных систем. «За последние два года количество атак на средний и крупный бизнес, даже не относящийся к КИИ, увеличивается на десятки процентов ежегодно. Причём растёт количество не только случаев кражи чувствительных сведений или кибервымогательства, но и диверсий, когда целью злоумышленников является уничтожение данных или нанесение максимального ущерба инфраструктуре компании-цели. Виртуализация является одним из ключевых слоёв современной инфраструктуры, поэтому мы уделяем максимум внимания безопасности экосистемы «Базиса» — внедряем лучшие практики безопасной разработки, тестируем продукты на уязвимости, сертифицируем их и регулярно проходим инспекционный контроль ФСТЭК. Уверен, именно эти усилия привели к тому, что экосистема «Базис» был выбрана для первого в России отечественного облака КИИ», — отметил Давид Мартиросов, генеральный директор «Базис». «Мы в РТК-ЦОД накопили огромный опыт в части хранения и обработки информации, а также обеспечения безопасности данных крупнейших государственных организаций и бизнеса. Объединив свой опыт с экспертизой наших партнёров, таких как «Базис», мы создали уникальный для российского рынка продукт. Альтернативой ему для бизнеса может быть самостоятельное создание защищённого частного облака, что потребует привлечения дорогостоящих специалистов, значительных вложений времени и ресурсов при отсутствии гарантии результата. Бизнес это понимает, и мы видим значительный интерес со стороны рынка, который уже превратился в первые успешные сделки», — прокомментировал Александр Обухов, директор по продуктам РТК-ЦОД. Продукт РТК-ЦОД «Облако КИИ» в 2024 году получил награду CNews Awards в номинации «Проект года», REFORUM AWARDS в номинации «Компания, которая поменяла рынок», а также премию «Приоритет 2024» за развитие технологического суверенитета России.

03.12.2024 [05:58], Руслан Авдеев

Сдайте ваши файлы: Amazon открыла в США пункты выгрузки данных в AWSAmazon представила сервис AWS Data Transfer Terminal — пункты, где можно быстро и безопасно выгрузить большие объёмы данных в облако AWS. Первые терминалы расположены в Лос-Анджелесе и Нью-Йорке, в будущем планируется добавить пункты приёма данных и в других локациях по всему миру. Использование пунктов AWS Data Transfer Terminal позволит значительно снизить время передачи данных (не считая времени на дорогу и обратно) в хранилища S3, EFS и др. Например, можно выгрузить большие датасеты от парка беспилотных машин, видеофайлы или картографические данные для дальнейшего анализа и обработки. Также с собой можно принести носители Snowball, хотя в целом AWS постепенно сворачивает сервисы Snow по физической доставке данных в облако. Список терминалов доступен в AWS Management Console, где можно заранее назначить дату и время визита и вписать участников. В назначенный час сотрудник AWS проверит документы и проводит до отдельной комнаты, где есть патч-панель, оптоволоконный кабель и ПК. Патч-панель интегрирована в небольшую стойку, а компьютер можно использовать для контроля процесса передачи данных. Примечательно, что в целях безопасности на зданиях и в помещениях нет никаких символов AWS. Плата за гигабайты не предусмотрена, вместо этого платить придётся за время загрузки в регионы AWS. При этом доступны только те регионы, которые находятся на том же континенте, где и пользователь.

02.12.2024 [21:29], Руслан Авдеев

Google предлагала европейским облакам миллионы евро для продолжения борьбы с MicrosoftСогласно закрытым документам, тексты которых попали в распоряжение The Register, в своё время Google Cloud предлагала «финансовые стимулы» на сотни миллионов евро для организации европейских облачных провайдеров CISPE, жаловавшихся регуляторам на Microsoft. Как свидетельствуют источники, представитель Google общался как с руководством группы, так и со всему участниками организации CISPE. В ходе одной из презентаций предлагалось создать для участников организации Фонд инноваций в объёме €4 млн, который использовался бы для финансирования проектов и лицензионных сборов участников CISPE, для поддержки инноваций в открытых облачных экосистемах. На каждого участника пришлось бы порядка €100 тыс. — сейчас в CISPE 36 членов, в том числе Oxya, Leaseweb, UpCloud и даже AWS, единственная «неевропейская» компания. Ещё в июле группа включала лишь 27 компаний. Дополнительно Google предложила выделить CISPE ещё €10 млн в качестве «ресурсов на участие и членство». Наконец, Google предложила участникам CISPE кредиты на использование Google Distributed Cloud в размере €100 млн в течение пяти лет. При этом в презентации подчёркивалось, что фонд инноваций и программная платформа будут доступны действующим членам CISPE с условием «сохранения организацией неограниченных возможностей в продвижении принципов справедливого ПО».

Источник изображения: David Clode/unsplash.com Предполагается, что предложение было сделано с целью убедить участников CISPE не отказываться от жалоб на Microsoft, связанных с политикой лицензирования последней, которая делает использование продуктов редмондского гиганта в чужих облаках неоправданно дорогим. Жалобу подали в ноябре 2022 года, но позже Microsoft небезвозмездно уговорила большинство участников CISPE (кроме гиперскейлеров) отказаться от претензий — о попытках Google остановить этот процесс сообщалось ранее. Правда, в самой Google заявляют, что жалоба и финансовые стимулы с её стороны никак не связаны. Несмотря на отчаянные попытки Google, CISPE приняла решение отказаться от тяжб с Microsoft. По слухам, последняя потратила на улаживание претензий €10–€30 млн. При этом членам CISPE станет доступно решение Azure Local (Stack HCI) для развёртывания облака на базе собственной инфраструктуры. Источники в CISPE сообщают, что устали бороться с Microsoft и хотят просто решить проблему лицензирования, а не начинать новую войну, навязываемую Google. Microsoft, вполне возможно, тоже так или иначе заплатила участникам CISPE за отказ от преследования. Сама Google создала Open Cloud Coalition (OCC), в которую входят преимущественно небольшие британские облачные операторы и один испанский провайдер. Microsoft уже назвала группу «искусственным газоном, созданным Google» для дискредитации компании и введения регуляторов в заблуждение. OCC заявляет, что выступает за открытые стандарты и против ограничительного лицензирования и иных барьеров, мешающих конкуренции и инновациям — в Google обеспокоены тем, что массовый переход в облако Microsoft фактически лишает её клиентов. OCC можно использовать для лоббирования и жалоб в Управлении по конкуренции и рынкам Великобритании (CMA). В Евросоюзе Google также подавала жалобу на антиконкурентные практики и доминирование Microsoft в сфере облачного ПО в сентябре. Впрочем, большую часть облачного рынка Европы и так занимают AWS, Microsoft и Google. По данным Synergy Research, во II квартале 2024 года расходы на облачный рынок в Европе составили $16 млрд. На долю AWS пришлось 32 % рынка, Microsoft — 26 %, а на Google — 15 %. Крупнейшие конкуренты Microsoft называют политику лицензирования её ПО несправедливой. Так, за использование Windows Server вне Azure обходится вчетверо дороже. Тем не менее, по словам представителя CISPE, общавшегося с The Register, участники организации проголосовали за предложения Microsoft, оптимальные для европейского облачного сектора. Ранее представитель Google уклонился от прямого ответа на вопрос о том, предлагала ли компания заплатить участникам CISPE за продолжение тяжбы с Microsoft. Ранее топ-менеджмент Google официально заявлял, что оплата не предлагалась.

02.12.2024 [11:46], Сергей Карасёв

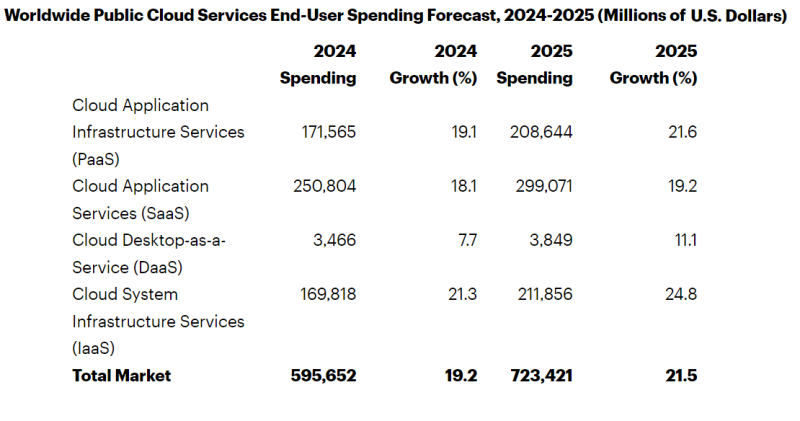

Gartner: затраты на публичные облака в мире в 2025 году достигнут $723 млрдКомпания Gartner обнародовала прогноз по мировому рынку публичных облачных услуг на 2025 год. Отрасль демонстрирует стремительный рост на фоне продолжающегося развития ИИ-приложений, включая генеративные сервисы. Аналитики учитывают затраты на платформы SaaS, IaaS и PaaS, а также DaaS (десктоп как сервис). По оценкам, в 2024-м объём отрасли достигнет $595,7 млрд, показав прибавку на уровне 19,2 % по отношению к предыдущему году. При этом наибольшую выручку обеспечит сектор SaaS — $250,8 млрд. Ещё приблизительно $171,6 млрд придётся на PaaS, около $169,8 млрд — на IaaS. Наименьший вклад внесёт DaaS-направление с расходами $3,5 млрд. В 2025 году, по мнению специалистов Gartner, отрасль продемонстрирует рост на 21,5 %: выручка поднимется до $723,4 млрд. Доминирующим сегментом останется SaaS с прибавкой на уровне 19,2 % в годовом исчислении и результатом примерно $299,1 млрд. Максимальные темпы роста прогнозируются в секторе IaaS — плюс 24,8 % год к году. В результате, выручка от этих услуг достигнет $211,9 млрд. Причём сегмент IaaS по денежным поступлениям опередит сферу PaaS, где выручка ожидается на уровне $208,6 млрд с ростом на 21,6 % по отношению к 2024-му. В области DaaS увеличение составит около 11,1 % — до $3,8 млрд. В Gartner также говорят о росте популярности концепции CIPS — Cloud Infrastructure and Platform Services. Речь идёт о полнофункциональной платформе, предоставляющей IaaS и PaaS в виде интегрированных облачных сервисов. Аналитики прогнозируют, что расходы конечных пользователей на CIPS поднимутся на 24,2 % в 2025 году и достигнут $301 млрд. Ожидается, что в 2025 году предложения CIPS составят 72 % суммарных затрат на IaaS и PaaS по сравнению с 70 % в 2022 году.

02.12.2024 [11:28], Сергей Карасёв

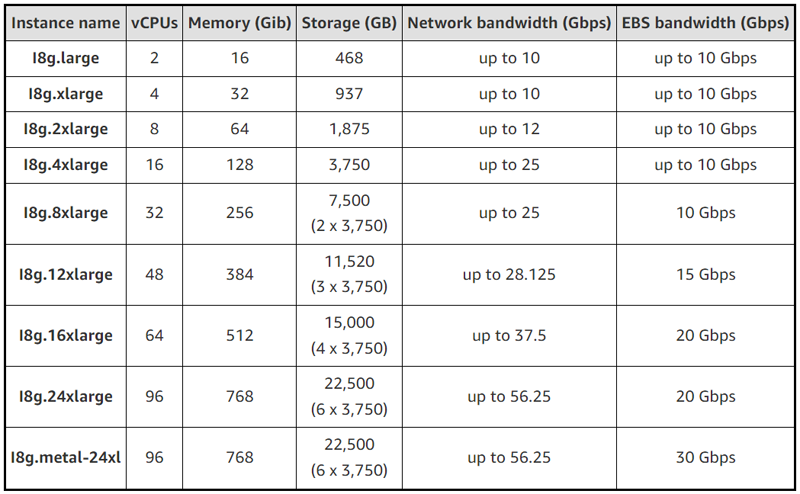

AWS запустила инстансы EC2 I8g с собственными процессорами Graviton4 и накопителями Nitro SSDОблачная платформа Amazon Web Services (AWS) анонсировала инстансы EC2 I8g, оптимизированные для хранения данных. Утверждается, что по сравнению с решениями предыдущего поколения EC2 I4g достигается прирост производительности на операциях хранения в реальном времени до 65 % в расчёте на 1 Гбайт. Инстансы EC2 I8g базируются на фирменных процессорах Graviton4, насчитывающих до 96 ядер Arm. Кроме того, впервые применены накопители AWS Nitro SSD третьего поколения, которые изготавливаются по индивидуальному заказу Amazon. Эти устройства, как утверждается, обеспечивают высокую производительность ввода-вывода, низкую задержку, минимальную изменчивость задержки и безопасность благодаря шифрованию. В зависимости от модификации инстансы EC2 I8g предлагают от 2 до 96 vCPU, а объём памяти варьируется от 16 до 768 ГиБ. Вместимость хранилища составляет от 468 Гбайт до 22,5 Тбайт. Пропускная способность сетевого подключения находится в диапазоне от 10 Гбит/с до 56,25 Гбит/с, пропускная способность EBS-томов — от 10 до 30 Гбит/с.

Источник изображения: AWS Отмечается, что инстансы I8g предназначены для рабочих нагрузок с интенсивными IO-операциями, требующими доступа к информации с минимальными задержками. Это могут быть различные базы данных, включая платформы реального времени (MySQL, PostgreSQL, Aerospike, Apache Druid, MongoDB), а также аналитика реального времени. Задействована система AWS Nitro, которая переносит функции виртуализации, хранения и сетевые операции на выделенное оборудование и ПО для повышения производительности и улучшения безопасности. Говорится о совместимости с Amazon Linux 2023, Amazon Linux 2, CentOS Stream 8 или новее, Ubuntu 18.04 или новее, SUSE 15 SP2 или новее, Debian 11 или новее, Red Hat Enterprise 8.2 или новее, CentOS 8.2 или новее, FreeBSD 13 или новее, Rocky Linux 8.4 или новее, Alma Linux 8.4 или новее и Alpine Linux 3.12.7 или новее.

01.12.2024 [11:08], Сергей Карасёв

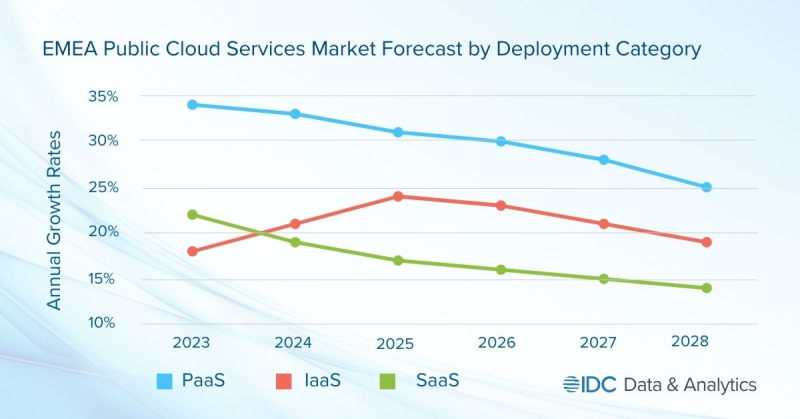

Объём рынка публичных облаков в регионе EMEA в 2024 году превысит $200 млрдКомпания International Data Corporation (IDC) обнародовала прогноз по рынку публичных облачных услуг в регионе EMEA, который включает Европу, Ближний Восток и Африку. Отрасль демонстрирует стремительный рост, что объясняется быстрым внедрением ИИ, в то числе сервисов генеративного ИИ, а также расширением инфраструктур ведущих облачных провайдеров. По оценкам, в 2024 году объём отрасли превысит $200 млрд, достигнув приблизительно $203 млрд. Аналитики IDC учитывают затраты в области публичных услуг SaaS, PaaS и IaaS. Первый из этих сегментов, который включает SaaS-приложения и SaaS-SIS (SaaS в области системных инфраструктур), обеспечивает наибольшую выручку — 64,4 % в общем объёме рынка ЕМЕА. Отмечается, что из-за своего размера и зрелости SaaS демонстрирует самые медленные темпы роста среди облачных услуг всех типов. Наиболее высокий показатель CAGR (среднегодовой темп роста в сложных процентах) прогнозируется в категории PaaS — 29,3 % в период 2023–2028 гг. В сегменте IaaS это значение ожидается на уровне 21,6 %. С субрегиональной точки зрения Западная Европа доминирует на рынке EMEA с долей около 80 % в общем объёме рынка. Далее следуют Ближний Восток и Африка (MEA), а также Центральная и Восточная Европа (CEE). Основные инвестиции в сегменте публичных облаков приходятся на Германию, Великобританию, Францию и Италию. Ключевыми игроками в регионе являются Google, Amazon, Microsoft и Oracle. Аналитики IDC считают, что глобальные технологические компании продолжат вкладывать средства в ИИ, что обеспечит дальнейший рост рынка. Величина CAGR в регионе EMEA прогнозируется на уровне 20,0 %: таким образом, к 2028-му затраты могут подняться до $415,1 млрд.

30.11.2024 [22:26], Владимир Мироненко

HPE VM Essentials упростит работу в облаке HPE GreenLake и может использоваться на сторонних платформах

hpe

hpe greenlake

software

виртуализация

гибридное облако

конфиденциальность

миграция

облако

частное облако

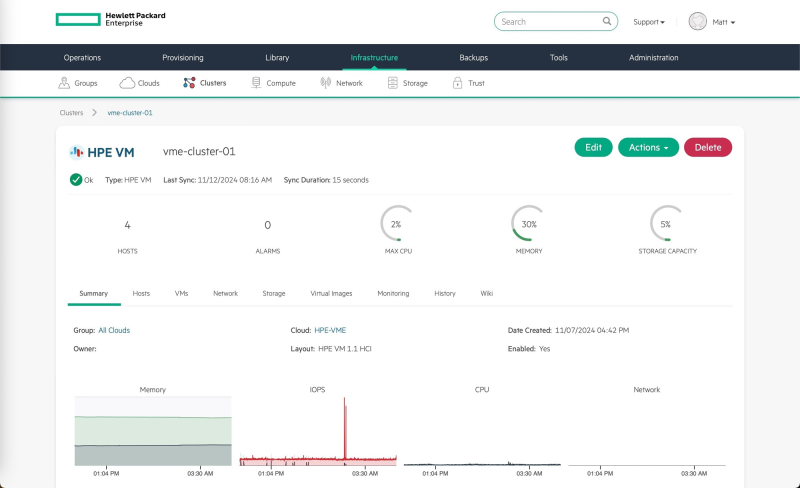

Компания Hewlett Packard Enterprise (HPE) объявила о ключевых усовершенствованиях в облаке HPE GreenLake, благодаря которым упрощается управление в сложных, гетерогенных гибридных ИТ-средах. В числе представленных HPE новинок — VM Essentials, ПО для управления виртуальными машинами, которое также можно использовать для управления виртуальными средами на основе KVM и VMware. Гипервизор HPE VM Essentials (HPE VME) поддерживает ведущие протоколы хранения, распределённое размещение рабочих нагрузок, высокую доступность, живую миграцию и интегрированную защиту данных. Благодаря усовершенствованию облака HPE GreenLake и ПО HPE VM Essentials предприятия могут пятикратно снизить совокупную стоимость владения, утверждает компания. Сообщается, что HPE VM Essentials снижает затраты для клиентов за счёт экономически эффективного ценообразования на сокет и встроенной поддержки обнаружения существующих виртуальных машин, а также предоставления виртуальных машин как услуги. ПО может интегрировать существующие кластеры гипервизоров клиентов для обеспечения управления и контроля над виртуальными машинами, в том числе на базе KVM, с помощью одного простого интерфейса, а также базового преобразования образов ВМ в HPE VM Essentials. HPE VM Essentials предлагается как часть HPE Private Cloud и как отдельная программа.

Источник изображений: HPE Для ревиртуализации и управления HPE использует гибридное облачное решение компании Morpheus Data, которую HPE приобрела в прошлом году. HPE отметила, что поглощение Morpheus Data позволило ещё больше унифицировать и упростить ИТ-операции для клиентов в облаке HPE GreenLake. HPE VM Essentials — это первый шаг к использованию Morpheus во всём портфеле решений HPE, сообщила она, добавив, что клиенты могут гибко управлять существующими виртуализированными рабочими нагрузками или переходить на гипервизор HPE VME с простым лицензированием виртуальных машин в обоих стеках. «Теперь, независимо от того, где работает VM Essentials, будь то частное облако, наше оборудование или стороннее оборудование, благодаря Morpheus мы можем позволить нашим клиентам управлять всеми этими виртуальными машинами в единой плоскости управления с помощью Morpheus Data», — заявил Ханг Тан (Hang Tan), главный операционный директор подразделения Hybrid Cloud. VM Essentials поддерживает собственное ПО HPE, включая Zerto, OpsRamp и Cloudphysics, а также внешние инструменты резервного копирования и восстановления от Cohesity и Commwall. С запуском VM Essentials компания HPE ориентируется на клиентов, недовольных повышением цен VMware. Почти половина из них сообщила об удвоении цен, а 15 % — о десятикратном увеличении. Другие компании, такие как Nutanix и Veeam, также ранее расширили свои портфели, чтобы привлечь клиентов VMware. При этом, как сообщает ITPro, Ульрих Зайбольд (Ulrich Seibold), вице-президент по глобальным продажам партнеров и поставщиков услуг HPE GreenLake, заявил следующее: «Мы не позиционируем VM Essentials как инструмент или ПО, конкурирующее с Broadcom. Во все наши продукты включены сервисы Broadcom, и у нас с ними прочные партнёрские отношения. Но могут быть области или среды, где у партнёров или клиентов есть бюджетные ограничения или они не хотят получать полную скорость — для них вполне достаточно виртуальной машины». Сообщается, что HPE VM Essentials в качестве отдельного приложения станет общедоступным в декабре. Оно будет сертифицировано для работы с последними версиями HPE ProLiant Compute и HPE Alletra Storage. Ожидается, что HPE VM Essentials с HPE Private Cloud Business Edition станет общедоступным весной 2025 года. HPE также представила HPE Private Cloud Enterprise Disconnected и HPE Alletra Storage MP Disconnected — решения для изолированного частного облака и блочных СХД, которые обеспечивают облачный опыт с автономным управлением. Для клиентов GreenLake Cloud это означает возможность его использования в изолированном режиме без подключения к интернету. HPE стремится удовлетворить повышенные требования организаций к безопасности. Крупные клиенты получат индивидуальные предложения для особых требований. А авторизованные партнёры HPE Partner Ready Vantage смогут предоставлять услуги суверенного частного облака на базе HPE GreenLake. В Европе партнёры смогут предлагать возможности суверенного облака, соответствующие местным, региональным и отраслевым нормам.

29.11.2024 [10:22], Владимир Мироненко

«РТК-ЦОД» запустил в работу обновленный сервис BareMetal 2.0 с ускорителями NVIDIAСервис-провайдер «РТК-ЦОД» (дочерняя компания «Ростелекома», предоставляющая услуги дата-центров и облачные услуги) объявил о запуске обновлённого сервиса BareMetal 2.0 с GPU-ускорителями. Как сообщает «РТК-ЦОД», сервис BareMetal 2.0 обеспечивает максимально эффективное использование вычислительных ресурсов, в том числе, с помощью интеграции физических серверов в единую сеть с виртуальной облачной инфраструктурой. Это дает возможность выстраивать гибридные IaaS-решения для повышения производительности и масштабируемости. По словам компании, обновлённый сервис идеально подходит для задач, требующих максимальной производительности: от анализа данных и машинного обучения до научных исследований и обработки графики. Согласно пресс-релизу, работу BareMetal 2.0 обеспечивают выделенные серверы без виртуализации, предоставляемые в составе «Публичного облака». Доступные конфигурации включают процессоры с частотой 2,6 и 3,0 ГГц, поддержку до 48 ядер и объём оперативной памяти до 1024 Гбайт с возможностью использования высокоскоростных сетевых SSD для хранения данных. В обновлённом сервисе для работы с графикой, 3D-моделированием, рендерингом, интенсивными вычислительными задачами можно выбрать сервер с ускорителями NVIDIA L4 (24 Гбайт), RTX A6000 (48 Гбайт) или A100 (80 Гбайт). Клиентам доступен выделенный менеджер и команда архитекторов, которые помогут адаптировать решение под индивидуальные задачи. BareMetal 2.0 и другие облачные сервисы РТК-ЦОД можно самостоятельно настроить через единый портал, а также использовать инструменты для удалённого управления.

28.11.2024 [10:00], Андрей Крупин

Selectel подтвердил соответствие государственному стандарту безопасности для организаций финансовой сферы и обновил действующие сертификаты безопасностиSelectel, крупнейший независимый провайдер сервисов IT-инфраструктуры в России, подтвердил соответствие продуктов требованиям ГОСТ Р 57580, который определяет требования по информационной безопасности для организаций финансовой сферы, и обновил сертификат международного стандарта безопасности данных платёжных карт до версии PCI DSS 4.0. Прохождение сертификации подтверждает высокий уровень обеспечения информационной безопасности продуктов и услуг облачного провайдера и расширяет возможности работы с инфраструктурой компаниям финансового сектора, включая кредитные и некредитные организации, а также организации, обрабатывающие данные держателей банковских карт. Выполнение требований ГОСТ Р 57580 является обязательным для большого количества компаний финансовой отрасли: банков, микрофинансовых организаций, операторов финансовых платформ и систем, выпускающих цифровые финансовые активы, негосударственных пенсионных фондов, страховых организаций и других. Для обеспечения надёжности работы компаний этого сектора инфраструктура провайдера также соответствует 152-ФЗ «О персональных данных», 17 приказу ФСТЭК для государственных информационных систем и международным стандартам ISO 27001, 27017, 27018 и SOC 2.

Источник изображения: selectel.ru «Финтех-индустрия в России активно растёт и является одним из лидеров в процессах цифровой трансформации. При этом требования регулятора по обеспечению информационной безопасности распространяются на все большее количество участников финансового рынка. По итогам аудита мы получили заключение о соответствии требованиям по первому (усиленному) уровню защиты с итоговым пятым уровнем соответствия и оценкой 0,92. Такой результат означает, что, предоставляя стабильную и безопасную IT-инфраструктуру и сервисы, мы в полном объёме реализуем и непрерывно совершенствуем организационные и технические меры защиты информации», — отметил Антон Ведерников, руководитель направления продуктовой безопасности Selectel. Обновлённая версия стандарта PCI DSS 4.0 содержит уточнённые требования к безопасности и более полно описывает способы их реализации и контроля для компаний, работающих с данными держателей платёжных карт. Также стандарт теперь предусматривает содействие сервис-провайдера клиентам при проведении пентестов инфраструктуры. Действие сертификата распространяется на все ключевые IaaS и PaaS-решения Selectel: выделенные и облачные серверы, объектное хранилище S3, облачные базы данных, Managed Kubernetes и Container Registry. Также стандарту соответствует ряд ИБ и сетевых сервисов компании: сеть доставки контента (CDN), балансировщик нагрузки, глобальный роутер, выделенное сетевое оборудование, менеджер секретов и сервис управления идентификацией и доступом (IAM).

24.11.2024 [11:43], Сергей Карасёв

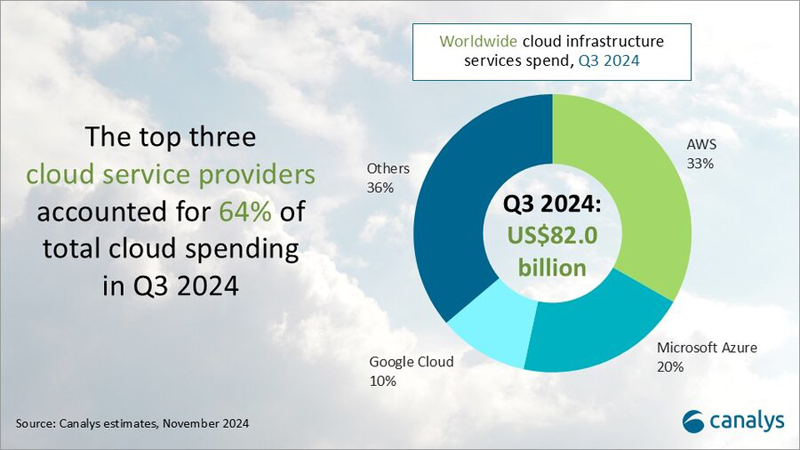

Квартальная выручка на рынке облачных инфраструктур подскочила на 21 %, превысив $80 млрдКомпания Canalys подвела итоги исследования глобального рынка облачных инфраструктур в III квартале 2024 года. Расходы в данной области продолжают быстро увеличиваться на фоне стремительного внедрения ИИ и расширения мощностей гиперскейлеров. В период с июля по сентябрь включительно объём отрасли достиг $82 млрд. Это на 21 % больше результата за III четверть прошлого года. Причём на трёх ведущих поставщиков облачных услуг — Amazon Web Services (AWS), Microsoft Azure и Google Cloud — пришлось 64 % от суммарных затрат, или приблизительно $52,5 млрд.

Источник изображения: Canalys Крупнейшим игроком на мировом рынке остаётся AWS с долей 33 % по итогам III квартала 2024 года: компания получила примерно $27,1 млрд. При этом в годовом исчислении выручка поднялась на 19 %. AWS объявила о планах по дальнейшему увеличению инвестиций в облачном сегменте: прогнозируемые расходы составят около $75 млрд в 2024 году. Средства пойдут в первую очередь на расширение технологической инфраструктуры для удовлетворения растущего спроса на услуги ИИ. На втором месте в рейтинге находится Microsoft Azure с 20 % отрасли, что соответствует $16,4 млрд. Редмондский гигант нарастил показатель на треть (33 %) по отношению к III четверти прошлого года. Существенный рост обусловлен востребованностью сервисов в сегменте ИИ. Замыкает тройку Google Cloud с 10 % ($8,2 млрд) и ростом на 36 % год к году. Таким образом, Google показала самую существенную прибавку среди лидеров. Компания, как отмечается, активно разрабатывает новые сценарии применения ИИ. Все три облачных гиперскейлера сообщили о положительной отдаче от инвестиций в сервисы ИИ, которые начали вносить значительный вклад в общую эффективность бизнеса. |

|