Материалы по тегу: hbm

|

23.03.2024 [22:29], Владимир Мироненко

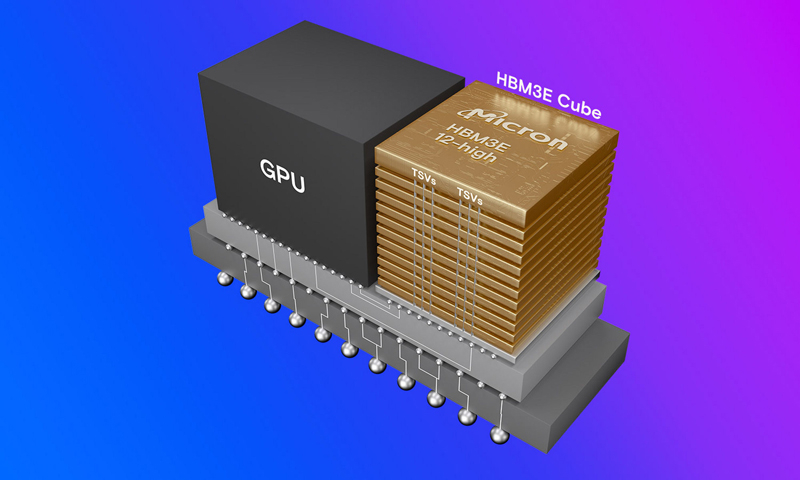

Micron уже продала всю HBM3E-память, которую выпустит в 2024 году и распределила заказы на 2025 годКомпания Micron Technology, приступившая в феврале к массовому производству передовой памяти HBM3E, сообщила, что уже имеет на руках контракты на весь объём поставок до конца 2024 года, а также на большую часть поставок в 2025 году. Память Micron HBM3E (Micron называет её HBM3 Gen2) одной из первых получила сертификацию для использования в ускорителях NVIDIA (G)H200, так что, по всей видимости, Micron станет ключевым поставщиком для NVIDIA, пишет AnandTech. «Наша HBM распродана на 2024 календарный год и подавляющая часть наших поставок на 2025 год уже распределена, — сообщил глава Micron Санджей Мехротра (Sanjay Mehrotra) в комментариях к отчёту за II квартал 2024 финансового года. Первый продукт HBM3E от Micron представляет собой сборку 8-Hi ёмкостью 24 Гбайт с 1024-бит интерфейсом и общей пропускной способностью 1,2 Тбайт/с. NVIDIA H200 использует шесть таких модулей. Micron также начала поставки образцов сборок 12-Hi ёмкостью 36 Гбайт.

Источник изображения: Micron В отчёте за II квартал 2024 финансового года Micron похвасталась результатами, которые оказались значительно выше прогнозов. Напомним, что до этого у компании были убытки пять кварталов подряд. В отчётном квартале Micron получила выручку в размере $5,82 млрд, превысив на 58 % на результат II квартала 2023 финансового года, равный $3,69 млрд, и на 23 % — результат предыдущего квартала, равный $4,73 млрд. При этом доля в общей выручке продаж DRAM составила 71 %, NAND — 27 %. Поставки подразделения сетевых и вычислительных решений (Compute and Networking, CNBU) выросли год к году на 59 % до $2,2 млрд, мобильного подразделения (Mobile, MBU) — на 69 % до $1,6 млрд, у подразделения встраиваемых решений (Embedded, EBU) зафиксирован рост на 28 % до $1,11 млрд, у подразделения решений для СХД — рост на 79 % до $905 млн. Компания сообщила о прибыли в размере $793 млн или $0,71 на акцию, в то время как годом ранее у неё были убытки (GAAP) в $2,31 млрд или $2,12 на акцию. Скорректированная прибыль (non-GAAP) составила $0,42 на акцию по сравнению с убытком в $1,91 на акцию годом ранее. Согласно прогнозу аналитиков, опрошенных FactSet, у Micron должны были быть убытки (non-GAAP) в размере $0,25 на акцию при выручке в $5,35 млрд. В текущем квартале Micron ожидает получить скорректированную прибыль (non-GAAP) в размере $0,42 на акцию при выручке в $6,6 млрд. Аналитики Уолл-стрит прогнозируют в III финансовом квартале прибыль (non-GAAP) в размере $0,09 на акцию при выручке в $6 млрд.

28.02.2024 [15:31], Сергей Карасёв

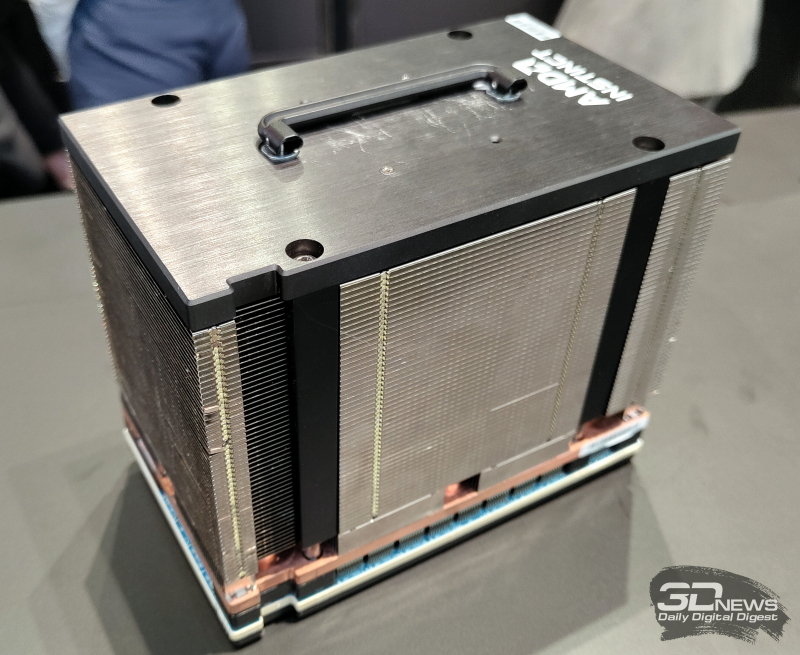

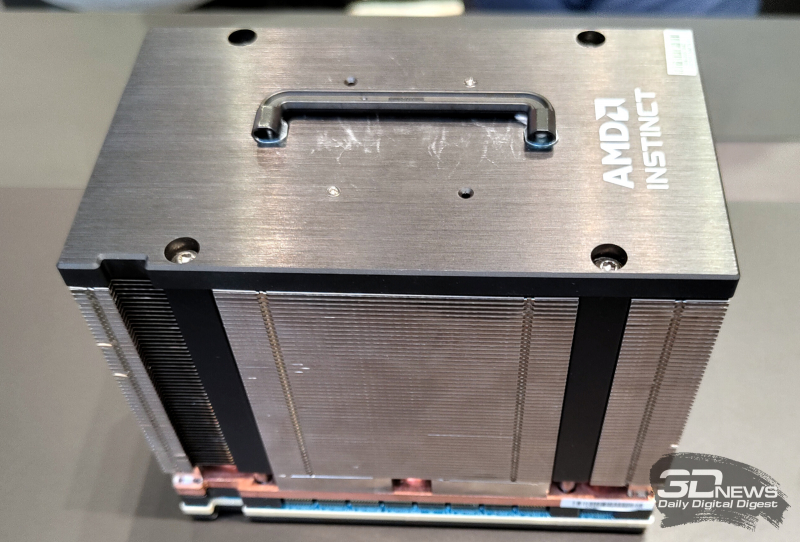

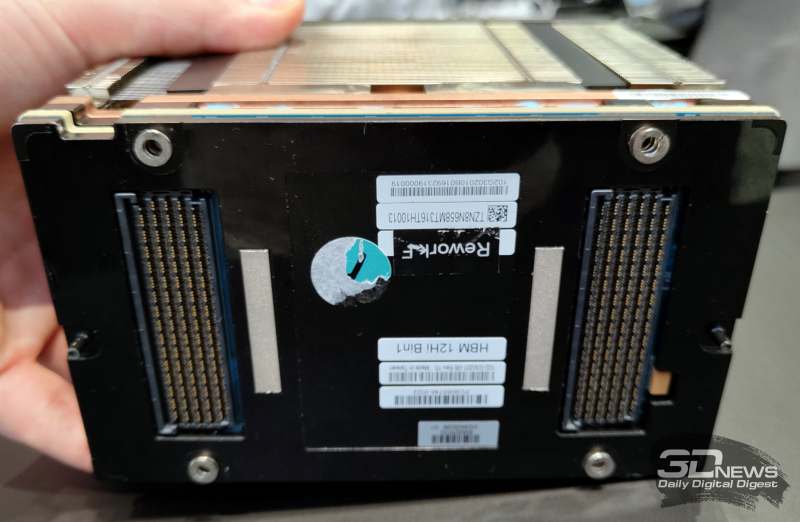

На MWC 2024 замечен первый образец ускорителя AMD Instinct MI300X с 12-слойной памятью HBM3EКомпания AMD готовит новые модификации ускорителей семейства Instinct MI300, которые ориентированы на обработку ресурсоёмких ИИ-приложений. Изделия будут оснащены высокопроизводительной памятью HBM3E. Работу над ними подтвердил технический директор AMD Марк Пейпермастер (Mark Papermaster), а уже на этой неделе на стенде компании на выставке MWC 2024 был замечен образец обновлённого ускорителя. На сегодняшний день в семейство Instinct MI300 входят модификации MI300A и MI300X. Первая располагает 228 вычислительными блоками CDNA3 и 24 ядрами Zen4 на архитектуре x86. В оснащение входят 128 Гбайт памяти HBM3. На более интенсивные вычисления ориентирован ускоритель MI300X, оборудованный 304 блоками CDNA3 и 192 Гбайт HBM3. Но у этого решения нет ядер Zen4. Недавно компания Micron сообщила о начале массового производства 8-слойной памяти HBM3E ёмкостью 24 Гбайт с пропускной способностью более 1200 Гбайт/с. Эти чипы будут применяться в ИИ-ускорителях NVIDIA H200, которые выйдут на коммерческий рынок во II квартале нынешнего года. А Samsung готовится к поставкам 12-слойных чипов HBM3E на 36 Гбайт со скоростью передачи данных до 1280 Гбайт/с. AMD подтвердила намерение применять память HBM3E в обновлённых ускорителях Instinct MI300, но в подробности вдаваться не стала. В случае использования 12-слойных чипов HBM3E ёмкостью 36 Гбайт связка из восьми модулей обеспечит до 288 Гбайт памяти с высокой пропускной способностью. Наклейка на демо-образце недвусмысленно указывает на использование именно 12-слойной памяти. Впрочем, это может быть действительно всего лишь стикер, поскольку представитель AMD уклонился от прямого ответа на вопрос о спецификациях представленного изделия. Ожидается также, что в 2025 году AMD выпустит ИИ-ускорители следующего поколения серии Instinct MI400. Между тем NVIDIA готовит ускорители семейства Blackwell для ИИ-задач: эти изделия, по заявлениям самой компании, сразу после выхода на рынок окажутся в дефиците.

28.02.2024 [14:04], Сергей Карасёв

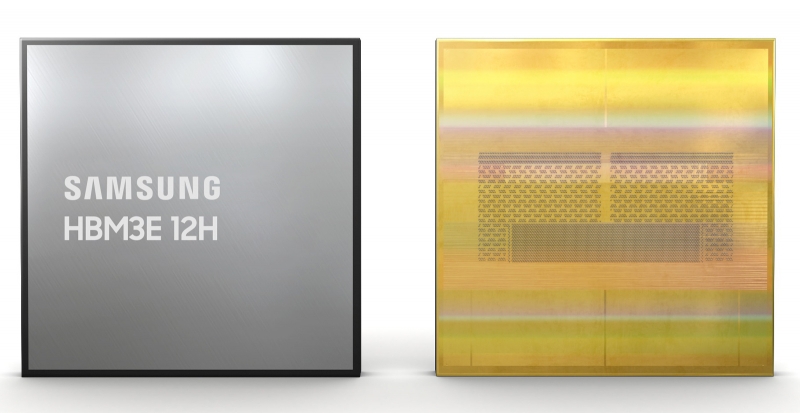

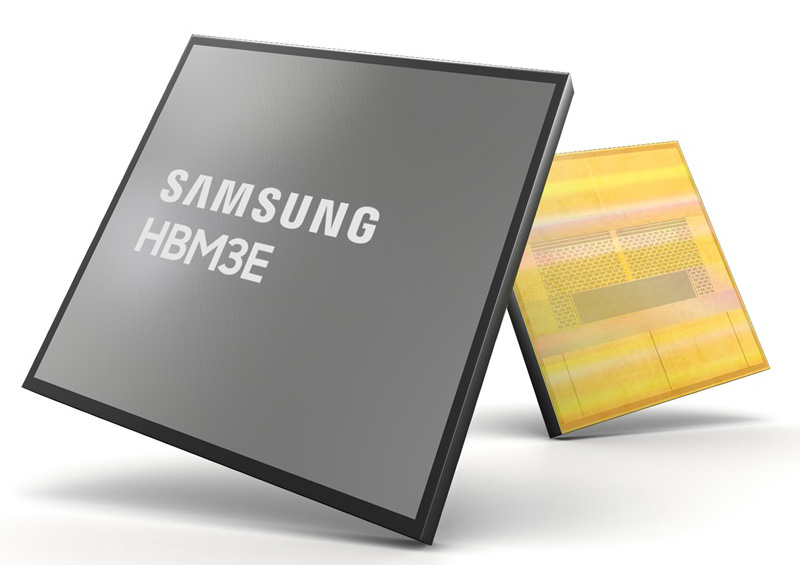

В Samsung разработаны первые в отрасли 12-слойные чипы HBM3E ёмкостью 36 ГбайтКомпания Samsung Electronics объявила о разработке первых в отрасли чипов высокопроизводительной памяти HBM3E в виде 12-ярусных стеков общей ёмкостью 36 Гбайт. Изделия ориентированы на применение в системах ИИ с большой вычислительной нагрузкой. Новые чипы Samsung HBM3E обеспечивают пропускную способность до 1280 Гбайт/с. По этому показателю, как утверждается, решения более чем на 50 % превосходят доступные на рынке 8-слойные стеки HBM3. При изготовлении чипов Samsung применяет технологию термокомпрессии в комплексе с диэлектрической плёнкой. В результате, суммарная высота полученных 12-слойных изделий эквивалентна высоте 8-слойных. Samsung добилась наименьших в отрасли зазоров в стеке — всего 7 мкм, а также устранила пустоты между слоями. Это позволило поднять плотность вертикальной компоновки более чем на 20 % по сравнению с 8-слойными продуктами HBM3. Кроме того, при производстве стеков Samsung использует между слоями памяти контактные выступы разного размера. Небольшие выступы служат для передачи сигналов, тогда как более крупные улучшают отвод тепла. Такой подход, по заявлениям Samsung, также способствует снижению доли брака. В целом, как утверждается, внедрение 12-слойной памяти HBM3E по сравнению с 8-слойными изделиями даёт возможность увеличить скорость обучения ИИ-моделей на 34 %, тогда как количество одновременно обслуживаемых пользователей систем инференса может вырасти в 11,5 раз. Пробные поставки новых чипов уже начались, а массовое производство намечено на I половину 2024 года. Нужно отметить, что буквально на днях компания Micron объявила о начале массового производства 8-слойной памяти HBM3E на 24 Гбайт с пропускной способностью более 1,2 Тбайт/с. Кроме того, Micron уже в марте начнёт распространять образцы 12-ярусных чипов HBM3E ёмкостью 36 Гбайт.

27.02.2024 [13:25], Сергей Карасёв

Micron начала массовое производство памяти HBM3E для ускорителей NVIDIA H200Компания Micron Technology объявила о начале массового производства передовой памяти HBM3E. Речь идёт об изделиях ёмкостью 24 Гбайт, предназначенных для ИИ-ускорителей NVIDIA H200, которые появятся на коммерческом рынке во II квартале нынешнего года. Чипы Micron HBM3E выполнены в виде 8-ярусного стека. Заявленная скорость передачи данных превышает 9,2 Гбит/с на контакт, а общая пропускную способность сборки превосходит 1,2 Тбайт/с. Вместе с тем, как утверждается, изделия потребляют примерно на 30 % меньше энергии по сравнению с решениями конкурентов. Micron подчёркивает, что чипы HBM3E объёмом 24 Гбайт позволяют дата-центрам беспрепятственно масштабировать различные ИИ-нагрузки — от обучения сложных нейронных сетей до ускорения инференса. Изделия выполнены по технологии 1β (1-бета) — самому передовому техпроцессу компании. Кроме того, применены другие современные методики упаковки чипов, включая усовершенствованную технологию сквозных соединений TSV (Through-Silicon Via). Micron также сообщила, что уже в марте нынешнего года начнёт распространять образцы 12-ярусных чипов HBM3E ёмкостью 36 Гбайт. Они, как и изделия на 24 Гбайт, обеспечат пропускную способность свыше 1,2 Тбайт/с при высокой энергетической эффективности.

21.10.2023 [15:26], Сергей Карасёв

Samsung представила чипы памяти HBM3E с пропускной способностью более 1,2 Тбайт/сКомпания Samsung Electronics в ходе ежегодного мероприятия Memory Tech Day сообщила о начале поставок образцов микросхем памяти HBM3E нового поколения с кодовым названием Shinebolt. Утверждается, что изделия Shinebolt обеспечивают прирост производительности примерно на 50 % по сравнению с чипами HBM3E предыдущего поколения (Icebolt). Пропускная способность в расчёте на контакт достигает 9,8 Гбит/с против 6,4 Гбит/с у Icebolt.

Источник изображения: Samsung Таким образом, общая пропускная способность микросхем Shinebolt составляет до 1,228 Тбайт/с. Это позволяет использовать память в высоконагруженных системах, обрабатывающих приложения генеративного ИИ и машинного обучения. С целью повышения плотности компоновки и улучшения тепловых характеристик Samsung оптимизировала свою технологию непроводящей пленки (NCF): это позволило минимизировать зазоры между слоями чипа и максимизировать теплопроводность. Samsung планирует производить 12-ярусные чипы Shinebolt с максимальной ёмкостью 36 Гбайт. Среди других продуктов, представленных компанией Samsung на мероприятии Memory Tech Day, — 32-гигабитные чипы DDR5 DRAM, первая в отрасли память GDDR7 с пропускной способностью 32 Гбит/с и архитектура PBSSD для создания решений «петабайтного класса».

21.08.2023 [10:17], Сергей Карасёв

SK hynix заявила о создании самой быстрой в мире памяти HBM3EКомпания SK hynix объявила о разработке самой высокопроизводительной в мире памяти HBM3E, предназначенной для использования в современных ИИ-системах. Образцы изделий уже поставляются отдельным заказчикам для оценки технических характеристик. HBM3E — это пятое поколение памяти данного типа, приходящее на смену изделиям HBM, HBM2, HBM2E и HBM3. HBM3E представляет собой улучшенную версию HBM3. Массовое производство HBM3E компания SK hynix намерена организовать в первой половине следующего года.

Источник изображения: SK hynix По заявлениям разработчика, память HBM3E соответствует самым высоким отраслевым стандартам скорости передачи данных. Таким образом, изделия подходят для применения в наиболее нагруженных ИИ-платформах. Кроме того, при создании памяти были учтены жёсткие требования в плане рассеяния тепла. Утверждается, что изделия HBM3E способны перемещать информацию со скоростью до 1,15 Тбайт/с. При изготовлении чипов компания SK hynix применяет технологию Advanced Mass Reflow Molded Underfill (MR-MUF), представляющую собой метод объединения нескольких чипов памяти на одной подложке посредством спайки. Это даёт возможность улучшить теплоотведение приблизительно на 10%. Говорится об обратной совместимости с HBM3, что упрощает внедрение новой памяти. По оценкам, доля SK hynix на мировом рынке памяти HBM по итогам 2022 года составила приблизительно 50 %. В текущем году, как ожидается, этот показатель окажется на уровне 46–49 %, в 2024 году — 47–49 %.

20.08.2023 [11:10], Сергей Карасёв

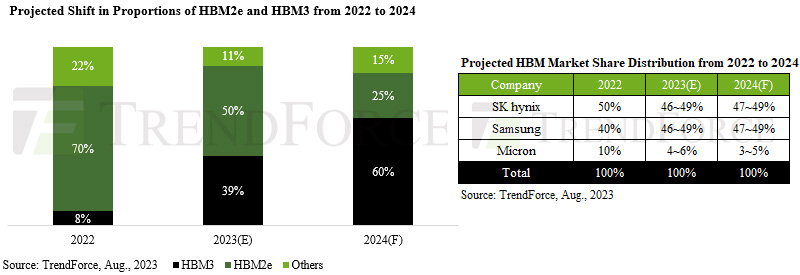

Поставки HBM-памяти в 2024 году вырастут вдвоеКомпания TrendForce опубликовала свежий прогноз по глобальному рынку чипов памяти HBM: аналитики полагают, что спрос на эту продукцию будет быстро расти на фоне стремительно развивающихся ИИ-технологий. Объём поставок HBM в 2024 году может увеличиться на 105 % по сравнению с 2023-м, при этом ожидается смещение фокуса с изделий HBM2e в сторону HBM3. В 2022 году, как отмечает TrendForce, около 70 % поставок пришлось на чипы HBM2e, тогда как доля HBM3 составила только 8 %. В 2023-м, как ожидается, эти показатели окажутся на уровне 50 % и 39 % соответственно. А в 2024 году решения HBM3 уйдут в отрыв, показав результат примерно 60 % против 25 % у HBM2e.

Источник изображения: TrendForce Анализ TrendForce показывает, что 2023–2024 гг. станут ключевыми для развития ИИ, что вызовет значительный рост спроса на чипы HBM. Однако надвигающийся бум производства HBM поставил поставщиков в затруднительное положение: им необходимо найти баланс между удовлетворением потребностей клиентов и недопущением формирования складских излишков из-за перепроизводства. Ещё одной проблемой является потенциальный риск «раздутого» бронирования, поскольку заказчики, ожидающие нехватку HBM, могут переоценить свои потребности. В настоящее время SK hynix удерживает лидерство в производстве HBM, выступая в качестве основного поставщика таких чипов для ускорителей NVIDIA. Доля SK hynix по итогам 2022 года составила приблизительно 50 %. Ещё 40 % досталось Samsung, оставшиеся 10 % — Micron. В 2023 году, полагает TrendForce, доли SK hynix и Samsung будут колебаться в пределах 46–49 %, а доля Micron составит 4–6 %. В следующем году, согласно прогнозам, позиции SK hynix и Samsung окажутся в диапазоне 47–49 %. Micron будет удерживать 3–5 % отрасли. Несмотря на то, что поставщики ещё не завершили разработку своих ценовых политик на 2024 год, TrendForce не исключает возможности дальнейшего снижения цен на продукты HBM2 и HBM2e. А вот цены на HBM3, по прогнозам, останутся такими же, как и в 2023 году.

14.07.2023 [19:40], Алексей Степин

Samsung и SK Hynix работают над снижением энергопотребления оперативной памятиЧем активнее внедряются ИИ-системы, тем важнее становится роль памяти HBM и DDR5, а в особенности её энергоэффективность. Так, в крупномасштабных системах на базе NVIDIA A100 на долю памяти может приходиться до 40 % потребляемой энергии. Неудивительно, что крупные производители памяти объединяют свои усилия с академическими кругами, чтобы разработать более экономичную память нового поколения. В частности, Samsung на базе CXL и 12-нм техпроцесса уже разработала чипы DDR5 ёмкостью 16 Гбайт, который на 23 % экономичнее в сравнении с аналогичными чипами предыдущего поколения. В содействии с Сеульским национальным университетом (Seoul National University) Samsung продолжает вести работы по дальнейшему снижению энергопотребления. Сам университет также ведёт исследования в этом направлении и уже разработал новую технологию DRAM Translation Layer. Ожидается, что её внедрение поможет снизить энергопотребление DRAM ещё на 31,6 %.

Источник: SK Hynix Не отстаёт от Samsung и другой крупный производитель устройств памяти, компания SK Hynix. Она представила новое поколение LPDDR5X, в котором применен техпроцесс High-K Metal Gate (HKMG). Благодаря материалу с оптимизированной диэлектрической проницаемостью удалось впятеро повысить заряд в ячейке, снизив при этом токи утечки. В итоге новая память LPDDR5X от SK Hynix может похвастаться на 33 % более высокой производительностью при 20 % экономии в энергопотреблении, в сравнении с предыдущим поколением.

13.07.2023 [18:02], Алексей Степин

Alphawave Semi получила первые контроллеры HBM3 и UCIe в 3-нм «кремнии»Компания Alphawave Semi анонсировала успешное воплощение в «кремнии» своих PHY-контроллеров HBM3 и UCIe. Что немаловажно, новые IP-блоки производятся с использованием 3-нм техпроцесса TSMC, что делает их весьма экономичными решениями и открывает путь к ещё более быстрым чиплетным платформам для рынка ЦОД и гиперскейлеров. Компания, по её собственным словам, стала первым в мире разработчиком, представившим PHY для UCIe, который работает на скорости 24 Гбит/с на линию и обеспечивает совокупную пропускную способность 7,9 Тбит/с на миллиметр. При этом благодаря применению 3-нм техпроцесса TSMC он же обеспечивает и беспрецедентную экономичность, расходуя всего 0,3 пДж/бит. Новый IP совместим с другими разработками Alphawave Semi, в частности, может работать вместе с блоками PCIe и CXL. Также он поддерживает продвинутые технологии упаковки, такие, как TSMC Chip-on-Wafer-on-Substrate (CoWoS) и Integrated Fan-Out (InFO), в том числе использующие органический субстрат, что удешевляет интеграцию. Соответствующими скоростными характеристиками может похвастаться и PHY-контроллер HBM3. Он поддерживает 16 каналов, работающих на скорости 8,6 Гбит/с, при этом очень компактен и экономичен и полностью совместим со стандартами JEDEC. Благодаря возможностям тонкой подстройки контроллер можно идеально подогнать к потребностям конкретных решений, включая ИИ и HPC. Согласно заявлению Alphawave Semi, два новых IP-блока станут ключевыми в чиплетном IP-портфолио компании. Благодаря им крупные гиперскейлеры и владельцы ЦОД-инфраструктуры смогут гибко проектировать и реализовывать кастомные SoC, отвечающие всем современным требованиям.

04.07.2023 [20:05], Алексей Степин

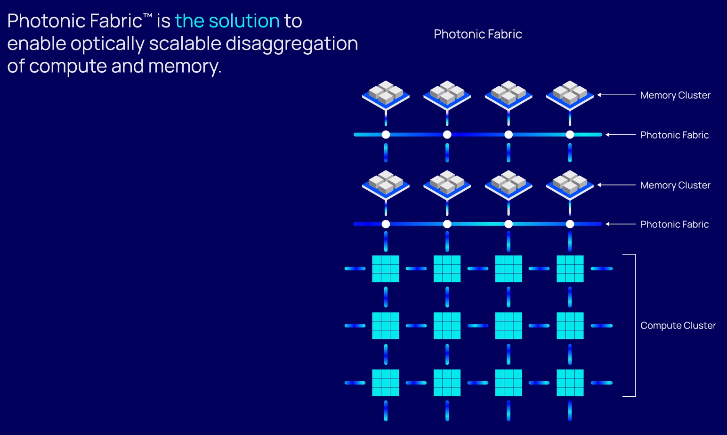

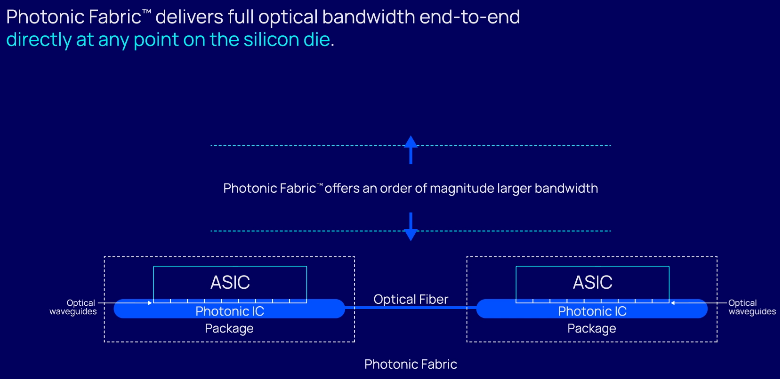

HBM по оптике: фотонный интерконнект Celestial AI Photonic Fabric обеспечит плотность до 7,2 Тбит/с на кв. ммCelestial AI, получившая $100 млн инвестиций, объявила о разработке интерконнекта Photonic Fabric, покрывающего все ниши: межкристалльного (chip-to-chip), межчипового (package-to-package) и межузлового (node-to-node) обмена данными. На рынке уже есть решения вроде Lightmatter Passage или Ayar Labs TeraPhy I/O. Тем не менее, Celestial AI привлекла внимание множества инвесторов, в том числе Broadcom. Последняя поможет в разработке прототипов, которые должны увидеть свет в течение 18 месяцев. В основе технологий Celestial AI лежит сочетание кремниевой фотоники и техпроцесса CMOS (TSMC, 4 или 5 нм), разработанных совместно с Broadcom. При этом речь идёт не об обычном «глупом» интерконнекте — разработчики говорят о блоках маршрутизации и коммутации на любом «конце» волокна. Разработка позволит объединить в одной упаковке несколько ASIC или даже SoC посредством оптического интерпозера или моста OMIB (multi-chip interconnect bridge). Celestial AI утверждает, что её технологии эффективнее, чем у конкурентов, и позволяет объединить несколько чипов с теплопакетами в районе сотен ватт.

Источник здесь и далее: Celestial AI Пока что технология опирается на 56-Гбит/с трансиверы SerDes. С четырьмя портами на узел и четырьмя линиями на порт речь идёт о пропускной способности до 1,8 Тбит/с на 1 мм2 чипа, что позволяет «прокормить» полноценную сборку из четырёх кристаллов HBM3. Второе поколение Photonic Fabric будет использовать уже 112-Гбит/с SerDes-блоки, что поднимет пропускную способность вчетверо, до 7,2 Тбит/с на мм2.  Интерконнект Celestial AI не зависит от проприетарных протоколов, в его основе лежат стандарты Compute Express Link (CXL) и Universal Chiplet Interconnect (UCIe), а также JEDEC HBM. В настоящее время сдерживающим фактором разработчики называют сами шины PCIe и UCIe. Их интерконнект, считают они, способен на большее. |

|