Материалы по тегу: gb200

|

20.10.2024 [11:01], Сергей Карасёв

NVIDIA передаст OCP спецификации компонентов суперускорителя GB200 NVL72Некоммерческая организация Open Compute Project Foundation (OCP), специализирующаяся на создании открытых спецификаций оборудования для ЦОД, сообщила о том, что для её инициативы Open Systems for AI собственные разработки предоставят NVIDIA и Meta✴. Проект Open Systems for AI был анонсирован в январе 2024 года при участии Intel, Microsoft, Google, Meta✴, NVIDIA, AMD, Arm, Ampere, Samsung, Seagate, SuperMicro, Dell и Broadcom. Цель инициативы заключается в разработке открытых стандартов для кластеров ИИ и дата-центров, в которых размещаются такие системы. Предполагается, что Open Systems for AI поможет повысить эффективность и устойчивость ИИ-платформ, а также обеспечит возможность формирования цепочек поставок оборудования от нескольких производителей. В рамках инициативы NVIDIA предоставит OCP спецификации элементы электромеханической конструкции суперускорителей GB200 NVL72, включая архитектуры стойки и жидкостного охлаждения, механические части вычислительного и коммутационного лотков. Кроме того, NVIDIA расширит поддержку стандартов OCP в своей сетевой инфраструктуре Spectrum-X. Речь идёт об обеспечении совместимости со стандартами OCP Switch Abstraction Interface (SAI) и Software for Open Networking in the Cloud (SONiC). Это позволит клиентам использовать адаптивную маршрутизацию Spectrum-X и управление перегрузками на основе телеметрии для повышения производительности Ethernet-соединений в составе масштабируемой инфраструктуры ИИ. Адаптеры ConnectX-8 SuperNIC с поддержкой OCP 3.0 появятся в 2025 году. В свою очередь, Meta✴ передаст проекту Open Systems for AI свою архитектуру Catalina AI Rack, которая специально предназначена для создания ИИ-систем высокой плотности с поддержкой GB200. Это, как ожидается, позволит организации OCP «внедрять инновации, необходимые для создания более устойчивой экосистемы ИИ».

18.10.2024 [20:45], Игорь Осколков

Microsoft стремительно увеличила закупки суперускорителей NVIDIA GB200 NVLПо словам аналитика Минг-Чи Куо (Ming-Chi Kuo), Microsoft резко нарастила закупки суперускорителей NVIDIA GB200 NVL. Заказы на IV квартал текущего года выросли в три-четыре раза, а общий объём заказов Microsoft выше, чем у других облачных провайдеров. Поставщики ключевых компонентов для новых ИИ-платформ Microsoft начнут их массовое производство и отгрузку в IV квартале, что укрепит цепочку поставок компании. При этом компоненты будут отгружаться в независимости от того, смогут ли сборщики готовых платформ вовремя удовлетворить запросы Microsoft. Предполагается, что до конца года будет поставлено 150–200 тыс. чипов Blackwell, а в I квартале 2025 года поставки вырастут до 500–550 тыс. ед. И Microsoft готова закупать их. В дополнение к первоначальным заказам GB200 NVL36 (в основном для тестирования) Microsoft намерена получить кастомизированные суперускорители GB200 NVL72 до начала массового производства референсного варианта DGX GB200 NVL72 от самой NVIDIA (середина II квартала 2025 года). Заказы Microsoft на IV квартал выросли с изначальных 300–500 стоек (в основном NVL36) до примерно 1400–1500 стоек (около 70 % NVL72). Последующие заказы Microsoft будут сосредоточены преимущественно на NVL72. Согласно опросам двух крупнейших сборщиков GB200 NVL, Foxconn и Quanta, заказы Microsoft в настоящее время, по-видимому, превышают общий объём заказов от других облачных провайдеров. Так, Amazon рассчитывает до конца года получить всего 300–400 стоек GB200 NVL36, а Meta✴ и вовсе ориентируется на платы Ariel, имеющие по одному чипу B200 и Grace, а не пару B200, как у «классических» плат Bianca. NVIDIA, по словам Минг-Чи Куо, решила отказаться от выпуска двухстоечной конфигурации GB200 NVL36×2. При этом NVIDIA, судя по всему, не удалось убедить Microsoft закупать полностью готовые NVL-стойки. На днях редмондский гигант показал свою реализацию суперускорителя GB200 NVL с огромным теплообменником. Первыми эти системы получат дата-центры Microsoft, расположенные в более холодном климате, например, на севере США, в Канаде, в Финляндии и т. д. Это позволит избежать проблем из-за недостатка времени на оптимизацию систем охлаждения ЦОД.

18.10.2024 [18:58], Руслан Авдеев

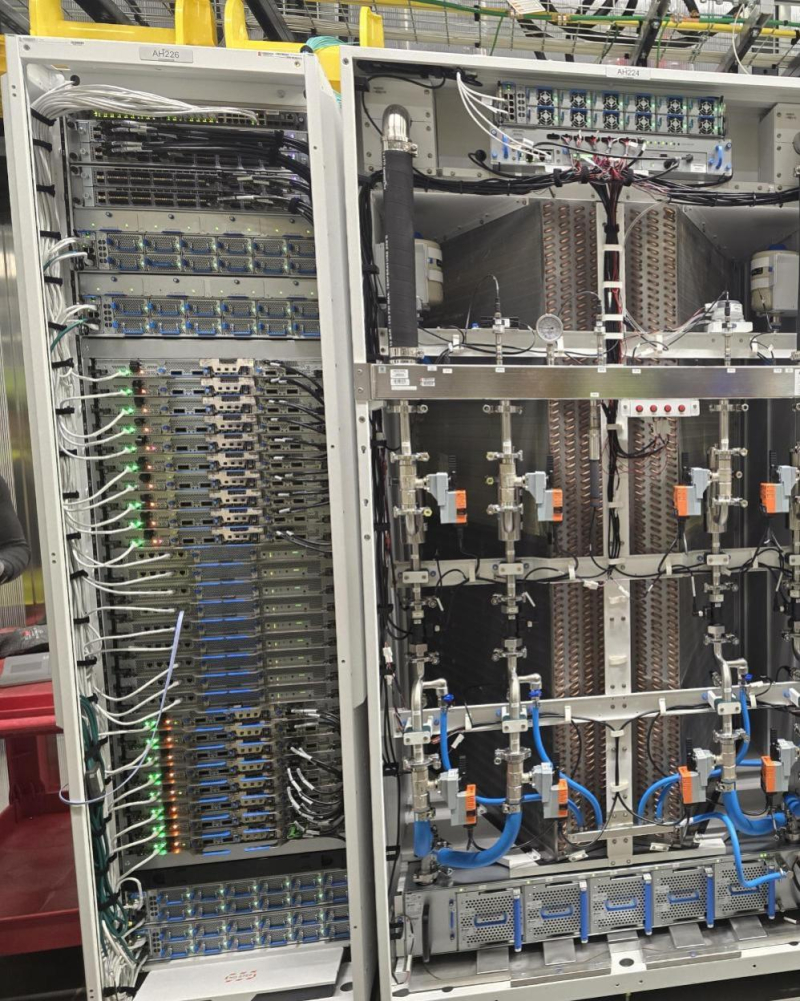

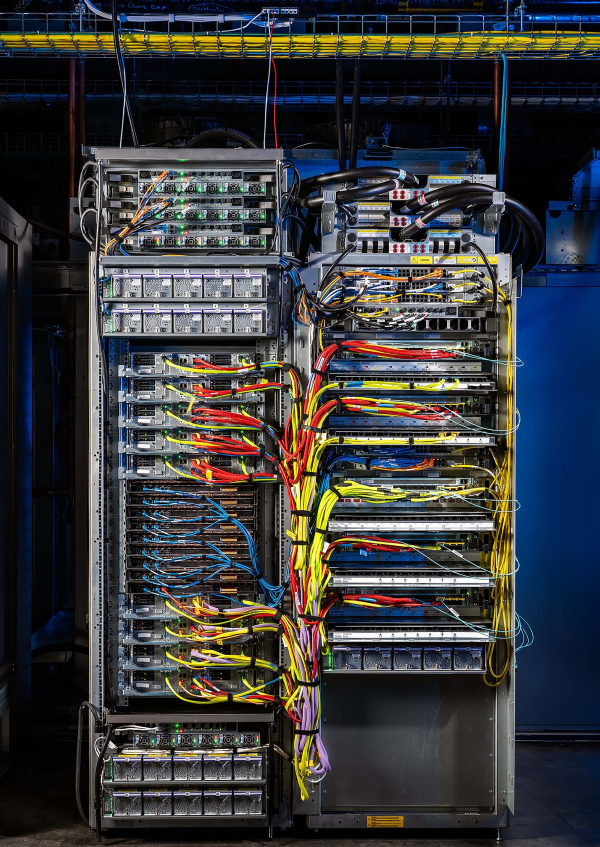

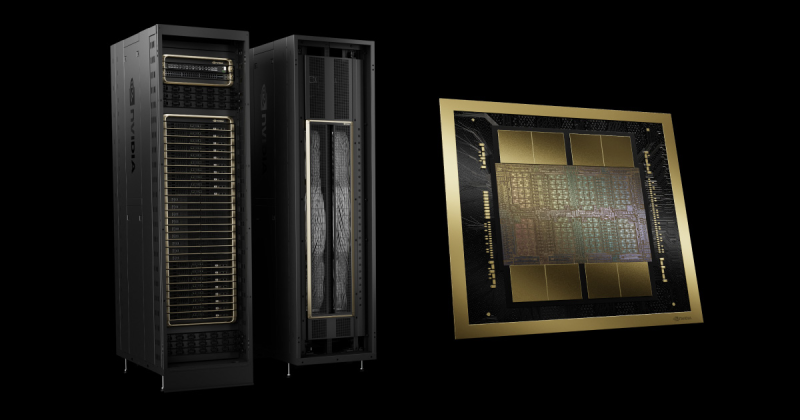

Google тоже показала собственный вариант суперускорителя NVIDIA GB200 NVLGoogle показала собственный вариант суперускорителя NVIDIA Blackwell GB200 NVL для своей облачной ИИ-платформы, передаёт Datacenter Dynamics. Решение Google отличается от вариантов Meta✴ и Microsoft, представленных ранее. Тем не менее, это показывает высокий интерес к новой ИИ-платформе NVIDIA со стороны гиперскейлеров. Google заявила о тесном сотрудничестве с NVIDIA для формирования «устойчивой вычислительной инфраструктуры будущего». Подробнее о новой платформе будут рассказано на одной из будущих конференций Google. Пока что, увы, даже не до конца ясна конфигурация суперускорителя в исполнении Google. На фото видно сразу две стойки. Одна содержит неназванное количество ускорителей GB200, а вторая комплектуется оборудованием Google, в том числе блоками питания, коммутаторами и модулями охлаждения. Хотя NVIDIA рекомендует использовать в качестве интерконнекта InfiniBand в своих ИИ-платформах, некоторые эксперты считают, что Google пользуется собственными инфраструктурными наработками на базе Ethernet. Так, компания уже применяет оптические коммутаторы (OCS) собственной разработки в ИИ-кластерах с фирменными ускорителями TPU. Вариант Microsoft также состоит из двух стоек. Во второй смонтирован огромный теплообменник, который, вероятно, обслуживает не одну стойку с ускорителями, а сразу несколько. Известно, что ранее между Microsoft и NVIDIA были разногласия по поводу компоновки платформ для GB200. Наконец, вариант Meta✴ наиболее близок к оригинальной версии NVIDIA GB200 NVL72. При этом NVIDIA открыла её спецификации в рамках OCP. Ранее компания отказалась от выпуска «компромиссных» суперускорителей GB200 NVL36×2, которые сами по себе занимают две стойки.

18.10.2024 [00:10], Алексей Степин

Meta✴ представила свой вариант суперускорителя NVIDIA GB200 NVL72Meta✴ поделилась своими новинками в области аппаратной инфраструктуры и рассказала, каким именно видит будущее открытых ИИ-платформ. В своей презентации Meta✴ рассказала о новой ИИ-платформе, новых дизайнах стоек, включая варианты с повышенной мощностью питания, а также о новинках в области сетевой инфраструктуры.

Источник изображений: Meta✴ В настоящее время компания использует нейросеть Llama 3.1 405B. Контекстное окно у этой LLM достигает 128 тыс. токенов, всего же токенов свыше 15 трлн. Чтобы обучать такие модели, требуются очень серьёзные ресурсы и глубокая оптимизация всего программно-аппаратного стека. В обучении базовой модели Llama 3.1 405B участвовал кластер 16 тыс. ускорителей NVIDIA H100, один из первых такого масштаба. Но уже сейчас для обучения ИИ-моделей Meta✴ использует два кластера, каждый с 24 тыс. ускорителей. Проекты такого масштаба зависят не только от ускорителей. На передний план выходят проблемы питания, охлаждения и, главное, интерконнекта. В течение нескольких следующих лет Meta✴ ожидает скоростей в районе 1 Тбайт/с на каждый ускоритель. Всё это потребует новой, ещё более плотной архитектуры, которая, как считает Meta✴, должна базироваться на открытых аппаратных стандартах. Одной из новинок стала платформа Catalina. Это Orv3-стойка, сердцем которой являются гибридные процессоры NVIDIA GB200. Стойка относится к классу HPR (High Power Rack) и рассчитана на 140 КВт. Сейчас Microsoft и Meta✴ ведут работы над модульной и масштабируемой системой питания Mount Diablo. Свой вариант GB200 NVL72 у Microsoft тоже есть. Также Meta✴ обновила ИИ-серверы Grand Teton, впервые представленные в 2022 году. Это по-прежнему монолитные системы, но теперь они поддерживают не только ускорители NVIDIA, но и AMD Instinct MI300X и будущие MI325X.  Интерконнектом будущих платформ станет сеть DSF (Disaggregated Scheduled Fabric). Благодаря переходу на открытые стандарты компания планирует избежать ограничений, связанных с масштабированием, зависимостью от вендоров аппаратных компонентов и плотностью подсистем питания. В основе DSF лежит стандарт OCP-SAI и ОС Meta✴ FBOSS для коммутаторов. Аппаратная часть базируется на стандартном интерфейсе Ethernet/RoCE. Meta✴ уже разработала и воплотила в металл новые коммутаторы класса 51Т на базе кремния Broadcom и Cisco, а также сетевые адаптеры FBNIC, созданные при поддержке Marvell. FBNIC может иметь до четырёх 100GbE-портов. Используется интерфейс PCIe 5.0, причём могущий работать как четыре отдельных слайса. Новинка соответствует открытому стандарту OCP NIC 3.0 v1.2.0.

17.10.2024 [12:20], Сергей Карасёв

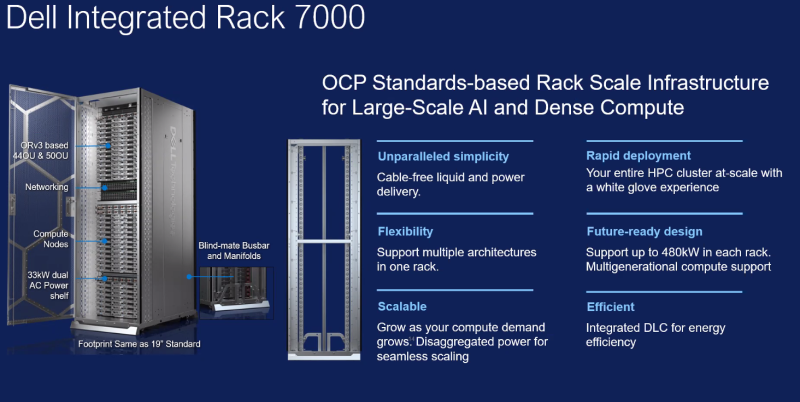

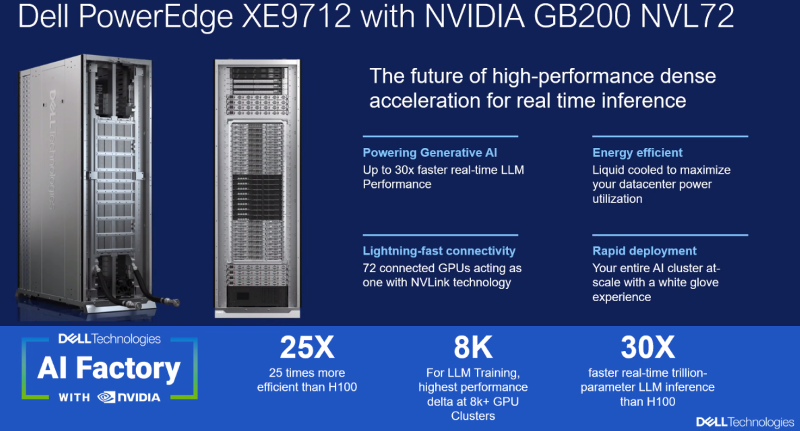

Dell представила решения AI Factory на базе NVIDIA GB200 и AMD EPYC TurinКомпания Dell Technologies анонсировала интегрированные стоечные масштабируемые системы для экосистемы AI Factory, рассчитанные на задачи НРС и ресурсоёмкие приложения ИИ. В частности, дебютировали решения Integrated Rack 7000 (IR7000), PowerEdge M7725 и PowerEdge XE9712.

Источник изображений: Dell IR7000 — это высокоплотная 21″ стойка Open Rack Version 3 (Orv3) с поддержкой жидкостного охлаждения. Говорится о совместимости с мощными CPU и GPU с высоким значением TDP. Модификации 44OU и 50OU оснащены салазками, которые шире и выше традиционных: это гарантирует совместимость с несколькими поколениями архитектур процессоров и ИИ-ускорителей. Полки питания в настоящее время поддерживают мощность от 33 кВт до 264 кВт на стойку с последующим увеличением до 480 кВт. Система Dell PowerEdge M7725 специально спроектирована для вычислений высокой плотности. В основу положены процессоры AMD серии EPYC 9005 (Turin), насчитывающие до 192 вычислительных ядер. Одна стойка IR7000 может вместить 72 серверных узла M7725, каждый из которых оборудован двумя CPU. Таким образом, общее количество вычислительных ядер превышает 27 тыс. на стойку. Возможно развёртывание прямого жидкостного охлаждения (DLC) и воздушного охлаждения. Доступны два IO-слота (PCIe 5.0 x16) в расчёте на узел с поддержкой Ethernet и InfiniBand.  В свою очередь, система Dell PowerEdge XE9712 разработана для обучения больших языковых моделей (LLM) и инференса в реальном времени. Эта новинка использует архитектуру суперускорителя NVIDIA GB200 NVL72. В общей сложности задействованы 72 чипа B200 и 36 процессоров Grace. Утверждается, что такая конфигурация обеспечивает скорость инференса до 30 раз выше по сравнению с системами предыдущего поколения.

17.10.2024 [11:46], Сергей Карасёв

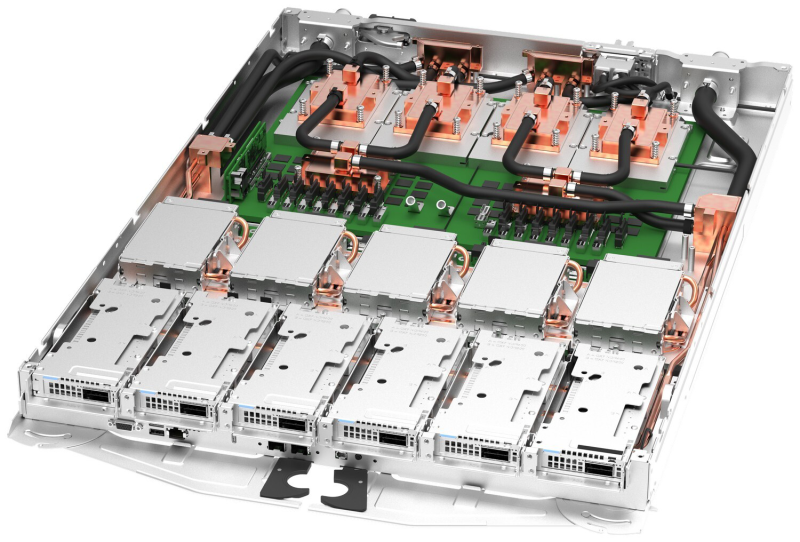

Lenovo представила сервер ThinkSystem SC777 V4 Neptune на базе NVIDIA GB200 с СЖОКомпания Lenovo анонсировала сервер ThinkSystem SC777 V4 Neptune, спроектированный специально для НРС-нагрузок и задач ИИ. Новинка 100 % прямым жидкостным охлаждением, что, как утверждается, обеспечивает максимальную производительность и энергоэффективность без ущерба для удобства обслуживания. По сравнению с аналогичной системой с воздушным охлаждением сервер ThinkSystem SC777 V4 Neptune обеспечивает увеличение общей производительности до 10 % благодаря постоянной работе в турбо-режиме; сокращение энергопотребления дата-центра до 40 %; снижение уровня шума от вентиляторов до 100 %. Базовая система ThinkSystem SC777 V4 Neptune, заключённая в 21″ корпус с возможностью вертикального монтажа, несёт на борту два ускорителя NVIDIA GB200, что в сумме даёт четыре чипа B200 и два процессора Grace. Возможна установка до шести адаптеров NVIDIA NDR или трёх адаптеров XDR LP InfiniBand. Архитектура сервера допускает использование до десяти накопителей E3.S NVMe в расчёте на лоток. Говорится о поддержке массивов RAID на уровне ОС. В оснащение входят два сетевых порта 25GbE SFP28 LOM. На фронтальную панель выведены интерфейс USB Type-C / DisplayPort, диагностический порт, два разъёма USB 3.0, интерфейс D-Sub, гнездо RJ-45 и пр. Восемь лотков ThinkSystem SC777 V4 Neptune могут быть размещены в шасси ThinkSystem N1380 Neptune типоразмера 13U, а три таких блока могут быть установлены в 19″ серверную стойку. Названное шасси допускает использование до четырёх узлов ThinkSystem Titanium Power Conversion Stations (PCS) мощностью 15 кВт каждый.

09.10.2024 [14:43], Руслан Авдеев

Foxconn и NVIDIA построят самый быстрый на Тайване ИИ-суперкомпьютерКомпании Foxconn и NVIDIA объединили усилия для постройки крупнейшего на Тайване суперкомпьютера. По данным пресс-службы NVIDIA, проект Hon Hai Kaohsiung Super Computing Center был представлен в ходе традиционного мероприятия Foxconn — Hon Hai Tech Day, прошедшего в минувший вторник. Вычислительные мощности будут построены на основе передовой архитектуры NVIDIA Blackwell — будет использована платформа GB200 NVL72, включающая 64 стойки. С ожидаемой производительностью ИИ-вычислений более 90 Эфлопс (FP4), машина может легко считаться самой быстрой на Тайване. Foxconn намерена использовать суперкомпьютер для исследований в области медицины, разработки больших языковых моделей (LLM) и инноваций в системах умного города. Это может сделать Тайвань одним из лидеров ИИ-индустрии. В рамках стратегии «трёх платформ» Foxconn уделяет внимание умному производству, умным городам и электрическому транспорту. Новый суперкомпьютер призван сыграть ключевую роль в поддержке инициатив компании по созданию «цифровых двойников», автоматизации робототехники и созданию умной городской инфраструктуры. Строительство уже началось в тайваньском муниципалитете Гаосюн, первая фаза должна заработать к середине 2025 года. Полностью работоспособным компьютер станет в 2026 году. Проект будет активно использовать технологии NVIDIA вроде робоплатформ NVIDIA Omniverse и Isaac для ИИ и «цифровых двойников». В Foxconn утверждают, что суперкомпьютер будет не только крупнейшим на Тайване, но и одним из самых производительных в мире. Каждая стойка GB200 NVL72 включает 36 CPU Grace и 72 ускорителя Blackwell, объединённых интерконнектом NVIDIA NVLink (суммарно 130 Тбайт/с). Технология NVIDIA NVLink Switch позволит системе из 72 ускорителей функционировать как единый вычислительный модуль — оптимальный вариант для обучения ИИ-моделей и инференса в режиме реального времени, с моделями на триллион параметров. Предполагается использование решений NVIDIA DGX Cloud Infrastructure и Spectrum-X для поддержки масштабируемого обучения ИИ-моделей. Тайваньская Foxconn (официально Hon Hai Precision Industry Co.) — крупнейший в мире производитель электроники, известный выпуском самых разных устройств, от смартфонов до серверов для популярных во всём мире заказчиков. Компания уже имеет производства по всему миру и является ключевым игроком в мировой технологической инфраструктуре. При этом производитель считается одним из лидеров в организации «умного» производства, внедряющим промышленные ИИ-системы и занимающимся цифровизацией заводов с помощью NVIDIA Omniverse Cloud. Кроме того, именно она одной из первых стала пользоваться микросервисами NVIDIA NIM в разработке языковых моделей, интегрированных во многие внутренние системы и процессы на предприятиях, создании умных электромобилей и инфраструктуры умных городов. Суперкомпьютер Hon Hai Kaohsiung Super Computing Center — лишь часть растущей общемировой сети передовых проектов на основе решений NVIDIA. Сеть включает несколько значимых проектов в Европе и Азии. Сотрудничество компаний становится всё теснее. В ходе того же мероприятия объявлено о сотрудничестве Foxconn и NVIDIA в Мексике. Первая построит завод в стране для упаковки полупроводников NVIDIA.

09.10.2024 [09:54], Сергей Карасёв

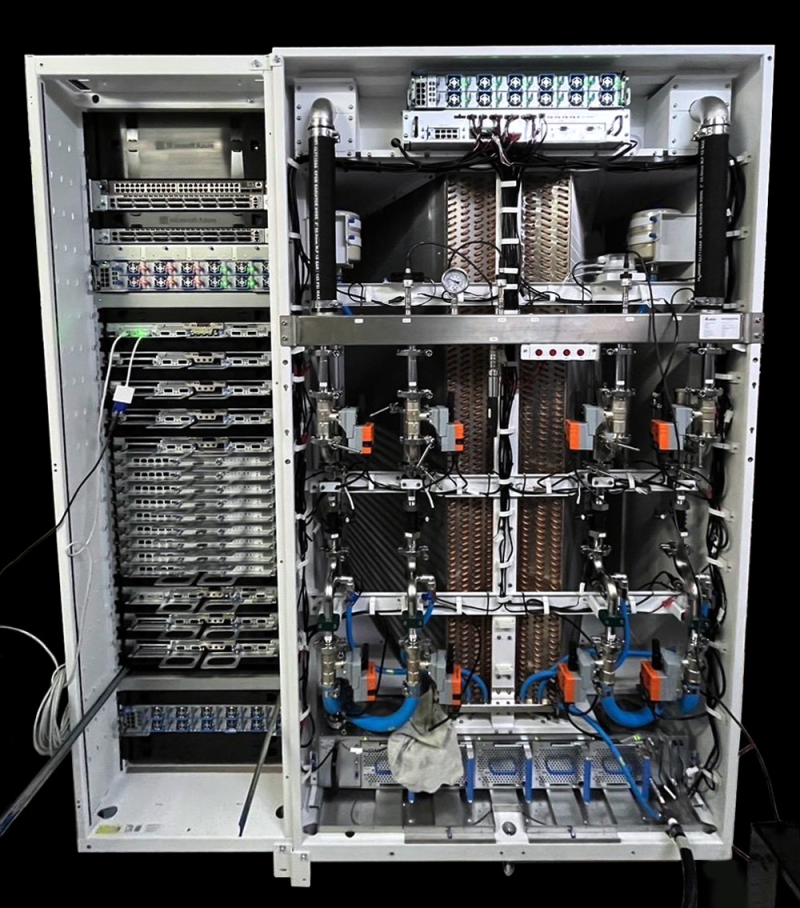

Фото дня: ИИ-система с NVIDIA GB200 и огромным радиатором для облака Microsoft AzureКорпорация Microsoft опубликовала в социальной сети Х фото новой ИИ-системы на базе ускорителей NVIDIA GB200 для облачной платформы Azure. Вычислительная стойка запечатлена рядом с блоком распределения охлаждающей жидкости (CDU), который является частью СЖО. Как отмечает ресурс ServeTheHome, вычислительная стойка содержит восемь узлов на основе GB200 с архитектурой Blackwell, а также ряд других компонентов. Точная конфигурация системы не раскрывается. На фотографии видно, что CDU-блок, расположенный по правую сторону от вычислительной стойки, имеет вдвое большую ширину. Он содержит крупноразмерный теплообменник жидкость — воздух, по сути, представляющий собой аналог автомобильного радиатора. Можно видеть насосы, элементы подсистемы питания, а также средства мониторинга. Наблюдатели отмечают, что обычно теплообменники шириной в две стойки предназначены для нескольких вычислительных стоек. Поэтому не исключено, что запечатленные на снимке изделия являются частью более крупной системы, где показанный CDU-блок будет отвечать за охлаждение сразу нескольких вычислительных стоек с ускорителями NVIDIA GB200. Напомним, ранее у Microsoft и NVIDIA возникли разногласия по поводу использования решений B200. NVIDIA настаивает на том, чтобы клиенты приобретали эти изделия в составе полноценных серверных стоек, тогда как Microsoft хочет использовать вариант стоек OCP с целью унификации инфраструктуры своих многочисленных дата-центров. Недавно также стало известно, что NVIDIA отказалась от выпуска двухстоечных суперускорителей GB200 NVL36×2 в пользу одностоечных вариантов NVL72 и NVL36. Причём Microsoft отдала предпочтение именно NVL72: корпорация начнёт получать эти системы в декабре.

09.10.2024 [09:49], Руслан Авдеев

Foxconn и NVIDIA построят крупнейший в мире завод по выпуску суперчипов GB200 в МексикеКомпания Foxconn построит в Мексике крупнейший в мире завод по упаковке суперчипов GB200 компании NVIDIA — ключевого продукта нового семейства Blackwell. По данным Reuters, Foxconn стал одним из главных выгодоприобретателей от бума ИИ, поскольку компания уже собирает серверы для систем искусственного интеллекта. По словам представителя Foxconn, речь действительно идёт о крупнейшем заводе по упаковке GB200 на планете. В мексиканском правительстве сообщили, что завод построят в городе Гвадалахара. В августе NVIDIA сообщала о начале поставок образцов чипов Blackwell партнёрам и клиентам, в период до января она рассчитывает уже заработать на новейших полупроводниках несколько миллиардов долларов. В Foxconn уверены, что сотрудничество компании с NVIDIA имеет важнейшее значение, поскольку спрос на новую платформу «ужасно огромный».

Источник изображения: Sergio Rodríguez/unsplash.com Foxconn уже активно развивает производство в Мексике и инвестировала более $500 млн в штате Чиуауа. В компании утверждают, что цепочка поставок компании уже готова к ИИ-революции и производственные возможности включают выпуск передовых систем жидкостного охлаждения и теплоотвода, необходимых для оснащения серверов с GB200. Утверждается, что в текущем квартале компания обеспечила сильные показатели. В минувшую субботу Foxconn отчиталась о рекордной выручке в III квартале — на фоне сильного спроса на ИИ-серверы. Ещё одним приоритетом Foxconn являются амбициозные планы диверсификации бизнеса. В компании не желают, чтобы она ассоциировалась исключительно со сборкой электроники для Apple и надеются использовать технологические наработки для контрактного производства других продуктов, в т.ч. электромобилей и даже собственных машин под брендом Foxconn. Также известно, что на днях Foxconn и NVIDIA объявили о совместном строительстве самого быстрого ИИ-суперкомпьютера на Тайване с использованием платформы GB200 NVL72.

03.10.2024 [10:51], Сергей Карасёв

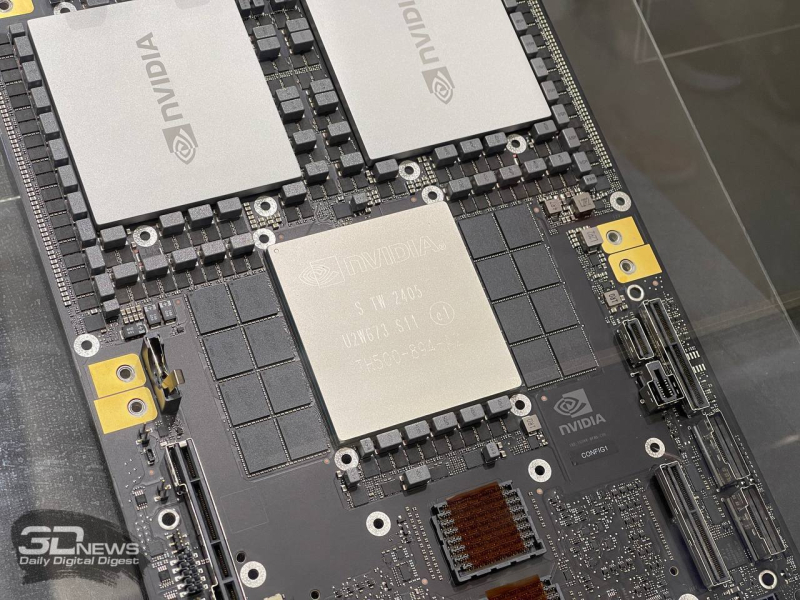

NVIDIA отказалась от выпуска двухстоечных суперускорителей GB200 NVL36×2Компания NVIDIA, по информации аналитика Минг-Чи Куо (Ming-Chi Kuo), приняла решение отказаться от выпуска двухстоечных ИИ-систем NVL36×2 на основе ускорителей GB200 в пользу одностоечных машин NVL72 и NVL36. Объясняется это ограниченностью ресурсов и предпочтениями клиентов. Изначально планировалось выпустить три суперсистемы GB200 на базе ускорителей Blackwell для рабочих нагрузок ИИ и HPC — NVL72, NVL36 и NVL36×2. Первая объединяет в одной стойке 18 узлов 1U, каждый из которых содержит два ускорителя GB200. В сумме это даёт 72 чипа B200 и 36 процессоров Grace. Задействована шина NVLink 5, а энергопотребление системы находится на уровне 120 кВт. В свою очередь, NVL36 насчитывает 36 чипов B200, тогда как NVL36×2 объединяет две такие системы.

Источник изображения: NVIDIA Ожидалось, что конфигурация NVL36×2 получит более широкое распространение, нежели NVL72. Дело в том, что дата-центры большинства клиентов NVIDIA не могут удовлетворить требования NVL72 в плане питания и охлаждения. С этой точки зрения NVL36×2 представляет собой компромиссное решение. С другой стороны, NVL72 требует меньше пространства для установки и обладает меньшим суммарным энергопотреблением: каждая из стоек NVL36×2 требует 66 кВт, что в сумме даёт 132 кВт. При этом обеспечивается несколько меньшая производительность. По сведениям Минг-Чи Куо, некоторые заказчики (в частности, Microsoft) отдали предпочтение NVL72 перед NVL36×2. При этом между компании ещё на этапе обсуждения возникли разногласия по поводу конфигурации стоек. Кроме того, для NVIDIA управление тремя разными проектами по созданию суперускорителей на базе GB200 стало сложной задачей. Поэтому от двухстоечной машины решено отказаться. Отмечается также, что массовое производство NVL72 может быть отложено до II половины 2025-го, хотя ранее называлось I полугодие следующего года. Впрочем, отдельные заказчики, включая Microsoft, начнут получать эти системы уже в декабре. |

|