Компания NeuReality на конференции по высокопроизводительным вычислениям SC23 представила полностью интегрированное решение NR1 AI Inference, предназначенное для ИИ-платформ. Изделие спроектировано специально для ускорения инференса и снижения нагрузки на аппаратные ресурсы.

Утверждается, что благодаря использованию технологий NeuReality операторы крупных дата-центров могут на 90 % сократить затраты на выполнение операций ИИ. При этом производительность по сравнению с традиционными системами на основе CPU больше на порядок. Впрочем, конкретные цифры не приводятся.

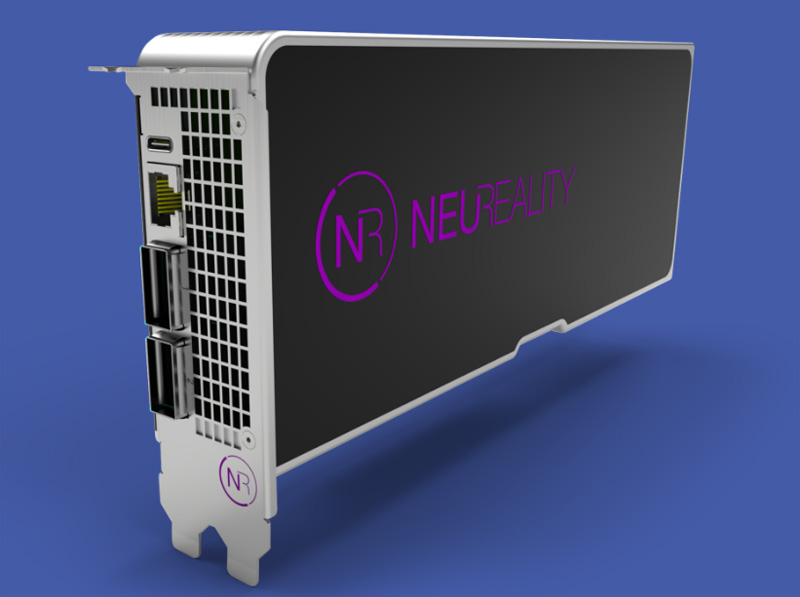

Источник изображений: NeuReality

В продуктовое семейство NeuReality входит решение NR1, которое разработчик называет «сервером на чипе» со встроенным нейросетевым движком. По заявлениям NeuReality, это первый в мире «сетевой адресуемый процессор» — NAPU (Network Addressable Processing Unit). Этот специализированный чип, ориентированный на задачи инференса, обладает возможностями виртуализации и сетевыми функциями.

Изделие NR1 является основой вычислительного модуля NR1-M AI Inference Module, выполненного в виде полноразмерной двухслотовой карты расширения PCIe. Модуль может подключаться к внешнему ускорителю глубокого обучения (DLA). Наконец, анонсирован сервер NR1-S AI Inference Appliance, который оснащается картами NR1-M AI Inference Module. NeuReality отмечает, что данная система позволяет снизить стоимость и энергопотребление почти в 50 раз на операциях инференса по сравнению со стандартными платформами.

Источник: