MosaicML, провайдер инфраструктуры генеративного искусственного интеллекта, основанный бывшими сотрудниками Intel и учёными-исследователями, анонсировал инференс-платформу Mosaic ML Inference и серию моделей MosaicML Foundation Series, которые компании могут задействовать в качестве основы при создании собственных моделей ИИ.

Как сообщается в пресс-релизе, это решение позволит разработчикам быстро, легко и по доступной цене развёртывать генеративные модели ИИ. «Благодаря добавлению возможностей инференса MosaicML теперь предлагает комплексное решение для обучения и развёртывания генеративного ИИ по наиболее эффективной цене, доступной на сегодняшний день», — отмечено в документе. Клиенты MosaicML отметили, что малые модели, обученные на собственных предметно-ориентированных данных, работают лучше, чем большие универсальные модели вроде GPT 3.5.

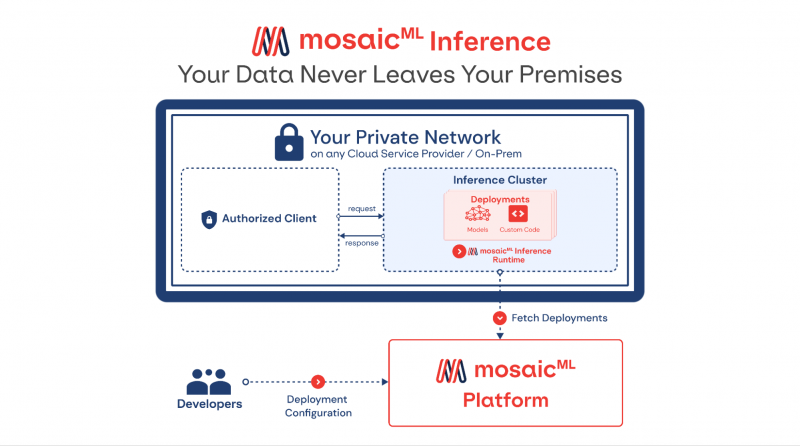

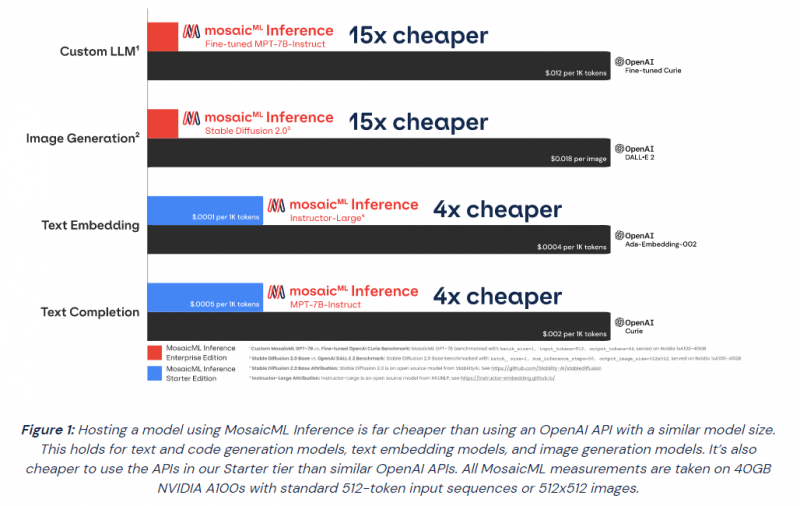

Гендиректор Навин Рао (Naveen Rao) сообщил ресурсу SiliconANGLE, что ценность решения компании для корпоративных клиентов включает два компонента: сохранение конфиденциальности и снижение затрат. Используя решение Inference от MosaicML, клиенты смогут развёртывать ИИ-модели с затратами в четыре раза меньше, чем при использовании большой языковой модели (LLM) от OpenAI, и в 15 раз дешевле при создании изображений, чем при использовании DALL-E 2 этой же компании.

«Мы предоставляем инструменты, работающие в любом облаке, которые позволяют клиентам предварительно обучать, настраивать и обслуживать модели, — сказал Рао. — Если клиент обучает модель, он может быть уверен, что эта модель принадлежит ему». С запуском нового сервиса клиенты MosaicML получают доступ к ряду LLM с открытым исходным кодом, включая Instructor-XL, Dolly и GPTNeoX, которые они могут точно настроить в соответствии со своими потребностями. Все модели получат одинаковую оптимизацию и доступность, что позволит им функционировать с меньшими затратами при развёртывании с помощью MosaicML Inference.

«Это модели с открытым исходным кодом, поэтому клиенты по определению могут настраивать и настраивать и обслуживать их с помощью наших инструментов, — сказал Рао. Компания готова помочь клиентам в работе с их ИИ-моделям. Разработчики смогут выполнять развёртывание в безопасном кластере локально или в облачной инфраструктуре AWS, CoreWeave, Lambda, OCI и GCP. Данные никогда не покидают защищённую среду. Также MosaicML Inference предлагает непрерывный мониторинг метрик кластера.

Кроме того, компания предлагает модель MosaicML Foundational Model, одним из преимуществ которой является очень большое «контекстное окно» — более 64 тыс. токенов или около 50 тыс. слов. Для сравнения, максимальное количество токенов GPT-4 составляет 32 768 или около 25 тыс. слов. Чтобы продемонстрировать работу модели, Рао предоставил ей содержание «Великого Гэтсби» Ф. Скотта Фицджеральда и попросил написать эпилог.

Источники: