Материалы по тегу: ram

|

10.02.2024 [14:50], Сергей Карасёв

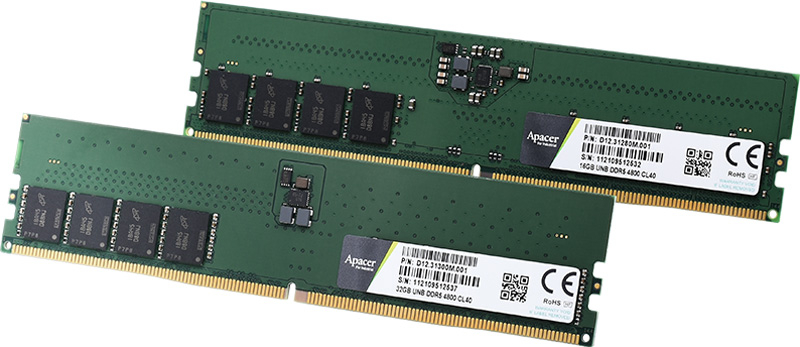

Apacer выпустила экологичные бессвинцовые модули ОЗУ для индустриального сектораКомпания Apacer, сообщила о доступности, как утверждается, первых в мире модулей оперативной памяти стандарта DDR5, компоненты которых полностью не содержат свинца. Изделия превосходят требования действующей директивы защиты окружающей среды RoHS, принятой Европейским союзом. Отмечается, что обычные модули ОЗУ, представленные на рынке, содержат свинец в своих резисторных элементах. Вместе с тем во всём миру принимаются всё более жёсткие экологические нормы, требующие в том числе отказа от применения этого тяжёлого металла.

Источник изображения: Apacer Чтобы решить указанную проблему, компания Apacer после длительного периода исследований и разработок успешно создала полностью бессвинцовые модули памяти с резисторными компонентами нового типа. Эти решения в полной мере соответствуют стандартам RoHS без потери производительности. В семействе представлены модули (ECC) UDIMM, (ECC) SO-DIMM и RDIMM стандарта DDR5-4800/5600. Напряжение питания во всех случаях равно 1,1 В; диапазон рабочих температур простирается от 0 до +85 °C. Изделия UDIMM и SO-DIMM доступны в вариантах ёмкостью 8, 16 и 32 Гбайт, а ECC UDIMM и ECC SO-DIMM — 16 и 32 Гбайт. В случае RDIMM объём варьируется от 16 до 128 Гбайт. В качестве сфер применения модулей названы оборона, автоматизация производства, здравоохранение, Интернет вещей, серверы, сетевое оборудование и пр.

30.12.2023 [21:17], Сергей Карасёв

Samsung и Red Hat впервые в отрасли успешно испытали CXL-память в реальной пользовательской средеКомпания Samsung Electronics в партнёрстве с Red Hat впервые в отрасли успешно проверила работу памяти Compute Express Link (CXL) в реальной пользовательской среде. Это открывает путь для внедрения CXL в существующих дата-центрах для выполнения ресурсоёмких задач, таких как генеративный ИИ, средства автономного вождения и in-memory базы данных. Интерконнект CXL, основанный на интерфейсе PCIe, обеспечивает высокоскоростную передачу данных с малой задержкой между хост-процессором и между такими устройствами, как серверные ускорители, буферы памяти и интеллектуальные IO-блоки. Технология позволяет повысить эффективность серверных платформ при одновременном снижении эксплуатационных расходов.

Источник изображения: Samsung В рамках сотрудничества с Red Hat компания Samsung оптимизировала работу своей памяти CXL на платформе Red Hat Enterprise Linux (RHEL) 9.3. Специалисты проверили распознавание памяти, а также опробовали операции чтения и записи в средах Red Hat KVM и Podman. Полученные результаты говорят о том, что клиенты могут использовать память Samsung CXL в своих ЦОД без необходимости внесения дополнительных изменений в существующее оборудование. Это, как утверждается, важная веха в интеграции аппаратного и программного обеспечения для создания открытой экосистемы с целью внедрения высокоскоростной памяти следующего поколения. Компании Samsung и Red Hat приступили к разработке руководства RHEL 9.3 CXL Memory Enabling Guide, которое поможет заказчикам в создании вычислительных систем с памятью CXL. Отмечается, что Samsung сотрудничает с дата-центрами и поставщиками облачных услуг по всему миру, чтобы лучше удовлетворять их потребность в высокоскоростной памяти большой ёмкости. Меморандум о взаимопонимании (MOU) с Red Hat компания Samsung подписала в мае 2022 года. Партнёрство охватывает широкий спектр решений, включая NVMe-накопители и собственно память CXL.

28.12.2023 [14:16], Сергей Карасёв

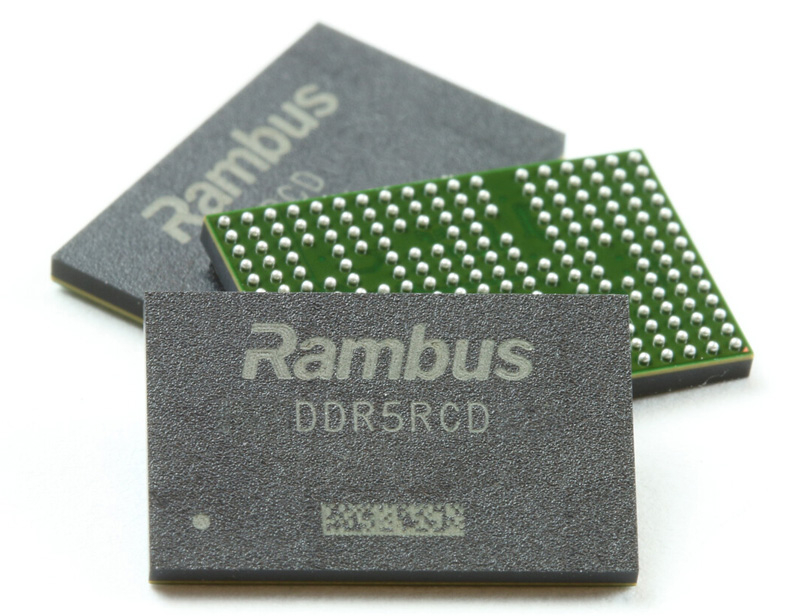

Rambus представила чип RCD для создания серверных модулей DDR5-7200Компания Rambus анонсировала первый в отрасли чип RCD (Registering Clock Driver) четвёртого поколения, предназначенный для создания высокопроизводительных модулей регистровой оперативной памяти DDR5 (RDIMM) для серверов. RCD действует как буфер между компонентами DRAM и контроллером памяти, что позволяет использовать в одном модуле больше компонентов DRAM для достижения более высокой ёмкости. Образцы новинки уже поставляются производителям ОЗУ.

Источник изображения: Rambus Новый чип Rambus RCD позволяет выпускать серверные модули DDR5 RDIMM со скоростью передачи данных до 7200 МТ/с. Прирост производительности, как отмечается, составляет 50 % по сравнению с современными изделиями DDR5-4800. Повышение пропускной способности ОЗУ, по заявлениям Rambus, необходимо для эффективного решения задач в области генеративного ИИ, стремительно набирающего популярность. Кроме того, модули DDR5-7200 помогут ускорить выполнение рабочих нагрузок в дата-центрах.

10.11.2023 [13:32], Сергей Карасёв

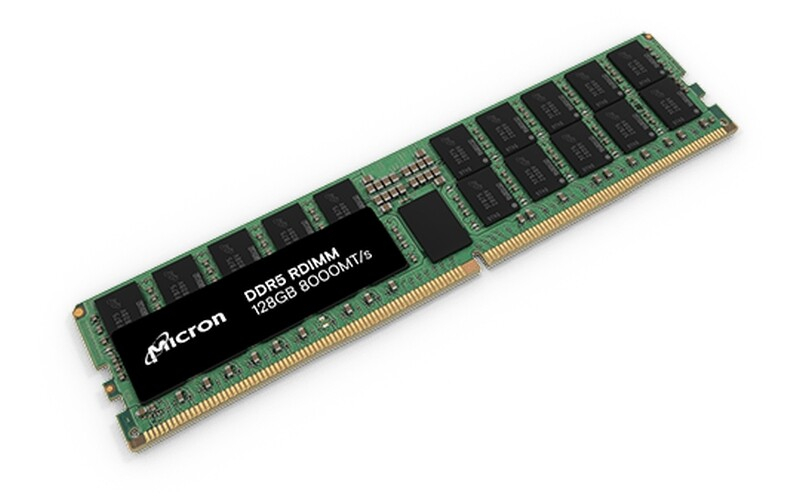

Micron анонсировала RDIMM-модули DDR5-8000 ёмкостью 128 ГбайтКомпания Micron Technology анонсировала модули оперативной памяти DDR5-8000 RDIMM ёмкостью 128 Гбайт для дата-центров и облачных платформ. Изделия рассчитаны на использование в системах с высокими вычислительными нагрузками: это могут быть ресурсоёмкие приложения ИИ, резидентные базы данных и пр. Модули выполнены на основе монолитных чипов на 32 Гбит по технологии 1β (1-бета) — самому передовому технологическому процессу производителя. Применяется инновационная архитектура кристалла, обеспечивающая максимальную эффективность массива, а также самую высокую плотность DRAM.

Источник изображения: Micron Задействованная технология, как утверждается, обеспечивает ряд преимуществ перед конкурирующей 3DS TSV (through-silicon via). Заявлено повышение битовой плотности более чем на 45 %, увеличение энергоэффективности до 24 %, снижение задержек до 16 % и повышение эффективности обучения ИИ до 28 %. Реализована функция управления напряжением питания, которая помогает оптимизировать энергопотребление. Номинальное напряжение VDD, VDDQ и VPP равно соответственно 1,1 В, 1,1 В и 1,8 В. Диапазон рабочих температур простирается от 0 до +95 °C. В 2024 году компания Micron намерена организовать поставки модулей DDR5 RDIMM на 128 Гбайт с частотой 4800, 5600 и 6400 МГц, а позднее появятся изделия с частотой до 8000 МГц.

30.10.2023 [14:33], Сергей Карасёв

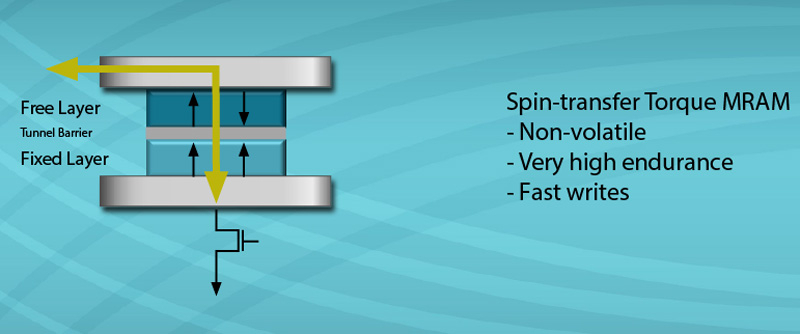

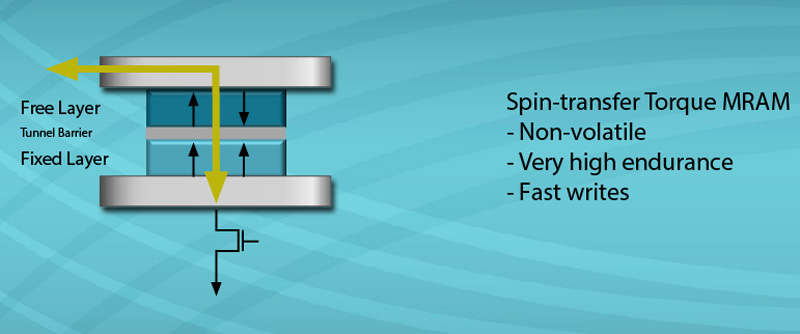

Everspin представила индустриальные чипы STT-MRAM высокой плотностиКомпания Everspin Technologies, разработчик магниторезистивной памяти с произвольным доступом (MRAM), анонсировала новые чипы STT-MRAM высокой плотности семейства EMxxLX. Изделия рассчитаны на применение в устройствах промышленного Интернета вещей, системах автоматизации, медицинских приборах, авиационном оборудовании и пр. Утверждается, что EMxxLX — это наиболее высокопроизводительная энергонезависимая память, доступная в настоящее время на коммерческом рынке. Задействована технология STT-MRAM, то есть запись данных с помощью переноса спинового момента.

Источник изображения: Everspin Память Everspin использует последовательный интерфейс xSPI. Заявленная скорость передачи информации в режимах чтения и записи достигает 400 Мбайт/с через восемь IO-линий с тактовой частотой 200 МГц. Плотность анонсированных изделий варьируется от 4 до 64 Мбит. Использована корпусировка DFN размером 5 × 6 мм, которая обеспечивает экономию площади на 37 % по сравнению с существующими решениями. Диапазон рабочих температур простирается от -40 до +105 °C. Разработчик заявляет, что решения EMxxLX могут стать альтернативой SRAM, BBSRAM, FRAM, NVSRAM и NOR. В настоящее время поставляются образцы EMxxLX ёмкостью 4 Мбит.

21.10.2023 [15:26], Сергей Карасёв

Samsung представила чипы памяти HBM3E с пропускной способностью более 1,2 Тбайт/сКомпания Samsung Electronics в ходе ежегодного мероприятия Memory Tech Day сообщила о начале поставок образцов микросхем памяти HBM3E нового поколения с кодовым названием Shinebolt. Утверждается, что изделия Shinebolt обеспечивают прирост производительности примерно на 50 % по сравнению с чипами HBM3E предыдущего поколения (Icebolt). Пропускная способность в расчёте на контакт достигает 9,8 Гбит/с против 6,4 Гбит/с у Icebolt.

Источник изображения: Samsung Таким образом, общая пропускная способность микросхем Shinebolt составляет до 1,228 Тбайт/с. Это позволяет использовать память в высоконагруженных системах, обрабатывающих приложения генеративного ИИ и машинного обучения. С целью повышения плотности компоновки и улучшения тепловых характеристик Samsung оптимизировала свою технологию непроводящей пленки (NCF): это позволило минимизировать зазоры между слоями чипа и максимизировать теплопроводность. Samsung планирует производить 12-ярусные чипы Shinebolt с максимальной ёмкостью 36 Гбайт. Среди других продуктов, представленных компанией Samsung на мероприятии Memory Tech Day, — 32-гигабитные чипы DDR5 DRAM, первая в отрасли память GDDR7 с пропускной способностью 32 Гбит/с и архитектура PBSSD для создания решений «петабайтного класса».

11.09.2023 [18:20], Сергей Карасёв

TeamGroup представила индустриальные низкопрофильные модули DDR5-4800/5600 ёмкостью до 48 ГбайтКомпания TeamGroup анонсировала модули оперативной памяти DDR5 VLP ECC U-DIMM, предназначенные для использования в дата-центрах. Особенностью изделий является низкопрофильное исполнение, благодаря чему они могут устанавливаться в устройства с ограниченным пространством внутри корпуса, например, в blade-серверы. Модули доступны в модификациях DDR5-4800 и DDR5-5600. Ёмкость варьируется от 16 до 48 Гбайт. Высота изделий DDR5 VLP ECC U-DIMM составляет только 18,7 мм.

Источник изображения: TeamGroup Применяя запатентованную технологию тестирования микросхем, TeamGroup отбирает наиболее качественные чипы, чтобы обеспечить стабильность и надёжность, а также минимизировать количество сбоев. Предусмотрены варианты со стандартным и расширенным диапазоном рабочих температур: во втором случае он простирается от -40 до +85 °C. Защита от серы и специальное покрытие позволяют эксплуатировать модули в неблагоприятных условиях. Компания TeamGroup отмечает, что продолжает активно заниматься исследованиями и разработками в области памяти DDR5, тесно сотрудничая с участниками рынка. Это гарантирует совместимость с различными аппаратными платформами, включая решения промышленного класса, сообщается в пресс-релизе.

08.09.2023 [11:23], Сергей Карасёв

Производитель MRAM-продуктов Everspin девятый квартал подряд получает прибыль, но очень скромнуюКомпания Everspin Technologies, разработчик магниторезистивной памяти с произвольным доступом (MRAM), обнародовала показатели деятельности во II четверти 2023 года, которая была закрыта 30 июня. Общая выручка составила $15,7 млн, что на 7 % большее прошлогоднего результата, равного $14,7 млн. Продажи MRAM-продуктов, включая Toggle MRAM и STT-MRAM, за трёхмесячный период оказались на уровне $13,4 млн. Это незначительно больше результата годичной давности, когда соответствующие изделия принесли $13,2 млн.

Источник изображения: Everspin Денежные поступления от лицензирования, выплаты роялти и других направлений деятельности составили около $2,3 млн, тогда как во II квартале 2022 года этот показатель был зафиксирован на отметке около $1,5 млн. Чистая квартальная прибыль, рассчитанная в соответствии с общепризнанными принципами бухгалтерского учёта (GAAP), достигла $3,9 млн, или приблизительно $0,19 в пересчёте на одну ценную бумагу. Для сравнения: годом ранее эти показатели равнялись соответственно $1,7 млн и $0,08. Таким образом, Everspin увеличила чистую прибыль более чем в два раза. В целом, компания сохраняет прибыльность девять кварталов подряд, что говорит об устойчивости бизнеса. В текущем квартале Everspin рассчитывает показать выручку от $15,4 млн до $16,4 млн. Чистая прибыль, как ожидается, будет лежать в диапазоне от $0,01 до $0,06 на одну ценную бумагу.

21.08.2023 [10:17], Сергей Карасёв

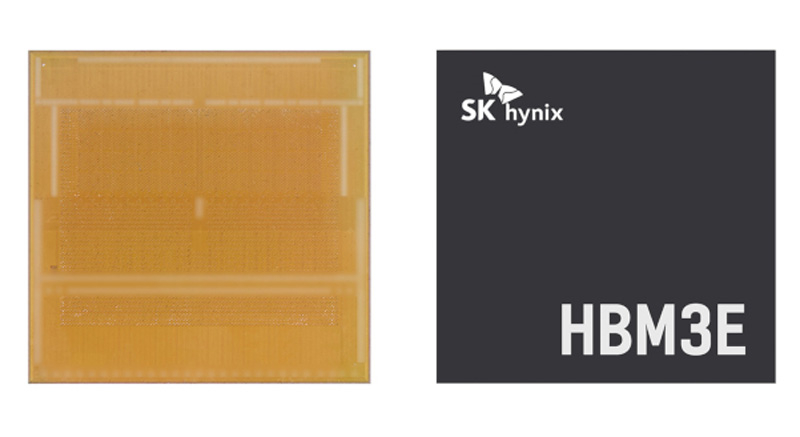

SK hynix заявила о создании самой быстрой в мире памяти HBM3EКомпания SK hynix объявила о разработке самой высокопроизводительной в мире памяти HBM3E, предназначенной для использования в современных ИИ-системах. Образцы изделий уже поставляются отдельным заказчикам для оценки технических характеристик. HBM3E — это пятое поколение памяти данного типа, приходящее на смену изделиям HBM, HBM2, HBM2E и HBM3. HBM3E представляет собой улучшенную версию HBM3. Массовое производство HBM3E компания SK hynix намерена организовать в первой половине следующего года.

Источник изображения: SK hynix По заявлениям разработчика, память HBM3E соответствует самым высоким отраслевым стандартам скорости передачи данных. Таким образом, изделия подходят для применения в наиболее нагруженных ИИ-платформах. Кроме того, при создании памяти были учтены жёсткие требования в плане рассеяния тепла. Утверждается, что изделия HBM3E способны перемещать информацию со скоростью до 1,15 Тбайт/с. При изготовлении чипов компания SK hynix применяет технологию Advanced Mass Reflow Molded Underfill (MR-MUF), представляющую собой метод объединения нескольких чипов памяти на одной подложке посредством спайки. Это даёт возможность улучшить теплоотведение приблизительно на 10%. Говорится об обратной совместимости с HBM3, что упрощает внедрение новой памяти. По оценкам, доля SK hynix на мировом рынке памяти HBM по итогам 2022 года составила приблизительно 50 %. В текущем году, как ожидается, этот показатель окажется на уровне 46–49 %, в 2024 году — 47–49 %.

20.08.2023 [11:10], Сергей Карасёв

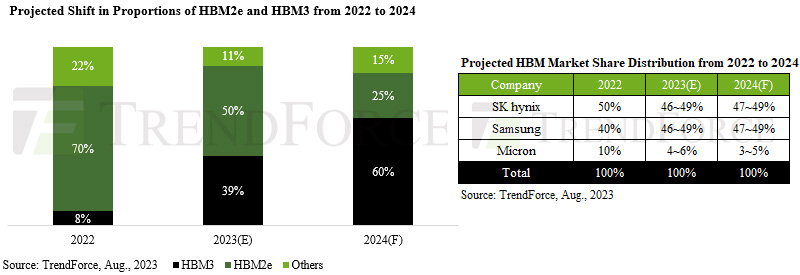

Поставки HBM-памяти в 2024 году вырастут вдвоеКомпания TrendForce опубликовала свежий прогноз по глобальному рынку чипов памяти HBM: аналитики полагают, что спрос на эту продукцию будет быстро расти на фоне стремительно развивающихся ИИ-технологий. Объём поставок HBM в 2024 году может увеличиться на 105 % по сравнению с 2023-м, при этом ожидается смещение фокуса с изделий HBM2e в сторону HBM3. В 2022 году, как отмечает TrendForce, около 70 % поставок пришлось на чипы HBM2e, тогда как доля HBM3 составила только 8 %. В 2023-м, как ожидается, эти показатели окажутся на уровне 50 % и 39 % соответственно. А в 2024 году решения HBM3 уйдут в отрыв, показав результат примерно 60 % против 25 % у HBM2e.

Источник изображения: TrendForce Анализ TrendForce показывает, что 2023–2024 гг. станут ключевыми для развития ИИ, что вызовет значительный рост спроса на чипы HBM. Однако надвигающийся бум производства HBM поставил поставщиков в затруднительное положение: им необходимо найти баланс между удовлетворением потребностей клиентов и недопущением формирования складских излишков из-за перепроизводства. Ещё одной проблемой является потенциальный риск «раздутого» бронирования, поскольку заказчики, ожидающие нехватку HBM, могут переоценить свои потребности. В настоящее время SK hynix удерживает лидерство в производстве HBM, выступая в качестве основного поставщика таких чипов для ускорителей NVIDIA. Доля SK hynix по итогам 2022 года составила приблизительно 50 %. Ещё 40 % досталось Samsung, оставшиеся 10 % — Micron. В 2023 году, полагает TrendForce, доли SK hynix и Samsung будут колебаться в пределах 46–49 %, а доля Micron составит 4–6 %. В следующем году, согласно прогнозам, позиции SK hynix и Samsung окажутся в диапазоне 47–49 %. Micron будет удерживать 3–5 % отрасли. Несмотря на то, что поставщики ещё не завершили разработку своих ценовых политик на 2024 год, TrendForce не исключает возможности дальнейшего снижения цен на продукты HBM2 и HBM2e. А вот цены на HBM3, по прогнозам, останутся такими же, как и в 2023 году. |

|