Материалы по тегу: cxl

|

08.04.2024 [09:48], Сергей Карасёв

CXL из коробки: Samsung представила стоечный массив памяти CMM-BКомпания Samsung анонсировала решение под названием CXL Memory Module — Box (CMM-B): это массив модулей памяти CXL, предназначенный для монтажа в стойку. Новинка совместима с решениями Supermicro Plug and Play. В состав CMM-B входят восемь пулов CXL-памяти на базе модулей E3.S CMM-D (PCIe 5.0) ёмкостью 2 Тбайт каждый. Таким образом, суммарный объём достигает 16 Тбайт. В составе стойки доступ к этому массиву могут получать три сервера Supermicro. Такая архитектура позволяет выделять необходимый объём памяти в соответствии с текущими нагрузками, устраняя узкие места в вычислительных системах. Через консоль SCMC (Samsung Cognos Management Console) можно отслеживать распределение памяти.

Источник изображений: Samsung Устройство CMM-B выполнено в формате 4U. Заявлена совместимость со стандартами CXL 1.1/2.0. Пропускная способность достигает 60 Гбайт/с, тогда как задержка находится на уровне 596 нс. С точки зрения «чистой» производительности один модуль CMM-B работает медленнее, чем двухканальная подсистема оперативной памяти DDR5-4800. Тем не менее, устройство значительно быстрее, чем даже наиболее передовые SSD.  Представленная стоечная система разработана в тесном сотрудничестве с Supermicro. В состав решения, помимо CMM-B и трёх серверов, входит PCIe-коммутатор. Система предназначена для приложений, которым требуется большой объём памяти, таких как ИИ, анализ массивов информации и in-memory базы данных. CMM-B позволяет динамически выделять необходимую память системе, когда она необходима ей. Благодаря этому повышается гибкость использования инфраструктуры и снижаются энергетические затраты, говорят создатели.

14.03.2024 [23:45], Алексей Степин

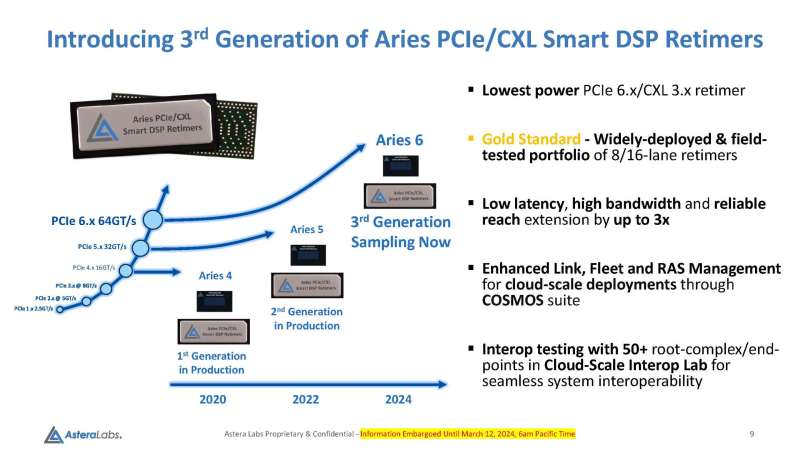

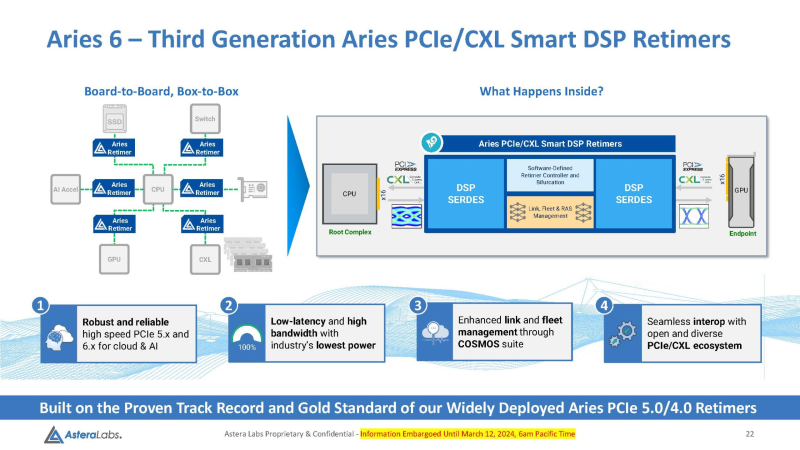

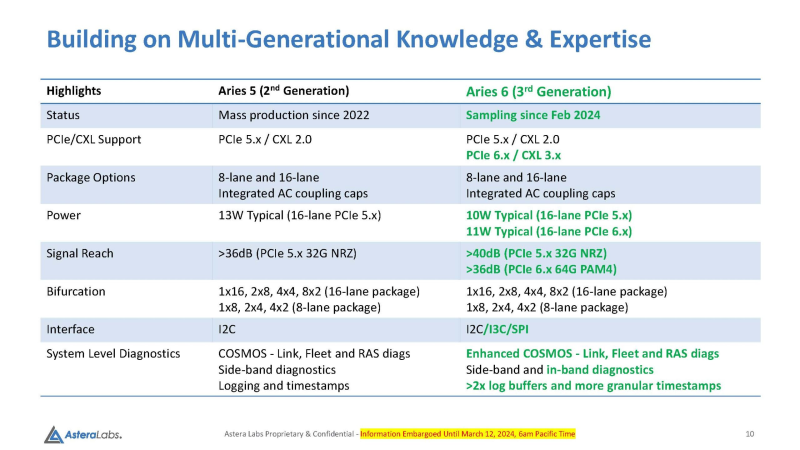

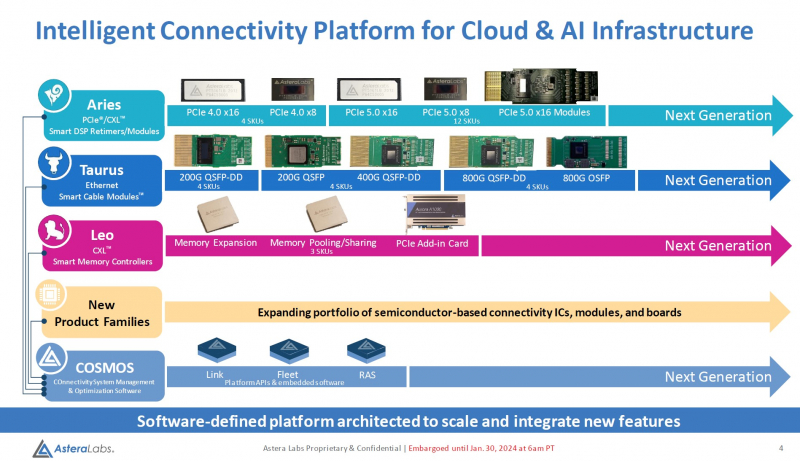

Войны ретаймеров: Astera Labs анонсировала чипы Aries 6 для PCIe 6.0Практически сразу после анонса чипов Broadcom Vantage 5 и 6 Astera представила свой вариант ретаймеров для инфраструктуры PCIe следующего поколения — серию чипов Aries 6, передаёт ServeTheHome. Высокий интерес к ретаймерам вызван теми возможностями, что открывает PCI Express 6.0 как в плане скоростей, так и в плане функциональности (CXL). А переход на новое поколение шины необходим для дальнейшего развития набирающего популярность генеративного ИИ. По мере роста скоростей PCI Express обострялась и проблема длины проводников на печатной плате, при которой сигнал достаточно устойчив и вписывается в окно требуемых характеристик. Если при переходе от PCIe 3.0 к 4.0 удалось обойтись сравнительно малой кровью, то для PCIe 5.0 уже потребовались более сложная схемотехника и более продвинутые ретаймеры. PCIe 6.0 же накладывает ещё более жёсткие требования к целостности сигнала. Платформы GPU-кластеров и СХД компактнее не становятся, так что требуемая длина проводников на печатных платах растёт, а вместе с ней растёт и важность ретаймеров, поскольку без них согласовать высокоскоростной сигнал PCIe 6.0 становится невозможно. Таким системам требуется сразу несколько подобных чипов, причём стоимость каждого из них достигает $20, так что суммарная стоимость этих компонентов на уровне целого ЦОД весьма внушительна. Новые чипы Aries 6 относятся к третьему поколению «умных» DSP-ретаймеров. Они представлены в вариантах с 8 и 16 линиями PCIe 6.0 и позволяют в три раза увеличить длину соответствующего соединения на плате, говорит Astera Labs. При этом новинки поддерживают CXL 3.x и предоставляют расширенные средства диагностики и управления COSMOS. Энергопотребление в режиме PCIe 6.0 при этом заявлено меньше, чем у Broadcom Vantage 6 — 11 Вт против 13 Вт у конкурента. Aries 6 уже протестированы на совместимость с полсотней разнообразных PCIe-соединений, включая root-комплексы и конечные устройства. И если Broadcom пока только говорит о ретаймерах для PCIe 6.0, а появление первого «кремния» Vantage 6 запланировано лишь на следующий год, то Astera Labs начала поставки образцов Aries 6 ещё в феврале. Похоже, Broadcom будет нелегко развернуться на этом рынке.

08.03.2024 [00:03], Алексей Степин

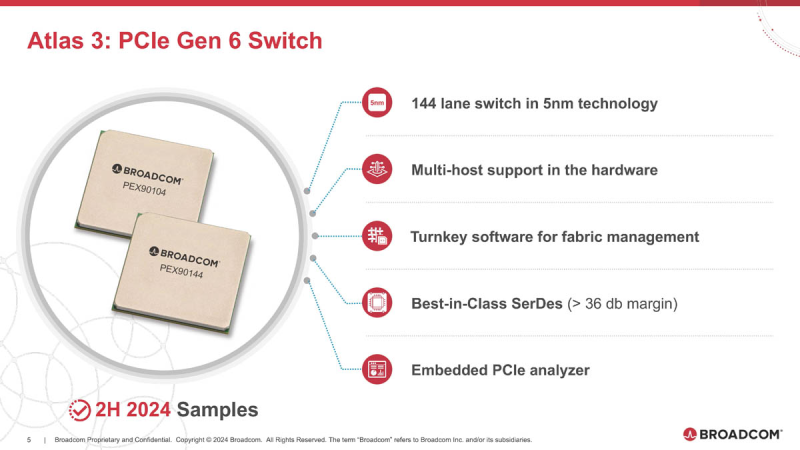

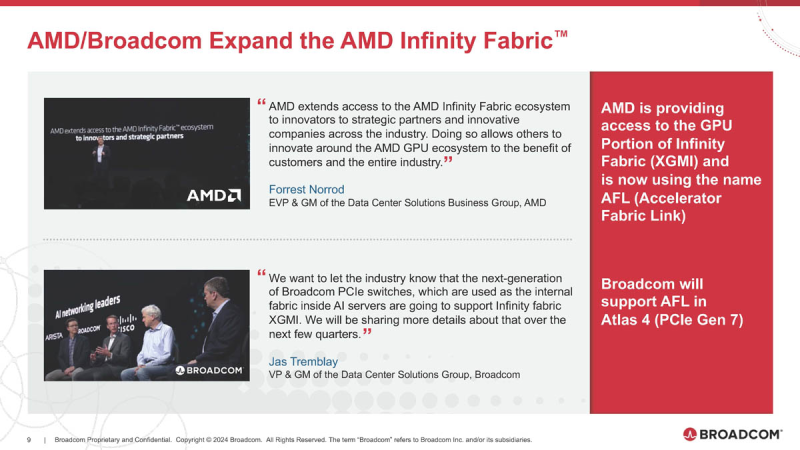

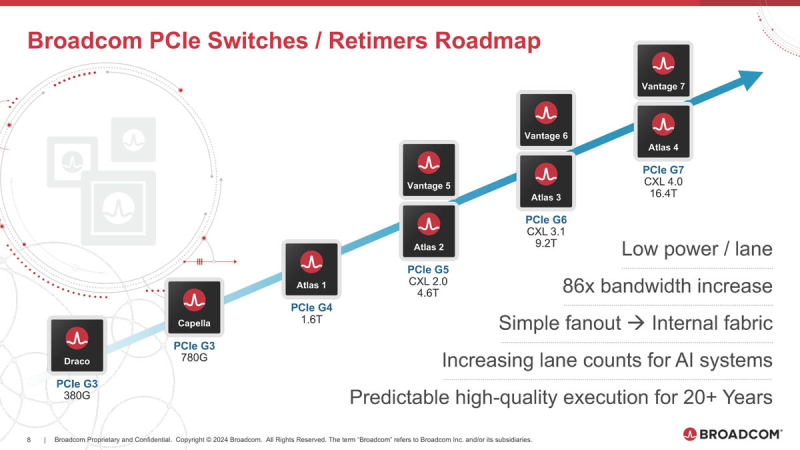

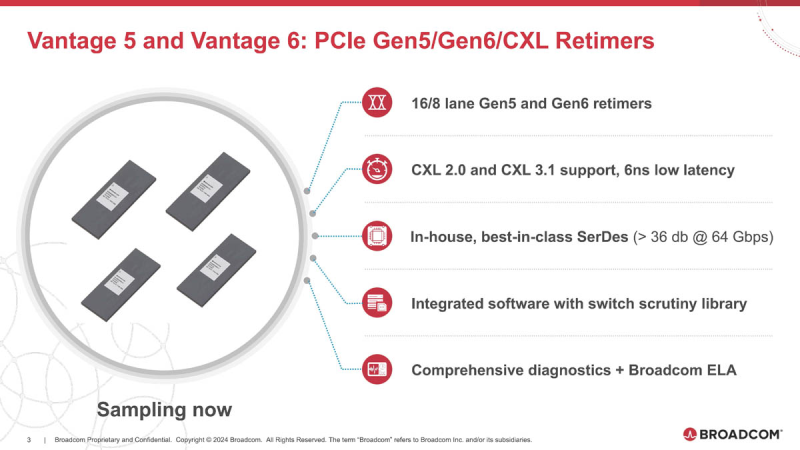

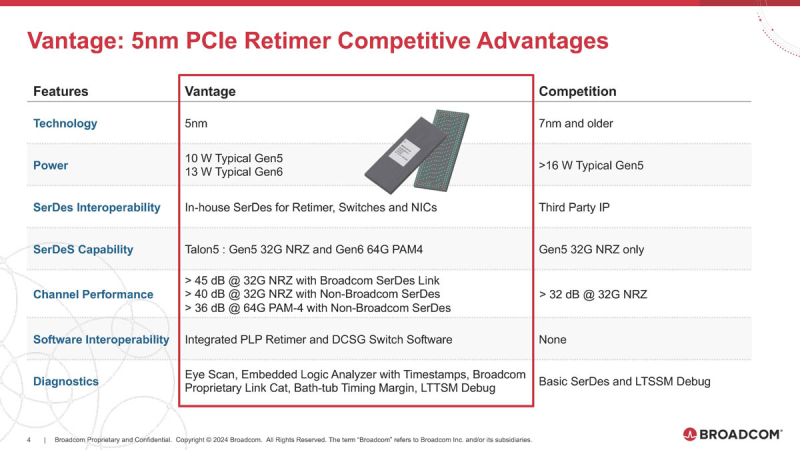

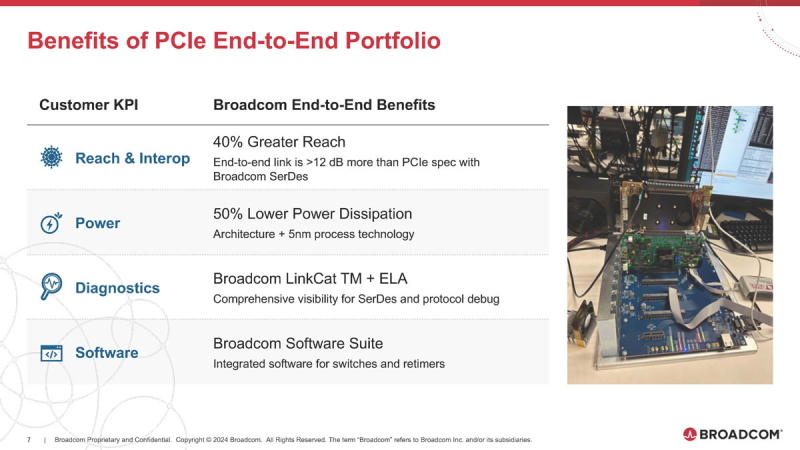

Broadcom готовит чипы для PCIe 6.0/7.0 с поддержкой AMD Infinity FabricОдним из столпов, на которых зиждется господство NVIDIA в мире ускорителей, является NVLink — высокоскоростной интерконнект, позволяющий чипам общаться напрямую не только в составе одного узла, но и за его пределами. AMD пытается ответить на это продвижением XGMI/Infinity Fabric, и в предварительном обзоре Instinct MI300 были затронуты вопросы топологии серверов в исполнении «красных». Ещё тогда, в момент анонса MI300, компания Broadcom объявила о поддержке данного интерконнекта в будущих поколениях своих PCIe-коммутаторов, а сейчас ресурс ServeTheHome поделился новыми подробностями. XGMI действительно станет коммутируемым, что упростит масштабирование систем на базе ускорителей AMD Instinct. Интерконнект получил официально название AFL (Accelerated Fabric Link). В основе AFL по-прежнему будет лежать PCI Express, в данном случае речь идёт уже о PCI Express 7.0. Поддержка данной технологии дебютирует в PCIe-коммутаторах Broadcom Atlas 4. В дополнение к ним будут выпущены и новые ретаймеры Vantage 7, которые также получат поддержку CXL 4.0. Но перед этим Broadcom начнёт поставки образцов чипов-коммутаторов Atlas 3 со 144 линиями PCIe 6.0 во II половине 2024 года, а серверы с такими коммутаторами появятся в 2025 году. Поддержка CXL здесь будет расширена до версии 3.1. Что касается ретаймеров, то здесь Broadcom уже нанесла ответный удар Astera Labs, анонсировав чипы серий Vantage 5 и Vantage 6 для экосистем PCI Express 5.0 и PCI Express 6.0 соответственно. Они будут выпускаться в вариантах с 8 и 16 линиями с опцией бифуркации и поддержкой CXL 2.0 и 3.1. Broadcom заявляет о более низком энергопотреблении, достигнутом за счёт применения 5-нм техпроцесса, лучших в индустрии блоках SerDes и расширенных средствах диагностики, интегрированных в новые ретаймеры. Экономичность здесь играет важную роль: хотя даже 7-нм ретаймер потребляет немного, таких микросхем в составе каждого GPU-сервера несколько, что при дальнейшем масштабировании выливается весьма серьёзные цифры. К тому же меньшая нагрузка ляжет и на систему охлаждения, ведь если CPU и ускорители могут обслуживаться СЖО, то остальные компоненты в таких серверах по-прежнему охлаждаются обычными вентиляторами. Что касается SerDes-блоков, то они позволят на 40 % удлинить соединения при сохранении стабильной работы. Ну а наличие продвинутого диагностического программного обеспечения с расширенными возможностями упростит разработку, отладку и ремонт систем нового поколения. Ретаймеры Vantage 5 будут использоваться в комплекте с коммутаторами Atlas 2 в решениях Broadcom уже сегодня, они обеспечат поддержку CXL 2.0, ну а системы с Vantage 6 и поддержкой CXL 3.1, как уже упоминалось, должны увидеть свет в следующем году. Astera Labs есть о чём беспокоиться: если на данный момент её ретаймерам почти нет альтернативы, то уже в ближайшем будущем ситуация может коренным образом измениться, поскольку Broadcom явно осознала всю важность этого компонента в экосистеме PCI Express и оценила солидный объём потенциальной клиентской базы.

13.02.2024 [22:21], Алексей Степин

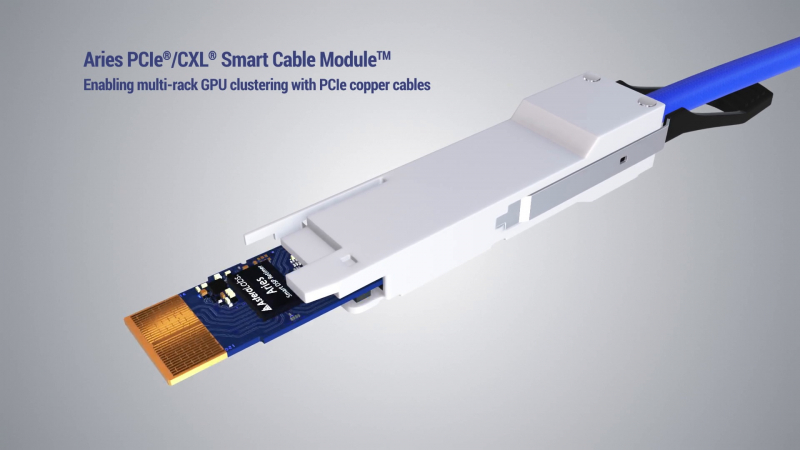

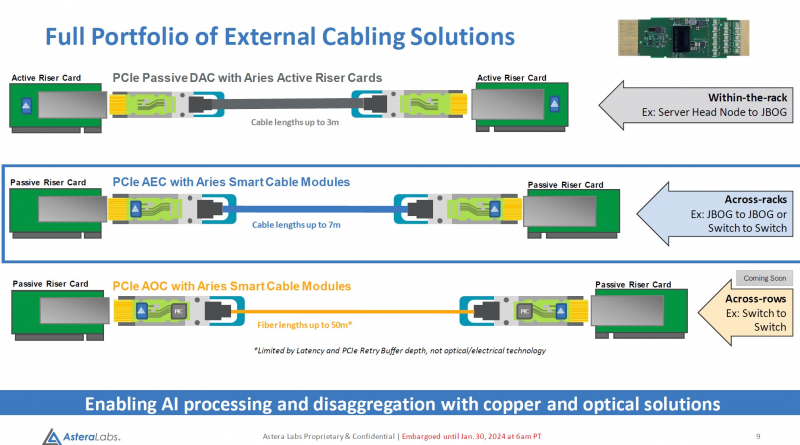

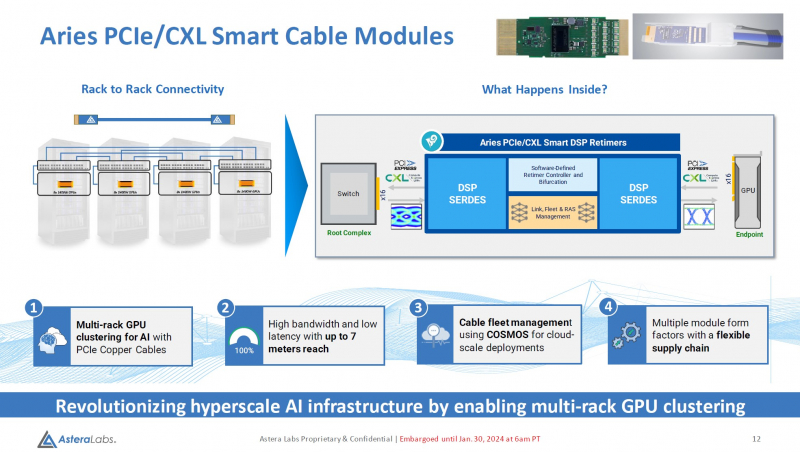

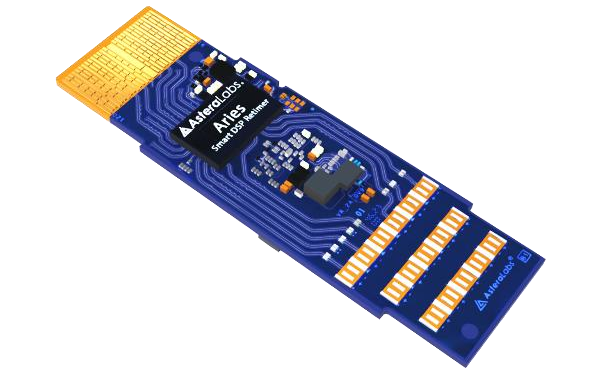

Дотянуться до GPU: Astera Labs представила кабельные модули Aries для PCIe 5.0 и CXLРазвитие пула технологий CXL естественным образом вызывает необходимость в разработке соответствующей кабельной инфраструктуры. Активные оптические кабели достаточно дороги для того, чтобы использовать их на соединениях малой длины, а полностью пассивная «медь» неизбежно потребует установки дополнительных ретаймеров. Astera Labs, разработчик решений для CXL, предлагает решить эту проблему путём использования активных медных кабелей, оснащённых встроенными ретаймерами.

Изображение: Astera Labs Новый тип кабельных модулей получил название Aries PCIe/CXL Smart Cable, он гарантирует устойчивую работу при длине соединения до 7 м, в то время как PCIe 5.0-совместимая пассивная «медь» работоспособна лишь на длинах до 3 м. В основу легли разработанные ещё в 2022 году ретаймеры серии Aries, представленные в рамках анонса целого портфолио решений с поддержкой CXL. Все решения Astera Labs поддерживают единую программно-аппаратную платформу COSMOS, отвечающую за управление и телеметрию, что должно упростить развёртывание и эксплуатацию крупномасштабных систем на базе PCIe/CXL-интерконнекта любой сложности, от комплексов GPU-кластеризации до пулов CXL-памяти. Сами ретаймеры Aries несмотря на свою компактность, представляют собой сложные устройства с достаточно производительными для работы на скоростях PCIe 5.0 сигнальными процессорами (DSP). Помимо DSP в состав чипа входит блок телеметрии и удалённого управления и программно-определяемый контроллер, отвечающий за режимы бифуркации. Применение «умных» медных кабелей Astera упростит и удешевит конструкцию систем с более чем одной стойкой, а также позволит использовать более разнообразные варианты топологии. Для подключений длиной более 7 м компания ведёт разработку активных оптических соединителей. Стоит отметить, что готовые кабели Astera Labs не продаёт. Она поставляет кабельные модули, которые гиперскейлеры и ОЕМ-производители вольны использовать в своих решениях так, как им представляется необходимым.

30.12.2023 [21:17], Сергей Карасёв

Samsung и Red Hat впервые в отрасли успешно испытали CXL-память в реальной пользовательской средеКомпания Samsung Electronics в партнёрстве с Red Hat впервые в отрасли успешно проверила работу памяти Compute Express Link (CXL) в реальной пользовательской среде. Это открывает путь для внедрения CXL в существующих дата-центрах для выполнения ресурсоёмких задач, таких как генеративный ИИ, средства автономного вождения и in-memory базы данных. Интерконнект CXL, основанный на интерфейсе PCIe, обеспечивает высокоскоростную передачу данных с малой задержкой между хост-процессором и между такими устройствами, как серверные ускорители, буферы памяти и интеллектуальные IO-блоки. Технология позволяет повысить эффективность серверных платформ при одновременном снижении эксплуатационных расходов.

Источник изображения: Samsung В рамках сотрудничества с Red Hat компания Samsung оптимизировала работу своей памяти CXL на платформе Red Hat Enterprise Linux (RHEL) 9.3. Специалисты проверили распознавание памяти, а также опробовали операции чтения и записи в средах Red Hat KVM и Podman. Полученные результаты говорят о том, что клиенты могут использовать память Samsung CXL в своих ЦОД без необходимости внесения дополнительных изменений в существующее оборудование. Это, как утверждается, важная веха в интеграции аппаратного и программного обеспечения для создания открытой экосистемы с целью внедрения высокоскоростной памяти следующего поколения. Компании Samsung и Red Hat приступили к разработке руководства RHEL 9.3 CXL Memory Enabling Guide, которое поможет заказчикам в создании вычислительных систем с памятью CXL. Отмечается, что Samsung сотрудничает с дата-центрами и поставщиками облачных услуг по всему миру, чтобы лучше удовлетворять их потребность в высокоскоростной памяти большой ёмкости. Меморандум о взаимопонимании (MOU) с Red Hat компания Samsung подписала в мае 2022 года. Партнёрство охватывает широкий спектр решений, включая NVMe-накопители и собственно память CXL.

13.10.2023 [00:45], Владимир Мироненко

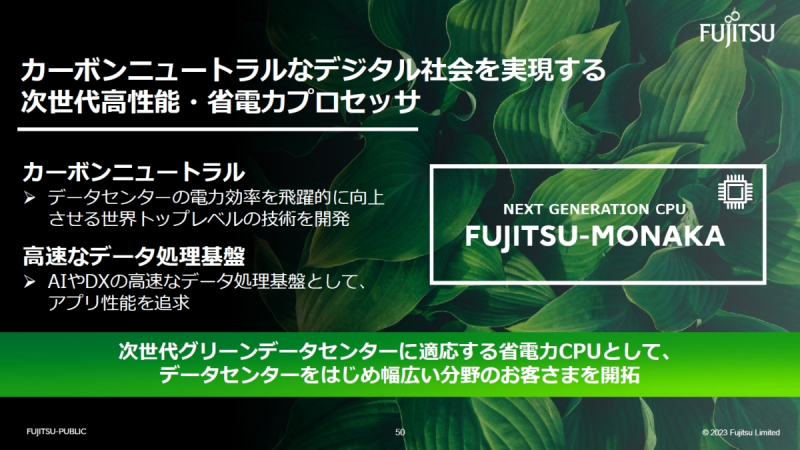

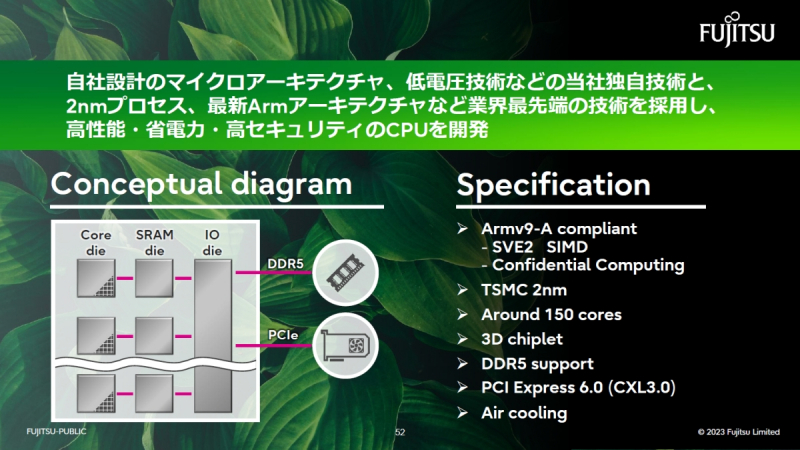

Fujitsu готовит 2-нм 150-ядерный серверный Arm-процессор MONAKA с поддержкой PCIe 6.0 и CXL 3.0Fujitsu провела на этой неделе брифинг для СМИ и аналитиков на заводе в Кавасаки, на котором рассказала о разработке серверного процессора MONAKA, появление которого на рынке запланировано в 2027 году, пишет ресурс MONOist. Впервые о создании нового поколения CPU компания объявила весной этого года, а часть средств на разработку выделило правительство Японии. Как сообщил Наоки Синдзё (Naoki Shinjo), гендиректор подразделения развития передовых технологий Fujitsu, MONAKA представляет собой высокопроизводительный энергоэффективынй процессор нового поколения, который разрабатывается для значительного повышения энергоэффективности ЦОД и обеспечения высокоскоростной обработки данных, необходимой для приложений ИИ и цифровой трансформации. MONAKA будет основан на процессорной архитектуре Arm с набором инструкций Armv9-A с поддержкой масштабируемых векторных расширений SVE2. Он будет представлять собой 3D-сборку из чиплетов, а и его изготовление будет осуществляться с использованием 2-нм техпроцесса TSMC. По словам Синдзё, у процессора будет около 150 ядер, поддержка памяти DDR5 и интерфейс PCIe 6.0 с CXL 3.0. При этом для работы ему будет достаточно воздушного охлаждения. Fujitsu ожидает, что MONAKA будет в два раза превосходить по энергоэффективности чипы конкурентов и во столько же раз опережать конкурентов по скорости обработки данных в области вычислений, ориентированных на рабочие нагрузки ИИ. За обеспечение безопасности данных в Armv9-A отвечает архитектура конфиденциальных вычислений Arm Confidential Compute Architecture (CCA). Также сообщается, что в суперкомпьютере-преемнике Fugaku, который будет запущен в 2030 году, будут использоваться процессоры, разработанные с применением технологий, задействованных в MONAKA. В отличие от узкоспециализированных HPC-процессоров FUjitsu A64FX, которые легли в основу Fugaku, чипы MONAKA являются более универсальными решениями.

13.09.2023 [14:57], Сергей Карасёв

Разработчик CXL-платформы для ИИ Enfabrica получил $125 млн финансированияСтартап Enfabrica, специализирующийся на разработке инфраструктурных решений в сфере ИИ, по сообщению ресурса SiliconAngle, провёл крупный раунд финансирования Series B и привлёк $125 млн. Enfabrica, основанная в 2020 году, вышла из режима скрытности в начале 2023-го на фоне ИИ-бума. Раунд Series B проводится под руководством Atreides Management с участием Sutter Hill Ventures, IAG Capital Partners, Liberty Global Ventures, NVIDIA, Valor Equity Partners и Alumni Ventures. Стартап заявляет, что его технологии могут помочь в решении критически важных проблем ввода-вывода и масштабирования памяти, которые становятся все более актуальными по мере стремительного роста размера ИИ-моделей. Enfabrica предлагает CXL-платформу Accelerated Compute Fabric (ACF) на базе ASIC собственной разработки. Платформа позволяет напрямую подключать другу к другу любую комбинацию GPU, CPU, DDR5 CXL и SSD, а также предоставляет 800GbE-интерконнект.

Источник изображения: Enfabrica Утверждается, что заказчики могут сократить затраты на вычисления до 50 % при работе с большими языковыми моделями (LLM) и до 75 % в случае рекомендательных систем на основе машинного обучения. В целом, заказчикам обещаны двукратное увеличение производительности на доллар, повышение пропускной способности в 10 раз по сравнению со стандартными сетевыми картами и четырёхкратное улучшение производительности на ватт затрачиваемой энергии.

27.08.2023 [11:22], Сергей Карасёв

H3C и Montage объединили усилия с целью развития технологии CXLКитайская корпорация New H3C Group (H3C), специализирующаяся на выпуске серверов и другого оборудования корпоративного класса, и компания Montage Technology сообщили о заключении соглашения о стратегическом сотрудничестве. Оно распространяется на технологию Compute Express Link (CXL) и другие инновационные разработки. Напомним, CXL — высокоскоростной интерконнект, отвечающий за взаимодействие хост-процессора с акселераторами, буферами памяти, умными устройствами ввода/вывода и пр. В основе CXL лежат физический и электрический интерфейсы PCIe.

Источник изображения: H3C По условиям договора, H3C Group будет использовать процессоры Montage Jintide в своих вычислительных платформах, СХД, сетевых устройствах и системах обеспечения безопасности. В этих чипах реализованы технологии PrC и DSC, которые обеспечивают различные уровни аппаратной защиты. Кроме того, Montage одной из первых в мире представила CXL-решения. Стороны намерены совместно вести исследования в области передовых технологий, а также разрабатывать более экономичные серверные продукты с улучшенными вычислительными возможностями и решения общего назначения с конвергентной вычислительной архитектурой. В совместном заявлении H3C и Montage Technology говорится, что договор станет новой отправной точкой для компаний в достижении взаимовыгодного сотрудничества. Стороны намерены интегрировать свои существующие наработки, ресурсы и технологии для ускорения создания и вывода на рынок передовых продуктов, отвечающих потребностям различных отраслей промышленности.

14.08.2023 [17:37], Алексей Степин

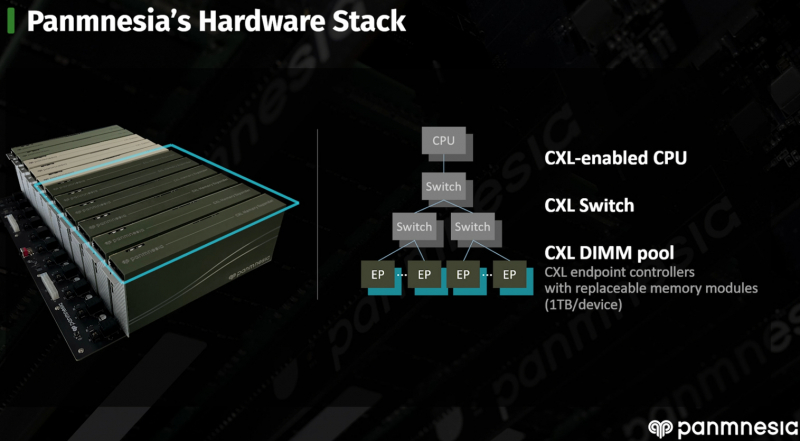

CXL-пул Panmnesia втрое быстрее RDMA-систем и может предложить 6 Тбайт RAMНа конференции Flash Memory Summit южнокорейская компания Panmnesia продемонстрировала свою версию CXL-пула DRAM объёмом 6 Тбайт на базе программно-аппаратного стека собственной разработки. Новинка продемонстрировала более чем троекратное превосходство над системой, построенной на базе технологии RDMA, в нагрузках, связанной с работой рекомендательной ИИ-системы Meta✴. Panmnesia разработана в сотрудничестве с Корейским инститом передовых технологий (KAIST). О более раннем варианте разработок KAIST в этой области мы рассказывали в 2022 году. Коммерческий вариант комплекса поддерживает CXL 3.0 и состоит из CXL-процессора, коммутатора и модулей расширения памяти. Все модули выполнены в форм-факторе, чрезвычайно напоминающем FHFL-карты. Модули устанавливаются в универсальное шасси, при этом их можно произвольно комбинировать. Демо-платформа содержала два процессорных модуля, три модуля коммутации и шесть 1-Тбайт модулей памяти. Модули памяти построены на базе обыкновенных DIMM-планок и поддерживают их замену и расширение. Реализован не только режима CXL.mem, но и CXL.cache и CXL.io. При этом компания предлагает не только готовые IP-решения, но и их кастомизацию под конкретного заказчика, что поможет оптимизировать цикл создания продукта и снизить общую стоимость разработки и валидации. Фирменное ПО базируется на Linux и содержит необходимые драйверы, а также специализированную виртуальную машину, с помощью которой пространство памяти представляется в виде безпроцессорного NUMA-узла. Поверх этих компонентов функционирует пользовательская часть, отвечающая за эффективное размещение и предвыборку (prefetching) данных. По ряду параметров Panmnesia можно назвать лидером в области CXL-решений. В частности, по объёму DRAM она уже обгоняет совместное решение Samsung, MemVerge, H3 и XConn, а использование DIMM-модулей только придаёт ей гибкости. Развитая программная часть, как утверждается, упрощает и удешевляет интеграцию в существующую инфраструктуру ЦОД. Спектр применения, как и у всех систем CXL-пулинга, крайне широкий и включает в себя не только ИИ-сценарии, но и любые задачи, требующие большого объёма оперативной памяти.

12.08.2023 [00:00], Алексей Степин

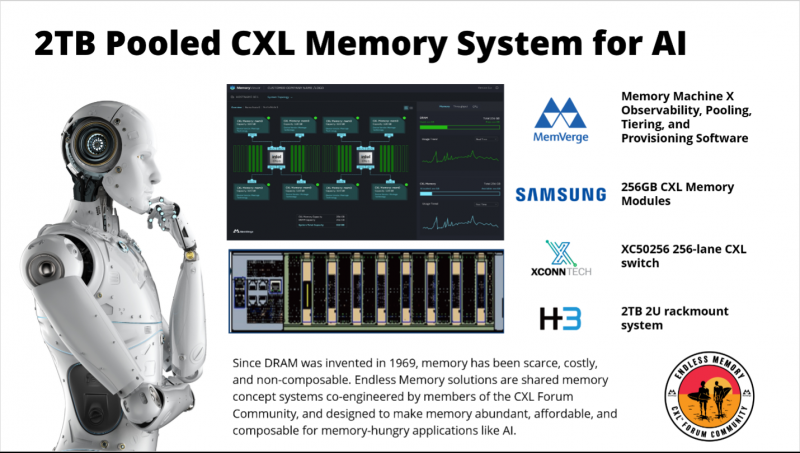

2 Тбайт RAM для ИИ: Samsung, MemVerge, H3 и XConn создали компактный CXL-пул памятиНа конференции Flash Memory Summit альянс компаний Samsung, MemVerge, H3 Platform и XConn Technologies продемонстрировал первые плоды своего сотрудничества. Речь идёт о новом CXL-пуле памяти ёмкостью 2 Тбайт, ставшим ответом на ряд проблем, с которым сталкиваются масштабные ИИ-платформы сегодня. Хостам, подключённым к пулу, можно динамически выделять требуемый объём RAM. Таких проблем, связанных со слишком тесной привязкой DRAM непосредственно к процессорам или ускорителям, можно назвать множество: потеря производительности при вынужденном сбросе данных на медленные накопители, излишнее перемещение данных из памяти и обратно, повышенная нагрузка на подсистему хранения данных, да и нехватка памяти. А памяти современным ИИ-системам требуется всё больше и больше, но наращиванию её ёмкости мешает слишком «процессороцентричная» архитектура. Многие видят здесь выход в отказе от традиционной концепции и переходе на композитную инфраструктуру, использующую возможности CXL в области организации вынесенных и легко наращиваемых при необходимости пулах памяти. Является таким пулом и демонстрируемая содружеством вышеназванных компаний система 2TB Pooled CXL Memory System.

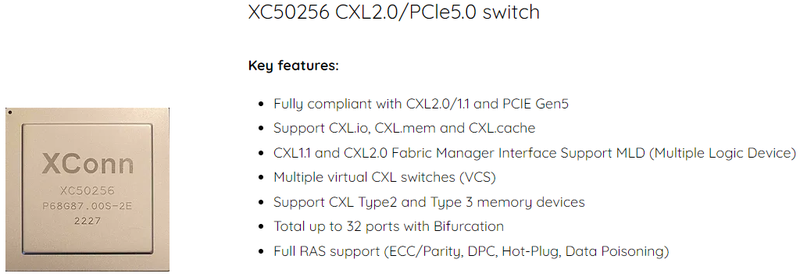

Источник изображения: Samsung Её основой стали CXL-модули Samsung ёмкостью 256 Гбайт с интерфейсом PCIe 5.0, имеющие максимальную пропускную способность до 35 Гбайт/с. В качестве связующего звена применены коммутаторы XConn Technologies XC50256 (Apollo). Эти чипы имеют 256 линий PCIe 5.0/CXL 2.0, которые группируются в 32 порта и могут обеспечить коммутацию на скорости до 2048 Гбайт/с при минимальной латентности. Как отметил представитель XConn, новые ASIC по всем параметрам превосходят аналогичные решения предыдущего поколения на базе FPGA.

Источник изображения: XConn Technologies Компания H3 Platform разработала компактное высокоплотное 2U-шасси. Также она отвечает за управляющее ПО H3 Fabric Manager, позволяющее удобно распределять CXL-ресурсы. Наконец, MemVerge ответственна за ПО, реализующее функцию «бесконечной памяти» — Memory Machine X. Этот комплекс, отвечающий за виртуализацию массивов памяти, поддерживает гибкое масштабирование, tiering, динамическое выделение памяти приложениям и многое другое, включая службу Memory Viewer, позволяющую наблюдать за топологией и загрузкой системы в реальном времени. |

|