Материалы по тегу: tesla

|

11.02.2025 [13:47], Руслан Авдеев

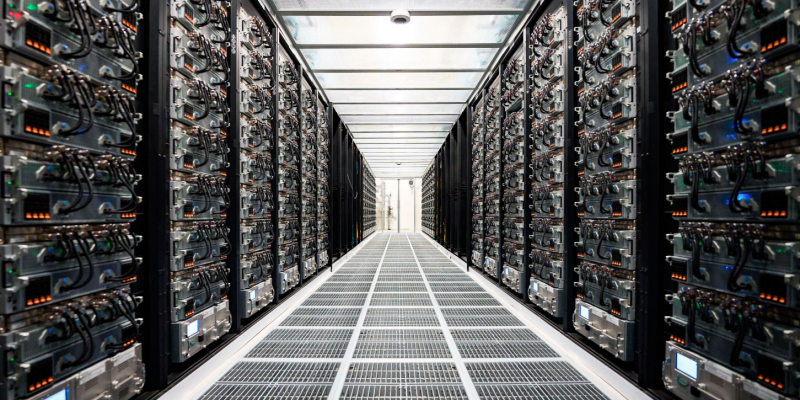

Tesla запустила суперкомпьютер Cortex с 50 тыс. ускорителей NVIDIA H100, а общие затраты компании на ИИ уже превысили $5 млрдКомпания Tesla завершила ввод в эксплуатацию ИИ-кластера из 50 тыс. ИИ-ускорителей NVIDIA H100 в IV квартале прошлого года. В презентации для акционеров отмечалось, что кластер Cortex заработал на принадлежащем Tesla объекте Gigafactory в Остине (Техас), сообщает Datacenter Dynamics. Информация впервые появилась в отчёте компании за IV квартал и 2024 финансовый год. Новый кластер не имеет отношения к суперкомпьютеру Dojo, предназначенному для технологий автономного вождения FSD, имеющего собственную архитектуру и оснащенного кастомными чипами D1. При этом в презентации, посвящённой отчёту, Dojo не упоминается вообще. Хотя компания не уточняет, когда именно в IV квартале началось развёртывание системы, на конференции по финансовым вопросам в октябре 2024 года представитель Tesla заявил, что компания находится «на пути к развёртыванию 50 тыс. ускорителей в Техасе к концу текущего месяца». По имеющимся данным, проект реализован с опозданием, поскольку Илон Маск уволил руководителя строительством ещё в апреле, а также приказал передать xAI 12 тыс. ускорителей H100, изначально предназначавшихся Tesla.

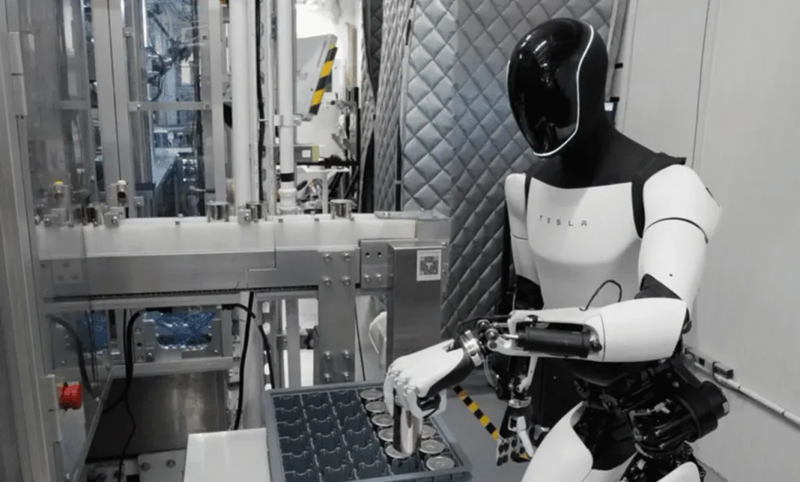

Источник изображения: Tesla В презентации сообщается, что именно Cortex уже помог в создании «автопилота» FSD V13 (Supervised). Новая версия повысила безопасность и комфорт вождения благодаря увеличению объёма данных в 4,2 раза, повышению разрешения видеопотока, а также другим усовершенствованиям. Заодно компания сообщила о продолжении работ над программной и аппаратной частями робота Optimus, в т.ч. рук нового поколения и механизмов передвижения. Также осуществлялось обучение выполнению дополнительных задач перед началом пилотного производства в 2025 году. Что касается доходов компании в IV квартале, в конце января Илон Маск (Elon Musk) сообщил, что бизнес продолжает инвестировать в обучающую инфраструктуру за пределами штаб-квартиры в Техасе. В конце января сообщалось, что Tesla наращивает вычислительные мощности для обучения Optimus. По словам миллиардера, на обучение Optimus необходимо потратить, как минимум, в 10 раз больше ресурсов в сравнении с полноценным обучением систем автомобиля. Капитальные затраты Tesla в 2024 году составили $10 млрд, столько же компания намерена потратить в ближайшие два года, хотя большая часть затрат придётся на инфраструктуру для электромобилей. В отчёте о доходах за IV квартал упоминалось, что общие капитальные затраты компании, связанные с ИИ, включая инфраструктуру, превысили $5 млрд.

31.01.2025 [07:02], Сергей Карасёв

Tesla наращивает вычислительные мощности для обучения человекоподобного робота OptimusГлава Tesla Илон Маск (Elon Musk) сообщил о том, что компания расширяет вычислительную инфраструктуру, необходимую для обучения человекоподобного робота Optimus. По словам Маска, в долгосрочной перспективе этот проект может принести более $10 трлн. Предполагается, что антропоморфные машины Optimus смогут выполнять самые разные задачи в быту и на производствах, взаимодействия с людьми. Но для разработки ИИ-систем робота требуются огромные вычислительные ресурсы. Маск подчёркивает, что обучение такой машины — гораздо более сложная задача, нежели обучение интеллектуальных автомобилей с автопилотом. Глава Tesla говорит, что у человекоподобного робота, вероятно, в 1000 раз больше функций, чем у транспортного средства. Это не означает, что обучение масштабируется в 1000 раз, но прирост вычислительных мощностей на порядок всё же необходим. «Потребности в обучении для гуманоидного робота Optimus, по всей видимости, как минимум в 10 раз превышают то, что требуется для создания полнофункционального умного автомобиля», — заявил Маск.

Источник изображения: channeliam.com Он не стал вдаваться в подробности о том, какая инфраструктура нужна компании для обучения Optimus. Ранее сообщалось, что Tesla планирует ввести в эксплуатацию дата-центр с 50 тыс. ускорителей NVIDIA H100. Кроме того, у компании есть кластер Dojo на базе собственных ускорителей D1. Маск говорит, что с учётом потенциала проекта Optimus даже инвестиции в размере $500 млрд в вычислительные ресурсы могут быть оправданными, хотя такую сумму Tesla на текущем этапе вкладывать не планирует. Вероятно, указанная сумма — это отсылка к проекту Stargate. Tesla потратила более $10 млрд на капитальные затраты в 2024 году. Примерно столько же средств компания намерена выделить в 2025 и 2026 годах. Ранее Маск говорил, что небольшое количество роботов Optimus будет задействовано на предприятиях Tesla до конца 2024-го. На коммерческом рынке эти человекоподобные машины, как ожидается, появятся в 2026 году.

18.11.2024 [10:59], Сергей Карасёв

OpenAI раздумывала, не купить ли разработчика ИИ-ускорителей Cerebras при участии TeslaКомпания OpenAI, по информации ресурса TechCrunch, изучала возможность приобретения американского стартапа Cerebras Systems, специализирующегося на разработке ИИ-ускорителей. Такие сведения вскрылись в рамках судебного процесса по иску Илона Маска (Elon Musk) против OpenAI. Маск является одним из основателей OpenAI — он покинул эту компанию в 2018 году. В начале августа нынешнего года Маск подал в суд на OpenAI и её генерального директора Сэма Альтмана (Sam Altman), обвинив их в нарушении прав и интересов, а также во введении в заблуждение. Как теперь сообщается, в электронном письме, адресованном Альтману и Маску, Илья Суцкевер (Ilya Sutskever), один из соучредителей OpenAI и бывший главный научный сотрудник компании, обсуждал идею покупки Cerebras через Tesla. В другом письме от июля 2017 года Суцкевер затрагивает ряд вопросов, связанных с Cerebras, таких как переговоры об условиях слияния и проверка благонадёжности финансового состояния Cerebras. «Если мы решим купить Cerebras, я твердо уверен, что это будет сделано через Tesla. Но зачем делать это таким образом, если мы могли бы провести сделку изнутри OpenAI? В частности, вызывает беспокойство то, что Tesla имеет обязательство перед акционерами максимизировать их доход, что не соответствует миссии OpenAI», — написал Суцкевер. Cerebras создаёт ИИ-суперускорители размером с целую кремниевую пластину. Флагманским продуктом стартапа является решение Wafer Scale Engine третьего поколения (WSE-3). Это гигантское изделие содержит 4 трлн транзисторов, 900 тыс. ядер и 44 Гбайт памяти SRAM. Предполагалось, что слияние с OpenAI будет выгодно обеим сторонам. В частности, Cerebras избежала бы сложного пути, связанного с IPO, тогда как OpenAI смогла бы получить в своё распоряжение мощные аппаратные ускорители для ресурсоёмких ИИ-задач. Однако сделка в итоге провалилась, хотя причины сворачивания переговоров не раскрываются.

01.11.2024 [19:11], Руслан Авдеев

Tesla надумала закупить у SK hynix серверные SSD на $725 млнПроизводитель электромобилей и разработчик других умных машин Tesla обсуждает с южнокорейской SK Hynix возможный заказ SSD корпоративного класса на сумму ₩1 трлн (около $725 млн), передаёт The Korea Economic Daily. Solidigm, дочерняя компания SK hynix, отмечает, что без ёмких и быстрых SSD работа с ИИ невозможна. Предполагается, что Tesla столь большая закупка SSD нужен как раз для развития ИИ-инфраструктуры. Компания вот-вот запустит ИИ-кластер из 50 тыс. NVIDIA H100. Также у неё есть собственный ИИ-суперкомпьютер Dojo, а в целом в этом году капитальные затраты за год, как ожидается, превысят $11 млрд. Значительная часть из них уйдёт как раз на ИИ ЦОД. Как уточняет ресурс Blocks & Files, поставщиками All-Flash СХД для обеих систем являются несколько вендоров. В данном случае, судя по всему, идёт закупке QLC-накопителей D5-P5336 ёмкостью 61,44 Тбайт. За указанную сумму можно приобрести порядка 100–200 тыс. накопителей суммарной ёмкостью от 10 Эбайт — конкретные значения будут зависеть от размера скидки, а при такой крупной закупке она обязательно будет. На прошлой неделе SK hynix заявила, что в III квартале она практически удвоила прибыль. SK Hynix намерена наращивать инвестиции в чипы, связанные с ИИ-технологиями — SSD и HBM. Ожидается, что спрос на них и в следующем году будет весьма высок. В компании игнорируют опасения отраслевых экспертов, предрекающих «зиму» спроса на чипы памяти. Наоборот, компания рассчитывает на дефицит поставок памяти для ИИ-ускорителей из-за огромного спроса на соответствующую продукцию.

26.10.2024 [00:53], Владимир Мироненко

Tesla до конца месяца запустит ИИ-кластер из 50 тыс. NVIDIA H100Tesla планирует ввести в эксплуатацию ЦОД с 50 тыс. ускорителей NVIDIA H100 в конце этого месяца, пишет Data Center Dynamics (DCD) со ссылкой на заявление компании. «Мы начали использовать кластер на базе нашего завода раньше срока и находимся на пути к развертыванию 50 тыс. GPU в Техасе к концу этого месяца», — сообщил финансовый директор Вайбхав Танеджа (Vaibhav Taneja) в ходе отчёта о финансовых результатах за III квартал. Предполагается, что именно этот кластер, размещённый в Остине (Техас) отставал от графика, из-за чего гендиректор Илон Маск (Elon Musk) уволил в апреле руководителя строительства. В июне по распоряжению Маска 12 тыс. ускорителей H100, предназначавшихся Tesla, были переданы xAI. Сама xAI в сентябре запустила ИИ-кластер со 100 тыс. ускорителей NVIDIA H100. Капитальные затраты Tesla достигли $3,5 млрд в отчётном квартале, «последовательно увеличившись в основном из-за инвестиций в ИИ-вычисления», а капитальные затраты за год, как ожидается, превысят $11 млрд, что на $1 млрд больше год к году. При этом Танеджа сообщил, что компания «очень разумно подходит к расходам на ИИ», пытаясь наилучшим способом использовать существующую инфраструктуру, прежде чем делать дальнейшие инвестиции. Маск заявил, что Tesla продолжает расширять возможности обучения ИИ, чтобы удовлетворить как потребности в обучении автопилота Full Self Driving (FSD), так и роботов Optimus, отметив, что в настоящее время компания не испытывает дефицита вычислительных ресурсов. В квартальном отчёте не упоминается Dojo, ИИ-инфраструктура Tesla на базе ускорителей собственной разработки.

29.08.2024 [16:41], Руслан Авдеев

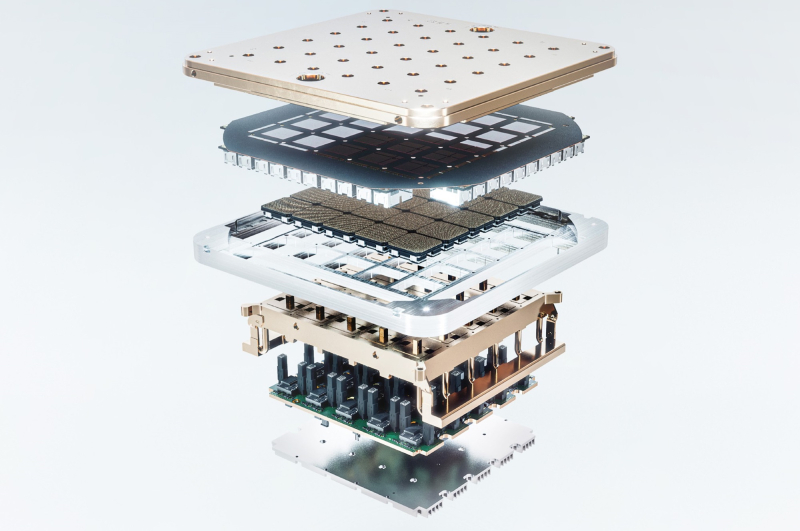

Илон Маск показал ИИ-суперкластер Tesla Cortex из 50 тыс. ускорителей NVIDIAИлон Маск (Elon Musk) продолжает наращивать вычислительные мощности своих компаний. Как сообщает Tom’s Hardware, он поделился сведениями об ИИ-суперкластере Cortex. По данным Tom's Hardware, недавнее дополнение завода Giga Texas компании Tesla будет состоять из 70 тыс. ИИ-серверов, а также потребует 130 МВт энергии на обеспечение вычислений и охлаждения на момент запуска, к 2026 году мощность вырастет до 500 МВт. На опубликованном в социальной сети X видео Илона Маска показан машинный зал: по 16 IT-стоек в ряд, по два ряда на коридор. Каждая стойка вмещает восемь ИИ-серверов, а в середине каждого ряда видны стойки без таковых. В видео можно разглядеть порядка 16–20 рядов, поэтому довольно грубый подсчёт позволяет предположить наличие около 2 тыс. серверов с ускорителями, т.е. менее 3 % от запланированной ёмкости. В ходе июльского финансового отчёта Tesla Илон Маск рассказал, что Cortex будет крупнейшим обучающим кластером Tesla на сегодняшний день и будет состоять из 50 тыс. ускорителей NVIDIA H100 и 20 тыс. ускорителей Tesla D1 собственной разработки. Это меньше, чем Маск прогнозировал раньше, в июне он сообщал, что Cortex будет включать 50 тыс. D1. Правда, сообщалось, что на момент запуска будут применяться только решения NVIDIA, а разработки Tesla появятся позже.

Источник изображения: Alexander Shatov/unsplash.com Кластер Cortex предназначен в первую очередь для обучения автопилота Full Self Driving (FSD), сервиса Cybertaxi и роботов Optimus, ограниченное производство которых должно начаться в 2025 году для использования на заводах компании. Также Маск анонсировал планы потратить $500 млн на суперкомпьютер Dojo в Буффало (штат Нью-Йорк), также принадлежащий Tesla. Первым же в «коллекции» Маска заработал Memphis Supercluster, принадлежащий xAI и оснащённый 100 тыс. NVIDIA H100. Со временем эта система получит 300 тыс. ускорителей NVIDIA B200, но задержки с их производством заставили отложить реализацию проекта на несколько месяцев.

14.08.2024 [16:58], Руслан Авдеев

Nimbus Data превратила Tesla Cybertruck в мобильное All-Flash хранилище BatArrayКомпания Nimbus Data создала мобильное хранилище BatArray, представляющее собой комбинацию All-Flash СХД FlashRack Turbo с электромобилем Tesla Cybertruck. По словам компании, BatArray позволит продемонстрировать энергоэффективность решений Nimbus Data и преимущества аккумуляторных технологий Tesla — это новый способ решать задачи по обработке или хранению данных в эпоху ИИ. BatArray использует шесть 2U-систем FlashRack Turbo (глубина 21″), каждая из которых способна хранить 1,5 Пбайт, что суммарно даёт 9 Пбайт чистой ёмкости. Эффективная же ёмкость после компрессии и дедупликации может достигать 25 Пбайт. Кластер СХД запитан от розетки 240В/40А в кузове Cybertruck. Заряда таяговых АКБ хватит на 24 часа работы хранилища данных. Патентованная архитектура Parallel Memory Architecture позволяет BatArray принимать данные со скоростью до 360 Гбайт/с. Это втрое быстрее, чем могли обеспечить фуры AWS Snowmobile. Все данные автоматически шифруются с использованием AES-256 с поддержкой KIMP. Скорость выгрузки данных и вовсе достигает 600 Гбайт/с. В наилучшем случае целиком заполнить BatArray можно за 7 часов, при этом оставшегося заряда АКБ хватит на проезд более 300 км без подзарядки. А используя 400G-трансиверы с FR4-волокном можно связать BatArray с нужным объектом на расстоянии до 2 км. Двухконтроллерная СХД FlashRack Turbo поддерживает установку 24 NVMe SSD (PCIe 4.0) ёмкостью до 64 Тбайт, а также 512-Тбайт SSP (Solid State Pack). Пиковая производительность составляет до 100 Гбайт/с (блоки 1 Мбайт) и 10 млн IOPS (4K-блоки). СХД поддерживает NVMe-oF (TCP/RoCE), iSCSI, iSER, FCP, SRP, NFS, SMB, AFP, S3, WebDAV, FTP. Для связи с миром доступны порты 10/25/50/100/200/400GbE, InfiniBand EDR/HDR/NDR и FC32/64. Энергопотребление не превышает 1100 Вт.

25.07.2024 [09:57], Сергей Карасёв

Илон Маск показал ИИ-суперкомпьютер Dojo на основе чипов Tesla D1Глава Tesla Илон Маск (Elon Musk), по сообщению ресурса Tom's Hardware, обнародовал фотографии вычислительного комплекса Dojo, который будет использоваться для разработки инновационных автомобильных технологий, а также для обучения автопилота. Tesla, напомним, начала создание ИИ-суперкомпьютера Dojo в июле 2023 года. Основой системы послужат специализированные чипы собственной разработки Tesla D1. Дата-центр Dojo, расположенный в штаб-квартире Tesla в Остине (Техас, США), по своей конструкции напоминает бункер. В апреле нынешнего года сообщалось, что при строительстве ЦОД компания Маска столкнулась с трудностями, связанными в том числе с доставкой необходимых материалов. Как теперь сообщается, Tesla намерена ввести Dojo в эксплуатацию до конца 2024 года. По производительности этот суперкомпьютер будет сопоставим с кластером из 8 тыс. ускорителей NVIDIA H100. По словам Маска, это «не слишком много, но и не тривиально». Для сравнения: мощнейший ИИ-суперкомпьютер компании xAI, также курируемой Илоном Маском, объединит 100 тыс. карт H100. Отмечается, что чипы Tesla D1 специально ориентированы на машинное обучение и анализ видеоданных. Поэтому систему Dojo планируется использовать прежде всего для совершенствования технологии автономного вождения Tesla путём обработки видеоданных, полученных от автомобилей компании. В свою очередь, «ИИ-гигафабрика» xAI поможет в развитии чат-ботов Grok следующего поколения. Маск также сообщил, что компания Tesla намерена «удвоить усилия» по разработке и развертыванию Dojo из-за высоких цен на оборудование NVIDIA. Вместе с тем финансовый директор Tesla Вайбхав Танеджа (Vaibhav Taneja) заявил, что, несмотря на снижение капвложений во II квартале 2024 года, компания по-прежнему ожидает, что соответствующие затраты превысят $10 млрд.

09.07.2024 [12:07], Руслан Авдеев

Китай намерен на треть нарастить вычислительные мощности к 2025 году, а развитию инфраструктуры ЦОД поможет даже TeslaВ ходе недавнего мероприятия Global Digital Economy Conference 2024 КНР не только раскрыла некоторые факты о национальной вычислительной инфраструктуре, но и обнародовала планы нарастить их только за 2024 год на 30 %, передаёт The Register. Как заявил представитель Китайской академии информационных и коммуникационных технологий (China Academy of Information and Communications Technology) Ван Сяоли (Wang Xiaoli), Китай располагает более 8,1 млн стоек, а общая вычислительная мощность составила 230 Эфлопс (точность не указывается). Но уже к 2025 году она должна вырасти до 300 Эфлопс. Впервые соответствующие планы были обнародованы ещё в конце 2023 года. Как именно Китай намерен добавить 70 Эфлопс, не уточнялось. Вопрос весьма актуальный, с учётом того, что Китаю удалось нарастить мощности со 180 Эфлопс в 2022 году лишь до 197 Эфлопс к августу 2023. Даже с учётом того, что сегодня этот показатель поднялся до 230 Эфлопс, Китаю придётся приложить немалые усилия, особенно с учётом санкций, ограничивающих поставки современных полупроводников в страну.

Источник изображения: 尧智 林/unsplash.com В развитии современной инфраструктуры ЦОД сыграет роль даже Tesla. По данным СМИ, шанхайский оператор ЦОД Yovole Network использует водородную энергетику, энергохранилища, подключённые к солнечным электростанциям, непрямое испарительное охлаждение и СЖО для обеспечения работы своих дата-центров. В апреле компания начала сотрудничать с Tesla для внедрения энергохранилищ Tesla Megapack в одном из ЦОД. Информация появилась в тот же день, когда китайские СМИ сообщили, что электротранспорт Tesla официально одобрен для закупок и использования в государственном секторе. В частности, Tesla Model Y приобрели некоторые принадлежащие государству шанхайские компании. При этом недавно тарифы на импорт китайских электромобилей подняли как в США, так и в Европе. На этом фоне китайские власти демонстративно подчёркивают, что в КНР одинаково относятся к местным и зарубежным предпринимателям, создавая им равные условия для развития бизнеса. Конечно, на фоне санкций далеко не все иностранные компании смогут принять участие в наращивании китайских вычислительных мощностей. Каким бы образом в Китае не собирались добавить 70 Эфлопс за несколько месяцев, Пекин рассчитывает, что это поможет трансформировать экономику, позволив шире внедрять ИИ и потенциально обеспечит развитие и дополнительные доходы сельским районам, которые смогут заработать на цифровом буме.

29.06.2024 [12:58], Сергей Карасёв

Бывший специалист Google по СЖО присоединился к OpenAIКомпания OpenAI, по сообщению ресурса Datacenter Dynamics, наняла еще одного бывшего сотрудника Tesla и Google для развития своей вычислительной инфраструктуры. Несмотря на использование облака Microsoft Azure, OpenAI развивает собственное направление ЦОД, в связи с чем расширяет штат специалистов в соответствующей области. В OpenAI перешел Реза Хиабани (Reza Khiabani), который ранее в течение почти двух лет работал в Tesla в качестве инженера-теплотехника. Он, в частности, помогал в создании системы охлаждения для ИИ-суперкомпьютера Dojo, для которого планируется построить специальный дата-центр. Однако с реализацией проекта возникли сложности. До прихода в Tesla Хиабани проработал почти девять лет в Google, из которых основную часть времени выполнял обязанности технического менеджера, архитектора тепловых систем и технического руководителя команды по разработке СЖО для ИИ-ускорителей семейства Cloud TPU. Он курировал проектирование ЦОД, тепловой дизайн TPU и «разработку машстабных систем жидкостного охлаждения». В OpenAI Хиабани войдёт в техническую команду. Чем именно ему предстоит заниматься, не уточняется. Но можно предположить, что его работа снова будет связана с решениями СЖО для дата-центров, ориентированных на ресурсоёмкие приложения ИИ. OpenAI активно нанимает бывших специалистов Tesla и Google. В частности, ранее ИИ-компания назначила бывшего руководителя Google TPU Ричарда Хо (Richard Ho) главой отдела аппаратного обеспечения. В OpenAI также перешли ветеран Google Тодд Андервуд (Todd Underwood) и старший инженер-программист команды Tesla Dojo Клайв Чан (Clive Chan). |

|