Материалы по тегу: европа

|

06.06.2023 [17:12], Сергей Карасёв

Evroc создаст облако, которое положит конец доминированию американских гиперскейлеров на европейском рынкеКомпания evroc раскрыла планы по созданию первого в Европе «безопасного, суверенного и устойчивого облака гиперскейл-класса». Проект, как утверждается, позволит положить конец доминированию зарубежных провайдеров на европейском рынке облачных вычислений. Evroc была основана в 2022 году для «развития цифровой Европы». Штаб-квартира компании находится в Стокгольме (Швеция), а офис разработки располагается в Софии-Антиполисе (Франция). Инвесторами проекта стали EQT Ventures и Norrsken VC. Сообщается, что в 2024 году evroc создаст пилотный дата-центр в районе Стокгольма, а также начнёт процесс выбора площадок для первых двух европейских облачных кампусов и дополнительных центров разработки софта. Один из ЦОД будет построен в Северной Европе, другой — в Южной. На этом этапе evroc рассчитывает привлечь и вложить в проект приблизительно €3 млрд.

Источник изображения: Evroc Evroc планирует использовать энергосберегающие технологии следующего поколения для создания «самого чистого в мире облака». Для платформы предусмотрено применение уникального проприетарного решения для балансировки нагрузки Eco Load Balancer. Эта система обеспечит бесперебойную и безопасную передачу данных между ЦОД в зависимости от того, где в текущий момент наиболее доступна энергия из возобновляемых источников. К 2028 году evroc планирует создать в Европе восемь сверхкрупных дата-центров, а также три центра разработки ПО, в которых будут работать более 3000 человек. Инфраструктура будет включать в себя полный набор облачных сервисов, интеграцию со сторонними приложениями и возможности для разработчиков.

06.06.2023 [12:43], Сергей Карасёв

IBM построит в Европе квантовый дата-центрКорпорация IBM сообщила о планах по созданию своего первого европейского центра квантовых вычислений. Предполагается, что воспользоваться его ресурсами смогут различные государственные учреждения, исследовательские институты и коммерческие заказчики. Новый ЦОД расположится на площадке IBM в Энингене (земля Баден-Вюртемберг, Германия). У IBM уже имеется центр квантовых вычислений в США — он находится в Покипси (штат Нью-Йорк). Появление европейского комплекса поможет ускорить разработку и внедрение решений на основе квантовых технологий. В состав ЦОД войдут несколько квантовых систем IBM, оперирующих более чем 100 кубитами. Доступ к вычислительным мощностям будет предоставляться клиентам из европейских государств и других стран по всему миру. Ввод площадки в эксплуатацию запланирован на 2024 год.

Источник изображения: IBM Отмечается, что в настоящее время сеть IBM Quantum Network насчитывает более 60 организаций по всей Европе. Им предоставляется доступ к квантовому оборудованию и сопутствующему ПО для решения сложных и ресурсоёмких задач, обработка которых зачастую не под силу традиционным компьютерам. Комплексы квантовых вычислений, в частности, применяются в таких сферах, как материаловедение, физика высоких энергий, финансовая аналитика и пр. К сети IBM Quantum Network через облако подключены Университет Бундесвера в Мюнхене, Европейская организация ядерных исследований (ЦЕРН), Общество Фраунгофера, компания Bosch и др.

24.05.2023 [18:50], Руслан Авдеев

+480 МВт: эксперты CBRE прогнозируют рост на рынках FLAPD в 2023 годуКомпания CBRE, специализирующаяся на операциях с недвижимостью, прогнозирует в 2023 году рекордный рост освоения мощностей ЦОД на рынках, включающих Франкфурт, Лондон, Амстердам, Париж и Дублин (т.н. FLAPD). По данным DataCenter Dynamics, в компании предполагают, что прирост за год составит почти 500 МВт. Примечательно, что I квартал 2023 года оказался чрезвычайно спокойным в этом отношении, в эксплуатацию на данных рынках были введены мощности всего на 2,9 МВт, самый низкий показатель за более чем 10 лет, а освоено в тот же период только 28 МВт, из которых 17 МВт — неназванным гиперскейлером в Лондоне. Значительную часть ожидаемых 480 МВт, по прогнозам CBRE, заберут гиперскейлеры, а больше половины мощностей придётся на Франкфурт и Лондон. Операторы на рынках FLAPD обеспечивают дополнительные мощности для удовлетворения спроса, в результате в текущем году ожидается и беспрецедентный рост ёмкости, большая часть которой будет выделяться по предварительным договорам индивидуальным клиентам из технологического сектора. С учётом спроса ожидается ввод в эксплуатацию в этом году ёмкости 524 МВт, многие проекты, например, до конца года завершат в Париже, Лондоне и Франкфурте (например, второй ЦОД Maincubes). Особенный всплеск активности ожидается в Лондоне. Reef Group предложила строительство кампуса на 600 МВт ещё в ноябре прошлого года, Vantage работает над строительством 48-МВт кампуса, а Global Switch получила разрешение на строительство ЦОД на 3,1 МВт. В докладе CBRE не отмечен фактический мораторий на строительство новых ЦОД в Дублине — в столице Ирландии ограничили подобную деятельность в связи с ограниченными возможностями электросетей. Ранее сообщалось, что вместо этого операторы переключаются на другие регионы — в декабре 2022 года было анонсировано строительство 21 ЦОД в населённых пунктах неподалёку от Дублина.

12.05.2023 [21:35], Владимир Мироненко

Евросоюз хочет оградить облачные данные от доступа иностранных правительствЕвропейское агентство по сетевой и информационной безопасности (ENISA) разрабатывает новые, более жёсткие требования к облачным провайдерам в части хранения данных в пределах ЕС, чтобы исключить возможность доступа иностранных правительств к данным блока, пишет Bloomberg, ознакомившийся с проектом нового закона. По новым правилам для того, чтобы получить высшую сертификацию кибербезопасности, компании будет необходимо хранить данные в ЕС. Как пояснил ресурс, на практике это означает, что американские провайдеры облачных услуг, такие как Amazon, Microsoft и Google, должны будут в соответствии с новыми требованиями гарантировать, что американское правительство не сможет получить доступ к европейским облачным данным. При этом зарубежные облачные провайдеры должны будут либо управлять отдельным юридическим лицом в ЕС независимо от материнской компании, либо создать СП с европейской облачной компанией.

Источник изображения: Pixabay ENISA предлагает ввести двухуровневую классификацию кибербезопасности «высокого» уровня. Большинство американских облачных провайдеров соответствуют предложенному стандарту «EL3», которым устанавливается определённый уровень прозрачности данных. Самый высокий уровень кибербезопасности — сертификация EL4 — требует, чтобы данные хранились в ЕС без доступа иностранного правительства. Наличие высшего сертификата кибербезопасности будет необходимым условием при отборе компаний для получения контракта на хранение конфиденциальных правительственных данных. Американские компании опасались, что ENISA в качестве условия высшей сертификации включит в новые требования правила владения облачными данными в ЕС подобные тем, что уже действуют во Франции. Однако, как оказалось им будет проще реализовать предложение ENISA. Например, по словам источников Bloomberg, решение Oracle Sovereign Cloud, скорее всего, уже соответствует предлагаемым требованиям сертификации EL4.

09.05.2023 [15:23], Сергей Карасёв

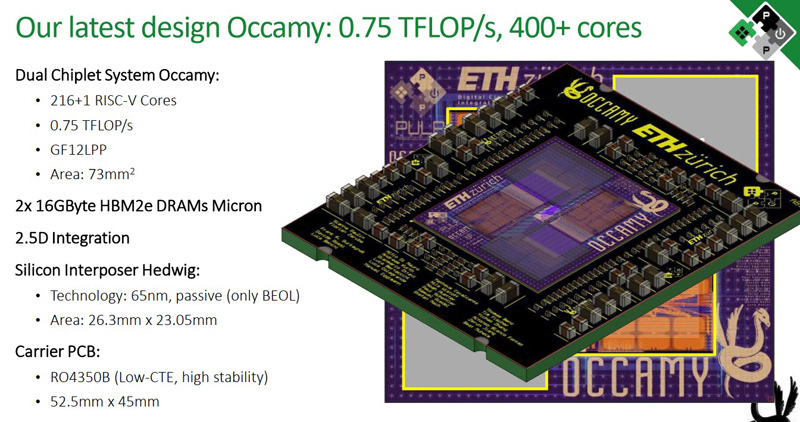

Космический RISC-V: 432-ядерный европейский чип Occamy готов к выходуЕвропейское космическое агентство (ESA), по сообщению HPC Wire, близко к выпуску специализированного процессора под названием Occamy, спроектированного для использования в космической технике. В основу решения с чиплетной компоновкой положена архитектура RISC-V. Сообщается, что в составе изделия соседствуют современные и неновые технологии. Чип ориентирован прежде всего на задачи ИИ и НРС. Процессор создан по программе EuPilot, цель которой заключается в снижении зависимости от проприетарных платформ х86 и Arm. В разработке Occamy приняли участие специалисты Швейцарской высшей технической школы Цюриха (ETH Zürich) и Болонского университета (Италия).

Источник изображения: HPC Wire В состав Occamy входят два вычислительных модуля, каждый из которых содержит 216 ядер RISC-V. Таким образом, суммарное количество ядер достигает 432. Задействованы два блока памяти HBM2e ёмкостью 16 Гбайт. Кроме того, процессор содержит 64-бит блоки для FP-вычислений. Соединения размещены в кремниевом слое-интерпозере (interposer). Occamy насчитывает в общей сложности приблизительно 1 млрд транзисторов. Заявленная производительность FP64 достигает 0,75 Тфлопс, FP8 — 6 Тфлопс. Изделию не требуется активное охлаждения. Общие размеры составляют 73 × 73 мм. Новинка также включает «лёгкое» 32-битное ядро, выполняющее функции управления. Применена память HBM2e разработки Micron, а само решение Occamy изготавливается на предприятии Globalfoundries с применением техпроцесса 12LPP. Процессор Occamy можно эмулировать на базе FPGA. Реализация, в частности, была протестирована на FPGA AMD Xilinx Virtex UltraScale+ HBM и FPGA Virtex UltraScale+ VCU1525.

21.04.2023 [22:55], Руслан Авдеев

Евросоюз поставит дата-центры на экоучёт и обяжет их отдавать мусорное тепло на нужды обществаЕвропарламент и Евросовет, наконец, согласовали текст Директивы по энергетической эффективности (EED). Как сообщает ComputerWeekly, документ обязывает операторов ЦОД в Евросоюзе обеспечить свободный доступ к данным о воздействии их проектов на окружающую среду. Кроме того, в скором будущем некоторые ЦОД станут обязаны отдавать избыточное тепло со своих площадок на нужды общества. Ассоциация Sustainable Digital Infrastructure Alliance (SDIA), намеренная добиваться того, чтобы дальнейший рост индустрии ЦОД не продолжался за счёт ущерба окружающей среде, и выступающая за использование открытых и доступных технологий энергоснабжения, приветствовала финальный вариант директивы. В SDIA назвали утверждение окончательного варианта документа важной вехой в деле перехода на экоустойчивую цифровую инфраструктуру к 2030 году. Согласно новому документу, операторы ЦОД, у которых мощность объектов превышает 500 кВт, будут обязаны отчитываться о воздействии на окружающую среду не реже раза в год, а первый отчёт придётся подать не позже 15 мая 2024 года. SDIA активно участвует в формировании требований о том, какими именно данными должны будут делиться операторы ЦОД. Так, операторы должны будут включать в отчёт подробности о потребляемой энергии, а также данные о температурах на объекте, использовании возобновляемой энергии и другие сведения. Еврокомиссия создаст базу ЦОД, куда и будет внесена вся эта информация. На основе собранных данных директива будет скорректирована, и к 15 мая 2025 года обновлённый документ получит уточнённые нормы и стандарты для ЦОД, а также план по переходу к нулевым углеродным выбросам. Важным новым требованием к дата-центрам мощностью более 1 МВт является обязательная утилизация избыточного тепла. Если это по каким-либо причинам невозможно, от операторов потребуется техническое или финансовое обоснование отказа. При этом спрос на такое тепло пока мал. При этом новые экологические нормативы, по данным Uptime Institute, будут одной из причин роста затрат на строительство и обслуживание ЦОД в ближайшие годы.

28.07.2022 [18:12], Руслан Авдеев

Европейские дата-центры хотят снизить потребление воды до 400 мл/кВт·ч, но только к 2040 годуГруппа Climate Neutral Data Centre Pact (CNDCP), объединяющая 90 % европейских операторов ЦОД, предложила добровольно снизить потребление воды до 400 мл на 1 кВт·ч к 2040 году и добиться углеродной нейтральности намного раньше 2050 года. Соответствующая цель уже поставлена ЕС, но операторы намерены добиваться её без законодательного принуждения и с опережением графика, — сообщает Data Center Dynamics. Хотя использование воды способно оказать значительное влияние на экологию, этот фактор часто недооценивают, учитывая только расход энергии. При этом многие ЦОД активно используют воду для охлаждения оборудования, благодаря чему снижается расход всё той же энергии, но растут затраты самой жидкости, что имеет критическое значение для некоторых регионов.

Источник изображения: Christian Lue/unsplash.com Группу CNDCP сформировали в 2021 году с намерением достичь углеродной нейтральности европейских ЦОД к 2030 году, а также обеспечить достойный ответ прочим экологическим вызовам, в том числе снизить расход воды. Для оценки эффективности использования воды используется коэффициент WUE, который отражает расход воды на каждый затраченный киловатт·час электричества. Например, исследование 2016 года показало, что на тот момент WUE для ЦОД в США составлял в среднем 1,8 л/кВт·ч. Цели поставлены с учётом жизненного цикла уже действующих систем охлаждения, поскольку их немедленная массовая замена может принести больше вреда, чем пользы из-за ущерба экологии в процессе производства самих систем. Поэтому в CNDCP заявили, что все 74 оператора ЦОД, участвовавшие в заключении пакта, добьются потребления не более 400 мл/кВт·ч только к 2040 году. Такой показатель вывели с учётом разницы технологий, климатических и иных условий, характерных для тех или иных ЦОД. Отдельные участники рынка уже заявили о намерении добиться положительного водного баланса для своих дата-центров — ЦОД будут отдавать больше чистой воды, чем потреблять. Так, Meta✴ и Microsoft планируют добиться этой цели к 2030 году. Последняя также начала устанавливать станции для очистки сточных вод ЦОД. А вот Google отметилась тем, что пыталась всеми возможными способами скрыть расход воды своими дата-центрами даже от властей. Помимо ограничения расхода воды, подписанты CNDCP предложили ввести и другие цели для дата-центров. Например, уже сформированы две рабочие группы для подготовки к переходу на «циркулярную экономику» со вторичным использованием материалов и переработкой различных ресурсов. В частном порядке аналогичную инициативу уже несколько лет развивает Microsoft в рамках проекта Circular Center.

15.06.2022 [23:40], Алексей Степин

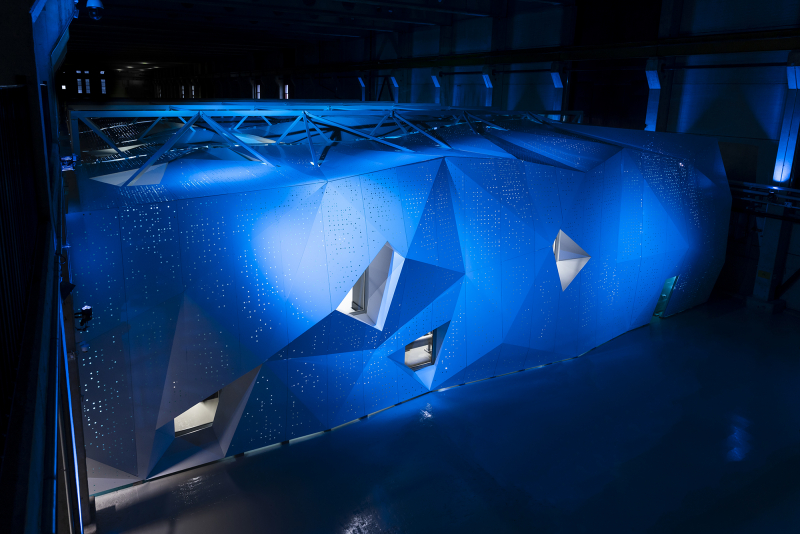

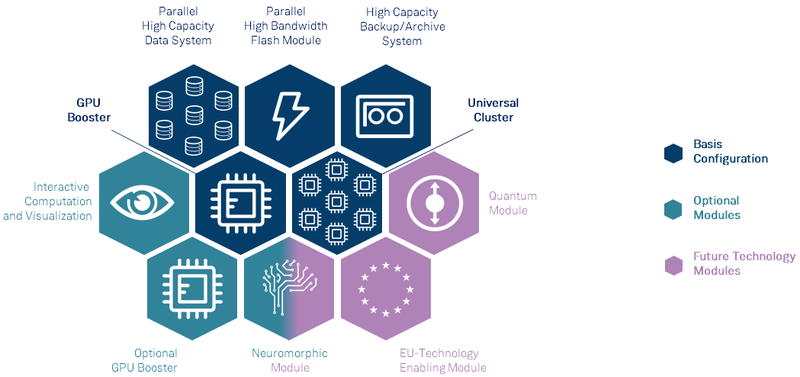

Анонсирован первый европейский суперкомпьютер экзафлопсного класса — JUPITERВсемирная гонка суперкомпьютеров экзафлопсного класса продолжается, и теперь в игру, наконец, вступил Евросоюз — консорциума EuroHPC сегодня раскрыл некоторые подробности о первой европейской система подобного уровня. Им станет машина под названием JUPITER (Joint Undertaking Pioneer for Innovative and Transformative Exascale Research), которая должна будет войти в строй в следующем году. Система будет смонтирована в Юлихском исследовательском центре (FZJ) в Германии. Сведений об аппаратной начинке JUPITER пока не так много, но в конструкции нового HPC-монстра будет применён тот же модульный подход, что был опробован на его предшественнике, суперкомпьютере JUWELS. Последний вступил в строй в 2018 году и на данный момент содержит несколько кластеров и бустеров с различной архитектурой.

Архитектура европейской экзафлопсной системы включает необычные средства. Источник: FZJ Новая система получит отдельные модули, куда входят вычислительные узлы, пулы памяти, узлы с различными ускорителями, узлы визуализации и т.д. Более того, она может быть дополнена блоками, которые содержат нейроморфные и квантовые системы, а также любые вычислительные модули, построенные на технологиях Евросоюза. Стоимость JUPITER оценивается примерно в €502 млн. Половину оплатит EuroHPC, четверть предоставит Министерство образования и науки Германии, оставшаяся четверть придётся на долю Министерства культуры и науки Северной Рейн-Вестфалии.

Машинный зал JUWELS. Источник: FZJ Проектировщики уделят серьёзное внимание энергоэффективности новой системы. Ожидается, что её потребление составит около 15 МВт, то есть она будет экономичнее нынешнего лидера TOP500 в лице Frontier. Для питания JUPITER планируется задействовать возобновляемые источники энергии, а СЖО будет использовать теплоноситель с относительно высокой рабочей температурой. Рассматривается возможность утилизации выделяемого системой тепла, как это реализовано в финском LUMI.

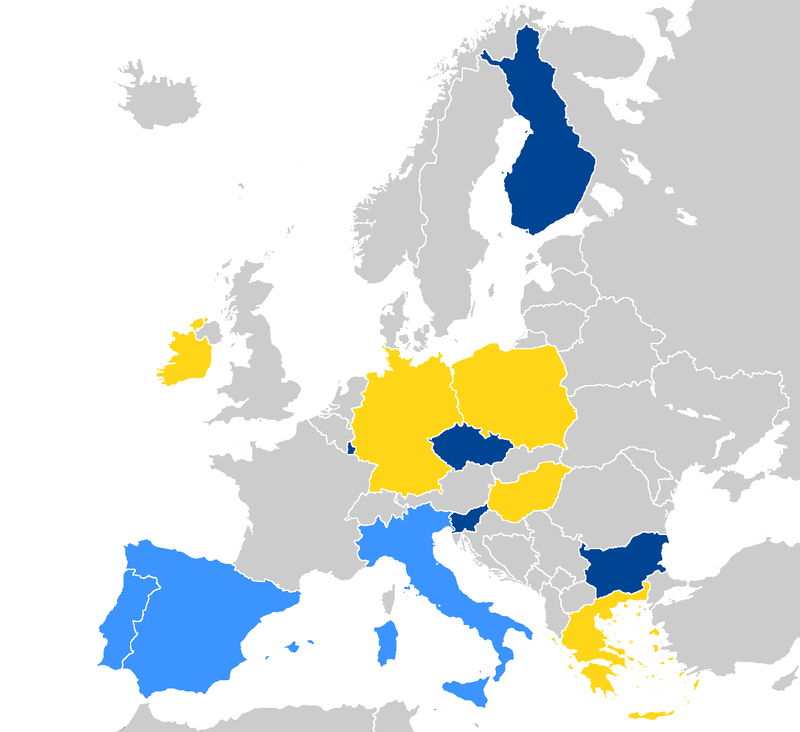

Страны, уже запустившие системы EuroHPC отмечены тёмно-синим, светло-синие — в процессе, жёлтым отмечены новички. Источник: EuroHPC Консорциум также анонсировал ещё четыре, более скромных суперкомпьютера. Это греческий DAEDALUS, венгерский LEVENTE, ирландский CASPIr и польский EHPCPL. В течение следующих нескольких лет EuroHPC планирует ввести в строй ещё минимум два суперкомпьютера экзафлопсного класса, так что гонка за зеттафлопом станет ещё интереснее. Впрочем, и Европе, и США надо опасаться в первую очередь Китая.

14.06.2022 [16:33], Владимир Мироненко

В Финляндии официально запущен LUMI, самый мощный суперкомпьютер в ЕвропеHPE и EuroHPC официально ввели в эксплуатацию вычислительную систему LUMI, установленную в ЦОД центре IT Center for Science (CSC) в Каяани (Финляндия), которая на данный момент считается самым мощным суперкомпьютером в Европе. LUMI — это первая система предэкзафлопсного класса, созданная в рамках совместного европейского проекта EuroHPC. LUMI будет в основном использоваться для решения важных для общества задач, включая исследования в области изменения климата, медицины, наук о жизни и т.д. Система будет применяться для приложений, связанных с высокопроизводительными вычислениями (HPC), искусственным интеллектом и аналитикой данных, а также в областях их пересечения. Для отдельных пользователей суперкомпьютер будет доступен в рамках второй пилотной фазы в августе, а полностью укомплектованная система станет общедоступной в конце сентября. Суперкомпьютер стоимостью €202 млн принадлежит EuroHPC (JU). Половина из этой суммы была предоставлена Евросоюзом, четверть — Финляндией, а остальная часть средств поступила от остальных членов консорциума, включающего 10 стран. По состоянию на 30 мая LUMI занимал третье место в списке TOP500 самых быстрых суперкомпьютеров мира. Сейчас его производительность составляет 151,9 Пфлопс при энергопотреблении 2,9 МВт. LUMI (снег в переводе с финского) базируется на системе HPE Cray EX. Система состоит из двух комплексов. Блок с ускорителями включает 2560 узлов, каждый из которых состоит из одного 64-ядерного кастомного процессора AMD EPYC Trento и четырёх AMD Instinct MI250X. Второй блок под названием LUMI-C содержит только 64-ядерные CPU AMD EPYC Milan в 1536 двухсокетных узлах, имеющих от 256 Гбайт до 1 Тбайт RAM. LUMI также имеет 64 GPU NVIDIA A40, используемых для рабочих нагрузок визуализации, и узлы с увеличенным объёмом памяти (до 32 Тбайт на кластер). Основной интерконнект — Slingshot 11. Хранилище LUMI построено на базе СХД Cray ClusterStor E1000 c ФС Lustre: 8 Пбайт SSD + 80 Пбайт HDD. Также есть объектное Ceph-хранилище ёмкостью 30 Пбайт. Агрегированная пропускная способность СХД составит 2 Тбайт/с. В ближайшее время суперкомпьютер получит дополнительные узлы. После завершения всех работ производительность суперкомпьютера, как ожидается, вырастет примерно до 375 Пфлопс, а пиковая производительность потенциально превысит 550 Пфлопс. Общая площадь комплекса составит порядка 300 м2, а энергопотребление вырастет до 8,5 МВт. Впрочем, запас у площадки солидный — от ГЭС она может получить до 200 МВт. «Мусорное» тепло идёт на обогрев местных домов.

22.09.2021 [21:16], Алексей Степин

Выпущена тестовая партия европейских высокопроизводительных RISC-V процессоров EPI EPAC1.0Наличие собственных высокопроизводительных процессоров и сопровождающей их технической инфраструктуры — в современном мире вопрос стратегического значения для любой силы, претендующей на первые роли. Консорциум European Processor Initiative (EPI), в течение долгого времени работавший над созданием мощных процессоров для нужд Евросоюза, наконец-то, получил первые весомые плоды. О проекте EPI мы неоднократно рассказывали читателям в 2019 и 2020 годах. В частности, в 2020 году к консорциуму по разработке мощных европейских процессоров для систем экза-класса присоединилась SiPearl. Но сегодня достигнута первая серьёзная веха: EPI, насчитывающий на данный момент 28 членов из 10 европейских стран, наконец-то получил первую партию тестовых образцов процессоров EPAC1.0.

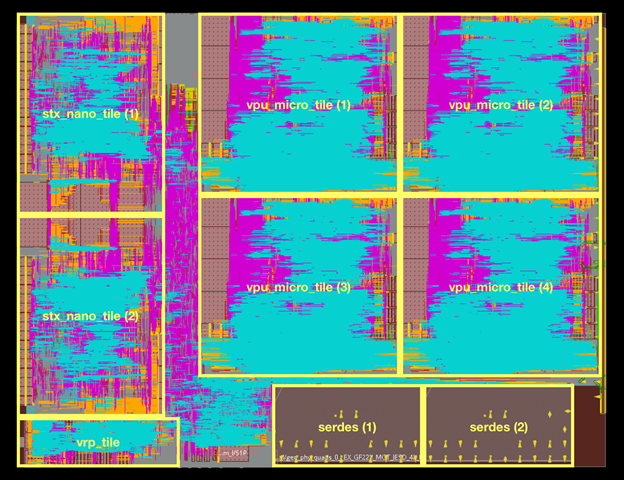

Источник изображений: European Processor Initiative (EPI) По предварительным данным, первичные тесты новых чипов прошли успешно. Процессоры EPAC имеют гибридную архитектуру: в качестве базовых вычислительных ядер общего назначения в них используются ядра Avispado с архитектурой RISC-V, разработанные компанией SemiDynamics. Они объединены в микро-тайлы по четыре ядра и дополнены блоком векторных вычислений (VPU), созданным совместно Барселонским Суперкомпьютерным Центром (Испания) и Университетом Загреба (Хорватия).

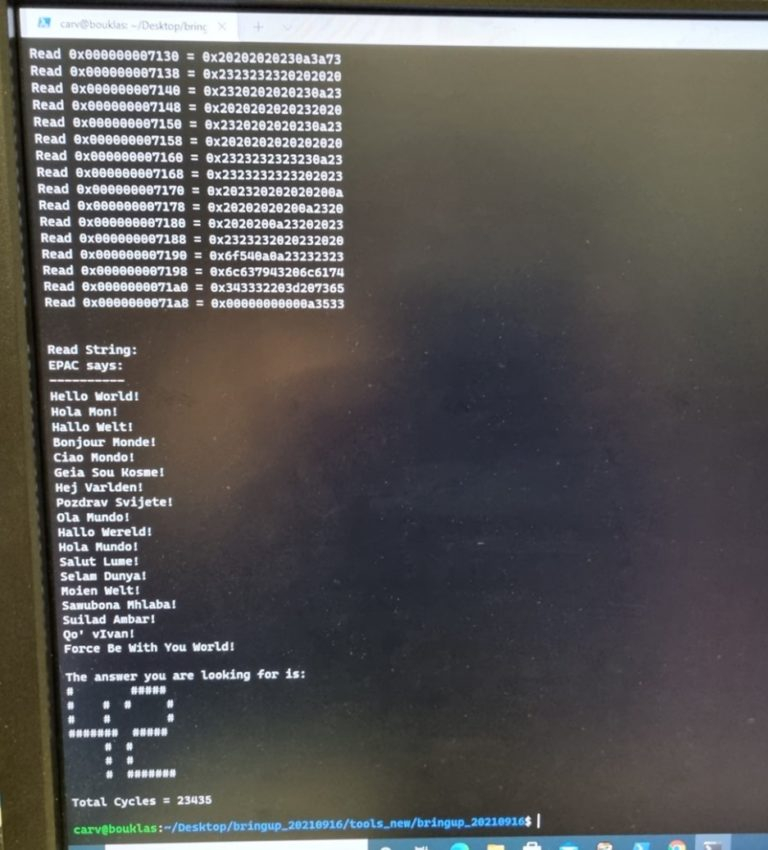

Строение кристалла EPAC1.0 Каждый такой тайл содержит блоки Home Node (интерконнект) с кешем L2, обеспечивающие когерентную работу подсистем памяти. Имеется в составе EPAC1.0 и описанный нами ранее тензорно-стенсильный ускоритель STX, к созданию которого приложил руку небезызвестный Институт Фраунгофера (Fraunhofer IIS). Дополняет картину блок вычислений с изменяемой точностью (VRP), за его создание отвечала французская лаборатория CEA-LIST. Все ускорители в составе нового процессора связаны высокоскоростной сетью, использующей SerDes-блоки от EXTOLL.  Первые 143 экземпляра EPAC произведены на мощностях GlobalFoundries с использованием 22-нм техпроцесса FDX22 и имеют площадь ядра 27 мм2. Используется упаковка FCBGA 22x22. Тактовая частота невысока, она составляет всего 1 ГГц. Отчасти это следствие использования не самого тонкого техпроцесса, а отчасти обусловлено тестовым статусом первых процессоров. Но новорожденный CPU жизнеспособен: он успешно запустил первые написанные для него программы, в числе прочего, ответив традиционным «42» на главный вопрос жизни и вселенной. Ожидается, что следующее поколение EPAC будет производиться с использованием 12-нм техпроцесса и получит чиплетную компоновку. |

|