Эпоха отставания Intel в количестве ядер у серверных процессоров, открытая дебютом AMD EPYC 7002 Rome пять лет назад, постепенно уходит в прошлое. Ещё летом компания представила чипы Xeon 6700E (Sierra Forest) со 144 ядрами. Но если Sierra Forest ещё можно было условно считать не совсем «настоящими» Xeon из-за использования исключительно энергоэффективных Е-ядер без SMT, которым противостоят 128-ядерные AMD EPYC Bergamo на базе Zen4c с SMT, то с анонсом Xeon 6900P этого сделать уже не получится. Встречаем Granite Rapids-AP c 128 полновесными P-ядрами!

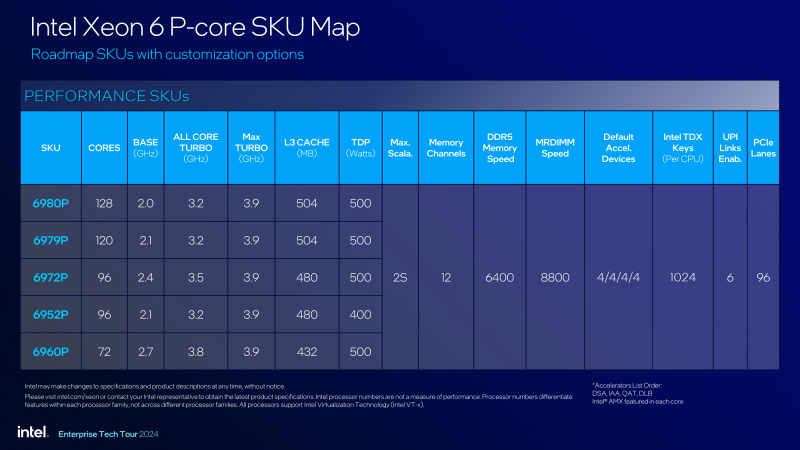

Многое об архитектуре и возможностях Granite Rapids было известно ещё в момент анонса Sierra Forest, но сейчас речь пойдёт о полноценном семействе, в котором на старте представлено пять моделей процессоров с числом ядер от 72 до 128. В этом старшая новинка не уступает даже будущим 128-ядерным AMD EPYC Turin Dense на базе Zen 5, анонс которых вот-вот состоится.

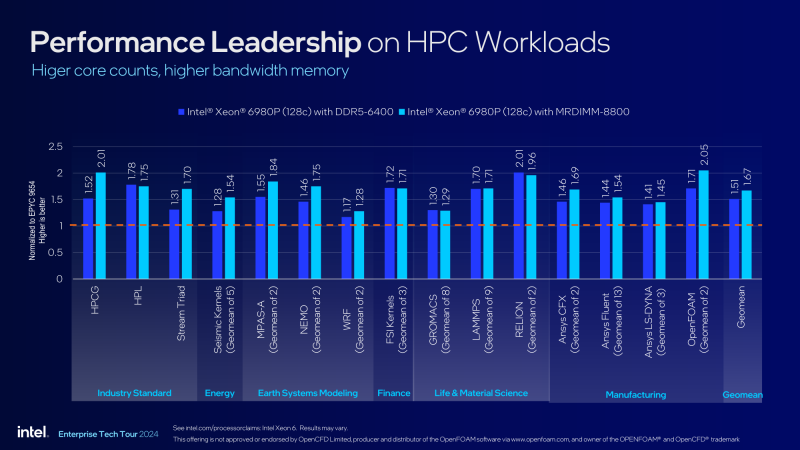

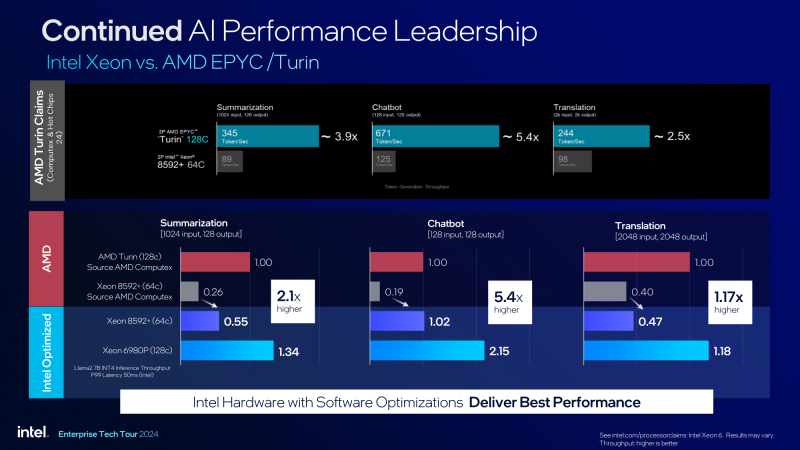

Благодаря использованию сложных и высокопроизводительных ядер у Intel теперь есть возможность заявить о 2,1-кратном превосходстве над 96-ядерным флагманским AMD EPYC Genoa в нагрузке OpenFOAM, а за счёт поддержки AMX и характерных для ИИ форматов вычислений, таких как FP16, в инференс-сценарии ResNet50 превосходство составляет 5,5 раза.

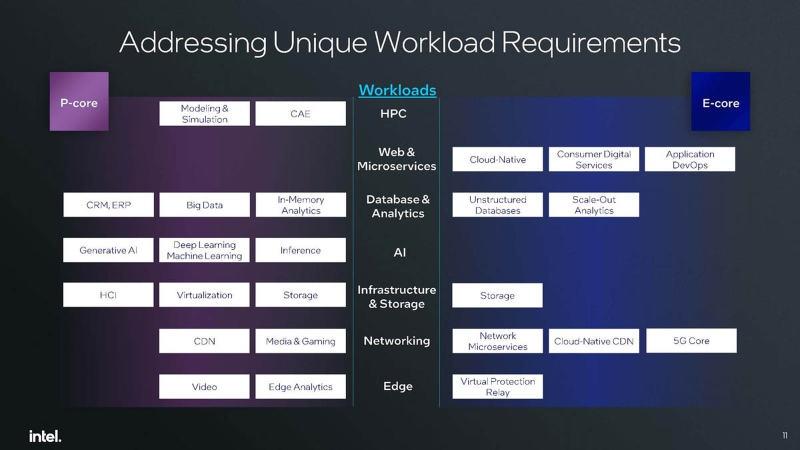

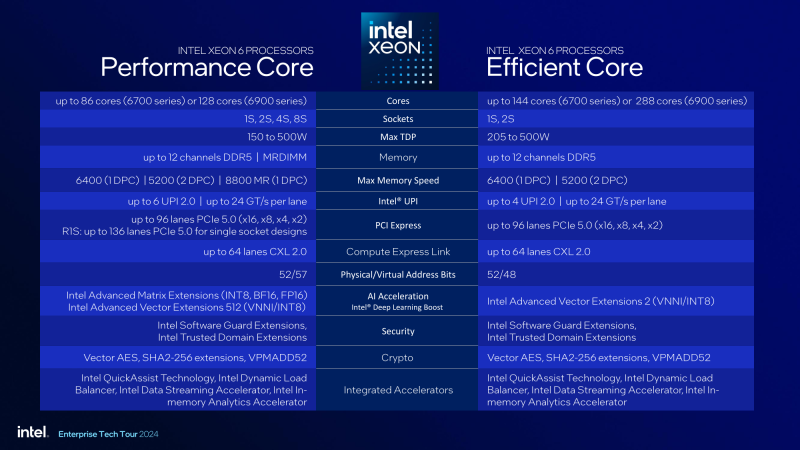

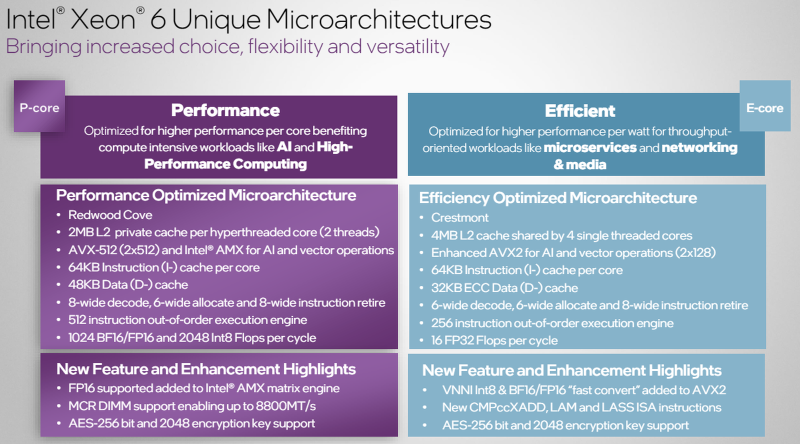

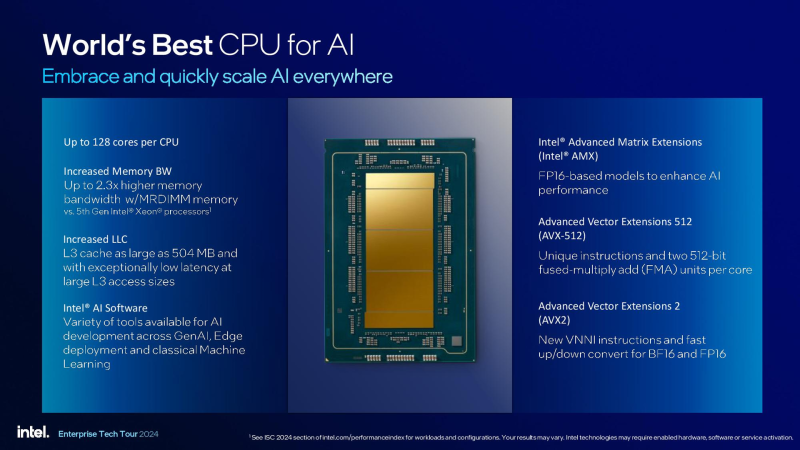

Intel весьма радикально подходит к вопросу «Великого Разделения», чётко разграничивая оптимальные сферы применения для процессоров с P-ядрами и E-ядрами, хотя с точки зрения ПО разница не столь велика и фактически упирается в отсутствие у E-ядер полноценной поддержки AVX-512 и AMX, что отчасти компенсируется продвинутой реализацией AVX. Тем не менее, Xeon со смешанной конфигурацией компания выпускать в обозримое время не планирует. Отметим также, что Р-ядра лучше подойдут в тех случаях, когда требуется максимальная производительность в пересчёте на поток, что особенно актуально для приложений с поядерным лицензированием.

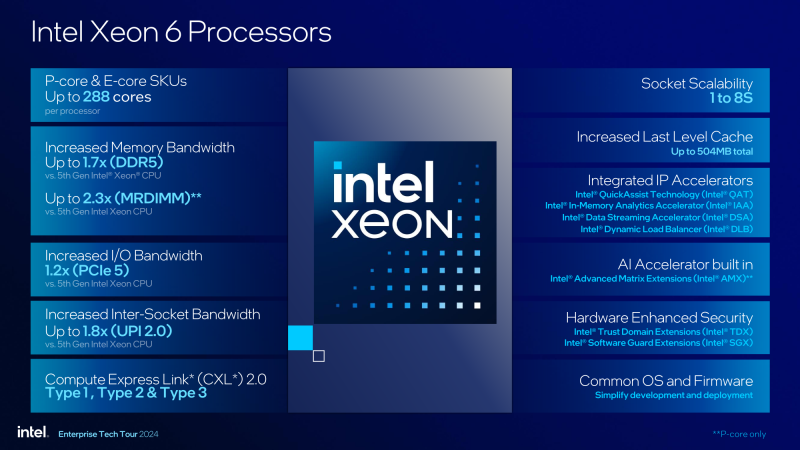

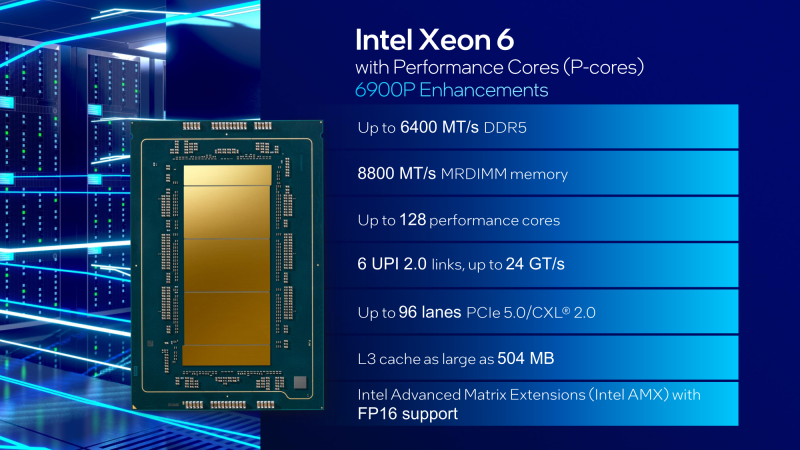

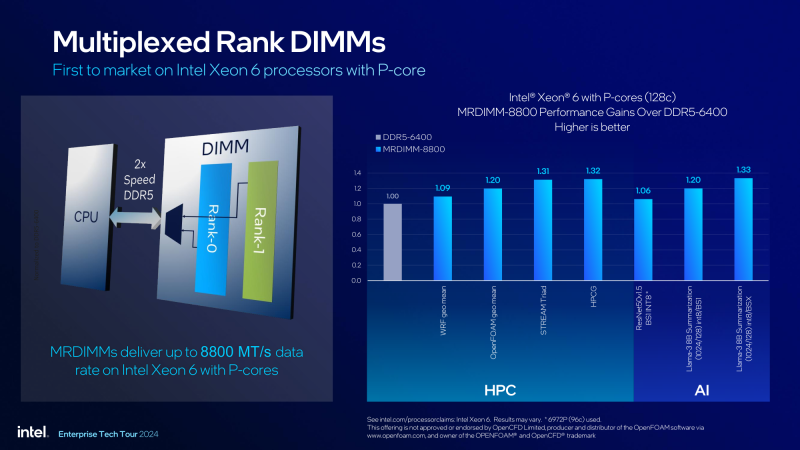

Новая серия Xeon 6900P может похвастаться ядрами Redwood Cove с поддержкой SMT (HT), что дает 512 потоков на систему с двумя процессорами, а 12-канальный контроллер памяти призван догнать и перегнать по производительности подсистемы памяти, реализованные AMD. Он работает с модулями DDR5-6400, но поддержка MRDIMM позволяет говорить и о скорости 8800 МТ/с.

Ядра включают два блока исполнения набора инструкций AVX-512. Кеш первого уровня состоит из 64 Кбайт для инструкций и 48 Кбайт для данных. Декодер рассчитан на обработку 8 инструкций за такт, такова же пропускная способность конвейера в обработке микроопераций. Сам движок внеочередного исполнения вдвое производительнее того, что реализован в Sierra Forest, и вмещает 512 инструкций.

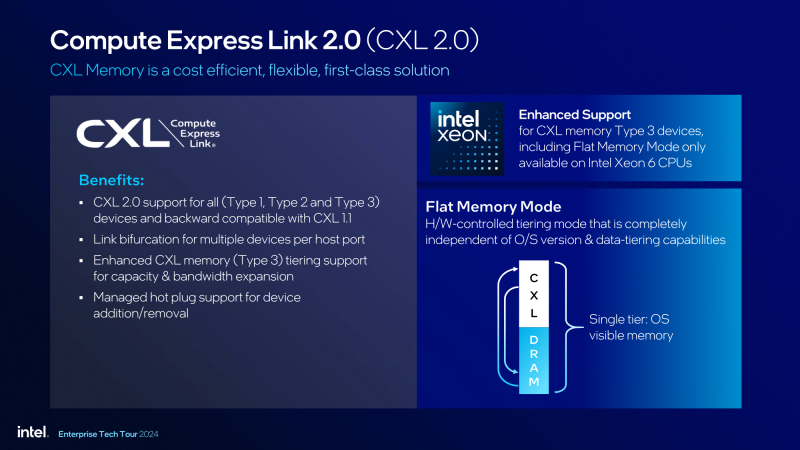

Впечатляют и объёмы кешей верхнего уровня: каждое ядро Redwood Cove имеет собственный кеш L2 объёмом 2 Мбайт, а размер общего кеша L3 достигает 504 Мбайт — больше могут предложить только AMD EPYC Genoa-X c 3D V-Cache. В двухпроцессорной конфигурации это даёт свыше 1 Гбайт кеша, что наверняка пригодится в HPC и ИИ-сценариях. Каждый процессор Xeon 6900P имеет 96 линий PCI Express 5.0 с поддержкой CXL 2.0, причём всех типов устройств — Type I, II и III. За межпроцессорное общение отвечает сразу шесть линий UPI с пропускной способностью 24 ГТ/с.

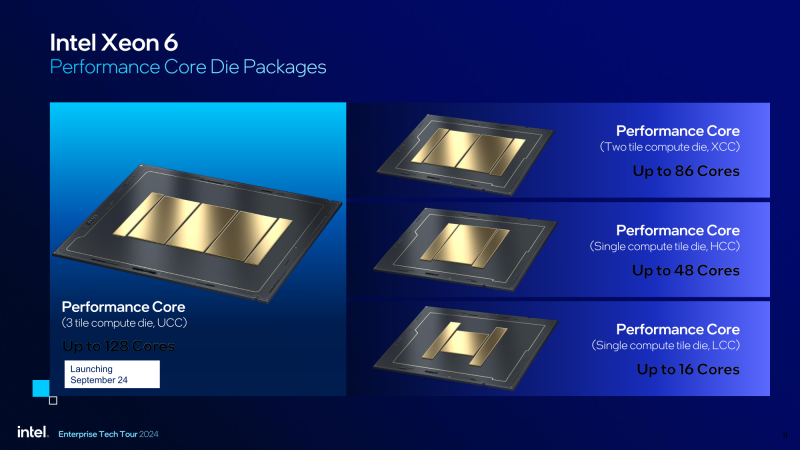

Процессоры используют так называемый «большой разъём» (big socket) LGA 7529. Позже Xeon 6 с Р-ядрами будут выпущены и для «малого разъёма» LGA 4710, используемого сейчас чипами Sierra Forest, но случится это не ранее I квартала 2025 года. Это будут решения с меньшим количеством ядер (до 86) и восьмиканальной подсистемой памяти. Тогда же будут освоены и решения с Е-ядрами на LGA 7529, а пока Sierra Forest и Granite Rapids существуют исключительно в рамках своих платформ.

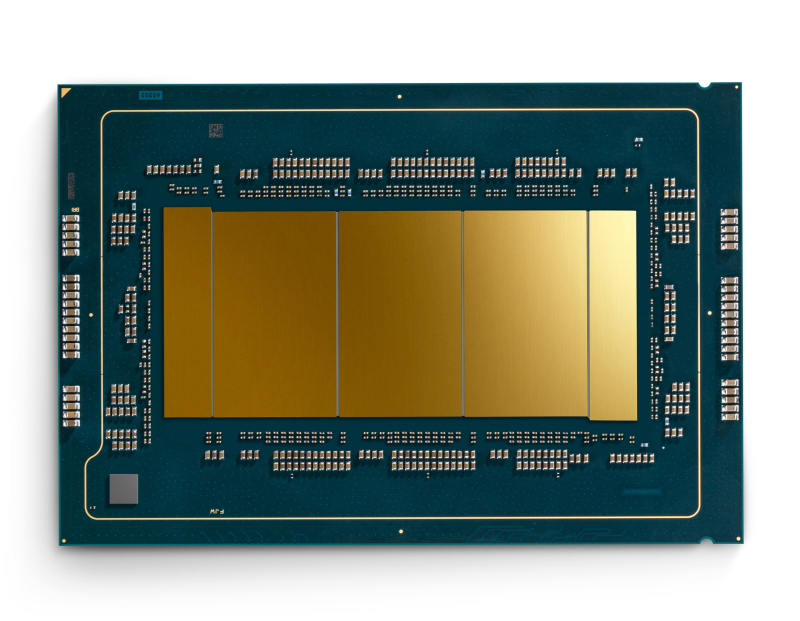

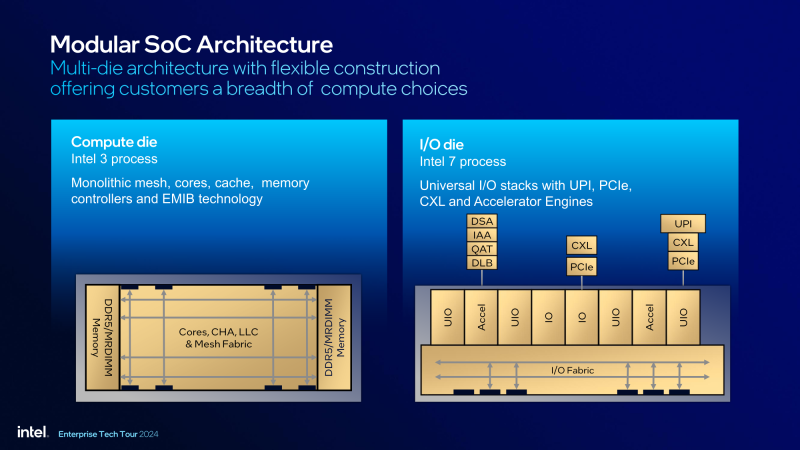

Компоновка у Xeon 6900P, разумеется, чиплетная, что также освещалось в обзоре Xeon 6700. Однако теперь мы знаем больше: на презентации новинок Intel показала, что чиплеты с P-ядрами будут двух размерностей: LCC (low core count), ограниченный 16 ядрами, и более крупный HCC (high core count), содержащий уже до 48 ядер. Конфигурация XCC (eXtreme core count) формируется компоновкой двух или трёх чиплетов HCC. Именно последний вариант с тремя тайлами используют все пять моделей Xeon 6900P.

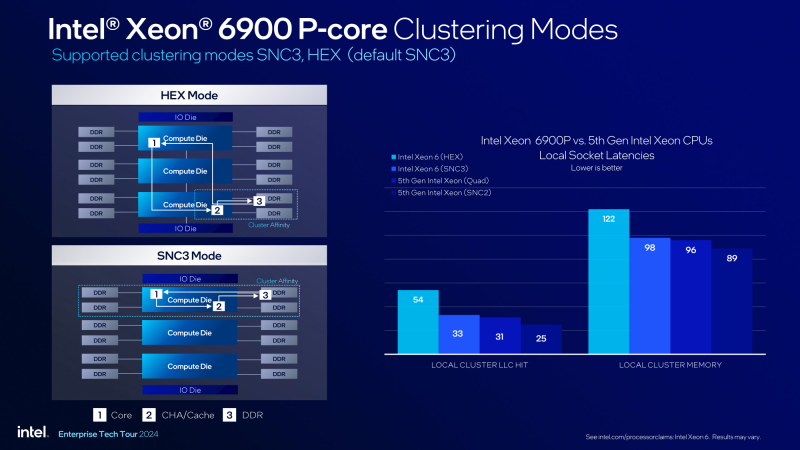

По сути, о Xeon 6900P можно говорить как о NUMA-системе с тремя узлами. Поскольку контроллеры DDR5 расположены в процессорных, а не I/O-чиплетах как у AMD, поддержка разных режимов кластеризации позволяет в некоторых сценариях выиграть в латентности доступа к памяти, а значит, и в производительности. Таких режимов у Xeon 6900P два — HEX и SNC3. Последний реализует сценарий «каждый чиплет обращается к своим DDR-контроллерам».

Интересно, что использована конфигурация с двумя тайлами по 43 активных ядра в каждом, тогда как третий имеет лишь 42 активных ядра. Сделано это, разумеется, для 128-ядерности, но гипотетически ничто не мешало Intel активировать больше ядер и получить чип, обгоняющий EPYC по количеству ядер. Причина, надо полагать, в энергетических аппетитах новинок, которые и со 128 ядрами требуют уже полкиловатта.

Картина латентности при межъядерном взаимодействии у Xeon 6900P специфическая. Общение ядер, принадлежащих крайним чиплетам, не отличается низкими задержками, что закономерно. Можно с уверенность предсказывать несколько более высокие задержки при работе среднего чиплета с внешними устройствами, поскольку I/O-чиплеты расположены буквально по краям CPU.

Чипы, как уже неоднократно отмечалось, более монолитны в реализации, нежели у AMD: чиплеты сшиваются посредством EMIB и используют универсальную модульную меш-сеть. Производятся вычислительные тайлы с использованием техпроцесса Intel 3 в то время как I/O-чиплеты используют более дешёвый и массовый процесс Intel 7. В отличие от аналогичного модуля в AMD EPYC, они отвечают лишь за реализацию интерфейсов UPI/PCIe/CXL и общение с акселераторами DSA/IAA/QAT/DLB.

Открывает новый модельный ряд 72-ядерный Xeon 6960P, который можно назвать своеобразным ответом Intel на NVIDIA Grace (72 ядра в GH200, 144 ядра в Grace Superchip). Впрочем, за всё приходится платить, и в данном случае расплата — возросший до 500 Вт теплопакет. Лишь у модели 6952P с низкой базовой частотой он чуть ниже и составляет 400 Вт. В остальном 6900P весьма похожи, они даже имеют одинаковую в турборежиме частоту, равную 3,9 ГГц для одного ядра и 3,7 ГГц для всех ядер. В настоящий момент это выше показателей AMD EPYC Genoa схожей «ядерности». Все варианты имеют по четыре активных ускорителя каждого типа, 12 каналов памяти, шесть линий UPI и 96 линий PCIe 5.0.

О памяти стоит сказать отдельно. Рост количества каналов и объёма памяти идёт гораздо медленнее, чем рост количества ядер. Это особенно актуально в свете бума ИИ-технологий, которые по своей природе весьма охочи до памяти. Назрела проблема и со скоростями: хотя отчасти она скрашивается переходом на DDR5, но даже Sierra Forrest поддерживает лишь DDR5-6400. В Granite Rapids-AP такая память тоже поддерживается, но перспективнее выглядит умение работать с модулями MRDIMM-8800.

Внешне модули MRDIMM (и MCR DIMM) напоминают обычные регистровые модули DDR5, однако использование дополнительного буфера позволяет новым модулям работать в режиме считывания из двух рангов сразу, вместо одного в обычных DIMM. Стоит сказать, что JEDEC лишь планирует к публикации спецификации MRDIMM. Пока преимущество на стороне Intel, но о массовости нового типа памяти говорить рано. Есть вероятность, что реализации поддержки этой памяти со стороны AMD будет отличаться.

Источник: Phoronix

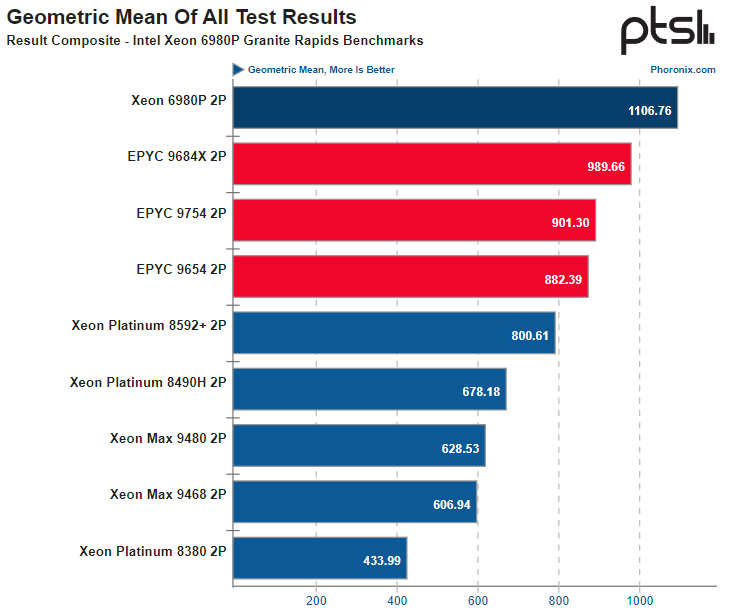

Что касается производительности в целом, то первые результаты также уже имеются: в тестах, проведённых ресурсом Phoronix, платформа, оснащённая двумя флагманскими Xeon 6980P, уверенно заняла первое место, опередив двухпроцессорные сборки с AMD EPYC 9754, 9684X и 9654.

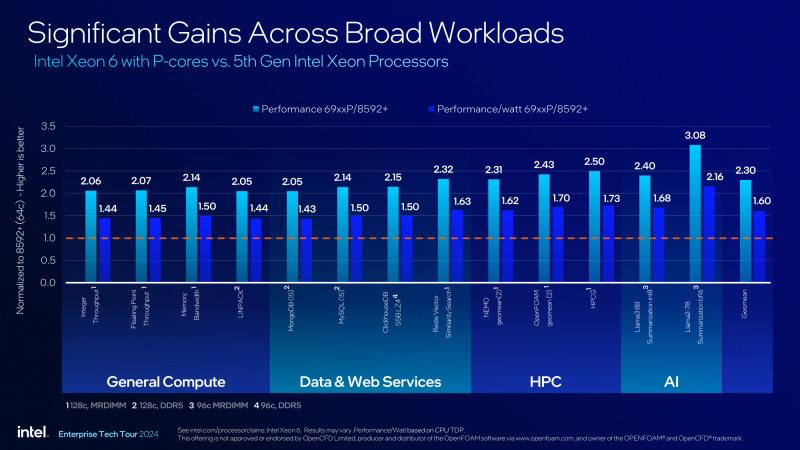

Согласно цифрам, приведённым самой Intel, превосходство шестого поколения Xeon над пятым (Emerald Rapids) 2-3x в чистой производительности, а в пересчёте на ватт составляет от 1,44x до 2,16x в зависимости от типа и характера нагрузки. Стоит отметить, что несмотря на возросший теплопакет, энергоэффективность Xeon 6900P тоже выросла: при типовой 40-% загрузке сервера новые процессоры обеспечивают в 1,9 раза большую производительность на Вт, нежели предыдущее поколение Xeon.

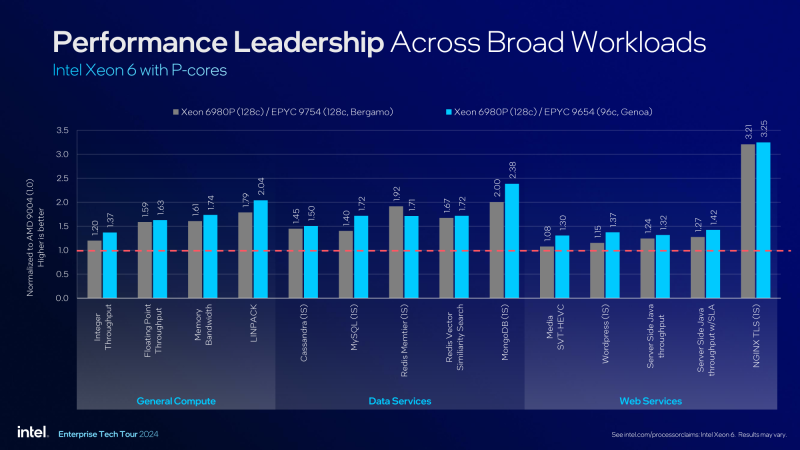

В сравнении с решениями AMD с сопоставимым количеством ядер (EPYC 9754 и 9654, 128 и 96 ядер, соответственно) Xeon 6980P быстрее в 1,2–3,21 раза, причем меньше всего преимущество проявляется в работе с целочисленными данными, и заметно больше — в вычислениях с плавающей запятой, а также в тестах подсистемы памяти.

Подведём промежуточные итоги. В своё время AMD удалось вырваться вперёд в сфере создания многоядерных серверных процессоров именно благодаря перехода на чиплетную компоновку. В немалой степени триумфу «красных» способствовал и затянувшийся до неприличия процесс внедрения 10-нм технологии у Intel. В итоге целых пять лет у EPYC успешно росло количество ядер в то время как «синие», упорно держась за монолитность кристалла, были ещё и ограничены параметрами техпроцесса. Это никак не позволяло уверенно перешагнуть отметку в 64 ядра.

Лишь в Sapphire Rapids удалось реализовать вариант чиплетной компоновки. Хотя она с самого начала и использовала более низкоуровневый принцип сшивки чиплетов, вплоть до последнего использовался не самый удачный гомогенный вариант с большими универсальными чиплетами. И только в поколении Xeon 6 дебютировал гетерогенный вариант с вынесенной в отдельные чиплеты I/O-частью, что в сочетании с освоенными тонкими техпроцессами позволил совершить Intel рывок, сокративший отставание от AMD.

Теперь у Intel есть не только козырь в виде высокопроизводительной архитектуры и специфических блоков-ускорителей, но и просто «большие» Xeon, способные на равных поспорить с EPYC в количестве ядер. Ситуация интересна ещё и тем, что уже 10 октября AMD готовится официально представить новые EPYC Turin Dense на базе Zen 5, которые тоже получат 128 ядер. Но AMD готовит не только их, но и 192-ядерные EPYC на базе Zen 5c. А как мы знаем, иногда количество превалирует над качеством.

Источники: