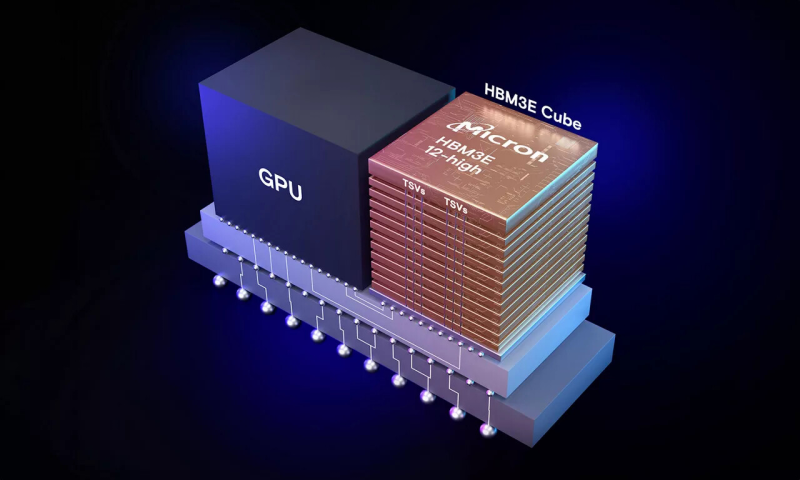

Компания Micron Technology сообщила о начале пробных поставок 12-ярусных (12-Hi) чипов памяти HBM3E, предназначенных для высокопроизводительных ИИ-ускорителей. Изделия проходят квалификацию в экосистеме отраслевых партнёров, после чего начнутся их массовые отгрузки.

Новые чипы имеют ёмкость 36 Гбайт, что на 50 % больше по сравнению с существующими 8-слойными вариантами HBM3E (24 Гбайт). При этом, как утверждает Micron, достигается значительно более низкое энергопотребление. Благодаря применению 12-ярусных чипов HBM3E крупные модели ИИ, такие как Llama 2 с 70 млрд параметров, могут запускаться на одном ускорителе.

Заявленная пропускная способность превышает 9,2 Гбит/с на контакт, что в сумме обеспечивает свыше 1,2 Тбайт/с. Появление новой памяти поможет гиперскейлерам и крупным операторам дата-центров масштабировать растущие рабочие нагрузки ИИ в соответствии с запросами клиентов.

Реализована полностью программируемая функция MBIST (Memory Built-In Self Test), которая способна работать на скоростях, соответствующих системному трафику. Это повышает эффективность тестирования, что позволяет сократить время вывода продукции на рынок и повысить надёжность оборудования. При изготовлении памяти HBM3E компания Micron применяет современные методики упаковки чипов, включая усовершенствованную технологию сквозных соединений TSV (Through-Silicon Via).

Нужно отметить, что о разработке 12-слойных чипов HBM3E ёмкостью 36 Гбайт в начале 2024 года объявила компания Samsung. Эти решения обеспечивают пропускную способность до 1,28 Тбайт/с. По данному показателю, как утверждается, чипы более чем на 50 % превосходят доступные на рынке 8-слойные стеки HBM3. Наконец, старт массового производства 12-Hi модулей HBM3E от SK hynix с ПСП 1,15 Тбайт/с намечен на октябрь.

Источник: