Материалы по тегу: рск

|

10.07.2023 [10:30], Сергей Карасёв

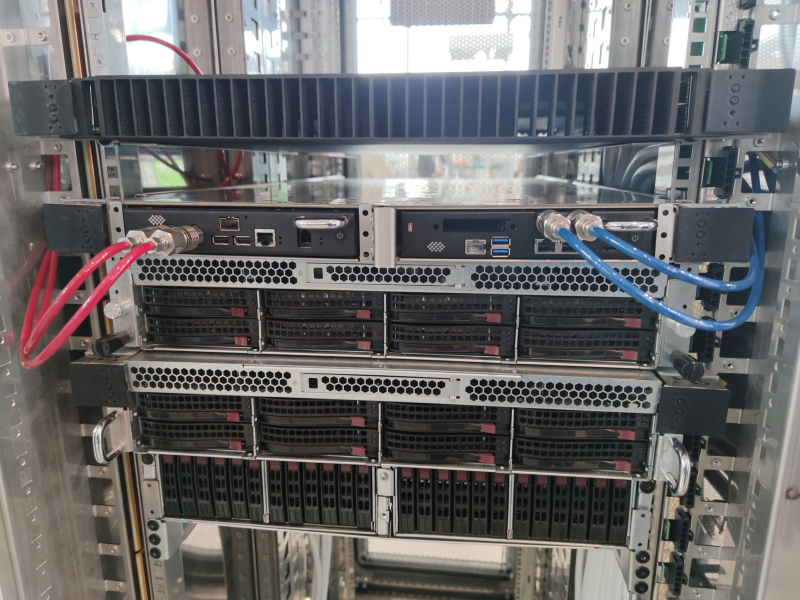

Представлена российская суперкомпьютерная платформа «РСК Экзастрим»: 570+ кВт на шкафГруппа компаний РСК в ходе международной промышленной выставки «Иннопром 2023» анонсировала энергоэффективное и высокопроизводительное кластерное решение «РСК Экзастрим» для создания российских суперкомпьютеров и дата-центров нового поколения. «РСК Экзастрим» — это двухсторонний универсальный вычислительный шкаф с возможностью монтажа 42 серверов формата 1U с каждой стороны (всего 84 сервера). Общие габариты составляют 2000 × 600 × 1200 мм. Платформа предлагает высокую энергетическую плотность (более 570 кВт на шкаф), но вместе с тем есть возможность использования разных типов охлаждения в одном шкафу: 100 % жидкостное, гибридное или воздушное. Среди особенностей «РСК Экзастрим» разработчик называет: полностью отечественную технологическую разработку и производство в РФ; гибкую, управляемую и компонуемую архитектуру; универсальность (применимы стандартные размеры серверного оборудования); большой выбор конфигураций для используемого оборудования; легкость обслуживания; возможность использования узлов на базе разных процессоров (в том числе на основе отечественных чипов «Эльбрус»). Платформа может включать интегрированные программные комплексы «РСК БазИС» и «РСК БазИС СХД» для мониторинга и управления, а также для динамического перераспределения ресурсов системы «по запросу» (как вычислительных, так и для хранения данных) для наиболее эффективного решения каждой задачи. В качестве примера использования «РСК Экзастрим» можно привести размещение узлов высокоплотной системы хранения RSC Tornado AFS на базе SSD форм-фактора E1.L (32 накопителя, 1 Пбайт на узел высотой 1U, со 100 % жидкостным охлаждением). Кроме того, могут использоваться вычислительные серверы «РСК Торнадо» на базе российских процессоров «Эльбрус-8СВ» и «Эльбрус-16С». Ещё один вариант — высокопроизводительные серверы для решения задач ИИ на основе специализированных ускорителей с плотностью размещения до четырёх штук на один узел высотой 1U.

24.04.2023 [17:11], Татьяна Золотова

Alias Group создаст коммерческий ЦОД в Новосибирской областиИТ-интегратор «Проф-сити» (входит в инвестиционный холдинг Alias Group), построит дата-центр в Новосибирской области. Объем инвестиций составит 2,2 млрд рублей. Совет по инвестициям Новосибирской области выделил под проект земельный участок площадью 2,28 га. Предполагается, что объем налоговых поступлений в региональный бюджет за 2023–2033 гг. составит около 700 млн руб. Первый этап планируется завершить во II квартале 2025 года, второй — до 2033 года. В новом ЦОД будет создано 800 стойкомест, а его мощность составит 4,8 МВт. На базе ЦОД будут оказываться услуги по размещению оборудования, организации инженерной инфраструктуры и электропитания для компаний с собственными серверами, СХД, а также телекоммуникационными устройствами. Основными потребителями услуг станут представители ритейла, финансового сектора, промышленности, а также ИТ-компании.

Изображение: Alias Group Как поясняют в Alias Group, в регионе наблюдается дефицит ИТ-ресурсов. При этом здесь формируется кластер ЦОД. Так, в начале апреля 2023 года «Вымпелком» («Билайн») и Key Point (франчайзи cети дата-центров 3data) приступили к строительству ЦОД уровня Tier III в Новосибирской области. Планируемый объем инвестиций в строительство двух очередей дата-центра составляет 2,5 млрд руб. Общая проектная мощность данного ЦОД составит 8 МВт, емкость каждой из очередей — 440 стоек по 5 кВт ИТ-нагрузки. Ранее Alias Group совместно с 3data объявила о создании первого коммерческого ЦОД уровня Tier III в Краснодарском крае: 600 серверных стоек, мощность 7 МВт. В первой очереди, создание которой намечено на 2023 год, планируется ввести в эксплуатацию 200 серверных стоек по 7 кВт нагрузки.

17.04.2023 [22:31], Татьяна Золотова

«билайн бизнес» и Key Point вложат 2,5 млрд руб. в дата-центр уровня Tier III в Новосибирске«Вымпелком» («билайн») и Key Point (франчайзи cети дата-центров 3data) приступили к строительству дата-центра уровня Tier III в Новосибирской области. Планируемый объем инвестиций в строительство двух очередей дата-центра составляет 2,5 млрд руб. В рамках партнерства «билайн» передает новосибирскому подразделению Key Point права на участок для дата-центра и обеспечивает техподдержку в решении вопросов, связанных с организацией на выделенном под ЦОД участке внешних инженерных коммуникаций. А Key Point предоставляет место под технологическую площадку для оборудования «билайна» на особых условиях. Запуск в эксплуатацию первой из двух очередей запланирован на декабрь 2023 года. Общая проектная мощность ЦОД составит 8 МВт, емкость каждой из очередей — 440 стоек по 5 кВт ИТ-нагрузки. Генеральным проектировщиком и подрядчиком объекта является компания «Свободные технологии инжиниринг», технический консалтинг осуществляет «Ди си квадрат». Новосибирский ЦОД создается в рамках региональной сети дата-центров Key Point. Компания планирует открыть площадки более чем в 30 городах РФ в течение ближайших шести лет. Key Point приглашает коммерческие компании, которые будут использовать емкости новых ЦОД на специальных условиях. Это не первый проект партнеров в регионах в рамках соглашения о сотрудничестве по ЦОД, подписанном в 2022 году. Key Point планирует к концу 2023 года создать новый коммерческий ЦОД в Екатеринбурге, ключевым клиентом которого тоже станет «билайн». Площадка рассчитана на 300 стоек (3,6 МВт). Также «билайн» стал первым крупным клиентом 10-МВт дата-центра Key Point уровня Tier III в Приморском крае.

12.07.2022 [00:28], Игорь Осколков

Суперкомпьютер в дорогу: РСК показала на Иннопроме обновлённый мобильный ЦОДГруппа компаний РСК, ведущий российский разработчик суперкомпьютеров и систем для высокопроизводительных вычислений (HPC), дата-центров, облачных платформ и систем хранения данных (СХД) показала на выставке Иннопром-2022 обновлённую версию своей платформы для автономных периферийных вычислений, которая позволяет оперативно, в течение часа силами двух человек, развернуть HPC-кластер практически в любом месте. Решение упаковано в несколько контейнеров (0,7 × 0,7 × 1,1 м), которые можно транспортировать независимо друг от друга и собирать уже на месте. Один контейнер вмещает собственно вычислительную часть, второй — полностью интегрированный модуль распределения теплоносителя с узлом управления, а третий, опциональный — ИБП с инвертором. Дополняет их компактный внешний модуль охлаждения. Вся система имеет весьма солидный запас по возможности отвода тепла — до 60 кВт. Правда, сейчас столько и не требуется. Вычислительный блок фактически является уменьшенной копией платформы «РСК Торнадо»: 2 колонны по 10 слотов. Поэтому мобильная платформа позволяет совмещать в одной системе серверы «Торнадо» с процессорами x86-64 (AMD EPYC и Intel Xeon) и «Эльбрус» (сейчас 8С/8СВ, в перспективе 16С) с любым уровнем TDP, GPGPU-серверы (по два PCIe-ускорителя на сервер, без ограничений по TDP) и серверы хранения (до 12 × M.2 All-Flash). В текущем варианте платформы каждый слот рассчитан на 2 кВт тепловой нагрузки (и столько же по питанию), хотя нынешние серверы укладываются в среднем в 700–800 Вт, а серверы следующего поколения потребуют чуть больше 1 кВт. Подсистема питания имеет два домена, по одному на колонну, и требует однофазный ввод AC 230 В/50 Гц, хотя фактически может работать в диапазоне 105–280 В. Запитать систему можно от генератора, а подстраховать — ИБП. Но возможно и специсполнение с поддержкой 48 В DC. Сетевая подсистема может быть представлена ToR-коммутаторами как двойной (на обе колонны) ширины, так и одиночной. В том числе есть варианты с жидкостным охлаждением. Доступен даже InfiniBand — у Mellanox есть коммутаторы в подходящем форм-факторе, рассчитанные на промышленное применение. Также предоставляется 1 GbE-коммутатор для развёртывания служебной сети. Самая интересная часть — это охлаждение. Как и в «большой» версии платформы здесь используется фирменная СЖО, которая покрывает все компоненты серверов, так что вычислительная часть не требует активного воздушного охлаждения и способна работать даже с закрытыми крышками контейнера. Защиты по какому-либо классу IP в стандартном варианте не предусмотрено, но опять-таки по заказу возможно специсполнение. СЖО всё так же поддерживает охлаждение горячей водой, причём на всех компонентах температура не превышает +45 °C. Для запуска вычислительного модуля необходимо, чтобы он находился в помещении с плюсовой температурой и чтобы не было образования конденсата. А вот внешний контур охлаждения менее прихотлив и способен работать при температурах от -65 °C. Верхний же предел — не менее +40 °C. Требования по питанию у него те же, что и у серверов. Узел управления автоматически отслеживает и регулирует параметры всех компонентов системы во время запуска и работы. По умолчанию используется сценарий защиты оборудования, так что при неблагоприятных условиях серверы могут выключаться. Но возможны и другие сценарии, например, «работа до последнего», когда потеря данных оказывается дороже потери оборудования. Управляется мобильная платформа фирменной системой оркестрации «РСК БазИС», которая позволяет задействовать все возможности компонуемой, программно определяемой инфраструктуры, в том числе для реализации HCI-платформы. «РСК БазИС» предлагает GUI, CLI, открытые API и SDK для интеграции с другими приложениями. Таким образом, заказчик получает полностью интегрированное программно-аппаратное решение, готовое к быстрому развёртыванию и использованию. Изначально платформа создавалась для нужд добывающего сектора, но этой сферой её возможности не ограничиваются. Она также подходит для научных экспедиций и промышленных предприятий (срочная обработка больших массивов данных), медиасферы и обслуживания массовых мероприятий (рендеринг, стриминг с множества камер) и т.д. В общем, везде, где на время требуется действительно мощная, но компактная и удобная в доставке, развёртывании и эксплуатации вычислительная платформа.

30.03.2022 [22:01], Владимир Мироненко

Российская суперкомпьютерная платформа «РСК Торнадо» объединила отечественные «Эльбрусы» и зарубежные x86-процессорыГруппа компаний РСК на конференции «Параллельные вычислительные технологии (ПаВТ) 2022» сообщила о создании суперкомпьютерной платформы «РСК Торнадо», которая позволяет одновременно использовать в одной системе вычислительные узлы на базе зарубежных x86-процессоров и отечественных чипов «Эльбрус». Возможность использования различных типов микропроцессорных архитектур в одном монтажном шкафу (до 104 серверов в стойке), позволит ускорить темпы импортозамещения в области высокопроизводительных вычислительных систем (HPC), решений для центров обработки данных (ЦОД) и систем хранения данных (СХД). Унифицированная интероперабельная (т.е. обеспечивающая функциональную совместимость разных решений) платформа «РСК Торнадо» предназначена для решения широкого круга задач, в том числе для работы с нагрузками Big Data, HPC и ИИ. Разработка и создание вычислительных систем на основе «РСК Торнадо» осуществляется на территории России в рамках соглашения с Министерством промышленности и торговли Российской Федерации с целью реализации подпрограммы «Развитие производства вычислительной техники» в составе государственной программы «Развитие электронной и радиоэлектронной промышленности». Программный стек «РСК БазИС» для вышеупомянутой платформы тоже разработан в России. В настоящее время система «РСК БазИС» используется для оркестрации вычислительных мощностей Межведомственного суперкомпьютерного центра (МСЦ) РАН, Санкт-Петербургского политехнического университета (СПбПУ) и Объединенного института ядерных исследований (ОИЯИ), сведённых в единую инфраструктуру для оптимизации вычислительных ресурсов. |

|